Le rendu en temps réel pour la réalité virtuelle crée un spectre unique de défis, les principaux étant la nécessité de prendre en charge les effets photoréalistes, d'atteindre des résolutions élevées et d'augmenter les taux de rafraîchissement. Pour relever ces défis, les chercheurs de Facebook Reality Labs ont développé DeepFocus , un moteur de rendu que nous avons lancé en décembre 2018; il utilise l'IA pour créer des graphiques ultra-réalistes dans des appareils à focale variable. Lors de la conférence virtuelle SIGGRAPH de cette année , nous avons présenté un développement ultérieur de ce travail, ouvrant une nouvelle étape dans notre voyage vers les futurs écrans haute définition pour la réalité virtuelle .

Notre article technique pour SIGGRAPH intitulé Neural Supersampling for Real-Time Rendering fournit une solution d'apprentissage automatique qui convertit les images d'entrée basse résolution en images haute résolution pour un rendu en temps réel. Ce processus de suréchantillonnage utilise des réseaux de neurones formés sur des statistiques de scène pour récupérer des détails précis, tout en réduisant le coût de calcul du rendu de ces détails dans des applications en temps réel.

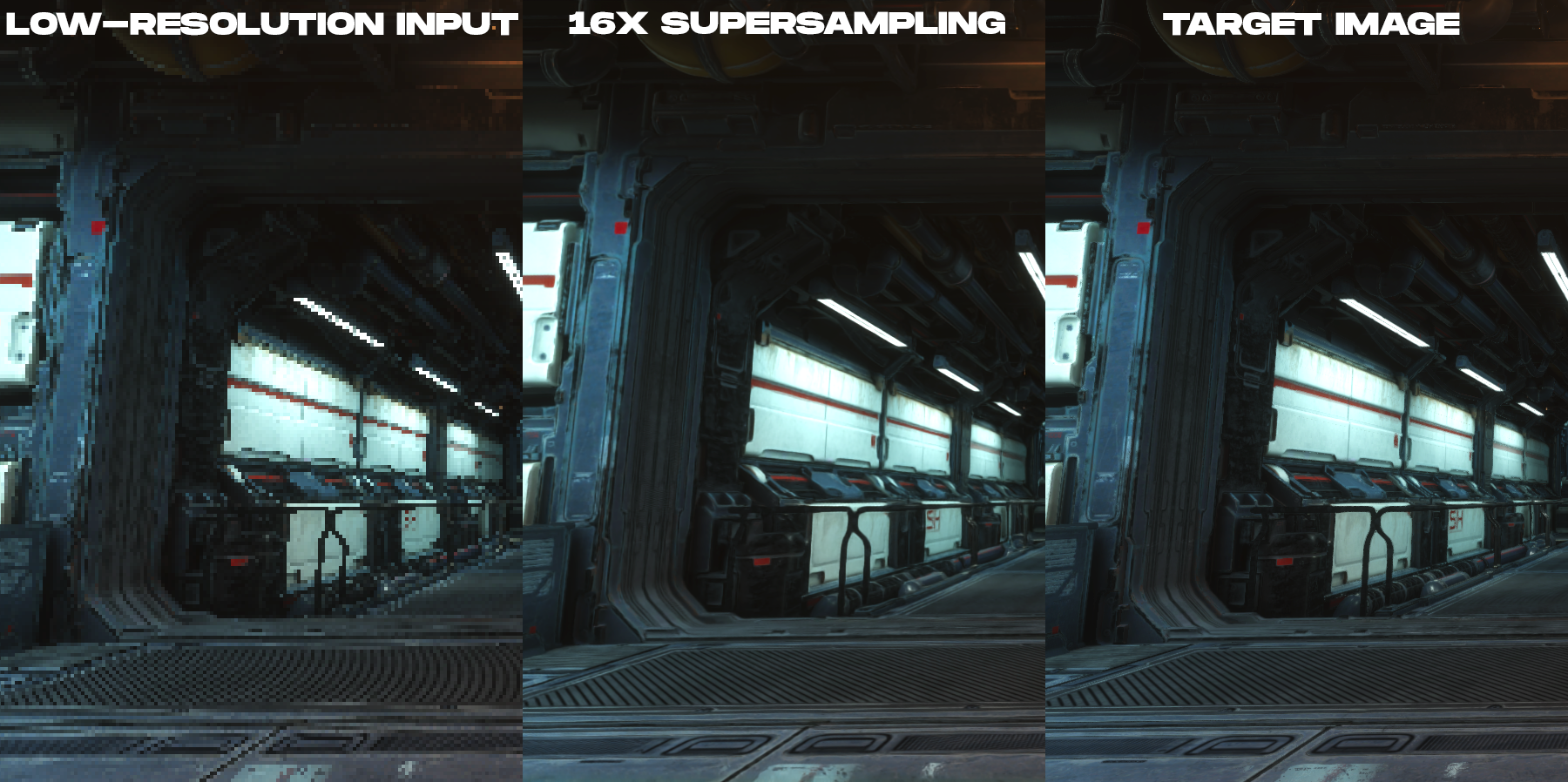

Notre solution est une technique de suréchantillonnage pré-entraînée qui réalise un suréchantillonnage 16x du contenu pour un rendu avec une fidélité spatiale et temporelle élevée, surpassant largement les travaux précédents.

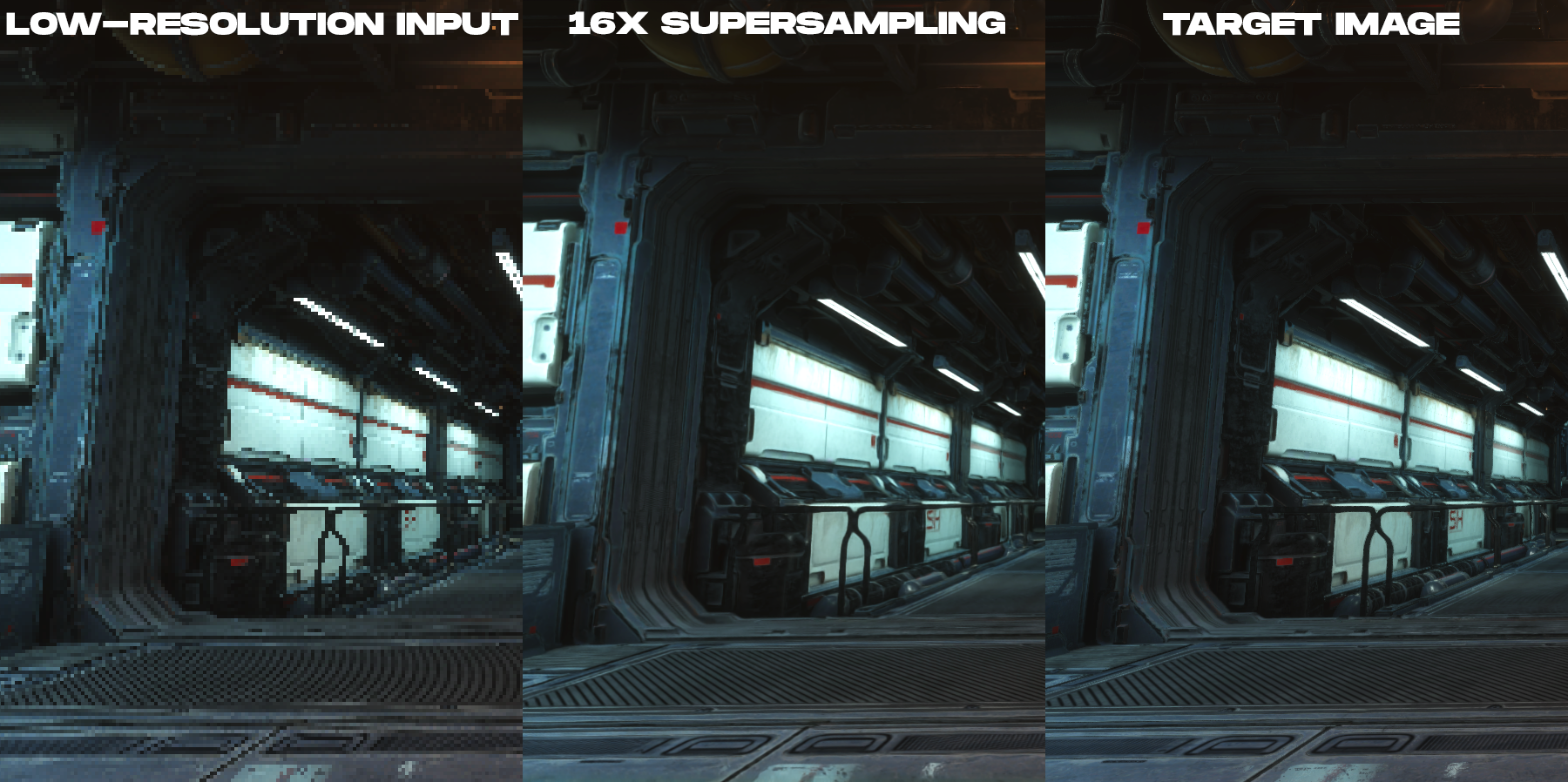

Animation pour comparer l'image couleur basse résolution rendue et l'image de sortie de suréchantillonnage 16x créée par la nouvelle technique de suréchantillonnage neuronal.

Sur quoi porte cette étude?

Pour réduire le coût du rendu sur les écrans haute résolution, notre méthode prend une image d'entrée qui a 16 fois moins de pixels que l'image de sortie souhaitée. Par exemple, si l'écran cible a une résolution de 3840 × 2160 , le réseau démarre avec une taille d'image d'entrée de 960 × 540 , moteurs de jeu otrendernnogo, puis effectue son suréchantillonnage à une résolution souhaitée de l'affichage en post-traitement en temps réel.

Bien qu'il y ait eu énormément de recherches sur le suréchantillonnage basé sur l'apprentissage des images photographiques, tous ces travaux ne répondaient pas directement aux besoins uniques du contenu rendu, comme les images produites par les moteurs de jeux vidéo. En effet, il existe des différences d'imagerie fondamentales entre les images rendues et photographiques. Dans le rendu en temps réel, chaque échantillon est un point à la fois dans l'espace et dans le temps. C'est pourquoi le contenu rendu a tendance à avoir une distorsion sévère, des lignes irrégulières et d'autres artefacts d'échantillonnage vus dans les exemples d'images à basse résolution de cet article. Pour cette raison, le suréchantillonnage du contenu rendu devient une tâche à la fois d'anti-crénelage et d'interpolation, plutôt qu'une tâche d'élimination du bruit et du flou.qui est bien étudié par les experts en vision par ordinateur. Le fait que les images entrantes soient fortement déformées et qu'il n'y ait absolument aucune information d'interpolation dans les pixels crée des difficultés importantes pour construire une reconstruction très précise du contenu rendu avec une intégrité temporelle.

, ( , ), .

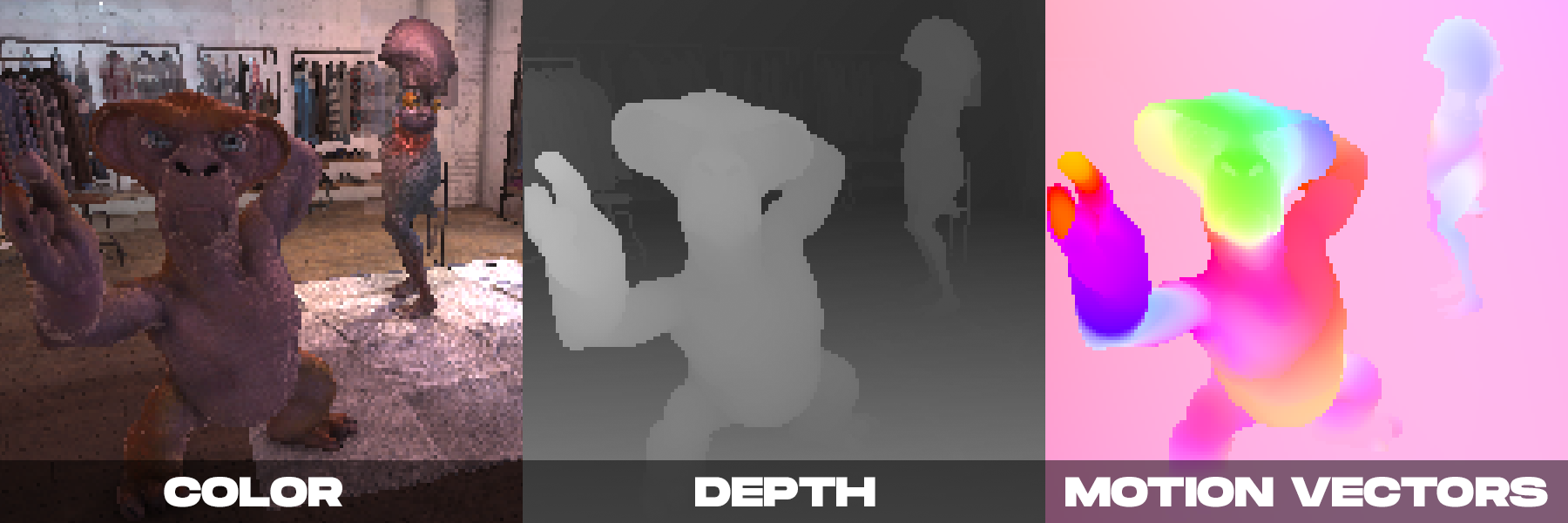

Par contre, lors du rendu en temps réel, on peut avoir plusieurs images couleur produites par la caméra. Comme nous l'avons démontré dans DeepFocus, les moteurs de rendu modernes fournissent également des informations auxiliaires telles que les valeurs de profondeur. Nous avons remarqué qu'avec le suréchantillonnage neuronal, les informations auxiliaires supplémentaires fournies par les vecteurs de mouvement étaient particulièrement importantes. Les vecteurs de mouvement définissent les relations géométriques entre les pixels dans des images consécutives. En d'autres termes, chaque vecteur de mouvement pointe vers un emplacement de sous-pixel auquel un point de surface visible dans une image peut avoir été dans une image précédente. Pour les images photographiques, ces valeurs sont généralement calculées à l'aide de méthodes de vision par ordinateur, mais ces algorithmes de calcul du mouvement optique sont sujets à des erreurs.En revanche, le moteur de rendu peut créer directement des vecteurs de mouvement denses, fournissant ainsi une entrée fiable et suffisante pour que le suréchantillonnage neuronal soit appliqué au contenu rendu.

Notre méthode est basée sur les observations ci-dessus, combinant des informations auxiliaires supplémentaires avec un nouveau schéma de réseau neuronal spatio-temporel conçu pour maximiser la qualité d'image et vidéo tout en offrant des performances en temps réel.

Lors de la prise de décision, notre réseau de neurones reçoit en entrée les attributs de rendu (couleur, carte de profondeur et vecteurs de mouvement denses de chaque image) des images actuelles et de plusieurs images précédentes, rendues à basse résolution. La sortie du réseau est une image couleur haute résolution correspondant à la trame courante. Le réseau utilise l'apprentissage supervisé. Pendant l'entraînement, avec chaque image basse résolution entrante, une image de référence haute résolution avec des méthodes d'anti-crénelage est mise en correspondance, qui est l'image cible pour l'optimisation de l'entraînement.

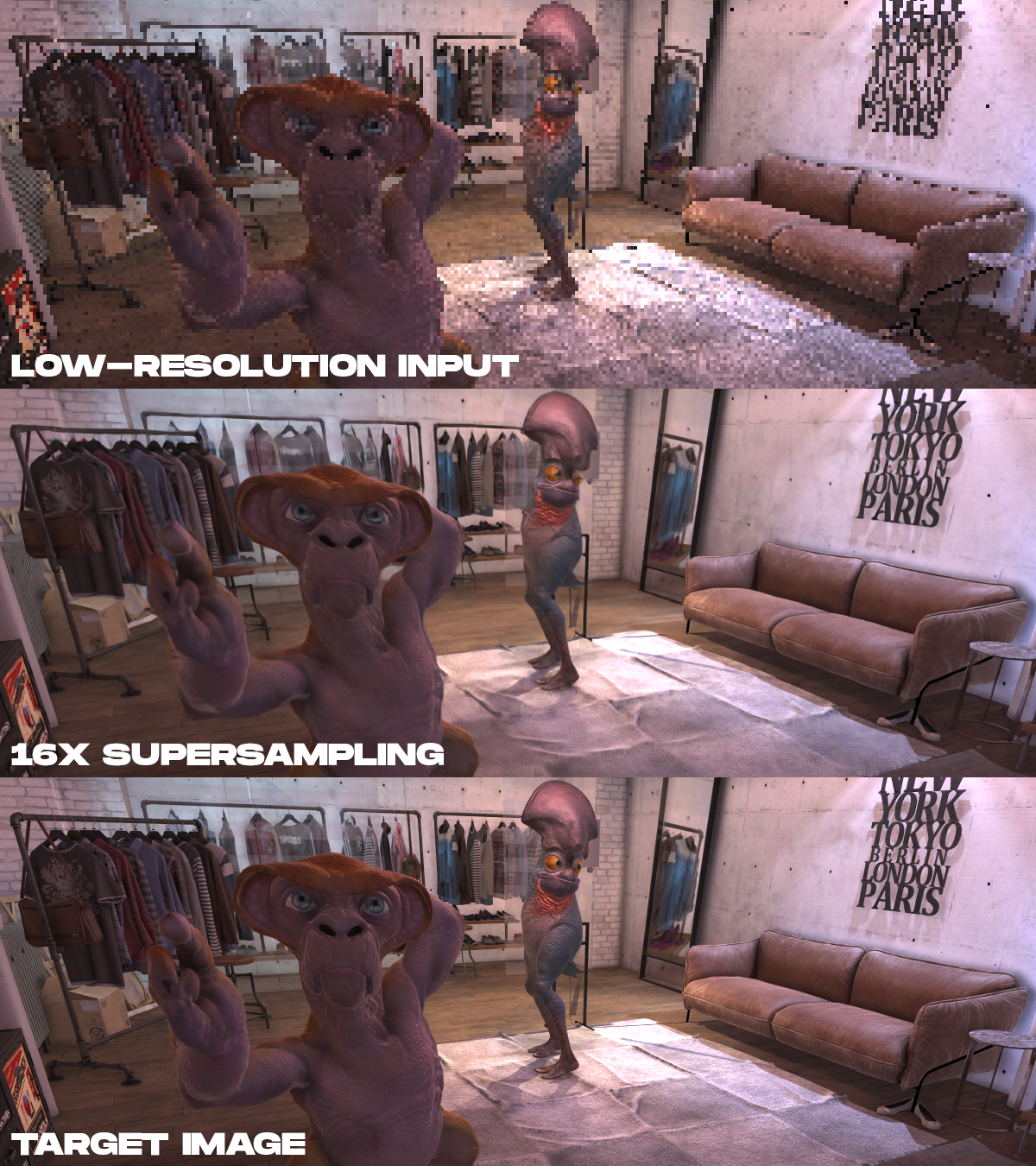

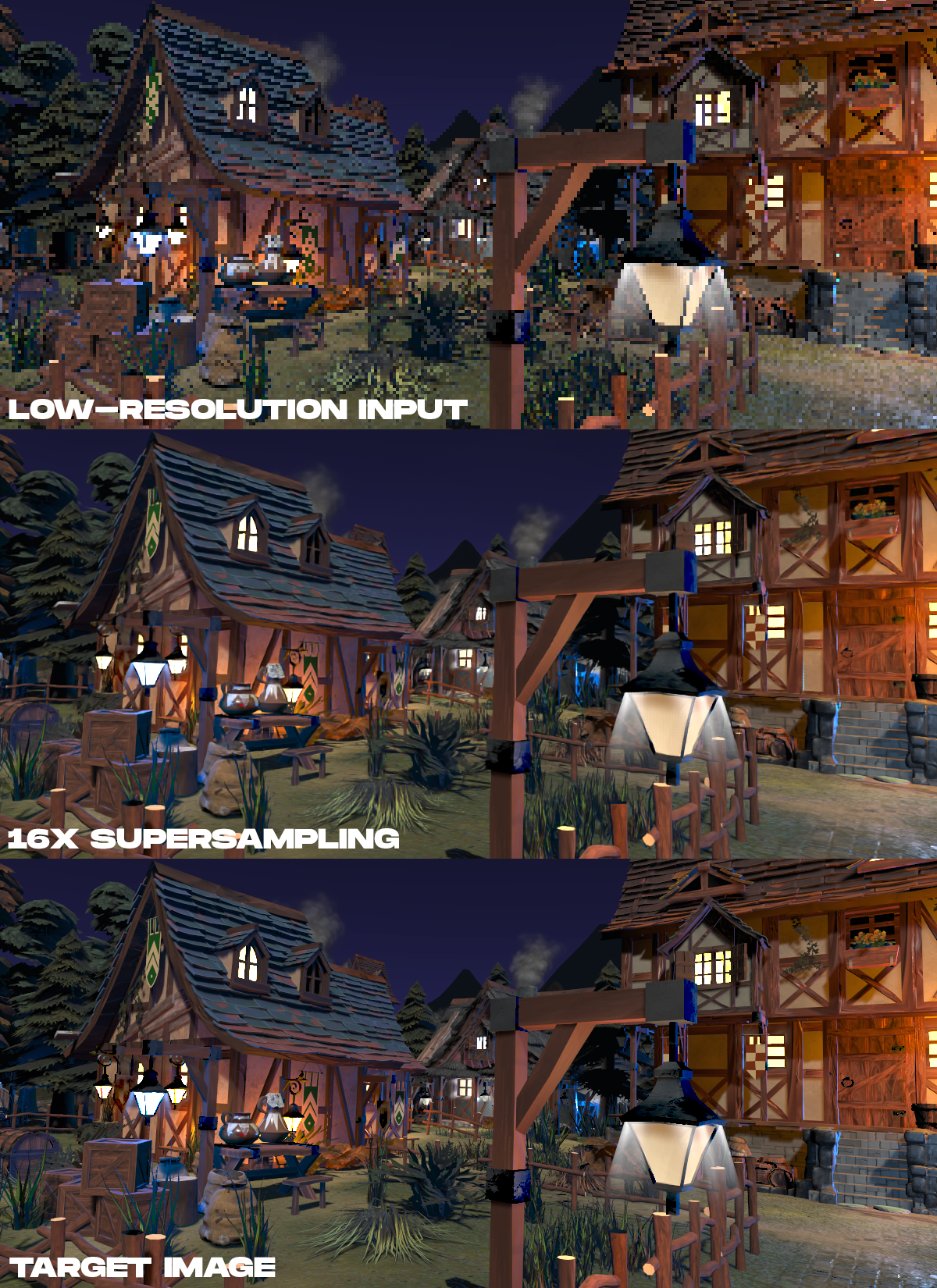

Exemples de résultats. De haut en bas, les données de couleur d'entrée rendues sont affichées à basse résolution, le résultat du suréchantillonnage par 16 fois effectué par la méthode proposée, et l'image cible haute résolution, qui a été rendue en temps non réel.

. , 16 , , , .

. , 16 , , , .

?

Le rendu neuronal a un potentiel énorme en AR / VR. Bien que cette tâche soit difficile, nous voulons inspirer d'autres chercheurs à travailler sur ce sujet. Alors que les fabricants d'écrans pour AR / VR s'efforcent d'obtenir des résolutions plus élevées, des fréquences d'images plus élevées et un photoréalisme, les techniques de suréchantillonnage neuronal pourraient être un moyen clé de récupérer des détails précis à partir de données de scène, plutôt que de rendre directement. Ce travail nous fait comprendre que l'avenir de la VR haute définition ne réside pas seulement dans les écrans, mais aussi dans les algorithmes nécessaires pour les piloter pratiquement.

Article technique complet: Neural Supersampling for Real-time Rendering , Lei Xiao, Salah Nouri, Matt Chapman, Alexander Fix, Douglas Lanman, Anton Kaplanyan, ACM SIGGRAPH 2020.

Voir également:

- " Rendu et optimisation dans le développement VR "

- " Physique en réseau dans la réalité virtuelle "