Le sujet de la mise à jour de la loi de Moore en trouvant des dépendances plus complexes de l'évolution des systèmes informatiques soulevées pour discussion est aujourd'hui bien compris par les chercheurs dans le domaine des technologies plasmoniques et nanophotoniques.

Important: la plupart des liens de l'article mènent à des documents en anglais. Il n'y a pas tellement de chercheurs nationaux en photonique en Russie, et ceux qui existent préfèrent être publiés en anglais.

Pour une étude complémentaire du sujet à votre guise autour d'une tasse de thé, vous êtes invité à écouter le reportage de Dmitry Fedyanin - l'un des principaux chercheurs russes sur l'application des technologies nanophotoniques aux systèmes informatiques.

Dmitry Fedyanin est chercheur senior au MIPT.

Et puis nous analyserons un article intéressant dans lequel un groupe d'auteurs propose un concept extrêmement original de la métrique de croissance de la productivité, une alternative à la loi de Moore classique. L'idée a mûri grâce à l'analyse des limitations physiques naturelles des technologies existantes pour le fonctionnement des cœurs de processeurs, ainsi qu'aux perspectives confirmées expérimentalement de nouveaux systèmes basés sur la nanophotonique.

Les demandes constantes du système industriel moderne pour améliorer l'efficacité des calculs et la bande passante de communication ont amené les technologies des semi-conducteurs à leurs limites dans leur état actuel. Cela a conduit à l'émergence de nouvelles technologies qui peuvent surpasser les solutions traditionnelles. On parle de préprocesseurs ou accélérateurs photoniques, de circuits hybrides électron-photon et de réseaux de neurones. Cependant, les efforts déployés pour décrire et prédire l'évolution des performances des systèmes informatiques ne permettent pas de prédire avec précision et donc d'expliquer le taux de développement réellement observé; c'est-à-dire que tous les indicateurs proposés finissent par s'écarter de leur trajectoire de développement plusieurs années après leur proposition initiale. Cet écart nécessite une métrique équilibrée,qui comprendrait un ensemble holistique de forces motrices derrière l'évolution des systèmes informatiques.

Le concept original d'une nouvelle métrique appelée Capability to Latency-Amount-Resistance (CLEAR) a été proposé par une équipe internationale de chercheurs (Shuai Sun, Vikram K. Narayana, Mario Miscuglio, Lionel C. Kimerling, Tarek El-Ghazawi, Volker J. Sorger). Selon les auteurs de l'article (voir ici), cette métrique couvre la dynamique des changements dans les taux de synchronisation, l'efficacité énergétique, la mise à l'échelle de la taille physique des ordinateurs et les coûts économiques. Selon les auteurs, CLEAR est aujourd'hui la seule métrique qui décrit correctement le développement historique des systèmes informatiques. Même avec des options différentes et des combinaisons technologiques mutuelles, CLEAR est cohérent avec le taux de croissance constant observé, y compris les technologies informatiques dominantes proposées pour une mise en œuvre dans le futur (prévision). CLEAR est présenté aux lecteurs comme un guide pour prédire quantitativement la croissance de la productivité des systèmes informatiques aujourd'hui et dans le futur.

Malgré le fait qu'en général l'évolution des performances de calcul est en constante augmentation, la vitesse de performance observée des dispositifs basés sur l'industrie des semi-conducteurs existante ralentit sensiblement, en particulier sur la technologie 14 nm (voir ici et ici ). Cela est dû à la fois aux contraintes physiques naturelles et aux coûts économiques croissants du processus de production industrielle continue de puces.

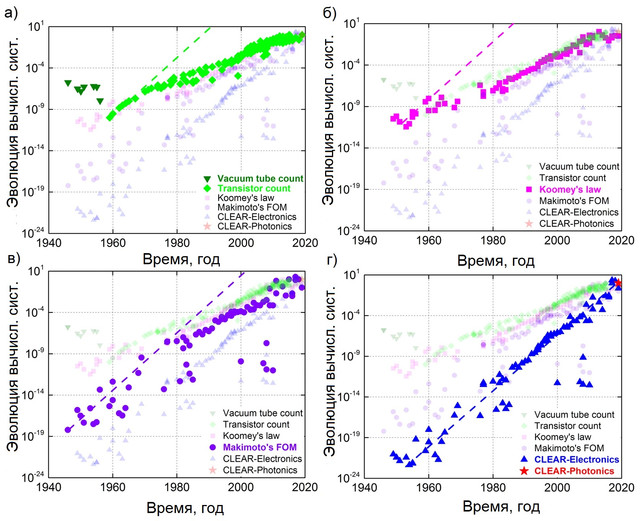

Pour ces raisons, la loi de Moore en tant que feuille de route pour l'industrie des semi-conducteurs a été révisée à plusieurs reprises pour supprimer ces obstacles (voir ici). De même, la dynamique de développement (dépendance au temps) d'autres relations de grandeurs physiques, comme l'indicateur de l'efficacité d'utilisation de la puissance de calcul ( loi de Kumi ) ou l'indicateur de puissance de calcul dérivé du rapport consommation d'énergie, taille et coût ( loi de Makimoto ), en conséquence, s'écarte tout de même par rapport au taux de développement technologique observé (Fig. 1) - la fonction du temps choisie dans l'indicateur (par exemple, multicœur, coût de fabrication) ne peut en pratique fournir une croissance exponentielle.

Par exemple, les performances d'un processeur à N cœurs sont toujours limitées par le rapport 1 / ((1-p) + p / N) , où p est le niveau de parallélisation (voir.ici ). Par conséquent, il devient de plus en plus difficile de suivre l'évolution des performances des systèmes informatiques si nous n'utilisons que la loi de Moore (ou d'autres métriques de prédiction existantes), dans laquelle un ou plusieurs facteurs déterminants sont utilisés pour décrire les performances d'un système informatique (voir ici ). En outre, les avantages des différentes implémentations matérielles (par exemple, électriques, optiques) changent de différentes manières au fil du temps, ce qui rend la prédiction évolutive encore plus difficile.

Par exemple, la photonique intégrée et éventuellement la plasmonique peuvent étendre certains canaux de communication sur une carte ou même sur une puce. En conséquence, les problèmes de dissipation de puissance thermique seront considérablement atténués, ainsi que l'augmentation de la bande passante de données avec la possibilité de surmonter la barrière d'efficacité numérique électronique à l'aide d'approches conceptuelles telles que le multiplexage par répartition en longueur d'onde ( WDM ), le moment angulaire optique ou des formats de modulation plus élevés tels que la modulation d'amplitude de polarisation. modulation (par exemple, QAM ), où la polarisation de phase et d'amplitude est utilisée simultanément (voir ici et ici ).

En ce qui concerne les compromis avec d'autres technologies, un transistor électronique avec un nœud de processus de 14 nm occupe une zone de 3 ordres de grandeur inférieure à un modulateur en anneau d'un microdisque photonique, cependant, la photonique fournit une interconnexion au niveau du canal sans fils de charge / décharge capacitifs, bien qu'elle soit synergique par rapport à ce qui précède caractéristiques uniques qui prennent en charge des taux de transfert de données jusqu'à Tbps (voir ici ). Figure 1. La nature du développement des systèmes informatiques, de 1946 à nos jours, peut être représentée sous la forme de quatre indicateurs différents: (a) loi de Moore - basée sur la croissance du nombre de composants sur une puce, mesurée en unités du nombre numérique de transistors; (b)

Loi de Kumi - reflète l'efficacité énergétique par unité de calcul, bit / (s * Joule); c) Indice de Makimoto, qui comprend «l'intelligence», la puissance, la taille et le coût du système - mesuré en unités de MIPS / (W * mm3 * $); et (d) le score CLEAR défini dans l'équation (4), qui prend en compte la latence du système en plus du score de Makimoto et les coûts économiques associés à l'introduction de la nouvelle technologie: MIPS / (s * W * mm3 * $). Les données Photonic CLEAR sont basées sur la prédiction d'Intel de la photonique du silicium. Les lignes pointillées représentent l'ajustement linéaire (logarithmique) basé sur le taux de croissance initial, avec un doublement de la productivité annuelle.

Selon les auteurs, l'indicateur à 5 facteurs CLEAR (dont le nom représente l'abréviation Capability-to-Latency-Energy-Amount-Resistance) est de loin le plus fiable pour décrire l'évolution des performances de calcul tout au long de la période historique connue, à partir du tout début de l'émergence des technologies informatiques. dans les années 40. et jusqu'à l'heure actuelle. Cet indicateur couvre à la fois les facteurs physiques et économiques associés au rythme de développement de diverses options informatiques. Ainsi, CLEAR peut être utilisé comme indicateur quantitatif indépendant de la technologie, car il comprend à la fois les dépendances physiques et économiques fondamentales.

Sur la base d'observations et d'analyses, les auteurs tirent deux conclusions clés:

- , ;

- ( ) , (.. CLEAR) ( ) .

Le développement de la physique fondamentale, la gestion de la technologie des semi-conducteurs et les coûts économiques nécessitent des changements et une adaptation constants afin de faire progresser progressivement la technologie des systèmes informatiques. Depuis la fondation de l'industrie des semi-conducteurs, la loi de Moore a changé plusieurs fois les facteurs sous-jacents: du comptage des transistors, l'industrie se déploie (premier mouvement) à l'empreinte et à la mise à l'échelle des transistors en raison des contraintes de taille des puces et de l'augmentation de la complexité globale du système (voir ici ).

Le deuxième saut s'est produit lorsque la fréquence d'horloge a trouvé ses limites en raison des contraintes de dissipation de densité de puissance décrites par la loi d'échelle de Dennard (voir ici). Alors que la mise à l'échelle des transistors approche les limites physiques fondamentales, le nombre de transistors continue d'augmenter à ce moment en raison du parallélisme mis en œuvre dans des architectures hétérogènes multicœurs et massivement parallèles. Cela augmente le goulot d'étranglement dans l'interconnexion, ce qui entraîne la nécessité de désactiver certaines zones de la puce ( "silicium noir" ). Le taux de croissance est donc passé d'un doublement initial tous les 12 mois à environ 24 mois maintenant.

Récemment, une nouvelle force motrice a émergé d'un domaine complètement différent qui influence l'évolution des systèmes informatiques et est la photonique intégrée et la nanophotonique hybridée, où le routage du signal lumineux est effectué par des composants photoniques intégrés passifs, tandis que les composants actifs électro-optiques sont amplifiés par de nouvelles solutions:

- matériaux reconfigurables;

- de fortes interactions de la lumière avec la matière, comme la plasmonique ou la photonique ENZ (epsilion-near-zero), fournissant ensemble une liaison de données et une bande passante dépassant l'électronique conventionnelle à deux niveaux: la puce et le cœur (voir ici ).

Pour ces nouvelles technologies, il n'est pas possible de compter simplement le nombre de composants par matrice ou de mettre à l'échelle l'encombrement et le coût comme une mesure distincte car elle ne reflète pas plus précisément le changement de performance réel. La tendance à l'émergence d'autres technologies, telles que celles utilisées dans les communications optiques, dans lesquelles plusieurs signaux de différentes longueurs d'onde sont emballés dans le même canal physique et améliorent ainsi l'utilisation du matériel, est également d'une grande importance. C'est un facteur important dans l'évaluation des performances du système. Par conséquent, une métrique holistique est nécessaire qui prend en compte plusieurs forces motrices pour fournir une comparaison précise de la contribution de différentes solutions technologiques à l'évolution des systèmes informatiques.

Un indicateur unique de l'évolution des systèmes informatiques

Pour obtenir une métrique indépendante de la technologie, les auteurs ont collecté des données sur les performances des ordinateurs de bureau, des ordinateurs portables, des appareils mobiles, des serveurs, des postes de travail et des supercalculateurs depuis les années 1940 et les ont comparées aux métriques traditionnelles (Figure 1).

En particulier, la loi de Moore prend le nombre de transistors comme seul facteur suffisant (équation 1), alors que la loi de Kumi repose déjà sur deux facteurs: l'énergie et le nombre de calculs, résumant ainsi la base de l'indicateur, mesurée en bits / (s * J) (équation 2). Des millions d'instructions par seconde (MIPS) par unité de taille-coût-puissance sont connus sous le nom de métrique Makimoto, déjà définie comme une métrique à 4 facteurs (équation 3).

Loi de Moore = Nombre de transistors [qté] (1)

Loi de Kumi= Calculs / Énergie [bits / (s * J)] (2)

Score Makimoto = Intelligence / (Taille * Coût * Puissance) [MIPS / (mm3 * $ * W)] (3)

Les valeurs de ces trois indicateurs montrent un modèle de croissance similaire : La tendance haussière suit bien leurs données brutes, mais seulement pendant une période limitée, et finit par s'en écarter. Cela suggère que les facteurs sous-jacents n'ont pas réussi à saisir pleinement la force motrice réelle qui domine l'évolution des systèmes informatiques.

Analyse des lignes de tendance sur la Fig. 1 montre que le nombre de transistors à l'origine (années 1950-1960) reflète bien la loi de Moore de la double croissance annuelle (ligne vert clair en pointillés, Fig. 1). Cependant, la mise à l'échelle de l'efficacité énergétique (c'est-à-dire la loi de Kumi) est devenue le facteur dominant au cours de la période suivante (1960-1970), car le simple ajout de transistors était limité par la taille et la complexité de la puce. Pour cette raison, la loi de Moore a commencé à s'écarter de la tendance 2X / an, tandis que la loi de Makimoto a conservé son taux de croissance d'origine. Depuis la fin des années 1970, des facteurs tels que la taille et la mise à l'échelle de la puissance ont progressivement atteint leur limite en raison de problèmes liés aux processus de fabrication nettement plus complexes, aux fuites d'énergie et à la dissipation thermique.Parallèlement à l'avènement du parallélisme (c'est-à-dire des processeurs multicœurs) et de la mise à l'échelle économique sur le marché, la métrique de Makimoto finit par s'écarter également (depuis 1978). Les lignes pointillées illustrées à la Fig. 1 représentent les projections initiales de la croissance de la productivité pour chaque loi. Ces lignes de tendance montrent comment chaque facteur supplémentaire introduit par les lois correspondantes affecte sa propre métrique de prévision d'origine, représentée comme un écart par rapport à la prévision d'origine. En considérant cette tendance comme une limite supérieure théorique de la vitesse de développement technologique, il est désormais possible de comprendre si la tendance «revendiquée» est réellement «réelle» ou non. Autrement dit, si la loi actuelle est la raison du ralentissement du développement technologique ou si de nouveaux facteurs de productivité commencent à dominer.également rejeté (depuis 1978). Les lignes pointillées illustrées à la Fig. 1 représentent les projections initiales de la croissance de la productivité pour chaque loi. Ces courbes de tendance montrent comment chaque facteur supplémentaire introduit par les lois respectives affecte sa propre métrique de prévision d'origine, représentée comme un écart par rapport à la prévision d'origine. En considérant cette tendance comme une limite supérieure théorique de la vitesse de développement technologique, il est désormais possible de comprendre si la tendance «revendiquée» est réellement «réelle» ou non. Autrement dit, si la loi actuelle est la raison du ralentissement du développement technologique ou si de nouveaux facteurs de productivité commencent à dominer.également rejeté (depuis 1978). Les lignes pointillées illustrées à la Fig. 1 représentent les projections initiales de la croissance de la productivité pour chaque loi. Ces lignes de tendance montrent comment chaque facteur supplémentaire introduit par les lois correspondantes affecte sa propre métrique de prévision d'origine, représentée comme un écart par rapport à la prévision d'origine. En considérant cette tendance comme une limite supérieure théorique de la vitesse de développement technologique, il est désormais possible de comprendre si la tendance «revendiquée» est réellement «réelle» ou non. Autrement dit, si la loi actuelle est la raison du ralentissement du développement technologique ou si de nouveaux facteurs de productivité commencent à dominer.comment chaque facteur supplémentaire introduit par les lois pertinentes affecte sa propre métrique de prévision d'origine, représentée comme un écart par rapport à la prévision d'origine. En considérant cette tendance comme une limite supérieure théorique de la vitesse de développement technologique, il est désormais possible de comprendre si la tendance «revendiquée» est réellement «réelle» ou non. Autrement dit, si la loi actuelle est la raison du ralentissement du développement technologique ou si de nouveaux facteurs de productivité commencent à dominer.comment chaque facteur supplémentaire introduit par les lois pertinentes affecte sa propre métrique de prévision d'origine, représentée comme un écart par rapport à la prévision d'origine. En considérant cette tendance comme une limite supérieure théorique de la vitesse de développement technologique, il est désormais possible de comprendre si la tendance «revendiquée» est réellement «réelle» ou non. Autrement dit, la loi actuelle est-elle la raison du ralentissement du développement technologique, ou de nouveaux facteurs de productivité commencent-ils à dominer.si la loi actuelle est la raison du ralentissement du développement technologique ou si de nouveaux facteurs de productivité commencent à dominer.si la loi actuelle est la raison du ralentissement du développement technologique ou si de nouveaux facteurs de productivité commencent à dominer.

Ainsi, à ce jour, il n'y a pas d'indicateur clair connu qui puisse:

- expliquer les récents changements de performance;

- fournir des conseils sur la prévision des performances futures.

La métrique CLEAR introduite par les auteurs comprend des facteurs de productivité provenant d'une variété d'options technologiques, qui incluent à la fois des contraintes physiques et économiques. L'affirmation principale des auteurs est que les facteurs qui composent CLEAR ne sont pas choisis au hasard, mais sont fondamentaux pour les tendances technologiques et économiques:

CLEAR = Capacité / (Retard * Énergie * Quantité * Résistance) [[MIPS / (s * W * mm3 * $)]] (4)

ou dans l'original:

CLEAR = (Capacité) / (Latence * Énergie * Montant * Résistance) [[MIPS / (s * W * mm3 * $)]]

Les auteurs, ayant formulé une formule pour l'indicateur CLEAR, déterminent un taux de croissance constant tout au long de l'évolution des systèmes informatiques, couvrant la croissance des performances de 4 ordres de grandeur sur sept décennies. De plus, le taux de développement réel observé a régulièrement doublé tous les 12 mois. Ce score à 5 facteurs est basé sur le concept de performance et de coût. CLEAR peut être appliqué au niveau de l'appareil, du schéma et du système.

Par exemple, au niveau du système, CLEAR est structuré comme suit: la

capacité C est la performance du système mesurée par le produit de millions d'instructions par seconde (MIPS) et de la longueur des instructions;

Délai minimum Lse réfère à la fréquence d'horloge et est limitée par la fenêtre de temps entre deux cycles d'horloge adjacents;

L'énergie E représente le niveau de consommation d'énergie pour qu'un tel système fonctionne afin d'obtenir une certaine puissance, exprimée en unités de watts;

La quantité A représente le volume spatial (c'est-à-dire la taille physique) du système et est fonction de la dimension du processus;

Resistance R quantifie la résistance économique à l'adoption de nouvelles technologies par le marché. Fondamentalement, les auteurs prennent un modèle économique basé sur la courbe d'expérience du Boston Consulting Group (BCG) qui explique la relation entre la production totale et le coût unitaire (voir ici ).

Les auteurs établissent une relation linéaire entre l'échelle logarithmique de l'unité de prix et de temps, puis confirment cette relation en comparant les données historiques (voir ici et ici ) avec CLEAR.

Les auteurs notent que la métrique MIPS en tant que mesure des performances est remplacée par des métriques telles que les opérations en virgule flottante (FLOPS) en raison de sa sensibilité au jeu d'instructions sous-jacent. CLEAR a été appliqué à diverses architectures de processeur à travers l'histoire pour lesquelles d'autres mesures de performance ne sont pas disponibles dans les suites de référence connues (telles que SPEC ou LINPAC). Cependant, pour faire de MIPS une métrique de performance représentative, les auteurs ont pondéré (c'est-à-dire multiplié) chaque instruction par sa longueur, donnant ainsi la métrique globale relative en bits / s.

Tendances du développement des systèmes informatiques

Après avoir comparé les quatre indicateurs illustrés à la Fig. 1, nous constatons que lorsqu'une métrique comprend des facteurs plus pertinents, son point initial de déviation par rapport à la tendance d'origine se produit plus tard. Contrairement à CLEAR, qui montre la correspondance exacte des données dans tout. Ainsi, nous constatons empiriquement que les performances de calcul augmentent constamment à un taux fixe d'environ un doublement par an et sont indépendantes de la technologie. Lorsque nous testons de nouvelles machines de calcul, telles que celles basées sur la photonique intégrée, comme prévu par IBM (voir ici ), nous constatons que de telles technologies pourraient en effet poursuivre la tendance évolutive du développement avec une double croissance annuelle (étoiles rouges sur la figure 1).

De plus, vous constaterez que l'écart relatif par rapport à la ligne de tendance 2X / an peut être utilisé pour classer une métrique du système informatique. Par exemple, les frais généraux supplémentaires (c'est-à-dire la taille physique, la concurrence, le refroidissement, les faibles économies d'échelle et les coûts de fabrication) sur les supercalculateurs montrent leurs pires valeurs CLEAR par rapport à tous les autres types d'ordinateurs, tels que les ordinateurs portables et les appareils mobiles, malgré leur productivité plus élevée (cercles en pointillés, Fig. 1 c, d). Le parallélisme élevé des technologies multicœurs utilisées dans les supercalculateurs a été remis en cause par le retour du calcul à l'énergie décrite dans la loi d'Amdahl (voir ici). Si les supercalculateurs fournissent des performances pétaflopiques, l'ensemble de l'infrastructure ressemble à une infrastructure informatique d'il y a cinq à trente ans, ce qui remet en question l'avenir de son évolutivité.

Analyse CLEAR

Pour avoir une compréhension plus détaillée de l'impact relatif de chacun des 5 facteurs CLEAR, les auteurs ont décomposé l'indicateur en facteurs individuels, opposés les uns aux autres, pour révéler les forces motrices réelles au fil du temps.

Combinaisons de facteurs utilisés dans la Fig. 2 représentent C contre LEAR, CLE contre AR et CLEA contre R (Fig. 2, C = capacité, L = retard, E = énergie, A = quantité, R = résistance). De plus, le taux d'exclusion C 'est indiqué par rapport à tous les autres facteurs, puisque le seul facteur d'échelle dans les premières années de l'industrie des semi-conducteurs est le nombre de composants par puce. Il est important de noter que les positions relatives de chaque point de données sont plus importantes que les valeurs exactes dans les deux axes X et Y, et donc les deux axes sont normalisés à un, ce qui permet de comparer chaque cas.

Étant donné que les zones ombrées bleues et rouges représentent respectivement des zones de croissance linéaire et de saturation, les décalages successifs du point de pivot vers la droite avec un nombre croissant de facteurs pris en compte pour l'axe X (c'est-à-dire le temps relatif) sont facilement détectés. Pour comprendre cela, les facteurs sur l'axe X peuvent être considérés comme la force motrice de l'indicateur, tandis que les valeurs sur l'axe Y indiquent les conditions de suivi réelles des forces motrices en question. Par conséquent, le domaine linéaire signifie que les facteurs sur l'axe X dominent toujours le développement de la technologie, tandis que la force motrice de la technologie commence à se déplacer vers d'autres facteurs lorsqu'elle entre dans le domaine de la saturation. Ce résultat coïncide avec l'observation faite que l'évolution d'un système informatique croît toujours à ce rythme constant, et un écart avec l'indicateur ne se produit que silorsque d'autres forces motrices apparaissent.

Figure 2. Analyse de la force motrice CLEAR.

L'indicateur CLEAR est divisé en quatre groupes, dont chacun se compose de deux parties: un coefficient qui démontre les facteurs de développement de la technologie (axe X) et un facteur de divulgation, qui montre la capacité de suivre un facteur sélectionné ou une combinaison de facteurs (axe Y). Les résultats montrent qu'un écart ultérieur par rapport au développement normalisé est observé lorsque davantage de facteurs sont pris en compte pour décrire les performances des systèmes informatiques. (a) Vitesse insaisissable C 'par rapport au coût de retard-énergie-quantité-coût (LEAR); (b) Capacité C contre retard-énergie-quantité-coût (LEAR); (c) Capacité à retarder l'énergie (CLE) par rapport à la quantité-coût (AR); (ré)Delay-Energy-Amount (CLEA) Capacité vs Coût R. Les axes X et Y sont normalisés à un pour une meilleure comparaison. Les zones de croissance linéaire et de saturation sont respectivement couvertes d'ombres bleues et rouges.

Application CLEAR

Il est important que la capacité de suivre de manière transparente l'évolution des différentes technologies permette à CLEAR de prédire les futures substitutions technologiques et de déterminer la norme pour les technologies futures, y compris leur hybridation, par exemple, entre l'électronique et la photonique (voir ici , ici , ici et ici ).

Changement technologique

L'interconnexion photonique dans la puce a récemment montré une capacité de transfert de données élevée (supérieure aux interconnexions électriques conventionnelles) lorsqu'elle est hybridée avec des dispositifs plasmoniques actifs (voir ici ). Bien que le routage optique des données soit perçu comme une solution possible pour éliminer les goulots d'étranglement de communication entre les cœurs de calcul et qu'il soit couramment utilisé dans les centres de données et les supercalculateurs, la photonique intégrée n'a pas encore été mise en œuvre dans le secteur grand public. Cela semble surprenant au début, car des études antérieures ont suggéré des performances supérieures dans l'hybridation photon-plasmon. La question est donc: pourquoi la photonique intégrée n'est-elle pas utilisée dans les produits du marché de masse?

Pour répondre à cette question, comparons CLEAR pour les liaisons électroniques avec des liaisons hybrides photon-plasmon en fonction du temps d'évolution et de la distance de propagation du signal (Fig. 3). Ici, la manipulation de la lumière est réalisée à l'aide de blocs de construction plasmoniques "actifs" (source, modulateur, détecteur, interrupteur) (voir ici et ici), tandis que la propagation de la lumière est traitée par une photonique à faibles pertes basée sur des plates-formes de silicium ou de nitrure de silicium. L'électronique est comparée à cette variante d'un hybride plasmon-photon, car la séparation des fonctionnalités actives et passives dans un hybride plasmon-photonique se traduit par des performances plus élevées (c.-à-d. Une latence plus faible, un débit plus élevé, une fonction d'énergie par bit plus faible). Les courbes de surface résultantes montrent que l'électronique CLEAR et la photonique plasmonique ont une ligne de seuil de rentabilité (intersection des surfaces, Fig. 3), qui est mise à l'échelle à la fois dans le temps et dans la distance de propagation du signal. Fait intéressant, même aujourd'hui, l'électronique est toujours en avance sur la photonique avec une taille de puce de 1 cm à la longueur du transfert d'informations.Par conséquent, l'électronique est toujours utilisée commercialement sur les cristaux, contrairement à la photonique. Les investissements et les développements dans l'électronique au cours du dernier demi-siècle ont ainsi créé une durabilité technologique (barrières à l'entrée) pour d'autres technologies. Cette mise à l'échelle a conduit le transistor à ne coûter qu'un milliardième du coût d'un dispositif photonique, voire moins.ici ). Figure 3. Comparaison des indicateurs CLEAR de l'interconnexion électrique (bleu) et hybride photon-plasmonique (rouge) sur une puce, en fonction de la longueur de la connexion et du moment du développement technologique. La taille de la puce = 1 cm, la longueur du lien et l'année d'écriture (2019) sont marquées en rouge. Les modèles suivants ont été déployés; a) un modèle de bande passante basé sur le nombre de transistors et de dispositifs optiques sur une puce, qui peut être considéré comme le modèle original de la loi de Moore; b) un modèle d'efficacité énergétique basé sur la loi de Kumi, qui est limité par la limite de Landauer kB * T * ln (2) ≈ 2,75 sJ / bit, (kB est la constante de Boltzmann; T est la température); à)

un modèle de durabilité économique basé sur des modèles de développement technologique jusqu'en 2019, selon lequel le coût d'une chaîne électronique est inférieur à un milliard ou un millionième du coût d'une chaîne hybride; d) un modèle de concurrence (post-2006) décrivant l'architecture multicœur et les limites du «silicium noir» dans l'interconnexion électrique. Le point jaune est situé à l'intersection des deux technologies dans la période de 2019, lorsque la technologie Hybrid Plasmon-Photonics vient d'atteindre la taille d'une puce et commence à montrer les meilleures performances CLEAR sur une puce.

À mesure que la technologie et les processus de fabrication s'améliorent, la distance de rentabilité de productivité pour un prix unique (c'est-à-dire CLEAR) pour la transmission de petites quantités d'informations diminue en raison de la courbe de coût plus plate de l'électronique par rapport à la photonique, cette dernière suivant une loi de puissance au fil du temps. De plus, le coût commence à augmenter avec la mise à l'échelle de la densité de l'interconnexion électrique, associée à des surcoûts dus à des problèmes physiques fondamentaux sur des nœuds de transistors inférieurs à 10 nm (voir ici ). En revanche, une interconnexion hybride photon-plasmonique est actuellement coûteuse en raison de la mise à l'échelle naissante qui est l'objectif de l'American Institute for Integrated Photonics Manufacturing ( AIM Photonics). La mise à l'échelle est désormais possible grâce aux progrès récents de la nanophotonique; le concept d'amélioration de l'interaction de la lumière avec la matière permet de créer des longueurs d'onde compactes dans les dispositifs optoélectroniques avec les avantages d'un rendement énergétique élevé et d'une vitesse de fonctionnement élevée grâce à une faible capacité électrique (voir ici ). En conséquence, la distance de rentabilité entre l'électronique et les technologies hybrides photon-plasmon devrait se déplacer de plus en plus courtes distances à mesure que nous nous déplaçons le long de la chronologie. Par exemple, la puce photonique au silicium CMOS démontrée par IBM en 2015 est proche du seuil de rentabilité (voir ici). La photonique intégrée ne pourra remplacer l'électronique que si la vitesse de ses performances CLEAR peut rattraper la tendance générale évolutive des systèmes informatiques.

conclusions

Comme nous l'avons vu à partir du raisonnement ci-dessus, CLEAR peut être considéré comme un indicateur technique et économique universel non seulement en raison de sa large applicabilité hiérarchique (appareils, interconnexion, niveaux système), mais aussi en raison de sa capacité à s'adapter à une application technologique spécifique. Par exemple, pour l'hybridation de réseau dans un cristal. Non seulement CLEAR peut être utilisé comme mesure de performance pour prédire l'évolution d'une plate-forme technologique, mais il est également possible de comparer la capacité globale d'une ou de plusieurs plates-formes technologiques dans différentes conditions d'utilisation en ajoutant des poids à chaque facteur de l' équation (4) .

Dans cette métrique CLEAR initialement proposée, les cinq facteurs affectent linéairement la valeur CLEAR, cependant, pour une application particulière qui dépend de manière critique d'un facteur particulier (ou d'une combinaison de facteurs), chaque facteur de CLEAR peut être pondéré différemment. Pour assurer la comparabilité, même parmi ces métriques «accordées», il peut être nécessaire de s'assurer que la somme de tous les coefficients est égale à 5, similaire à la normalisation à l'unité, comme l'intégrale de la fonction d'onde en mécanique quantique. Par exemple, un système d'appareil portable peut avoir de fortes contraintes d'énergie (E) et de volume (A), résultant en une métrique CLEAR C 0,8 L 0,8 E 1,2 A 1,2 Rpour une telle technologie. En effet, il serait intéressant de comparer les tendances de différents paramètres réglés avec la capacité de prédire les technologies futures.

De plus, on peut percevoir les futurs canaux ou réseaux de communication comme étant dynamiquement reconfigurables, permettant à la puce de changer son point de fonctionnement idéal en fonction de l'application actuelle, de la charge, du mode d'alimentation, etc. Ces systèmes dynamiques pilotés par les données ( DDDAS) sont en demande en raison de leur capacité de traitement cognitif combinée. On s'attend à ce que l'adaptation des systèmes informatiques à une variété de contraintes soit en synergie avec les systèmes émergents de théorie de l'information tels que le calcul neuromorphique et le calcul des réservoirs, où l'adaptation et le réglage des «poids» permettent l'apprentissage automatique, l'arithmétique du calcul résiduel ou même la photonique au silicium embarquée de l'informatique optique. (voir ici , ici , ici et ici ).

Il convient également de noter que, comme cela s'est produit avec toutes les mesures de prédiction de performances précédentes pour les plates-formes technologiques, CLEAR peut éventuellement commencer à s'écarter de sa tendance d'origine lorsque des caractéristiques physiques plus uniques sont utilisées dans la nouvelle technologie. À l'heure actuelle, CLEAR couvre de manière adéquate tous les facteurs de performance dominants dans les technologies modernes, ce qui permet de prédire avec précision l'évolution des systèmes informatiques au moment de la rédaction de cet article.

Ainsi, CLEAR peut être non seulement un outil de cartographie et de prévision des perspectives, mais il peut également ouvrir la voie à des plates-formes de contrôle informatique intelligentes et cognitives basées sur le matériel, où les compromis entre performances et coûts sont examinés et optimisés en temps réel.

En conséquence, CLEAR peut être considéré comme une nouvelle loi de Moore, qui reflète intégralement les tendances du développement des technologies à divers niveaux d'application hiérarchique.