Figure: Photo 1: Photo Nikon D610 avec objectif AF-S 24-120 mm f / 4 à 24 mm f / 8 ISO100

Quelles sont les étapes de base pour le rendu d'une image RAW à bas niveau? Dans cet article, je vais décrire ce qui se passe sous le capot des convertisseurs d'appareils photo numériques, où les données brutes sont converties en une image RAW visible - parfois appelée rendu. Pour démontrer la transformation des informations de l'image à chaque étape, j'utiliserai la photographie présentée au début de l'article, prise sur un Nikon D610 avec un objectif AF-S 24-120mm f / 4 et des réglages 24mm f / 8 ISO100.

Le rendu est la conversion et l'édition RAW

Le rendu peut être divisé en deux processus principaux: la conversion RAW et l'édition. La conversion RAW est nécessaire pour transformer les données d'image brutes dans un format standard que l'édition d'image, les programmes de visualisation et les périphériques peuvent comprendre. En règle générale, cela se fait à l'aide d'un espace colorimétrique RVB tel qu'Adobe ou sRVB.

Les éditeurs prennent des informations sur une image dans un espace colorimétrique standard et y appliquent des ajustements pour rendre l'image plus «adaptée» ou «agréable» pour le photographe.

Un exemple de convertisseur RAW propre est dcraw par David Coffin. Un exemple d'éditeur propre est Photoshop d'Adobe. La plupart des convertisseurs RAW combinent en fait des fonctions de conversion RAW avec des fonctions d'édition (par exemple, Capture NX, LR, C1).

7 étapes pour la conversion RAW de base

La limite entre la fin de la conversion et le début de l'édition est plutôt floue, mais selon la façon dont vous les séparez, il n'y a que 7 étapes dans le processus principal de conversion d'un fichier RAW en un espace colorimétrique standard - sRGB par exemple. Les étapes ne doivent pas nécessairement être dans cet ordre, mais la séquence suivante est assez logique.

- Chargez des données linéaires à partir d'un fichier RAW et soustrayez les niveaux de noir.

- Équilibrez les blancs.

- Corrigez la luminosité linéaire.

- Recadrer les données d'image.

- Restaurez l'image d'origine à partir de la mosaïque ( démolition ).

- Appliquez des transformations et des corrections de couleur.

- Appliquez le gamma.

Dans la conversion RAW de base, le processus reste linéaire jusqu'à la toute fin. Idéalement, la courbe gamma de la dernière étape est corrigée par l'appareil qui affiche l'image, de sorte que le système de traitement d'image du début à la fin - du moment où la lumière atteint le capteur au moment où la lumière atteint l'œil - est approximativement linéaire. Si vous avez besoin de rendre "honnêtement" une image telle qu'elle est arrivée au capteur, c'est tout ce dont vous avez besoin d'un convertisseur RAW.

+ Tone Mapping: s'adapte à la plage dynamique du périphérique de sortie

Cependant, comme nous le verrons, la conversion de base des fichiers RAW dans les appareils photo numériques existants ne donne presque jamais un résultat satisfaisant, car la plupart des périphériques de sortie (papier photographique, moniteurs) ont des rapports de contraste inférieurs à ce que de bons appareils photo numériques peuvent capturer. Par conséquent, en pratique, il est nécessaire d'effectuer une correction de tonalité pour ramener la large plage dynamique de la caméra à la plage dynamique étroite de l'appareil. Il peut s'agir d'une simple courbe de contraste - ou d'un mappage de tons plus complexe avec des ajustements locaux et globaux pour les ombres, les hautes lumières, la clarté, etc. (curseurs standard dans les éditeurs commerciaux et les logiciels de conversion). Ceci est généralement fait lors de l'édition d'un rendu - mais si vous visez une couleur "précise",Idéalement, le mappage des tons devrait faire partie de la 6ème étape de l'étalonnage des couleurs lors de la conversion RAW (voir.un excellent site par Alex Torgera décrivant les profils de couleurs).

Après sept étapes de conversion de base, vous pouvez accéder à l'éditeur afin de corriger objectivement les imperfections identifiées dans un cadre particulier et dans une sortie d'image particulière vers le périphérique de sortie - et également rendre l'image subjectivement plus agréable à l'œil de l'artiste. Par exemple, corriger la distorsion de l'objectif et l'aberration chromatique latérale; appliquer la réduction du bruit; appliquer un filtre de netteté. Il peut être préférable d'exécuter certaines de ces fonctions dans l'espace linéaire avant certaines étapes de conversion RAW, mais elles sont généralement optionnelles et peuvent être effectuées de la même manière dans l'éditeur après le rendu dans l'espace gamma.

Dans cet article, nous nous concentrerons sur la partie de rendu de base de la conversion RAW, en laissant le mappage de tons et l'édition pour une autre fois.

1. Chargez les données linéaires du fichier RAW et soustrayez les niveaux de noir

La première étape de la conversion RAW consiste simplement à charger les données du fichier RAW dans la mémoire. Étant donné que les formats RAW diffèrent d'un appareil photo à l'autre, la plupart des convertisseurs utilisent des variantes des programmes open source LibRaw / dcraw . Les commandes suivantes pour LibRaw ou dcraw reconditionneront le RAW dans un TIF 16 bits linéaire qui peut être lu par des applications de traitement (Matlab, ImageJ, PS, etc.). Il n'est pas nécessaire d'installer le programme, vous avez juste besoin que le fichier exécutable soit dans la variable PATH ou dans le même répertoire.

unprocessed_raw -T yourRawFileou

dcraw -d -4 -T yourRawFileSi votre capteur d'image est bien conçu et conforme aux spécifications, les données enregistrées seront dans une relation linéaire avec l'intensité lumineuse, mais elles sont généralement stockées avec des biais dépendant de la caméra et du canal. T.N. les niveaux de noir ont des magnitudes de plusieurs centaines ou milliers de DN, et ils doivent être soustraits des données brutes d'origine afin que l'intensité de zéro pixel corresponde à zéro lumière. dcraw avec la ligne de commande ci-dessus le fera pour vous (bien qu'avec des valeurs moyennes). Lorsque vous utilisez un_raw, vous devez connaître le niveau de noir de votre caméra et le soustraire en conséquence (ou vous pouvez utiliser le paramètre –B, qui, cependant, ne semble pas être pris en charge dans la version actuelle de LibRaw).

Il s'avère que Nikon soustrait les niveaux de noir de chaque canal avant d'écrire dans les fichiers D610, donc pour notre cadre de référence, l'une ou l'autre commande fonctionnera. Je l'ai chargé avec la commande dcraw -d -4 -T, qui met également à l'échelle les données à 16 bits (voir l'étape 3 pour la correction de la luminosité ci-dessous).

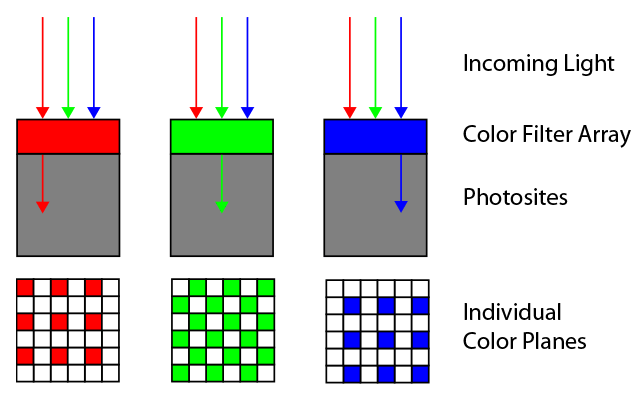

Les données chargées à ce stade sont simplement l'intensité de l'échelle de gris de l'image. Cependant, ils ont une correspondance avec la position sur la matrice associée à un certain filtre de couleur sous lequel il se trouve. Dans les matrices Bayer, il y a des rangées de couleurs rouges et vertes alternées - et vertes et bleues - comme indiqué sur l'image. L'ordre exact est déterminé par le premier quartet de la zone active de la matrice - dans ce cas, il s'agit de RGGB, mais trois autres options sont également possibles.

Fig 2: Matrice de filtre couleur Bayer: disposition RGGB.

La matrice Bayer pour le D610 a une disposition RGGB. Les données brutes à ce stade ressemblent à une image en noir et blanc sous-exposée:

Fig. 3: Étape 1: Image brute linéaire avec soustraction des niveaux de noir. Il devrait être aussi brillant que la photo suivante. 4. Sinon, votre navigateur ne gère pas correctement les couleurs (j'utilise Chrome et il ne les gère évidemment pas correctement).

Si la photo est noire, votre navigateur ne sait pas comment afficher les données de ligne correctement étiquetées. Fait intéressant, l'éditeur WordPress affiche correctement l'image, mais elle n'a pas l'air correcte lorsqu'elle est publiée sur Chrome (note: cela a finalement été corrigé en 2019) [article 2016 / env. trad.]. Voici à quoi devrait ressembler cette image:

Fig. 4: même photo, mais en échelle de gris CFA

Voici à quoi ressemblent les données linéaires CFA directement dans le fichier. Cela semble un peu sombre, car j'ai décalé l'exposition vers la droite pour ne pas couper les reflets de la cascade - nous corrigerons cela plus tard, lors de l'étape de réglage linéaire de la luminosité.

L'image ressemble à un noir et blanc à part entière en raison de sa petite taille, mais en réalité ce n'est pas le cas: même dans des zones également éclairées, la pixellisation est visible. Cela est dû au fait que les filtres de couleur voisins, ayant une sensibilité spectrale différente, collectent différentes informations sur les couleurs. Ceci est facilement visible lorsque l'image est agrandie. Voici à quoi ressemble la zone de l'image juste en dessous de la carte WhiBal avec un grossissement jusqu'à 600%:

Figure 5: La pixellisation CFA est visible sur la carte uniformément grise (en haut) et sur les feuilles colorées.

2. Données de balance des blancs

En raison de la distribution spectrale de l'énergie de la source lumineuse (dans ce cas, le ciel est partiellement couvert par des nuages dont la lumière pénètre à travers le feuillage) et de la sensibilité spectrale des filtres situés sur la matrice, différents pixels colorés enregistrent proportionnellement des valeurs plus ou moins élevées même sous le même éclairage. Ceci est particulièrement évident dans les parties neutres de l'image, où il semblerait que les mêmes valeurs moyennes devraient apparaître sur tous les plans de couleur. Dans ce cas, sur la carte gris neutre, les pixels rouges et bleus ont enregistré des valeurs de 48,8% et 75,4% de la valeur verte, respectivement, de sorte qu'ils apparaissent plus foncés.

L'étape suivante consiste donc à appliquer la balance des blancs aux données CFA linéaires en multipliant chaque pixel rouge par 2,0493 (1 / 48,8%) et chaque pixel bleu par 1,3256 (1 / 75,4%). En termes Adobe, nous obtenons une image en noir et blanc neutre pour la caméra. Ensuite, il est garanti, à l'exception du bruit, que tous les pixels montreront les mêmes valeurs linéaires sur les parties neutres de l'image.

Figure: 6: Après l'équilibrage des blancs, la pixellisation de la carte grise disparaît, mais elle est toujours visible sur les objets colorés.

Voyez comment la pixellisation en haut de l'image a disparu - une carte gris neutre a été utilisée pour l'étalonnage. Mais, bien sûr, la pixellisation n'a pas disparu des objets couleur: les informations sur les couleurs sont stockées dans la différence entre les intensités des trois canaux.

3. Correction de la luminosité linéaire

La plupart des appareils photo numériques modernes avec objectifs interchangeables fournissent des données brutes en 12 à 14 bits linéaires. La profondeur de bits standard des fichiers (jpeg, TIFF, PNG) est généralement donnée sous la forme d'un multiplicateur de 8, et 16 bits est la profondeur préférée de la plupart des éditeurs aujourd'hui. Nous ne pouvons pas simplement prendre des données 14 bits avec des niveaux de noir soustraits et les stocker en 16 bits - tout tombera dans les 25% inférieurs de la plage linéaire et sera trop sombre. Idéalement, nous souhaitons découper les données après l'équilibrage des blancs et la soustraction du noir pour les adapter aux données découpées dans un fichier 16 bits, et les mettre à l'échelle en conséquence (voir étape 4). Un moyen simple de convertir grossièrement les données consiste simplement à multiplier les données 14 bits par 4, en les mettant à l'échelle à 16 bits. C'est exactement ce qui a été fait à l'étape 1 après avoir soustrait le noir (dcraw -d -4 -T le fait automatiquement,et avec un_raw, vous devrez le faire manuellement).

En parlant de mise à l'échelle, nous pourrions également vouloir modifier notre luminosité. Cette étape est subjective et ne vaut probablement pas la peine d'être effectuée si vous recherchez un rendu "honnête" d'une image, telle qu'elle est apparue sur le capteur et enregistrée dans un fichier RAW. Cependant, personne ne parvient à perfectionner l'exposition, et différents appareils photo mesurent souvent le gris moyen à différents pourcentages des données brutes, il est donc utile de pouvoir ajuster la luminosité. Par conséquent, de nombreux convertisseurs se réfèrent aux curseurs relatifs comme «compensation d'exposition» ou «compensation d'exposition». Adobe a une étiquette DNG associée qui normalise le compteur d'exposition pour différentes caméras, BaselineExposure. Pour le D610, il est de 0,35 pas.

Notre image est un peu sombre à mon goût, et la carte WhiBal, qui devrait être réfléchissante à 50%, n'est qu'à 17% à pleine échelle. La correction de luminance linéaire est la multiplication de chaque pixel des données par une constante. Si nous considérons que dans cette image nous n'avons pas besoin de conserver les zones les plus lumineuses de l'image avec une luminosité supérieure à 100% de la lumière blanche diffusée, alors cette constante dans cet exemple sera 50/17, soit environ 1,5 pas de correction. Dans ce cas, j'ai décidé d'appliquer une correction subjective-conservatrice de +1,1 pas de luminosité linéaire, en multipliant toutes les données du fichier par 2,14, et ce qui suit a été obtenu:

Fig. 7: image CFA après soustraction des niveaux de noir, équilibrage des blancs, recadrage, correction linéaire de la luminosité par 1,1 pas

Mieux. Mais comme vous pouvez le voir, le prix à payer pour la correction linéaire de la luminosité est d'éclairer des parties de la cascade. C'est là que les curseurs avancés de récupération des hautes lumières et des ombres non linéaires trouvés dans la plupart des convertisseurs RAW viennent à la rescousse.

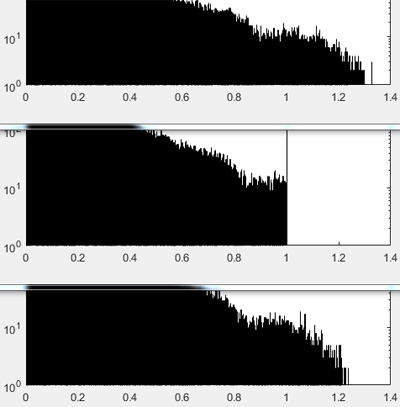

4.Assurez-vous que les données de balance des blancs sont coupées uniformément

Si le canal vert a été initialement coupé dans les données brutes, vous devrez peut-être recadrer les deux autres à pleine échelle après avoir appliqué des multiplicateurs de balance des blancs pour corriger la non-linéarité résultante. La pleine échelle est indiquée dans les histogrammes ci-dessous sous la forme d'une valeur normalisée de 1,0. Vous pouvez voir que le canal vert des données brutes d'origine a été coupé (en raison de l'encombrement des valeurs), et les autres ne l'ont pas été.

Figure: 8: De haut en bas: histogrammes R, V, B après application des multiplicateurs de balance des blancs aux données brutes, avant le recadrage. Assurez-vous de rogner les trois au niveau du plus petit canal afin que les fausses couleurs n'apparaissent pas dans les zones claires. Les données d'image sont tracées à 0-1, où 1 est la pleine échelle.

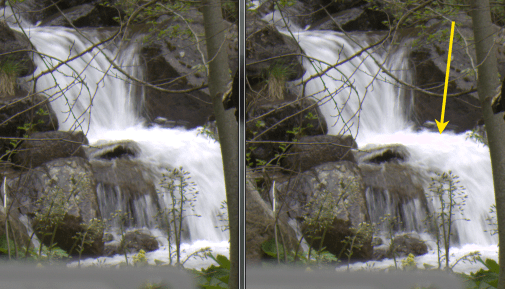

Un recadrage à pleine échelle est nécessaire car dans les zones où il n'y a pas de données des trois canaux, la couleur résultante est susceptible d'être incorrecte. Dans l'image finale, cela peut se manifester par, par exemple, une teinte rosée dans les zones proches de la luminosité maximale. C'est très ennuyeux, par exemple, sur des images de montagnes enneigées. Par conséquent, la taille résout ce problème sans compromis.

Figure: 9: Gauche: Image correctement recadrée après application de la balance des blancs. À droite: l'image n'est pas recadrée. La flèche jaune montre une zone proche de la luminosité maximale, où les informations incomplètes des canaux de couleur donnent une teinte rosâtre.

Au lieu de recadrer, on pourrait faire certaines hypothèses sur les couleurs manquantes et compléter les données relatives. Dans les convertisseurs RAW avancés, cela se fait par des algorithmes ou des curseurs avec des noms tels que «reconstruction de surbrillance». Il existe de nombreuses façons de procéder. Par exemple, s'il manque un seul canal, comme dans le cas du vert de 1.0 à 1.2 sur la Fig. 8, il est plus facile de supposer que les hautes lumières sont dans une zone blanche neutre et que les données d'image brutes ont la balance des blancs correcte. Ensuite, dans tout quatuor où la couleur verte sera coupée et les deux autres ne le seront pas, alors la valeur du vert sera égale à la valeur moyenne des deux autres canaux. Pour ce cliché, cette stratégie serait capable de reconstruire pas plus d'un quart de pas dans les zones lumineuses (log 2(1,2)). Ensuite, il serait nécessaire de compresser les hautes lumières et / ou de re-normaliser la nouvelle pleine échelle à 1.0.

5. Débayerisation des données CFA

Jusqu'à présent, l'image CFA était sur le même plan noir et blanc, ce qui faisait apparaître les zones colorées pixélisées, comme on peut le voir sur la Fig. 6. Il est temps de démêler - séparer les pixels rouges, verts et bleus illustrés à la fig. 2, dans des plans de couleur pleine grandeur séparés en se rapprochant des données manquantes (dans la figure ci-dessous, elles sont représentées sous forme de carrés blancs).

Figure: 10: Debayering - remplir les données manquantes dans chaque plan de couleur en utilisant les informations des trois plans.

N'importe lequel d'un grand nombre d'algorithmes de débayage avancés peut être utilisé dans cette étape. La plupart fonctionnent très bien, mais certains sont meilleurs que d'autres, selon la situation. Certains convertisseurs RAW comme RawTherapee open source et dcraw invitent l'utilisateur à sélectionner un algorithme dans une liste. La plupart des convertisseurs ne proposent pas cette option et utilisent le même algorithme de debayering. Savez-vous quel algorithme de démolition utilise votre convertisseur RAW préféré?

Dans ce test, j'ai décidé de tricher et de simplement compresser chaque quatuor RGGB en un seul pixel RVB, en laissant les valeurs R et B de chaque quatuor telles qu'elles étaient dans les données brutes et en faisant la moyenne de G sur deux (cela équivaut au mode dcraw –h). Il s'agit d'un algorithme de débayage 2 × 2 du plus proche voisin. Cela donne une image plus pratique à utiliser qui fait la moitié de la taille (en dimensions linéaires, ou quatre fois en surface).

Figure: 11: Image RVB brute après soustraction du noir, équilibrage des blancs, recadrage, correction linéaire de la luminosité et démarcation 2x2 du voisin le plus proche (équivalent à dcraw –h).

En figue. 11, vous pouvez voir que nos données brutes sont maintenant RVB avec trois plans de couleurs entièrement remplis. Les couleurs, qui ont été enregistrées par la caméra, étaient affichées par le navigateur et le moniteur. Ils ont l'air terne, mais pas très différents de l'original. Les stores ne sont pas stockés dans l'espace RVB standard, de sorte que les logiciels et le matériel ne savent pas toujours quoi en faire. L'étape suivante consiste à convertir ces couleurs en un espace colorimétrique standard colorimétrique commun.

6. Conversion et correction des couleurs

C'est l'une des étapes les moins intuitives mais les plus importantes requises pour obtenir une image finale avec des couleurs agréables. Tous les fabricants gardent jalousement les secrets de leurs filtres de couleur dans le CFA de leurs matrices, mais avec le bon équipement, il n'est pas trop difficile de dériver des fonctions de sensibilité spectrale. Vous pouvez vous faire une idée approximative des fonctions de votre appareil photo même avec un spectromètre bon marché .

Armé de tout cela et faisant beaucoup d'hypothèses sur les sources de lumière, les scènes et les méthodes de visualisation typiques, un tableau linéaire de compromis peut être généré qui convertit la couleur d'une image CFA (comme le montre la figure 11) en une couleur standard, sera en mesure de reconnaître les programmes courants tels que les éditeurs ou les navigateurs, ainsi que les périphériques tels que les écrans et les imprimantes.

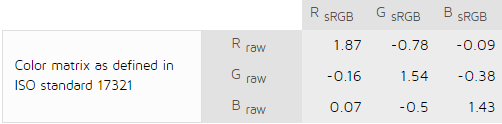

Heureusement pour nous, plusieurs excellents laboratoires sont engagés dans la mesure et le calcul de ces matrices - puis ils mettent les calculs dans le domaine public. Par exemple, DXOmark.com produit des matrices pour convertir des données photo brutes après la balance des blancs en sRGB pour deux sources pour n'importe quel appareil photo de leur base de données. Par exemple, voici leur capteur pour Nikon D610 etsource lumineuse standard D50:

Fig 12: Matrice couleur du laboratoire DXO pour la source lumineuse D50: des données équilibrées et débayerisées des blancs au sRGB.

Laquelle des matrices de compromis sera la meilleure dépend de la distribution spectrale de l'énergie de la source lumineuse au moment de la prise de vue, de sorte que la matrice réelle est généralement interpolée sur la base de quelques références. Dans le monde Adobe d'aujourd'hui, ce sont les sources lumineuses standard A et D65, chargées de limiter la plage d'éclairage typique dans la photographie de tous les jours, du tungstène à la lumière du jour et à la photographie en intérieur. Les données converties sont ensuite adaptées à une source lumineuse qui correspond à l'espace colorimétrique final - pour sRVB, par exemple, D65. Le résultat est une sorte de matrice, telle que celle illustrée à la Fig. 12. Il ne reste plus qu'à le multiplier par les valeurs RVB de chaque pixel débayerisé après l'étape 5.

Dans la spécificationAdobe recommande un processus plus flexible pour son convertisseur DNG. Au lieu d'une transition directe de la caméra CFA vers l'espace colorimétrique colorimétrique, Adobe convertit d'abord les données dans l'espace colorimétrique Profile Connection (XYZ D50), en multipliant les données après l'équilibrage des blancs et la décomposition par une matrice avant interpolée, puis arrive à l'espace colorimétrique final comme sRGB. Parfois, Adobe applique également une correction de couleur non linéaire supplémentaire à l'aide de profils spéciaux dans XYZ (en langage DNG, il s'agit de corrections HSV via ProPhoto RGB, HueSatMap et LookTable).

Les matrices directes de l'appareil photo qui a pris la photo sont enregistrées dans chaque fichier DNG, louange Adobe. J'ai téléchargé à partir de là des matrices pour D610 et des matrices XYZD50 -> sRGBD65 à partir du site de Bruce Lindblum, et j'ai obtenuimage finale:

Fig. 13: Image convertie «assez». Données brutes, niveaux de noir soustraits, équilibrage des blancs effectué, recadrage, correction de la luminosité, démultiplication 2x2, correction des couleurs et conversion en sRVB.

Désormais, les couleurs sont ce que les programmes et les appareils s'attendent à trouver dans l'espace colorimétrique sRGB. Au cas où vous vous poseriez la question, cette image est presque identique à celle du convertisseur Capture NX-D à profil plat de Nikon. Cependant, il n'a pas l'air très net en raison du faible contraste de nos moniteurs (voir Tone Mapping).

7. Application du gamma

La dernière étape dépend de l'espace colorimétrique sélectionné. Le gamma pour l'espace sRGB est d'environ 2,2 . Je ne le mentionne que pour montrer que le processus de rendu devient non linéaire à ce stade. A partir de ce moment, l'image est réduite à la gamme colorimétrique de l'espace colorimétrique, et elle peut être soit chargée dans votre éditeur préféré, soit affichée à l'écran. En théorie, toutes les étapes précédentes étaient linéaires, c'est-à-dire facilement réversibles.

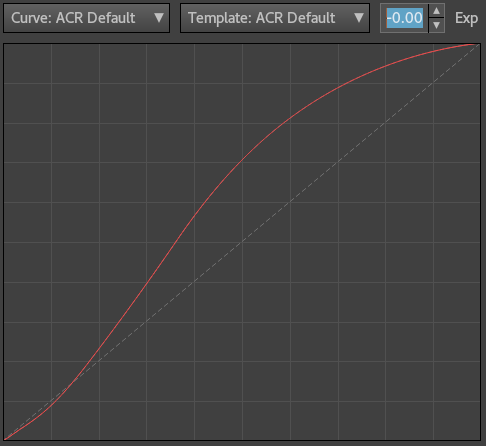

+ Affichage de la tonalité

En 2016, la correction du ton est presque toujours nécessaire pour choisir comment serrer la plage dynamique élevée d'une caméra dans une petite plage de l'appareil d'imagerie. Par exemple, en fonction de votre résistance au bruit, la plage dynamique de mon D610 a 12 étapes, tandis que mon assez bon moniteur a un rapport de contraste de 500: 1, soit environ 9 étapes. Cela signifie que les trois dernières étapes de la caméra ne seront pas visibles sur le moniteur en raison de son rétroéclairage.

La courbe RVB redistribuera subjectivement les tons sur toute la plage, de sorte que certaines des ombres soient plus visibles au détriment de certaines des zones les plus claires (par conséquent, cette courbe est appelée la «courbe des tons»). Au moment d'écrire ces lignes, une telle courbe est généralement appliquée par Adobe en ACR / LR au moment du rendu, avant d'afficher l'image pour la première fois:

Figure: 14: Courbe de tons appliquée par ACR / LR vers la fin du processus de rendu dans la version de processus 3 (2012-2016). L'axe horizontal est non linéaire.

Dans ce cas, je ne l'ai pas utilisé. J'ai juste appliqué une courbe d'augmentation du contraste et ajouté une certaine netteté dans Photoshop CS5 à la fig. 13 pour obtenir l'image finale:

Fig. 15: Image sRGB finale. Données initialement brutes, niveaux de noir soustraits, équilibrage des blancs, rognage, correction de la luminosité, démultiplication, correction des couleurs, courbe de ton appliquée

Bien sûr, l'application d'une courbe de contraste à un stade ultérieur modifie la chromaticité et la saturation des couleurs, mais c'est exactement ce qui se passe lorsque vous appliquez ces ajustements à l'espace gamma RVB après le rendu de l'image. Historiquement, c'est ainsi que tout s'est passé dans les caméras, et c'est ainsi que tout se passe dans les convertisseurs RAW populaires - c'est la procédure, et nous nous y sommes habitués au fil des ans. Une alternative pour obtenir la «précision» de la reproduction des couleurs sera d'utiliser le profil de couleurs du site Web de Torgera et de ne plus toucher le ton.

Résumons

Ainsi, pour la conversion RAW de base avec ajustement linéaire de la luminosité et de la couleur, vous avez besoin de:

- Chargez des données linéaires à partir d'un fichier RAW et soustrayez les niveaux de noir.

- Équilibrez les blancs.

- Corrigez la luminosité linéaire.

- Recadrer les données d'image.

- Debayerize.

- Appliquez des transformations et des corrections de couleur.

- Appliquez le gamma.

Et c'est tout - le voile du secret de la conversion des données brutes a été arraché.

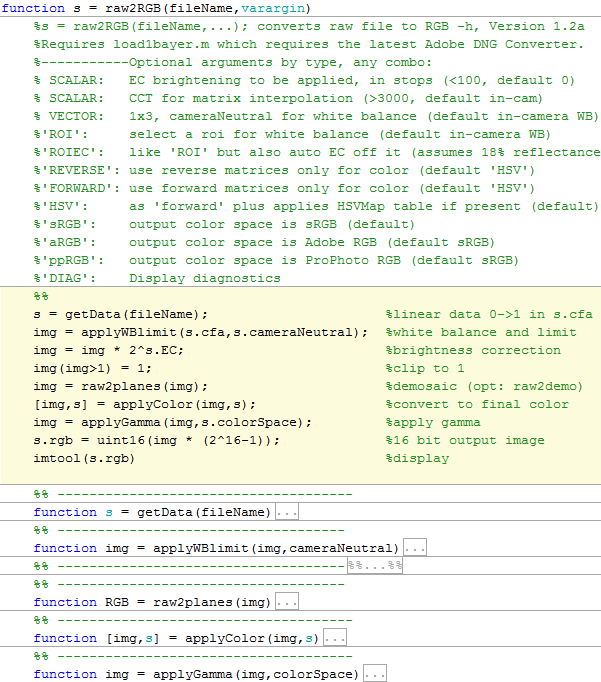

Les scripts pour Matlab pour obtenir les images données dans cet article peuvent être téléchargés à partir du lien . Les 7 étapes de base sont indiquées en jaune:

s = raw2RGB(‘DSC_4022’ , ‘ROI’ , 1.1)

Après avoir utilisé le script, enregistrez le fichier au format TIFF, chargez-le dans l'éditeur de couleurs et appliquez l'espace colorimétrique choisi pour voir les couleurs correctes.