Le champion du monde Garry Kasparov a battu l'ordinateur IBM Deep Blue en 1996, mais a été battu en 1997, perdant 4-2.

La victoire en 1997 de l'ordinateur IBM Deep Blue sur le grand maître et champion du monde Garry Kasparov est considérée comme un tournant triomphant dans l'histoire de la technologie, comparable à l'atterrissage sur la lune. Elle semble avoir démontré que les ordinateurs peuvent battre les humains dans ce que l'on pensait être unique à nous: penser 1 . Les technologies d'IA symboliques utilisées par l'ordinateur DeepBlue sont désormais considérées comme obsolètes, en particulier pour les jeux plus complexes comme le go, inventé en Chine il y a deux mille cinq cents ans. Mais en 2016, le champion du monde de go Lee Sedol a été battu par le système d'IA DeepMind AlphaGo de Google. Le chercheur et capital-risqueur Li Kaifu a qualifié cet événement de "Moment Spoutnik" pour la Chine 2: Il pense que c'est cela qui a poussé la Chine à investir des milliards de dollars dans la recherche sur l'IA pour rattraper et peut-être même dépasser les États-Unis. La victoire d'AlphaGo illustre l'épanouissement d'un nouveau paradigme d'IA - l'apprentissage en profondeur et les réseaux de neurones - qui est au cœur de la révolution moderne de l'IA.

Pourquoi des jeux comme les échecs sont-ils si importants dans l'histoire de l'IA? Les pionniers de la recherche sur l'intelligence artificielle, dont Herbert Simon, Allen Newell, John McCarthy et Marvin Minsky, ont envisagé l'intelligence humaine à travers le prisme traditionnel de la philosophie occidentale, dont les fondements ont été posés par Aristote. Cette vision masculine et eurocentrique de l'intelligence, enracinée dans la division cartésienne de l'esprit et du corps, a donné la priorité aux compétences cérébrales - logique, mathématiques et résolution de problèmes au détriment des formes d'intelligence corporelle, émotionnelle, sociale et culturelle. Ils croyaient que si la raison (c'est-à-dire la logique) distingue l'homme de la bête, alors c'est la logique qui devrait être la base de l'intelligence.

Blaise Pascal était philosophe et mathématicien. Dans les années 1640, il invente une machine capable d'effectuer des ajouts pour aider son père, percepteur d'impôts.

De nombreux philosophes et mathématiciens occidentaux, de Blaise Pascal à George Boole et Bertrand Russell, ont cherché soit à rendre le calcul / logique, qu'ils assimilaient à la pensée elle-même, plus rigoureux mathématiquement (plus «formel»), soit à passer à l'étape suivante - la mécaniser. Pascal lui-même a fabriqué une machine informatique à cet effet, et le point culminant de cette impulsion de la pensée occidentale a été l'invention de l'ordinateur numérique au XXe siècle. Les pionniers de la recherche sur l'IA dans les années 1950 et 1960 considéraient les jeux comme un autre moyen pour les humains de démontrer leur intelligence en résolvant des problèmes. Si les chercheurs en IA pouvaient simuler la façon dont les joueurs le font, ils pourraient automatiser ce processus. La branche des mathématiques appelée théorie des jeux, appliquée à l'économie et aux affaires militaires, a été fondée par le mathématicien et pionnier de l'informatique John von Neumann;il a permis d'optimiser les stratégies et les algorithmes largement utilisés en informatique. Le pionnier de l'IA, Herbert Simon, a appliqué ces théories à la fois à l'informatique et à l'économie (dans laquelle il a remporté le prix Nobel). Par conséquent, l'idée que les jeux peuvent modéliser sérieusement des aspects du monde réel était au cœur des débuts de l'informatique. En particulier, parce que les premiers ordinateurs avaient du mal à simuler la complexité du monde réel, les jeux étaient considérés comme un «micromonde» simplifié, dont les limites et les règles étaient bien comprises par les ordinateurs qui permettaient des progrès rapides dans les années 1960.Par conséquent, l'idée que les jeux peuvent modéliser sérieusement des aspects du monde réel était au cœur des débuts de l'informatique. En particulier, parce que les premiers ordinateurs avaient du mal à simuler la complexité du monde réel, les jeux étaient considérés comme un «micromonde» simplifié, dont les limites et les règles étaient bien comprises par les ordinateurs qui permettaient des progrès rapides dans les années 1960.Par conséquent, l'idée que les jeux peuvent modéliser sérieusement des aspects du monde réel était au cœur des débuts de l'informatique. En particulier, parce que les premiers ordinateurs avaient du mal à simuler la complexité du monde réel, les jeux étaient considérés comme un «micromonde» simplifié, dont les limites et les règles étaient bien comprises par les ordinateurs qui permettaient des progrès rapides dans les années 1960.

La machine d'échecs Turok de Wolfgang von Kempelen, contrôlée par un joueur vivant caché à l'intérieur.

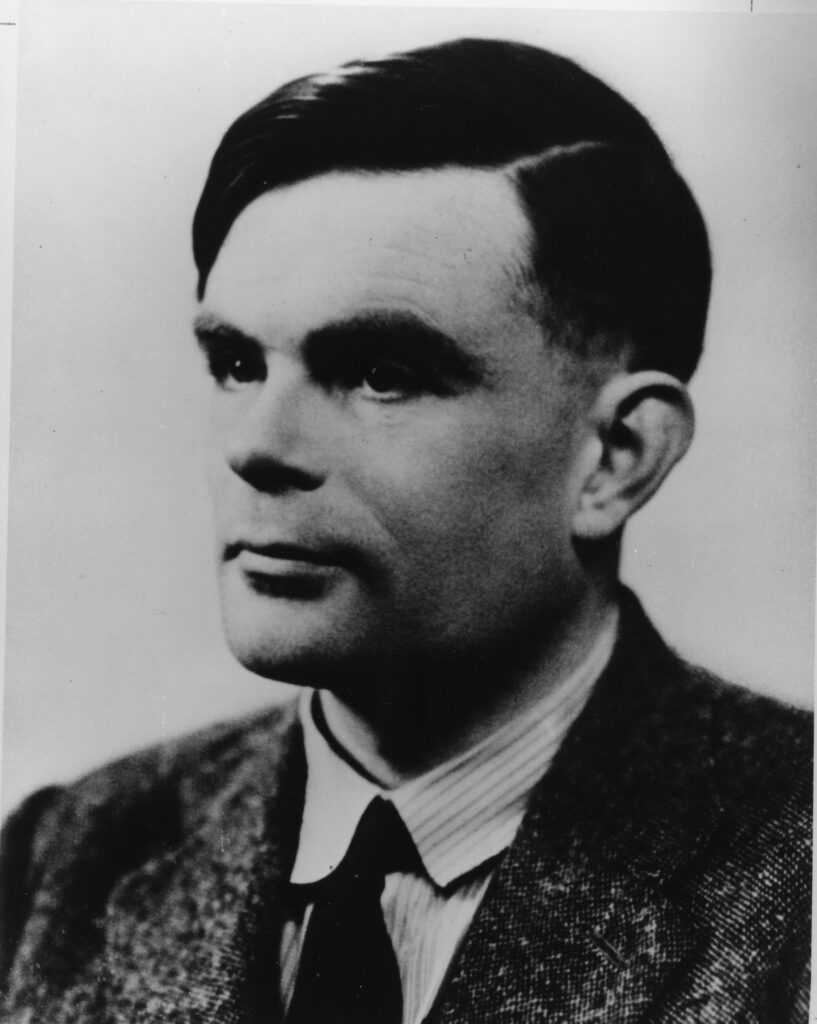

Les échecs, en particulier, ont été historiquement considérés comme le summum de l'activité intellectuelle en Occident. C'était un jeu intellectuel associé à la logique et à la stratégie. Pensez à M. Spock de Star Trekvaincre des joueurs humains aux échecs 3D. Même au 18ème siècle, l'élite européenne était fascinée par l'idée de machines capables de jouer aux échecs. Wolfgang von Kempelen est devenu célèbre pour son "Turc mécanique" - une machine d'échecs faite pour l'impératrice autrichienne Maria Theresa et battant Benjamin Franklin et Napoléon. Plus tard, il s'est avéré que le "Turc" était un faux et qu'un joueur en direct se cachait à l'intérieur; néanmoins, il frappa l'imagination d'Edgar Allan Poe et de Charles Babbage. L'intérêt pour les échecs en tant qu'indicateur d'intelligence s'est étendu aux mathématiciens qui ont posé la théorie du calcul au XXe siècle: Alan Turing, Claude Shannon, John von Neumann, Norbert Wiener et, bien sûr, les pionniers de l'IA Herbert Simon, Allen Newell et John McCarthy. En particulier, Newell et Simon considéraient les échecs comme un défi modèle pour l'IA,parfait pour leur solution préférée: rechercher.

1947 .

MIT Bell Labs () 1950 , . MIT ( ). (. 1950 ).

, , 1980 .

Qu'est-ce que la recherche et comment l'utiliser pour jouer aux échecs? Dans le contexte de l'IA, la recherche ne signifie pas la recherche de texte sur le Web à l'aide de Google (bien qu'un moteur de recherche Web puisse utiliser le concept de recherche dans un contexte d'IA). En IA, la recherche fait référence au processus d'essais et d'erreurs pour parcourir les solutions possibles à un problème. La recherche est l'une des méthodes fondamentales de l'IA classique, également connue sous le nom d'IA "symbolique", car de telles méthodes impliquent la manipulation de listes de symboles, par exemple, comme pour résoudre des problèmes algébriques. Toutes sortes de processus de résolution de problèmes, tels que la démonstration de théorèmes, la résolution d'énigmes, les jeux et la résolution de labyrinthes, impliquent de décider quoi essayer en premier. Ces choix peuvent être modélisés sous la forme d'un arbre de décision ramifié.

.

-. , , - «».

Disons que nous devons créer une souris robotique à la recherche d'un moyen de sortir d'un labyrinthe (à peu près ce que Claude Shannon a fait en 1950). Si elle heurte une intersection avec quatre portes, elle peut se déplacer vers la droite, l'avant et la gauche, mais il lui est interdit de reculer. Cela nous donne trois choix possibles. Les informaticiens diraient qu'une souris a un «facteur de branchement» de 3. La façon la plus simple de programmer un ordinateur pour parcourir (résoudre) un labyrinthe serait de cocher chaque option, ou branche, tour à tour. C'est ce qu'on appelle la recherche par force brute: nous testons chaque variation. Cependant, notre souris ira bien sûr à une autre intersection avant d'avoir la possibilité de revenir pour vérifier toutes les autres options à la première intersection. Chaque fois qu'elle atteint une nouvelle intersectionla souris peut choisir entre trois nouveaux chemins supplémentaires. Nous pouvons définir le nombre d'intersections que la souris peut rechercher en profondeur avant de revenir en arrière et d'essayer un chemin différent.

Claude Shannon déplace sa souris électrique dans un labyrinthe (vers 1952).

C'est ce qu'on appelle la profondeur de recherche et, dans le contexte du jeu, «regarder vers l'avenir». Comme vous pouvez le voir, le nombre de chemins qui doivent être recherchés par la souris augmente très rapidement: comme 3 (le facteur de branchement), multiplié par lui-même autant de fois que nous vérifions de manière proactive dans l'arbre de décision. En d'autres termes, le problème croît de façon exponentielle. Dans l'industrie de l'IA, on parle souvent de problème de «l'explosion combinatoire».

L'échiquier dans les premières théories

Une méthode similaire peut également être utilisée aux échecs. Sur le coup de chaque joueur, nous avons le choix d'un maximum de 38 coups autorisés possibles, c'est-à-dire que le problème d'échecs a un facteur de branchement de 38. Pour sélectionner le meilleur de ces 38 coups, une méthode quantitative est utilisée pour évaluer l'avantage relatif d'une position d'échecs par rapport à une autre. C'est ce qu'on appelle la «fonction de notation». La partie d'échecs moyenne prend 42 coups, et comme il y a deux joueurs, cela doit être multiplié par deux, ce qui nous donne environ 38 84 - plus que le nombre d'étoiles dans l'univers. Même dans les premiers stades de l'histoire de l'IA, il est devenu clair qu'une telle recherche par la force brute des échecs et d'autres tâches ne fonctionnerait tout simplement pas sur l'équipement de l'époque; il y a trop d'options et les ordinateurs sont trop faibles. Claude Shannon a été l'un des premiers à utiliser l'algorithme "minimax "dans un programme d'échecs sur ordinateur (cet algorithme est toujours la base de la plupart des programmes d'échecs), ayant remarqué que grâce aux connaissances humaines et à l'expérience du jeu, vous pouvez rapidement couper de nombreuses branches sans les regarder. Herbert Simon et Allen Newell ont suggéré d'utiliser" l'heuristique ", ou règles empiriques que les humains utilisent en partie pour résoudre des problèmes, le plus souvent elles fonctionnent, mais cela ne se produit pas toujours Les heuristiques sont le type de connaissances humaines qui peuvent être programmées dans un ordinateur.

Échecs

Les échecs ont beaucoup plus de branches dans leur arbre de décision que le tic-tac-toe. Il a été calculé que le nombre de variantes de jeux d'échecs est approximativement égal à 10 120 , ce qui est plus que le nombre d'atomes dans l'univers.

Lookahead borné

Étant donné le grand nombre de branches, les programmes d'échecs ne peuvent regarder en avant dans l'arbre de recherche que jusqu'à une profondeur finie, sinon la recherche durera éternellement.

L'une de ces heuristiques qui s'est avérée utile aux échecs est la " coupure alpha-bêta". Cela signifie que si le programme a déterminé que l'un des mouvements peut être facilement contré par l'ennemi, alors il n'est pas nécessaire de chercher d'autres moyens de contrecarrer le même mouvement. Une recherche plus poussée le long de cette voie peut être ignorée, coupant toute cette branche de l'arbre. Cela peut réduire considérablement le facteur de branchement, de 38 à 6, et parfois à 3. De plus, étant donné les limites des ordinateurs à l'époque, la plupart des programmes ne pouvaient envisager que 4 coups d'avance. Un des premiers programmes d'échecs à jouer avec compétence contre des amateurs. , a été créé vers 1959-1962 par Alan Kotok, étudiant du MIT, sous la direction de John McCarthy. Le programme Kotoka-McCarthy utilisait le découpage alpha-bêta.

, IBM 7090 . , - . 1967 , , 3-1 .

1959 MIT , . , , . . 1962 .

Newell et Simon pensaient que tous les problèmes d'IA, tels que les échecs, pouvaient être résolus en recherchant en combinaison avec des heuristiques, ou «recherche heuristique». La recherche heuristique était l'idée centrale derrière les premières percées de Newell et Simon, le théoricien de la logique et le solveur général de problèmes, et est devenue un pilier critique de leur théorie selon laquelle l'intelligence pour les humains et les machines réside dans la simple manipulation de symboles, les éléments de base fondamentaux. mathématiques et langage. Cette hypothèse du «système physique des symboles» est devenue la prémisse sur laquelle reposait tout le projet d'intelligence artificielle symbolique, de sa création dans les années 1950 au début des années 2000. Cette théorie, qui postulait l'équivalence du «cerveau» des ordinateurs et des humains, est devenue extrêmement influente en psychologie cognitive.et plus tard même est entré dans la culture populaire grâce à des œuvres du genre cyberpunk, dans lesquelles les gens pouvaient télécharger leur cerveau sur Internet ou les remplacer par des puces.

() , -, Logic Theorist, General Problem Solver NSS ( --). JOHNNIAC RAND.

Les ordinateurs sont devenus plus rapides et les informaticiens qui étaient eux-mêmes des joueurs d'échecs expérimentés, tels que Richard Greenblatt et Hans Berliner, ont créé leurs propres programmes d'échecs. Ils ont constaté que les premiers programmes d'échecs (comme celui écrit par Kotok) jouaient extrêmement mal et ont ajouté leur propre connaissance de la façon dont les vrais joueurs abordent le jeu à leurs programmes; ces connaissances ont pris la forme d'heuristiques supplémentaires pour améliorer l'estimation de la position des pièces, des bases de données de coups d'ouverture et de fin de partie, et des reconnaisseurs de modèles du terrain de jeu. Au fil du temps, cependant, il est devenu clair que les programmes d'échecs exécutés sur des ordinateurs plus rapides ou des équipements spécialisés peuvent surpasser les programmes qui intègrent une grande quantité de connaissances humaines. Cela s'est produit parce qu'aucune heuristique n'est parfaite et ne peut pas rendre compte de toutes les situations.Parfois, des mouvements ingénieux surviennent parce que le joueur essaie de faire quelque chose que la plupart des gens considéreraient comme un mauvais coup. La plupart des heuristiques couperaient un tel mouvement sans autre recherche, ce qui signifie que les programmes utilisant la connaissance humaine ne feraient jamais un tel mouvement.

Hans Berliner (arrière-plan), Murray Campbell (à gauche) et Feng Xiong Xu à la 20e édition des championnats d'échecs informatiques ACM à Reno, NV. La première place était partagée par deux équipes - HiTech (équipe de Berliner) et Deep Thought (équipe de Campbell et Xu); tous deux représentaient l'Université Carnegie Mellon. Trois membres de l'équipe Deep Thought (dont Campbell et Xu) ont ensuite été embauchés par IBM pour créer Deep Blue.

Au fur et à mesure que les ordinateurs devenaient plus rapides, ils étaient capables de regarder plus en avant, 6, 7, 8 coups, battant facilement les programmes qui ne prédisaient que 4 coups. Un algorithme de recherche plus efficace a été découvert, appelé "recherche itérative d'approfondissement"; il pouvait progressivement augmenter la profondeur de la recherche le long du chemin qui semblait le plus prometteur. Il a été utilisé pour la première fois dans Chess 4.5.3 David Slate et Larry Atkins - le premier programme à remporter le tournoi d'échecs humain de 1976. L'augmentation de la capacité de mémoire a également permis aux programmes de conserver des positions précédemment examinées, réduisant encore davantage le nombre de recherches requises. Toutes ces innovations (élagage alpha-beta, approfondissement itératif, stockage des positions vérifiées et base de données d'ouvertures et de fin de partie) ont été librement échangées par les développeurs de programmes d'échecs dans les tournois d'échecs informatiques, elles sont donc devenues des techniques standard.

En 1977, Ken Thompson (mieux connu comme le co-auteur du système d'exploitation Unix) et Joe Condon des Bell Laboratories ont conçu la Belle, une machine d'échecs spécialisée. L'équipement d'échecs spécialisé et la base de données de fin de partie de Belle ont révolutionné les échecs informatiques.

Belle 13- . Belle , Cray Blitz. 1970 1994 (Association for Computing Machinery, ACM) .

1980- Belle, Bell Labs, . Belle CHAOS WCCC 1980 , , . Belle CHAOS .

Belle Chess 4.0 4- (WCCC), - 1983 . : , . : Chess . Cray Blitz, Bebe.

Malgré les progrès du logiciel, avec la vitesse croissante des ordinateurs dans les années 1970, les programmes d'échecs se sont automatiquement améliorés sans aucune innovation logicielle. Dans les années 1980, le facteur dominant dans les progrès des échecs informatiques était l'utilisation de matériel pour accélérer la recherche. Ils sont devenus un défi de conception informatique, pas un défi d'IA. En 1997, Deep Blue utilisait encore largement les mêmes techniques de programmation que les programmes d'échecs 20 ans auparavant; cependant, il a réussi à vaincre Kasparov principalement parce qu'il était un ordinateur rapide avec de nombreux processeurs parallèles spécialisés. En un sens, à mesure que la vitesse des ordinateurs augmentait, les programmes d'échecs devenaient moins intelligents.

Deep Thought I, 1988 . Deep Thought, — , Deep Blue.

Deep Blue.

IBM Deep Blue ( , , , , . . ).

1997 Deep Blue (-).

Dans les années 1980, la recherche en profondeur en tant que sujet dominant de la recherche sur l'IA était déjà en déclin. À partir des années 1960, des chercheurs comme Ed Feigenbaum à Stanford ont créé des soi-disant «systèmes experts», dans lesquels de grandes quantités de connaissances d'experts humaines ont été versées dans des programmes d'IA sous la forme de règles si-alors. Comme dans le cas des premiers programmes heuristiques, ces règles étaient programmées dans le code du logiciel, mais contrairement aux systèmes heuristiques, la «base de connaissances» était séparée des parties logiques du programme («machines d'inférence»). Feigenbaum et d'autres adeptes des systèmes experts ont soutenu que «la connaissance est le pouvoir». En d'autres termes, ils pensaient qu'une large base de connaissances compense le manque de raisonnement complexe: plus il y a de connaissances, moins il y a de recherche, et vice versa.

Tiger in a Cage: Applying Knowledge Base Systems, Conférence d'Edward Feigenbaum, 1993

Discussion sur l'histoire de l'IA à AAAI-17: systèmes experts, 2017

Dans les années 80, les systèmes experts ont engendré de nombreuses sociétés commerciales. Toute cette activité n'affectait presque pas les programmes d'échecs, qui à l'époque se déroulaient dans une direction différente: retour à la recherche par force brute à l'aide d'un équipement spécialisé. Les principales machines d'échecs de ce type étaient Belle of Bell Labs de Ken Thompson et deux projets distincts de l'Université Carnegie Mellon: HiTech de Hans Berliner avec Feng Xiong Xu et Deep Thought de Murray Campbell, qui a ensuite évolué pour devenir le Deep Blue d'IBM. C'est-à-dire qu'au moment où la machine a vaincu Kasparov, les programmes d'échecs avaient pratiquement cessé d'être associés au domaine général de la recherche sur l'IA, bien qu'ils fournissaient une bonne publicité.

Plus troublant, cependant, était l'attaque d'un projet d'IA symbolique basé sur l'hypothèse de symbole physique de Newell et Simon au début des années 1990. Ses critiques, en particulier le philosophe Hubert Dreyfus, ont commencé à remettre en question le projet de l'IA symbolique dans les années 1960, arguant que l'hypothèse philosophique de la séparation du cerveau et du corps était incorrecte et dépassée. Des philosophes du XXe siècle tels que Martin Heidegger ont soutenu que la pensée humaine ne peut être séparée de l'expérience corporelle et de l'environnement culturel immédiat du sujet.

Les chercheurs en IA ont réagi très brusquement aux critiques de Dreyfus (même si lui-même n'était pas particulièrement diplomate): les principales autorités dans le domaine de l'IA ont menacé les journaux lorsqu'ils ont publié les travaux de Dreyfus. Ils ont jubilé quand Dreyfus, qui n'était pas très bon aux échecs, a été vaincu par le programme d'échecs MacHack de Richard Greenblatt. Cependant, le succès des programmes d'échecs n'a pas prouvé que la critique de Dreyfus était erronée. En fait, le fait même que les programmes d'échecs comme Deep Blue utilisaient la recherche par force brute signifiait qu'ils ne jouaient que peu de rôle dans un projet d'intelligence artificielle plus large. Le drame de la défaite tonitruante de Kasparov a été salué comme une étape importante pour la victoire de Machines sur Man, mais en réalité, c'était un triomphe des ingénieurs de Deep Blue sur un joueur d'échecs. Et les créateurs de Deep Blue n'ont pas revendiquéque leur ordinateur était intelligent. Ils ont dit: si un incendie se déclarait dans le bâtiment, Kasparov serait assez intelligent pour s'échapper et la voiture resterait en place. Et bien que le pionnier de l'IA, John McCarthy, considérait les échecs comme l'objectif principal de l'IA, après la victoire de Deep Blue, il a critiqué les échecs pour le fait qu'ils n'avaient pas réussi à développer une seule nouvelle théorie sur la façon d'imiter l'intelligence humaine.

Les médias ont décrit la rediffusion de 1997 entre le champion du monde d'échecs Garry Kasparov et le supercalculateur spécialisé IBM Deep Blue comme une bataille entre l'homme et la machine. Sur la couverture de Newsweek, elle a été surnommée «La dernière ligne de défense du cerveau». De telles vues exagéraient la puissance de l'ordinateur et minimisaient le travail des personnes qui construisaient la machine elle-même.

Au début des années 1990, les chercheurs ont commencé à prendre au sérieux les critiques de Dreyfus et ont commencé à inventer de nouveaux types d'IA, comme celles qui ont catégoriquement des corps, comme les robots Rodney Brooks 4, ou ceux qui traitent des émotions. Comme nous le verrons dans la deuxième partie de cet article, dans les années 2000, une tradition complètement différente de l'IA appelée apprentissage automatique a commencé à remplacer l'IA symbolique. L'apprentissage automatique est capable d'exécuter des tâches que l'IA symbolique n'a jamais fait mieux que les humains, telles que la reconnaissance de visages ou la compréhension de la parole humaine. Il en va de même pour un jeu auquel les machines ne pourraient pas jouer de manière compétitive avec la recherche heuristique, à savoir go.

Cependant, si la recherche a perdu sa grandeur en tant que technique d'IA principale, elle n'a jamais perdu son utilité dans le domaine plus large de l'informatique. Des progrès significatifs ont été réalisés dans l'amélioration des algorithmes de recherche pour une résolution optimale et efficace des problèmes. Cette technique est si fondamentale que la création et la recherche d'arbres de décision sont extrêmement répandues; il est presque impossible de lister tous les programmes qui l'utilisent.

La recherche joue un rôle dans toute tâche d'obtention d'informations, de l'exécution de requêtes sur des bases de données à la recherche sur le Web. Un algorithme de recherche * inventé pour le robot ShakeyLe SRI est largement utilisé pour le routage de véhicules autonomes et les applications GPS. Et même aujourd'hui, les programmes d'IA qui jouent à des jeux utilisant l'apprentissage automatique utilisent différents types de recherche, même si ce n'est plus le composant le plus intéressant d'entre eux. Cependant, comme d'autres techniques qui étaient autrefois considérées comme de «l'intelligence artificielle», la recherche moderne n'est considérée qu'une autre technique informatique de base, pas plus intelligente qu'un programme ordinaire. Cela illustre le modèle historique du développement de l'IA: une fois qu'elle devient standard et automatique, les gens ne la considèrent plus comme de «l'intelligence». Auparavant, lorsque nous parlions d '«IA», il s'agissait probablement de recherche. Lorsque «AI» est mentionné aujourd'hui, il est généralement destiné à désigner le successeur de l'IA symbolique - l'apprentissage automatique.

Dans la deuxième partie de cet article, nous explorerons la révolution de l'apprentissage automatique dans l'intelligence artificielle, la profondeur de la différence entre l'apprentissage en profondeur, la recherche et l'IA symbolique, et comment AlphaGo de DeepMind a utilisé l'apprentissage en profondeur pour vaincre le champion du monde de Go Lee Sedol.

Remarques

1. Nathan Ensmenger, «Les échecs sont-ils la drosophile de l'intelligence artificielle? Une histoire sociale d'un algorithme », Social Studies of Science 42, no. 1 (février 2012): 22, https://doi.org/10.1177/0306312711424596 .

2. Kai-Fu Lee, superpuissances de l'IA: la Chine, la Silicon Valley et le nouvel ordre mondial. (Boston; New York: Houghton Mifflin Harcourt, 2019), 1-5.

3. Stuart J. Russell et Peter Norvig, Artificial Intelligence: A Modern Approach , 3e éd., Prentice Hall Series in Artificial Intelligence (Upper Saddle River, NJ: Pentice Hall, 2010), 110.

4. Rodney A. Brooks, « Les éléphants ne jouent pas aux échecs », Robotique et systèmes autonomes, Concevoir des agents autonomes, 6, no. 1 (1er juin 1990): 3-15, https://doi.org/10.1016/S0921-8890(05)80025-9 .

La publicité

Si vous avez besoin de serveurs avec activation instantanée sur Linux ou Windows pour fonctionner , alors vous venez certainement chez nous - le serveur est prêt à fonctionner en une minute après le paiement!