Un outil de reconnaissance des gestes musicaux basé sur l'intelligence artificielle développé au MIT-IBM Watson AI Lab utilise les mouvements du corps pour distinguer les sons d'instruments de musique individuels.

Image gracieuseté des chercheurs.

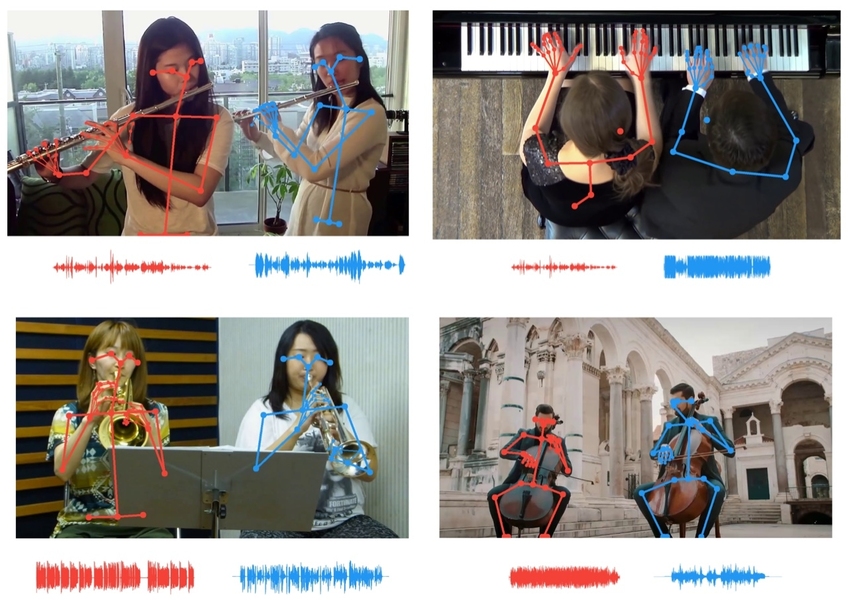

Les chercheurs utilisent des données de points clés squelettiques pour corréler les mouvements des musiciens avec le tempo de leur partie, permettant aux auditeurs d'isoler les instruments qui sonnent de la même manière.

Image gracieuseté des chercheurs.

Nous apprécions la musique non seulement avec nos oreilles, mais aussi avec nos yeux, regardant avec gratitude comment les doigts du pianiste volent au-dessus des touches, et l'archet du violoniste se balance sur la crête des cordes. Lorsque l'oreille est incapable de séparer deux instruments de musique, nos yeux nous aident en faisant correspondre les mouvements de chaque musicien au rythme de chaque partie.

Nouvel outil d'intelligence artificielle développé par MIT-IBM Watson AI Labutilise des yeux virtuels et des oreilles d'ordinateur pour séparer les sons qui sont si similaires qu'il est difficile pour une personne de les différencier. L'instrument a été amélioré par rapport aux itérations précédentes en alignant les mouvements des musiciens individuels en utilisant les points clés de leur squelette avec le tempo des parties individuelles, ce qui permet aux auditeurs d'isoler le son d'une flûte ou d'un violon individuel parmi plusieurs des mêmes instruments.

Les utilisations possibles du travail vont du mixage du son et de l'augmentation du volume d'un instrument dans un enregistrement à la réduction de la confusion qui amène les gens à s'interrompre pendant la visioconférence. Le travail sera présenté à la conférence Computer Vision Pattern Recognition ce mois-ci.

«Les points clés du corps fournissent des informations structurelles puissantes», a déclaré l'auteur principal Chuang Gang , chercheur au laboratoire IBM. "Nous les utilisons ici pour améliorer la capacité de l'IA à écouter et à séparer le son."

Dans ce projet et dans d'autres projets similaires, les chercheurs ont utilisé des pistes audio-vidéo synchronisées pour recréer la façon dont les gens apprennent. Un système d'intelligence artificielle qui apprend avec plusieurs modalités sensorielles peut apprendre plus rapidement, avec moins de données et sans avoir à ajouter manuellement des raccourcis gênants à chaque vue du monde réel. «Nous apprenons de tous nos sens», déclare Antonio Torralba, professeur au MIT et co-auteur de l'étude. "Le traitement multisensoriel est le précurseur de l'intelligence incarnée et des systèmes d'intelligence artificielle qui peuvent effectuer des tâches plus complexes."

Cet outil, qui utilise le langage corporel pour séparer les sons, s'appuie sur des travaux antérieurs dans lesquels des signaux de mouvement étaient utilisés dans des séquences d'images. Sa première incarnation, PixelPlayer, permettait de cliquer sur un instrument dans une vidéo en direct pour le rendre plus fort ou plus silencieux. La mise à jour PixelPlayer vous permet de différencier deux violons dans un duo en faisant correspondre les mouvements de chaque musicien avec le tempo de leur partie. Cette dernière version ajoute des données de points clés (que les analystes sportifs utilisent pour suivre les performances des athlètes, pour extraire des données de mouvement plus granulaires) pour différencier des sons presque identiques.

Le travail met en évidence l'importance des repères visuels dans l'enseignement des ordinateurs afin qu'ils puissent mieux entendre, et l'utilisation d'indices audio pour leur donner une vision plus nette. Tout comme l'étude actuelle utilise des informations visuelles sur les mouvements d'un musicien pour séparer des parties d'instruments de musique aux sons similaires, les travaux précédents utilisaient des sons pour séparer des objets similaires et des animaux de la même espèce.

Torralba et ses collègues ont montré que les modèles d'apprentissage profond formés sur des données audio-vidéo couplées peuvent apprendre à reconnaître les sons naturels , tels que le chant des oiseaux ou les vagues qui frappent le rivage. Ils peuvent également déterminer les coordonnées géographiques d'un véhicule en mouvement par le bruit de son moteur et des roues qui se rapprochent ou s'éloignent du microphone.

Les dernières recherches suggèrent que les outils de suivi audio pourraient être un ajout utile aux voitures autonomes, aidant leurs caméras dans des conditions de mauvaise visibilité. «Les suiveurs sonores peuvent être particulièrement utiles la nuit ou par mauvais temps, en aidant à signaler les véhicules qui auraient autrement pu être manqués», explique Hang Zhao, Ph.D. '19, qui a participé à des recherches sur le mouvement et le suivi sonore.

D'autres auteurs de l'étude CVPR sur les gestes musicaux sont Deng Huang et Joshua Tenenbaum du MIT.

C'est tout. Pour en savoir plus sur le cours, nous vous invitons à vous inscrire à la journée portes ouvertes via le lien ci-dessous:

Lire la suite:

Comment j'ai appris à mon ordinateur à jouer à Doble en utilisant OpenCV et Deep Learning