L'apprentissage par renforcement est mauvais, ou plutôt ne fonctionne pas du tout avec des dimensions élevées. Et fait également face au problème que les simulateurs physiques sont assez lents. Par conséquent, récemment, un moyen de contourner ces limitations est devenu populaire en entraînant un réseau neuronal distinct qui simule un moteur physique. Il s'avère quelque chose comme un analogue de l'imagination, dans lequel un apprentissage de base supplémentaire a lieu.

Voyons les progrès réalisés dans ce domaine et regardons les principales architectures.

L'idée d'utiliser un réseau neuronal au lieu d'un simulateur physique n'est pas nouvelle, car de simples simulateurs comme MuJoCo ou Bullet sur des processeurs modernes sont capables de fournir au moins 100-200 FPS (et plus souvent à 60), et l'exécution d'un simulateur de réseau neuronal en lots parallèles produit facilement 2000-10000 FPS à qualité comparable. Certes, sur de petits horizons de 10 à 100 pas, mais pour l'apprentissage par renforcement, cela suffit souvent.

Mais plus important encore, le processus d'entraînement d'un réseau de neurones pour imiter un moteur physique implique généralement une réduction de la dimensionnalité. Étant donné que le moyen le plus simple de former un tel réseau de neurones est d'utiliser un auto-encodeur, où cela se produit automatiquement.

, , . , . - , , , , Z.

Z Reinforcement Learning. , , ( , , ). , .

, — , , . . , Z , model-based , , .

, Reinforcement Learning. "" : , , , .

World Models

( ), 2018 World Models.

: - "" , Z. ( ).

VAE:

, VAE ( MDN-RNN), . VAE , . , RNN Z . .

:

, : VAE(V) Z MDN-RNN(M) . Z, . MDN-RNN , Z , .

, "" ( - MDN-RNN), . ( ), .

, "" (. ) MDN-RNN (Controller — "", ). , , environment. , C , . VAE(V).

Controller ©, ? ! , -"", Controller. , . , CMA-ES. , Z , . . , , , .

, , .

PlaNet

PlaNet. (, , Controller reinforcement learning), PlaNet Model-Based .

, Model-Based RL — . . , . , , RL , .

Model-Based , , , . (CEM PDDM).

- , ! , .

, . , . .

, . . . (.. state, Reinforcement Learning) , , . Model-Based .

PlaNet, World Models , , Z ( S — state).

Z (, S) , , . , - .

S (, Z) . , , . , .

S , . Model-Based ( ""). .

, , .. -"", A. Model-Based — . , state S . R , state S , ( ). , , ! ( ). Model-Based , .. , , , S R. , World Models, .

Model-Based , PlaNet . 50 . , , , , Model-Free .

Model-Based , (-), . , . . , Model-Based, PlaNet . ( ), .

Dreamer

PlaNet Dreamer. .

PlaNet, Dreamer S, , . Dreamer Value , . Reinforcement Learning. . , . Model-Based ( PlaNet) .

, , Dreamer Actor , . Model-Free , actor-critic.

actor-critic Model-Free , actor , critic ( value, advantage), Dreamer actor . Model-Free .

Dreamer' , . Actor , (. ). Value , , value reward .

, Dreamer Model-Based . Model-Free. model-based ( , ) Actor . Dreamer . , PlaNet Model-Based .

, Dreamer 20 , , Model-Free . , Dreamer 20 , ( ) .

Dreamer Reinforcement Learning . MuJoCo, , .

Plan2Explore

. Reinforcement Learning , .

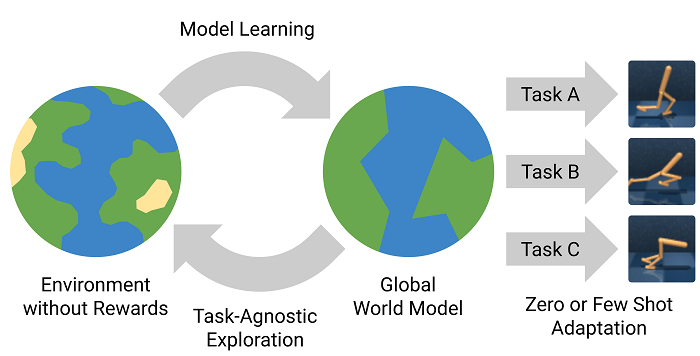

, - , . , - , , . , , ! Plan2Explore .

Reinforcement Learning , , . , .

, . . , -, . -, , - , .

, . , , Plan2Explore , . , .

Plan2Explore : , . , - , . . . zero-shot . ( , . World Models ), few-shot .

Plan2Explore , Dreamer Model-Free , , . , .

Fait intéressant, Plan2Explore utilise une manière inhabituelle d'évaluer la nouveauté de nouveaux endroits tout en explorant le monde. Pour cela, un ensemble de modèles formés uniquement sur un modèle du monde et ne prédisant qu'un pas en avant est formé. On fait valoir que leurs prédictions diffèrent pour les états de grande nouveauté, mais comme des ensembles de données (visites fréquentes sur le site), leurs prédictions commencent à concorder même dans des environnements stochastiques aléatoires. Puisque les prédictions en une étape convergent finalement vers certaines valeurs moyennes dans cet environnement stochastique. Si vous n'avez rien compris, vous n'êtes pas seul. Là, dans l'article, il n'est pas très clair qu'il est décrit. Mais d'une manière ou d'une autre, cela semble fonctionner.