Au cours des six derniers mois, Recursive Cactus (comme il s'est présenté lors de son inscription sur notre site) se prépare pour les prochains entretiens, consacrant au moins 20 à 30 heures par semaine aux exercices LeetCode, aux tutoriels d'algorithmes et, bien sûr, à la pratique des entretiens sur notre plateforme pour évaluer ses progrès.

Journée de travail récursive typique de Cactus:

| Temps | Occupation |

| 6h30 - 7h00 | Montée |

| 7h00 - 7h30 | Méditation |

| 7h30 - 9h30 | Résolution de problèmes par algorithmes |

| 9h30 - 10h00 | La façon de travailler |

| 10h00 - 18h30 | Emploi |

| 18h30 - 19h00 | Chemin du travail |

| 19h00 - 19h30 | Communication avec sa femme |

| 19h30 - 20h00 | Méditation |

| 20h00 - 22h00 | Résolution de problèmes par algorithmes |

Jour de congé récursif typique des cactus:

| Temps | Occupation |

| 8h00 - 10h00 | Résolution de problèmes par algorithmes |

| 10h00 - 12h00 | Éducation physique |

| 12h00 - 14h00 | Temps libre |

| 14h00 - 16h00 | Résolution de problèmes par algorithmes |

| 16h00 - 19h00 | Dîner avec femme et amis |

| 19h00 - 21h00 | Résolution de problèmes par algorithmes |

Mais ses efforts massifs pour se préparer à l'entrevue ont eu des conséquences néfastes sur lui, ses amis et sa famille. Étudier a consommé tout son temps personnel à tel point qu'il n'a pratiquement plus de vie, sauf pour le travail et la préparation aux entretiens.

Une pensée vous tient éveillé: «Et si je n'obtiens pas l'interview? Et si tout ce temps avait été perdu? "

Nous avons tous cherché du travail à un moment ou à un autre, et beaucoup en ont fait l'expérience. Mais pourquoi le cactus récursif passe-t-il autant de temps à se préparer et quelle est la raison de cette frustration?

Il estime qu'il n'atteint pas la barre haute des ingénieurs, le niveau minimum de compétence généralement accepté que tout ingénieur doit démontrer pour obtenir un emploi.

Pour répondre à la barre, il a choisi une tactique spécifique: répondre aux attentes généralement acceptées d'un ingénieur, et pas seulement être le professionnel qu'il est vraiment.

Il semble ridicule de prétendre délibérément être quelqu'un que vous n'êtes pas. Mais si nous voulons comprendre le comportement d'un cactus récursif, il est conseillé de comprendre ce qu'est cette barre. Et si vous réfléchissez un peu à ce sujet, il semble qu'il n'ait pas une définition aussi claire.

Définition du "bar"

Voyons comment les entreprises FAANG (Facebook, Amazon, Apple, Netflix, Google) placent la barre. Après tout, ce sont les entreprises qui reçoivent le plus d'attention de pratiquement tout le monde, y compris les demandeurs d'emploi.

Peu d'entre eux fournissent des détails spécifiques sur le processus de recrutement. Apple ne partage publiquement aucune information. Facebook décrit les étapes de l'entretien, mais pas les critères d'évaluation. Netflix et Amazon affirment embaucher des candidats qui correspondent à leur culture de travail et à leurs principes de leadership. Ni Netflix ni Amazon ne décrivent exactement comment ils mesurent les principes sous-jacents. Cependant, Amazon indique comment les entretiens sont menés et nomme également des sujets qui peuvent être discutés dans les entretiens avec les développeurs....

La plus transparente des grandes entreprises, Google divulgue publiquement son processus d'entretien dans les moindres détails, ainsi que le livre de Laszlo Bock "Work rules!" ajoute des détails intérieurs.

Parlant des géants de la technologie d'un point de vue historique, Alina (notre fondatrice) a mentionné dans le dernier article le livre de 2003 Comment déplacer le mont Fuji? , qui parle du processus d'entretien chez Microsoft à l'époque où l'entreprise était un géant technologique de premier plan.

Pour recueillir plus d'informations sur la façon dont les entreprises évaluent les candidats, j'ai également examiné les interviews de programmation de piratage par Gaila Luckmann McDowell, qui est en fait la Bible pour les entretiens avec des candidats potentiels, etGuerrilla Interviewing Guide 3.0 de Joel Spolsky, écrit par une figure influente et bien connue des milieux technologiques.

Définitions des planches

| Une source | Critères d'évaluation |

|---|---|

| Pomme | Non publié publiquement |

| Amazone | Conformité aux principes de leadership d'Amazon |

| Non publié publiquement | |

| Netflix | Non publié publiquement |

| 1. Capacités cognitives générales

2. Leadership 3. "Google" 4. Connaissances professionnelles |

|

| Hacking Coding Interviews par Gaila Luckmann McDowell | - Compétences analytiques - Compétences en

programmation - Connaissances techniques / fondamentaux de l'informatique - Expérience - Pertinence culturelle |

| Joël Spolsky | - Soyez intelligent

- Faites votre travail avec succès |

| Microsoft (vers 2003) | - "Le but de l'entretien avec Microsoft est d'évaluer la capacité globale de résolution de problèmes, pas la compétence spécifique."

- "Vitesse de réflexion, ingéniosité, capacité de résolution de problèmes créative, sortir des sentiers battus ." ils l'ont fait " - Motivation |

Définition du «renseignement»

Sans surprise, le codage et les connaissances techniques font partie des critères d'embauche d'un développeur dans n'importe quelle entreprise. Après tout, c'est du travail.

Mais à côté de cela, beaucoup de gens mentionnent le critère de l'intelligence générale. Bien qu'ils utilisent des mots différents et définissent les termes légèrement différemment, ils pointent tous vers un concept de ce que les psychologues appellent «capacité cognitive».

| Une source | Détermination des capacités cognitives |

|---|---|

| « . , , . , , , GPA SAT» | |

| Microsoft ( 2003 ) | « Microsoft — , … , . , » |

| « - , , , » | |

| « (, ), , , . » |

Toutes ces définitions rappellent la théorie du psychologue du début du 19e siècle Charles Spearman, la théorie de l'intelligence la plus largement acceptée. Dans une série de tests cognitifs sur des écoliers, Spearman a constaté que ceux qui réussissaient bien sur un type de test avaient tendance à bien réussir sur d'autres tests également. Cette compréhension a conduit Spearman à la théorie selon laquelle il existe un seul facteur de capacité commun de base («g» ou «facteur g») qui affecte toutes les mesures, indépendamment des capacités spécifiques à une tâche («s»).

Si vous croyez en l'existence de "g" (beaucoup le croient, certains non ... il existe différentes théories de l'intelligence ), alors trouver des candidats avec des scores "g" élevés correspond clairement aux critères d'intelligence dans les entreprises.

Bien que les entreprises prennent également en compte d'autres critères, tels que le leadership et la culture, la barre n'est généralement pas définie dans ces termes. La planche est définie comme la possession de compétences techniques, ainsi que (et peut-être dans une plus grande mesure) d'intelligence générale . Après tout, les candidats ne forment généralement pas leur leadership et leur culture.

Ensuite, la question se pose de savoir comment le mesurer. Mesurer les compétences techniques semble difficile mais faisable, mais comment mesurez-vous «g»?

Mesurer l'intelligence générale

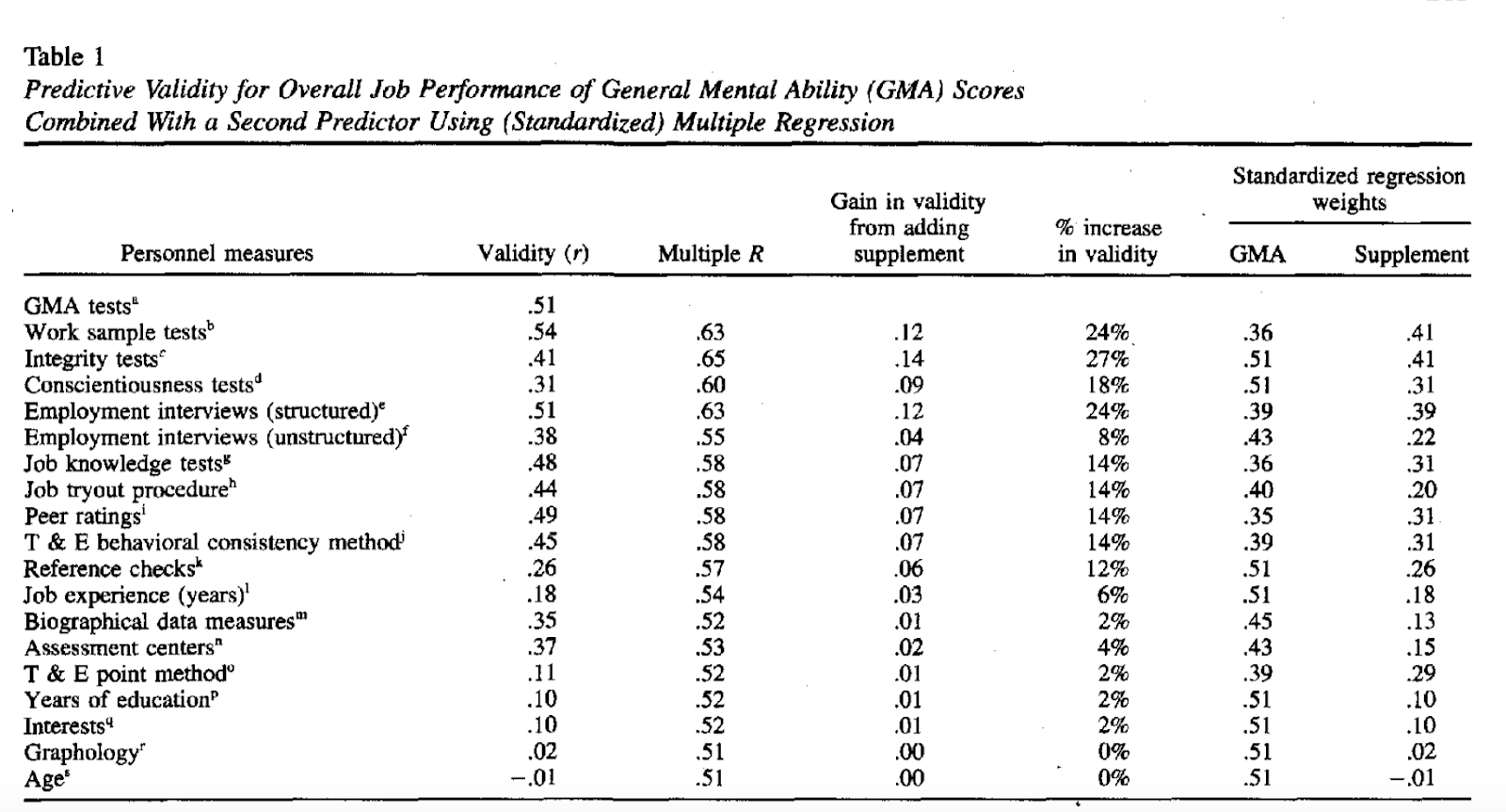

Le livre Boca mentionnait l'article de Frank Schmidt et John Hunter 1998 "La validité et l'utilité des méthodes de sélection en psychologie du personnel" . Elle tente de répondre à cette question en analysant un large éventail de 19 critères de sélection des candidats. Le défi consiste à déterminer lesquels prédisent le mieux les performances futures. Les auteurs ont conclu que l'intelligence générale (test GMA) est le meilleur prédicteur de la productivité du travail («validité prédictive»).

Dans cette étude, le test GMA est considéré comme un test de QI. Mais vers 2003, Microsoft a utilisé des énigmes telles que "Combien y a-t-il d'accordeurs de piano dans le monde?" Leur explication:

« Microsoft, , , , , . , , , , »

— « ?», . 20

Avance rapide jusqu'à aujourd'hui. Google condamne cette pratique , concluant que "la performance sur ce type de questions est au mieux une compétence discrète qui peut être améliorée grâce à la formation afin qu'elle ne soit d'aucune utilité pour évaluer les candidats".

Nous avons donc deux entreprises qui testent l'intelligence générale mais qui sont fondamentalement en désaccord sur la façon de la mesurer.

Mesurons-nous des capacités spécifiques ou une intelligence générale?

Mais peut-être, comme Spolsky et McDowell l'ont fait valoir, les questions d'interview algorithmiques et informatisées traditionnelles sont, en elles-mêmes, des tests efficaces d'intelligence générale. Les recherches de Hunter et Schmidt apportent un certain soutien à cette théorie. Parmi tous les outils d'évaluation à critère unique, les tests avec des échantillons de travail avaient la validité prédictive la plus élevée. En outre, lors de l'examen du résultat de régression le plus élevé de la validité d'un instrument de notation à deux critères (test GMA plus un test avec un échantillon de travail), la taille de l'effet normalisé sur l'évaluation de l'échantillon de travail était supérieure à celle de la note GMA, indiquant une relation plus forte avec les performances futures du candidat.

La recherche suggère que les entretiens algorithmiques traditionnels prédisent les performances futures, peut-être même plus que le test GMA / IQ.

Recursive Cactus ne croit pas qu'il existe une telle connexion:

«Il y a peu de chevauchement entre les connaissances acquises au travail et la résolution de problèmes algorithmiques. La plupart des ingénieurs traitent rarement des graphiques ou de la programmation dynamique. En programmation d'application, les structures de données les plus courantes sont les listes et les objets dictionnaire. Cependant, les questions d'entrevue qui leur sont associées sont souvent considérées comme insignifiantes, de sorte que l'accent est mis sur d'autres catégories de problèmes. "

À son avis, les questions d'algorithme sont similaires aux questions de puzzle Microsoft: vous apprenez des tâches à partir d'entretiens que vous ne rencontrerez jamais dans le travail réel. Si tel est le cas, cela ne correspond pas vraiment aux recherches de Hunter et Schmidt.

Malgré les convictions personnelles de Recursive Cactus, des intervieweurs comme Spolsky croient toujours que ces compétences sont extrêmement importantes pour un programmeur productif.

« , , : „ ?” — .

, . , , . , , Ruby on Rails 2.0».

—

Spolsky admet que les questions d'entretien techniques traditionnelles ne peuvent pas simuler de vrais problèmes de travail. Au contraire, ils testent les capacités générales en informatique qui sont générales à certains égards mais spécifiques à d'autres égards. Nous pouvons dire qu'il s'agit de renseignements généraux dans un certain domaine.

Ainsi, si vous ne pensez pas que l'intelligence informatique est une intelligence générale, McDowell suggère ce qui suit:

«Il y a une autre raison pour laquelle la connaissance des structures de données et des algorithmes est discutée: parce qu'il est difficile de trouver des questions pour résoudre des problèmes qui ne leur sont pas liés. Il s'avère que la grande majorité des questions de résolution de problèmes impliquent certains de ces principes fondamentaux. "

- Gail Luckmann McDowell

Cela peut être vrai lorsque vous regardez le monde à travers le prisme de l'informatique. Cependant, il serait injuste de penser que les non-programmeurs ont plus de difficultés à résoudre les problèmes.

À ce stade, nous ne parlons pas de mesurer l'intelligence générale telle que Spearman la définissait à l'origine. Nous parlons plutôt d'une intelligence spécifique définie ou diffusée par ceux qui ont grandi ou qui participent à l'enseignement informatique traditionnel, en conjonction avec l'intelligence générale (Spolsky, McDowell, Bill Gates de Microsoft et quatre des cinq fondateurs de FAANG ont étudié l'informatique ou certains Ivy League University ou Stanford).

Peut-être que lorsque nous parlons de la barre, nous voulons vraiment dire quelque chose de subjectif, selon qui fait la mesure, et cette définition diffère d'une personne à l'autre.

Cette hypothèse est étayée par les notes que les candidats reçoivent des intervieweurs sur notre plateforme.

La barre est subjective

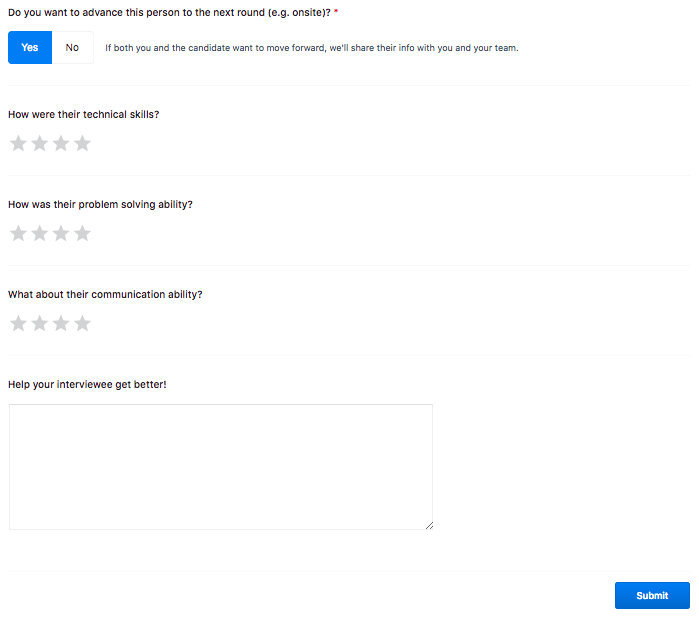

Sur notre plateforme interviewing.io, les gens se forment à des entretiens techniques en ligne, avec des intervieweurs de grandes entreprises, et de manière anonyme. Les questions d'entrevue sont similaires à celles que vous pourriez entendre lors d'un examen téléphonique pour un poste de développeur backend, et les intervieweurs proviennent généralement d'entreprises comme Google, Facebook, Dropbox, Airbnb et d'autres. Voici quelques exemples de ces entretiens . Après chaque entretien, les enquêteurs évaluent les candidats sur plusieurs dimensions: compétences techniques, compétences en communication et compétences en résolution de problèmes sur une échelle de 1 à 4, où 1 signifie «mauvais» et 4 est «incroyable!». Voici à quoi ressemble le formulaire de commentaires:

Si vous vous sentez en confiance, vous pouvez sauter la formation et postuler pour un véritable entretien directement avec nos entreprises partenaires (plus à ce sujet plus tard).

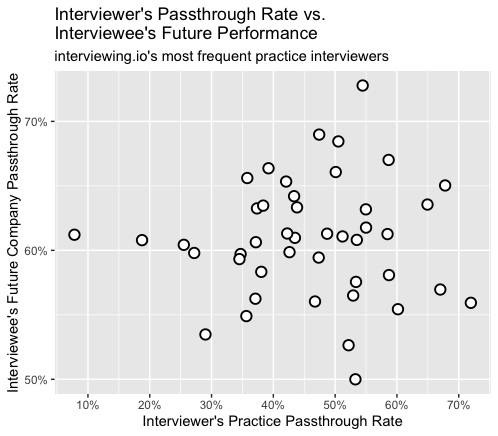

En observant les intervieweurs les plus actifs, nous avons remarqué une différence dans le pourcentage de candidats que cette personne embaucherait («taux de réussite»). Ce ratio varie de 30% à 60%. Certains intervieweurs semblent beaucoup plus durs que d'autres.

Étant donné que les personnes interrogées et les enquêteurs sont anonymes et sélectionnés au hasard [1]Nous ne nous attendons pas à ce que la qualité des candidats varie considérablement entre les intervieweurs. Par conséquent, la qualité des personnes interrogées ne devrait pas être la cause de ce phénomène. Cependant, même en tenant compte des attributs d'un candidat comme l'expérience, il existe toujours une différence dans le taux de passage pour différents intervieweurs [2]...

Peut-être que certains intervieweurs sont intentionnellement stricts parce que leur barre est plus élevée. Bien que les candidats qui atteignent les plus stricts intervieweurs reçoivent des notes inférieures, ils obtiennent généralement de meilleurs résultats lors de l'entretien suivant.

Ce résultat peut être interprété de plusieurs manières:

- Les intervieweurs plus stricts sous-estiment systématiquement les candidats

- Les candidats sont tellement fatigués par les intervieweurs rigoureux qu'ils ont tendance à s'améliorer entre les entretiens dans le but d'atteindre la barre supérieure de l'intervieweur d'origine.

Si ce dernier est vrai, alors les candidats qui se sont formés avec des intervieweurs plus rigoureux devraient mieux performer dans les entretiens réels. Cependant, nous n'avons pas trouvé de corrélation entre la sévérité de l'intervieweur et la rapidité de réussite des futurs entretiens réels sur notre plateforme [3]...

Les intervieweurs de notre plate-forme représentent les types de personnes qu'un candidat rencontrerait lors d'un entretien réel, car les mêmes personnes effectuent une sélection téléphonique et des entretiens en face à face avec des entreprises technologiques réelles. Et puisque nous ne dictons pas la méthodologie de l'entretien, ces graphiques montrent également la répartition des opinions sur les résultats de votre entretien dès que vous raccrochez ou quittez le bureau.

Cela suggère que, quelles que soient vos réponses réelles, les chances d'obtenir un emploi dépendent vraiment de la personne avec qui vous interviewez . En d'autres termes, la barre est subjective.

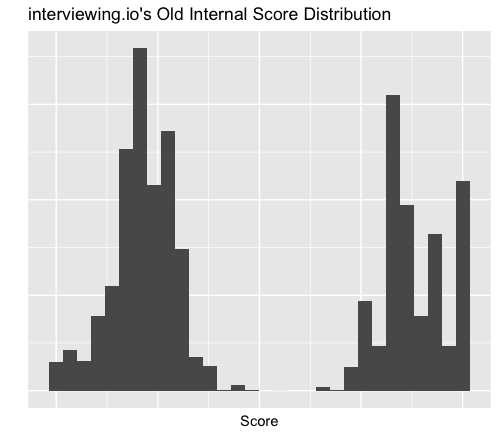

Cette différence entre les enquêteurs nous a obligés à repenser notre propre définition de la barre qui filtre les candidats lors de leur admission aux entretiens avec nos entreprises partenaires. Notre définition ressemblait étroitement aux critères binaires de Spolsky («soyez intelligent»), surestimant l'opinion de l'intervieweur et sous-estimant les trois autres critères, résultant en une distribution bimodale, semblable à un chameau, qui est illustrée dans le diagramme ci-dessous.

Bien que le système de notation actuel corresponde raisonnablement bien aux résultats des entretiens futurs, nous avons constaté que le score de l'intervieweur n'est pas aussi fortement corrélé aux résultats futurs que nos autres critères. Nous avons réduit son poids, ce qui a finalement augmenté la précision des prévisions [4]... Comme dans le film Ricky Bobby: le roi de la route, Ricky Bobby a appris qu'il y a d'autres endroits dans la course en plus du premier et du dernier , donc nous avons également appris qu'il est utile d'aller au-delà de la structure binaire de «embaucher - pas embaucher», ou, si vous préférez , "Intelligent - pas intelligent".

Bien sûr, nous ne pouvions pas nous débarrasser complètement de la subjectivité, puisque d'autres critères sont également déterminés par l'enquêteur. Et c'est ce qui rend l'évaluation difficile: l'évaluation de l'enquêteur est elle-même une mesure de la capacité du candidat.

Dans une telle situation, la précision de chaque mesure spécifique devient moins certaine. C'est comme si les enquêteurs utilisaient des bâtons de différentes longueurs pour mesurer, mais tout le monde supposait que la longueur de leur propre bâton était connue, disons, un mètre.

Lorsque nous avons discuté avec nos enquêteurs de l'évaluation des candidats, la théorie des bâtons de différentes longueurs s'est confirmée. Voici quelques exemples de la façon dont les intervieweurs évaluent les candidats:

- Posez deux questions. Si répond aux deux, le test est réussi

- Poser des questions de difficulté variable (facile, moyen, difficile). Si la réponse est moyenne, le test est réussi

- La rapidité de la réponse est d'une grande importance. Le test est réussi si les réponses sont rapides (le terme «rapide» n'est pas clairement défini)

- La vitesse n'a pas vraiment d'importance. Passer s'il y a une solution de travail

- Les candidats commencent avec la note la plus élevée. Des points sont déduits pour chaque erreur

Différents critères d'évaluation - pas nécessairement mauvais (et en fait, tout à fait normaux). Ils introduisent simplement une grande dispersion dans nos mesures, c'est-à-dire que les évaluations des candidats ne sont pas entièrement exactes.

Le problème est que lorsque quelqu'un parle de la barre, il ignore généralement l'incertitude des mesures.

Il est souvent conseillé de n'embaucher que des candidats de haut niveau.

«Une bonne règle de base est de n'embaucher que ceux qui sont meilleurs que vous. Pas de compromis. Toujours "

- Laszlo Bock

«N'abaissez pas vos normes, même s'il est difficile de trouver ces excellents candidats.»

- Joel Spolsky

«Dans la division Macintosh, nous avions un dicton: 'Le joueur A engage les joueurs A; Les joueurs B embauchent des joueurs C »- cela signifie que des gens formidables embauchent aussi des gens formidables»

- Guy Kawasaki

"Chaque employé embauché devrait être meilleur que 50% de ceux qui occupent actuellement des rôles similaires - cela élève la barre"

- Article de blog Bar Raiser sur Amazon

Ce sont tous de bons conseils. Cependant, ils supposent que la «qualité» peut être mesurée de manière fiable. Mais nous avons déjà vu que ce n'est pas toujours le cas.

Même lorsque l'incertitude est mentionnée, la variance est attribuée à la capacité du candidat et non au processus de mesure ou à l'intervieweur.

«Au milieu, il y a un grand nombre d'employés« potentiellement utiles »qui semblent être en mesure de contribuer à la cause commune. La clé est de distinguer les superstars de celles "potentiellement utiles", puisque vous ne voulez pas en embaucher des "potentiellement utiles". Jamais.

…

Si vous avez du mal à décider, il existe une solution très simple. N'embauchez personne. N'embauchez pas quelqu'un dont vous n'êtes pas sûr. "

- Joel Spolsky

L'évaluation des candidats n'est pas un processus complètement déterministe, mais beaucoup le considèrent comme tel.

Pourquoi la barre est-elle si haute

L'expression «compromis de qualité» ne signifie pas vraiment compromis, mais prise de décision face à l'incertitude. Et comme vous pouvez le voir sur les citations ci-dessus, la stratégie habituelle est de n'embaucher que lorsqu'il y a une confiance absolue.

Quel que soit le bâton de mesure que vous avez, cela élève la barre très haut. Avoir entièrement confiance en un candidat signifie minimiser la possibilité d'une mauvaise embauche («faux positifs»). Et les entreprises font tout ce qu'elles peuvent pour l'éviter.

«Un mauvais candidat coûte très cher compte tenu du temps qu'il faut pour corriger toutes ses erreurs. Le licenciement d'un employé embauché par erreur peut prendre des mois et être un cauchemar, surtout s'il choisit de poursuivre en justice. "

- Joel Spolsky

Hunter et Schmidt ont calculé le coût d'une mauvaise embauche: «L'écart type ... représente au moins 40% du salaire annuel moyen», soit 40 000 $ aujourd'hui, en supposant que le salaire moyen d'un ingénieur est de 100 000 $.

Mais si vous placez la barre trop haut, il y a de fortes chances que que vous ratez quelques bons candidats (faux négatifs). McDowell explique pourquoi les entreprises ne se soucient pas vraiment de beaucoup de faux négatifs:

«Du point de vue de l'entreprise, il est vraiment acceptable de rejeter un certain nombre de bons candidats ... ils sont prêts à l'accepter. Bien sûr, ils préfèrent ne pas le faire car cela augmente les coûts des RH. Mais c'est un compromis acceptable, à condition qu'ils reçoivent encore un nombre suffisant de bons candidats. "

En d'autres termes, il vaut la peine d'attendre le meilleur candidat si l'écart de résultat attendu est important par rapport aux coûts de recrutement liés à la poursuite de votre recherche. En outre, les coûts de personnel et les problèmes juridiques des employés potentiellement problématiques font également monter la barre autant que possible.

Cela ressemble à un calcul très rationnel des coûts et des bénéfices. Mais est-ce que quelqu'un a réellement fait un tel calcul en chiffres? Si tel est le cas, nous serions ravis de vous entendre. Mais cela semble très difficile en pratique.

Étant donné que tous les calculs sont effectués à l'œil nu, nous pouvons faire de même et affirmer que la barre ne doit pas être placée si haut.

Comme mentionné précédemment, la distribution des capacités des candidats n'est pas binaire, de sorte que le scénario de cauchemar de Spolsky ne se produira pas avec toutes les prétendues «mauvaises» embauches, ce qui signifie que la différence de performance attendue entre les «bons» et les «mauvais» employés peut être moindre que prévu.

D'un autre côté, les coûts de recrutement peuvent s'avérer plus élevés que prévu car les candidats deviennent plus difficiles à sélectionner à mesure que leurs qualifications augmentent. Par définition, plus la barre est élevée, moins ces personnes sont nombreuses. Le calcul des dommages de «mauvaise location» de Schmidt et Hunter compare les candidats uniquement au sein du pool. L'étude ne prend pas en compte le coût relatif du recrutement de candidats de haute qualité dans le pool, qui est un problème majeur pour de nombreuses équipes de recrutement technologiques de nos jours. Et si d'autres sociétés informatiques utilisent la même stratégie de recrutement, la concurrence augmente la probabilité moyenne qu'un candidat refuse une offre. Cela augmente le temps nécessaire pour pourvoir le poste vacant.

Pour résumer, si le résultat attendu entre les «bons» et les «mauvais» candidats est moins élevé que prévu et que les coûts de recrutement sont plus élevés que prévu, alors il est logique de baisser la barre.

Même si une entreprise a embauché un employé inefficace, elle peut utiliser la formation et les outils RH pour atténuer l'impact négatif. Après tout, la productivité d'une personne augmente vraiment avec le temps, elle acquiert de nouvelles compétences et connaissances.

Cependant, lors de l'embauche, les gens pensent rarement au développement des employés (Laszlo Bock le mentionne à certains endroits, mais la plupart de ces sujets sont discutés séparément les uns des autres). Mais si vous en tenez compte, un lien peut être établi entre l'embauche et le développement des employés. Vous pouvez parler de différentes méthodes pour augmenter l'efficacité du travail: soit payer pour la formation d'employés existants, soit en embaucher de nouveaux.

Vous pouvez même le considérer comme un compromis. Au lieu de développer les collaborateurs en interne, pourquoi ne pas externaliser ce développement? Laissez les autres découvrir comment développer des talents bruts, et vous paierez plus tard des recruteurs pour trouver des professionnels prêts à l'emploi. Pourquoi acheter chez Whole Foods et cuisiner à la maison alors que vous pouvez payer pour livrer des plats cuisinés? Pourquoi perdre du temps en gestion et en formation alors que vous pouvez faire du vrai travail (c'est-à-dire des tâches d'ingénierie)?

Peut-être que la barre est si haute parce que les entreprises ne savent pas comment développer efficacement les gens.

Ainsi, les entreprises réduisent les risques en transférant le fardeau de la croissance de carrière sur les candidats eux-mêmes. À leur tour, les candidats tels que Recursive Cactus n'ont pas d'autre choix que de pratiquer les entretiens.

Au début, je pensais que le cactus récursif était l'exception à la règle. Mais il s'est avéré qu'il n'était pas seul.

Les candidats s'entraînent avant l'entrevue

L'année dernière, nous avons demandé aux candidats combien d'heures ils avaient passé à préparer l'entrevue. Près de la moitié des répondants ont déclaré avoir consacré 100 heures ou plus à la préparation [5]...

Nous nous sommes intéressés à la façon dont les recruteurs comprennent la situation. Alina a posé une question similaire sur Twitter - et les résultats ont montré que les responsables RH sous-estiment largement les efforts des candidats pour se préparer aux entretiens.

Apparemment, cet écart ne fait que confirmer la règle cachée et tacite de l'embauche: si vous n'êtes pas l'un des plus intelligents (quoi que cela signifie), ce n'est pas notre problème.

Révision de la barre

Voilà donc ce qu'est la «planche». Il s'agit d'une norme élevée établie par les entreprises pour éviter les faux positifs. Cependant, on ne sait pas si les entreprises ont effectivement effectué une analyse coûts-avantages appropriée. Peut-être la barre haute peut-elle s'expliquer par une réticence à investir dans le développement des employés.

Plank mesure à peu près votre intelligence générale, mais les outils de mesure réels ne correspondent pas nécessairement à la littérature scientifique. Même la littérature scientifique elle-même sur ce sujet peut être qualifiée de douteuse [6]... La barre mesure en fait une intelligence spécifique en informatique, mais cette mesure varie en fonction de la personne qui vous interviewe.

Malgré les différences dans de nombreux aspects de l'embauche, nous parlons du bar comme s'il avait un sens clair. Cela permet aux responsables du recrutement de faire des choix binaires clairs, mais ne leur permet pas de réfléchir de manière critique à la question de savoir si la définition de la «barre» peut être améliorée pour leur entreprise.

Et cela aide à comprendre pourquoi le cactus récursif passe autant de temps à s'entraîner. C'est en partie parce que son entreprise actuelle ne développe pas ses compétences. Il se prépare à une myriade de questions et d'intervieweurs possibles auxquels il pourrait être confronté car les critères de recrutement varient considérablement. Il explore des sujets qui ne seront pas forcément utilisés dans son travail quotidien - le tout dans le but de passer pour ceux qui sont considérés comme "intelligents".

C'est le système actuel qui a eu un impact significatif sur sa vie personnelle.

«Ma femme a dit plus d'une fois que je lui manquais. J'ai une vie bien remplie et heureuse, mais je ressens le besoin de me préparer à fond pendant plusieurs mois pour être compétitif dans les entretiens. Aucune mère célibataire ne peut se préparer comme ça. »

- Cactus récursif

Cela affecte son travail actuel et ses collègues.

«Le processus demande beaucoup d'efforts, je ne peux donc plus travailler à 100%. J'aimerais pouvoir faire mieux, mais je ne peux pas simultanément m'occuper de mon avenir, pratiquer des algorithmes quatre heures par jour et bien faire mon travail.

Ce n'est pas une sensation très agréable. J'aime mes collègues. Je me sens responsable. Je sais que je ne serai pas viré, mais je comprends qu'ils ont un fardeau supplémentaire "

- Cactus récursif

Il est utile de se rappeler que toutes ces micro-décisions concernant les faux positifs, la structure des entretiens, les énigmes, les critères d'embauche et de développement s'ajoutent à un système qui affecte en fin de compte la vie personnelle des gens. Non seulement les candidats eux-mêmes, mais aussi toutes les personnes qui les entourent.

Le recrutement du personnel est loin d'être un problème résolu. Même si nous le résolvons d'une manière ou d'une autre, il n'est pas clair si nous pourrons un jour éliminer toute cette incertitude. Après tout, il est assez difficile de prédire l’issue future du travail d’une personne après avoir passé une heure ou deux avec elle dans un environnement de travail artificiel. Bien que nous devrions certainement minimiser l'incertitude, il est utile de l'accepter comme une partie naturelle du processus.

Le système peut être amélioré. Cela nécessite non seulement de proposer de nouvelles idées, mais aussi de revoir les idées et les hypothèses formulées il y a des décennies. Vous devez prendre en compte le travail précédent et passer à autre chose et ne pas vous y attacher.

Nous sommes convaincus que tout le monde dans l'industrie informatique peut contribuer et améliorer le système de recrutement informatique. Nous savons que vous pouvez le faire, ne serait-ce que parce que vous êtes intelligent.

[1]Il existe un certain potentiel de biais, en particulier en ce qui concerne le temps que les candidats choisissent pour se former. Une analyse superficielle montre que la connexion n'est pas si significative, mais nous étudions cette question (nous pourrions écrire sur ce sujet dans un blog à l'avenir). Vous pouvez également choisir sur le site entre l'entretien algorithmique traditionnel et l'entretien de conception du système, mais la grande majorité choisit l'interview traditionnelle. Les taux de réussite indiqués sont en ligne avec les entretiens traditionnels. [retour]

[2]Vous vous interrogez peut-être sur le niveau relatif des candidats sur interviewing.io. Bien que le niveau réel soit difficile à déterminer (ce qui est le thème principal de cet article), nos enquêteurs praticiens disent que le niveau moyen des candidats à interviewing.io correspond au niveau qu'ils rencontrent lors des entretiens dans leurs propres entreprises, notamment lors de la projection téléphonique. [retour]

[3]Cela comprend uniquement les candidats qui répondent à nos normes de recrutement internes et qui sont venus pour une entrevue à notre bureau. Le graphique ne reflète pas l'ensemble de la population des candidats qui ont été interviewés. [retour]

[4]Vous vous souvenez peut-être qu'auparavant nous avions un algorithme qui ajustait les statistiques en fonction de la rigueur des enquêteurs. Après un examen plus approfondi, nous avons constaté que cet algorithme introduit une variance dans les scores des candidats de manière inattendue. Par conséquent, maintenant, nous ne comptons plus tant sur lui. [retour]

[5]Les rafales à 100 et 200 heures étaient dues à une erreur de formulation et des valeurs maximales de l'enquête. Les trois questions suivantes ont été posées: 1) Lors de votre dernière recherche d'emploi, combien d'heures avez-vous passé à préparer votre entretien? 2) Combien d'heures avez-vous passé à vous préparer à l'entrevue avant de vous inscrire à interviewing.io? 3) Combien d'heures avez-vous passé à vous préparer à l'entretien après vous être inscrit à interviewing.io (sans compter le temps passé sur le site Web)? Les réponses à chaque question étaient limitées à 100 heures maximum, mais pour de nombreux répondants, la somme des réponses 2 et 3 dépassait 100. La médiane des réponses à la question 1 était de 94, ce qui est presque identique à la médiane de la somme des réponses 2 et 3, nous avons donc utilisé cette somme pour une distribution supérieure à 100 heures. Leçons clés: définissez la valeur maximale plus élevée que prévuet vérifiez votre enquête.[retour]

[6]Je trouve un peu difficile d'évaluer cette étude car je ne suis pas psychologue et des méthodes comme la méta-analyse me sont un peu étrangères, bien qu'elles reposent sur des outils statistiques familiers. La question n'est pas de savoir si ces outils sont corrects, mais dans quelle mesure il est difficile de raisonner sur l'apport de la recherche. Comme le code spaghetti, la validation des ensembles de données sous-jacents est répartie sur des décennies de travaux scientifiques antérieurs, ce qui rend l'analyse difficile. C'est probablement la nature de la psychologie, où il est plus difficile d'obtenir des données utiles par rapport aux sciences naturelles. En outre, d'autres questions se posent sur la méthodologie, qui sont traitées plus en détail dans cet article . [revenir]