Film double

Vous avez probablement vu des acteurs doubles à l'écran plus d'une fois et, très probablement, vous n'avez même pas remarqué la substitution. Si auparavant, les maquilleurs étaient responsables de la similitude, les réalisateurs attirent de plus en plus des équipes de développement de l'industrie du développement de jeux.

Gladiator, que j'ai cité en exemple, a été l'un des premiers films à présenter un jumeau numérique. Celles de ses scènes qui n'ont pas eu le temps d'être filmées avec Oliver Reed ont été collectées à partir de matériel partiellement filmé, en ajoutant des cadres réalisés à l'aide de graphiques 3D. Pour 1999, nous avons réussi à obtenir un résultat tout simplement fantastique, et même les spécialistes en CG ne remarquent souvent pas la substitution.

Un autre exemple célèbre de la recréation d'un héros de cinéma après la mort d'un acteur est le film "Superman Returns" (2006) de Brian Singer. Faire de Marlon Brando le père d'un surhomme était une question de principe pour le réalisateur, car en 1978, Brando jouait le même rôle dans Superman.

Un modèle 3D du visage de l'acteur a été créé à partir de photographies, et son animation - expressions faciales et mouvements des yeux - a été créée sur la base des images de l'acteur qui n'étaient pas incluses dans la version d'édition finale. En général, un processus très long.

Jusqu'à il y a dix ans, de nombreuses opérations complexes pour créer un modèle photoréaliste étaient effectuées manuellement. Et l'industrie cinématographique moderne dispose déjà d'une énorme pile technologique aux mêmes fins, et il n'est pas nécessaire de «réinventer la roue».

L'exemple le plus révélateur des progrès technologiques est peut-être le processus de création de cuir en 3D. La peau humaine transmet la lumière et un rayon qui la traverse est réfléchi et distribué à l'intérieur. En infographie, c'est ce qu'on appelle la diffusion souterraine - la distribution de la lumière sous la surface. Les moteurs de rendu modernes qui implémentent la fonctionnalité de matériau de diffusion Subsurface sont capables de calculer cet effet physiquement correctement. Et il y a 10 ans, vous deviez le programmer ou créer un "faux" en post-traitement.

Maintenant, le processus est automatisé et il vous suffit de changer manuellement la couleur et la texture de la peau. De plus, la gestion de la couleur peut être effectuée par un mécanisme biologiquement correct - en modifiant la teneur en mélanine du matériau de la peau. Les jumeaux numériques modernes sont si réalistes que vous pouvez à peine comprendre que dans un cadre particulier, vous voyez l'humain numérique, et non votre acteur préféré.

Envie de vous entraîner? Regardez la série SuperBobrovs avec la star du Dog's Heart Vladimir Tolokonnikov. Malheureusement, l'acteur, connu de tous pour son rôle de Polygraph Poligrafovich Sharikov, n'a pas pu terminer le tournage en raison d'un arrêt cardiaque. Donc toutes les scènes manquantes ont été jouées par son avatar.

De sérieux progrès dans la création de jumeaux numériques sont également associés au développement de la puissance de calcul. Si auparavant, pour calculer une séquence avec un caractère numérique, des fermes entières de processeurs et de RAM étaient nécessaires, maintenant tout est considéré sur un ordinateur de jeu à domicile - lentement mais sûrement. Je pense donc qu'Antony Proximo pourrait être rendu en un mois environ par trois d'entre nous. Et si l'on prend également en compte la création d'un modèle tridimensionnel (la partie la plus longue et la plus coûteuse du travail), la durée totale du projet serait de 2 à 2,5 mois, et le budget pourrait être limité à 100 mille dollars.

Usine de contenu d'entreprise

Les progrès des technologies de création de modèles photoréalistes de personnes s'accompagnent d'un saut dans le développement de réseaux de neurones avec lesquels vous pouvez contrôler des modèles 3D. Ensemble, cela crée la base d'une application plus large de l'humain numérique. Ainsi, en combinant un modèle 3D avec des réseaux de neurones ou un chat bot, vous pouvez organiser toute une usine de production de contenu vidéo: vous le «nourrissez» du texte, et votre avatar le lit avec des expressions faciales et des émotions. Le développement d'un tel scénario est déjà sur le marché , cependant, ils n'utilisent pas de modèles 3D, mais des photographies de personnes réelles.

En regardant les présentateurs de nouvelles sur les chaînes fédérales, beaucoup pensent que c'est ainsi qu'ils fonctionnent. En fait, non - les présentateurs lisent non seulement le texte avec des expressions faciales et des émotions, mais l'écrivent également pour eux-mêmes. Et à l'avenir, bien sûr, les réseaux de neurones pourront «écrire» du texte pour les blogs télévisés et vidéo, et les avatars pourront les exprimer. Et lors de l'organisation des rapports, il sera également possible d'économiser de l'argent - envoyer uniquement l'opérateur sur le site, et superposer un stand-up d'avatar avec le texte écrit par l'éditeur sur le matériel vidéo déjà filmé.

Chez LANIT-intégration pense que deux directions de l' utilisation des technologies de l' homme numérique sont les plus prometteuses.

La première consiste à remplacer le visage d'une personne par une vidéo.... Probablement, tout le monde a déjà vu les clones d'Elon Musk qui se sont connectés aux conférences Zoom. Ce scénario s'appelle Deep Fake et, comme son nom l'indique, est utilisé pour toutes sortes de faux. Technologiquement, la même direction s'appelle aussi Face Swap, mais ce scénario n'est plus pour les relations publiques noires, mais à des fins commerciales qui ne suscitent pas de controverse éthique. Par exemple, vous pouvez déboguer la production de contenu éducatif.

Une banque dotée d'un réseau d'agences fédérales propose de nombreuses vidéos de formation de différentes qualités. Certains d'entre eux ne sont que des enregistrements de conférences Zoom. La faible qualité de la vidéo et la situation dans le cadre, qui ne correspond pas au standard de l'entreprise, ne permettent pas de les rassembler en une seule formation. Et avec l'aide d'avatars numériques et de réseaux de neurones, vous pouvez tout réparer - changer à la fois l'arrière-plan et l'apparence du haut-parleur.

Un scénario similaire pour la création de produits vidéo est intéressant pour la télévision et les blogueurs. Récemment, nous avons été contactés par le producteur d'une chaîne thématique et nous avons demandé d'estimer le coût de production de numéros réguliers avec la participation d'un avatar numérique en tant que présentateur. Bien sûr, Digital Human ne supprimera pas toutes les tâches - il n'y a toujours pas de technologie permettant à un avatar de reproduire des émotions lors du traitement de texte par un réseau de neurones - pour cela, vous avez toujours besoin d'une personne vivante, dont les expressions faciales et les mouvements que l'avatar utilisera. De plus, vous avez besoin d'un spécialiste qui prendra en charge l'écriture de scripts, de textes pour le doublage. Certes, ce à quoi ressemblent les personnes impliquées dans la production de contenu médiatique, leur sexe, leur timbre de voix et leur position n’est absolument pas important. Pour photographier, vous aurez besoin d'une combinaison pour la capture de mouvement, d'un casque avec une caméra vidéo dirigée vers le visage (pour «capturer» les expressions faciales),et l'avatar lui-même, qui diffusera en temps réel sur l'écran tous les mouvements du travailleur hors écran. Selon nos calculs, cette technologie réduira de 10 fois le coût de la production vidéo.

La deuxième direction de l'application Digital Human est de combiner un avatar numérique avec un chatbot et un système de synthèse vocale , et elle peut être très demandée pour la communication avec les clients.

Les chatbots sont désormais utilisés dans de nombreux centres d'appels. Mais tous les clients ne sont pas à l'aise pour communiquer avec un robot. Peut-être que la communication serait plus agréable si le client voyait son interlocuteur numérique.

En vissant un chatbot, un microphone et un système de reconnaissance et de synthèse de la parole à un avatar numérique, vous pouvez créer des hôtesses virtuelles, des conseillers commerciaux, des consultants dans les institutions gouvernementales ( Soul Machines a un cas similaire - l' assistant virtuel Ellacommunique avec les visiteurs du quartier général de la police néo-zélandaise), les sommeliers - en général, tous les employés dont la tâche principale est simplement de répondre aux questions des clients. En théorie, cela permettra d'économiser de l'argent sur la paie et les employés - pour faire ce que le réseau neuronal ne peut pas encore faire.

Expériences d'apparence

Ainsi, la base de tous les scénarios ci-dessus est un avatar numérique. J'ai déjà dit que sa création est un processus très laborieux. En fait, nous parlons d'une sculpture virtuelle d'une personne réalisée par un sculpteur 3D. Il travaille à travers tous les détails de l'apparence, puis à l'aide d'outils de simulation "pousse" les cheveux.

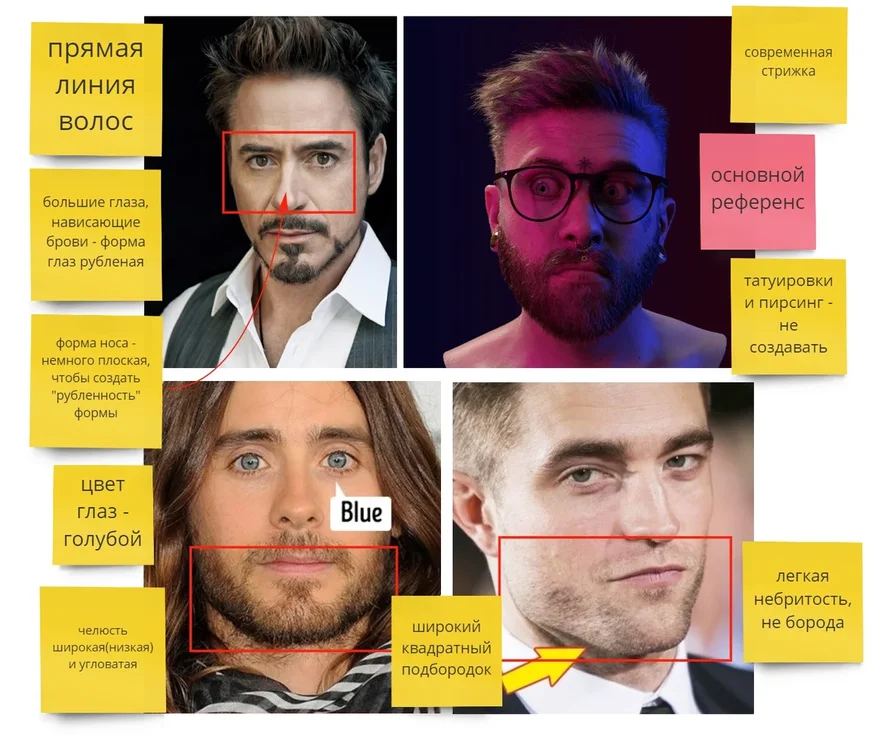

Les questions d'apparence ne se poseront pas si vous créez une copie d'une célébrité ou d'un modèle. Et si vous avez besoin de créer une personne virtuelle à partir de zéro? Quels traits lui donneras-tu?

À titre expérimental, nous avons décidé de créer notre propre avatar numérique - l'ambassadeur LANIT. Bien sûr, vous pouvez demander à tous vos collègues à quoi il devrait ressembler. Mais, d'une part, une enquête auprès de plusieurs milliers de personnes est déjà trop, et d'autre part, sur la base de ces données, il faudrait créer un second Ken pour Barbie - une image généralisée agréable, complètement dénuée d'individualité. Non, nous n'avons pas du tout besoin d'un tel ambassadeur. Nous avons emprunté un chemin différent.

Chacun de nous a formé un ensemble de stéréotypes au fil des ans. Par exemple, une barbe grise épaisse est associée à une bonne disposition (comme le Père Noël), des sourcils larges et droits - à la franchise et au caractère dominateur, etc.

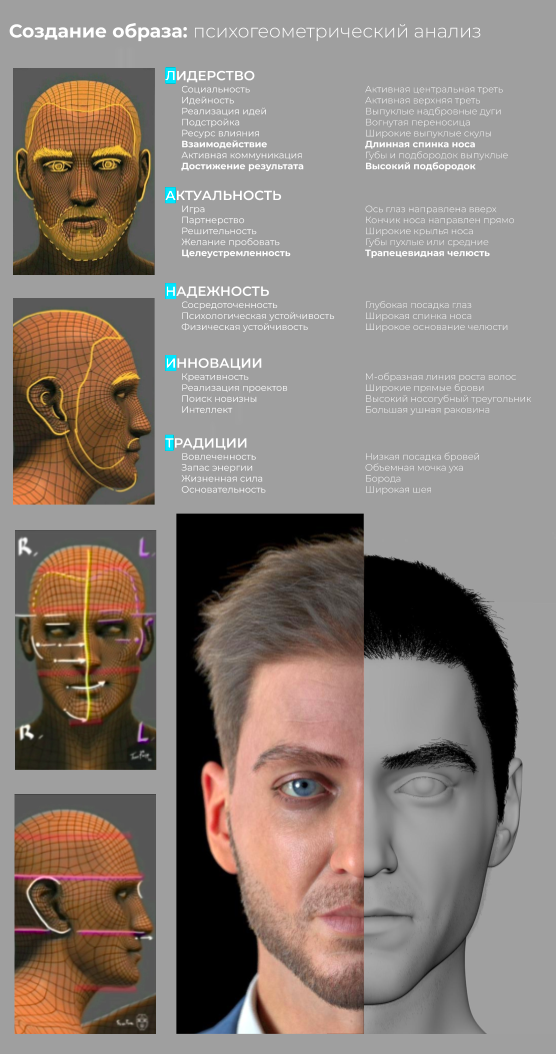

Nous avons formé une expertise en psychogéométrie du visage et formé le réseau de neurones à identifier, à partir de schémas de perception, la relation entre l'apparence d'une personne et l'impression qu'elle fait. Maintenant, elle analyse les caractéristiques de son apparence et donne un ensemble de mots décrivant comment une personne peut sembler aux autres, par exemple, gentille, vulnérable, insécurisée, calme, etc. Nous avons pris ces développements et avons commencé le processus dans l'ordre inverse - nous avons donné au réseau de neurones une description de notre futur héros (comment le public cible devrait le percevoir) et obtenu un certain ensemble de traits du visage.

Je ferai tout de suite une réserve importante: nous ne prétendons en aucun cas être scientifiquement fiables dans notre expérience. De plus, de nombreuses recherches confirment qu'il est dangereux de rechercher des relations entre les traits du visage et, par exemple, le caractère ou (à Dieu ne plaise) l'intelligence. Nous n'explorons donc pas le domaine scientifique, mais les possibilités de la technologie.

Ainsi, nous avons «nourri» les réseaux de neurones avec des qualités humaines qui correspondent aux caractéristiques de l'esprit d'entreprise: leadership, innovation, fiabilité, dévouement, etc.

Et même une sélection aussi sélective des qualités nécessaires a conduit au fait que nous avons un personnage complètement neutre qui ne provoque aucune émotion. Par conséquent, les résultats que le réseau neuronal nous a donnés ont dû être corrigés manuellement.

Le visage et, en général, toute l'infographie se compose de trois éléments:

- 3D-, ;

- , , ;

- ( , ).

1.

Tête

Pour créer Maxim (comme nous avons nommé notre avatar), nous avons pris la forme simplifiée d'une tête humaine comme base et formé les détails (sculpter) dans Zbrush. Tout d'abord, un modèle high-poly a été créé, dans lequel les moindres détails ont été élaborés, y compris les pores de la peau (des textures ont été développées pour cela).

Nous utilisons des textures 4K. Les textures 8K donnent un meilleur résultat sur les gros plans, mais leur besoin est rare, nous avons donc refusé d'utiliser des textures 8K pour des raisons de performance. Une fois que le modèle high-poly est prêt, nous en créons une copie low-poly et y transférons de petits détails en utilisant des textures normales (textures "d'extrusion" de surface).

Cheveux

Il existe de nombreux outils pour créer des cheveux. Nous avons choisi GroomBear pour Houdini pour garder la pile logicielle à plat - la plupart du travail technique est effectué dans Houdini.

vêtements.

Designer Marvelous a été utilisé pour les vêtements de modèle, et les plis et les petits détails et caractéristiques ont été complétées dans Blender.

2. Texturation

Nous effectuons la texturation dans Substance Painter - à notre avis, ses outils fournissent le processus de texturation le plus simple et le plus rapide. Un point important est le conseil : pour corriger l'image de l'avatar, il suffit de changer uniquement la texture de la peau, sans toucher du tout à la base géométrique. Cependant, ce n'est pas un secret pour les amateurs de maquillage. Avec l'aide de cosmétiques, les femmes chinoises obtiennent quotidiennement un effet comparable à la chirurgie plastique. Et pour les avatars, un changement d'apparence aussi simple signifie de grandes économies dans la production de contenu vidéo - trois clics, et l'image de votre personnage a radicalement changé - à tel point qu'il s'agit déjà d'une personne complètement différente.

3. Animation

Notre personnage est réglé pour fonctionner avec des systèmes de capture de mouvement: la combinaison de maquette Xsense et le système de maquette de visage Dynamixyz. Nous n'avons pas utilisé de systèmes de capture de mouvement optique, car ils sont très volumineux, non mobiles, ce qui signifie que le processus de production de contenu aurait beaucoup plus de restrictions.

Xsense contrôle les mouvements du tronc, de la tête et des membres. Le système d'animation est hybride: de grands tableaux de géométrie sont contrôlés par des os, qui, à leur tour, sont contrôlés par les données du système de maquette, et les plis de vêtements dans la zone des articulations et d'autres endroits caractéristiques sont contrôlés par des formes de mélange auxiliaires (états du modèle avec des plis caractéristiques dans la zone des articulations), qui garantissent un fonctionnement correct géométrie où l'animation osseuse ne permet pas d'obtenir le résultat correct.

Le besoin de créer des formes mixtes est le principal problème de la création de la garde-robe d'un personnage - c'est laborieux. Pour chaque nouveau vêtement, l'artiste doit créer plusieurs dizaines de formes de mélange. Nous recherchons activement des moyens d'automatiser cette routine, et si vous avez des idées ou des solutions toutes faites, je me ferai un plaisir d'en discuter avec vous dans les commentaires.

Dynamixyz gère l'animation faciale et la configuration de l'animation faciale est la partie la plus difficile et la plus longue du pipeline. Le fait est que 57 muscles sont cachés sous la peau du visage (25% du nombre total de muscles du corps humain), et le mouvement de chacun d'eux affecte l'expression du visage.

La reconnaissance des visages et des émotions est une capacité extrêmement importante nécessaire à l'existence dans la société, de sorte que les gens capturent instantanément des expressions faciales invraisemblables. Donc, pour l'avatar, vous devez faire une animation faciale 100% réaliste.

Chaque visage peut avoir une variété infinie d'expressions, mais comme l'a montré la pratique, 150 formes de fusion suffisent pour créer une animation réaliste. Nous sommes allés un peu plus loin et avons créé 300 formes de mélange (et continuons à en créer de nouvelles si nous trouvons des situations où 300 ne suffit pas).

Dynamixyz fonctionne sur le principe suivant: un casque est placé sur la tête de l'acteur, sur lequel sont fixées des caméras spécialisées avec des taux de transfert de données ultra-élevés. La vidéo de ces caméras est diffusée au poste de travail, où le réseau neuronal détermine les points d'ancrage sur le visage de l'acteur et dans chaque image les fait correspondre avec les points d'ancrage sur le masque facial virtuel, le forçant à se déplacer. Un système de formes mixtes est lié aux mouvements du masque facial, qui «basculent» en fonction de la nature du mouvement du masque facial. Chaque forme de fusion est créée pour l'ensemble du visage, mais elle peut être commutée localement pendant l'animation, par exemple, dans la zone de la bouche ou de l'œil droit, séparément du reste du visage. Ces interrupteurs sont lisses et complètement invisibles à l'œil.

Il existe des systèmes d'animation faciale alternatifs, moins exigeants en main-d'œuvre, comme celui récemment breveté par la Sberbank. Mais la réduction des coûts de main-d'œuvre se fait au prix de la qualité et de la flexibilité, c'est pourquoi nous avons abandonné l'utilisation de ces technologies.

4. Rendu

Notre Maxim vit dans Unreal Engine et Houdini.

Dans Unreal Engine (UE), nous rendons des animations qui ne nécessitent pas de post-traitement complexe, car l'UE ne nous permet pas d'obtenir les canaux et les masques complets nécessaires pour le post-traitement en sortie, et présente également un certain nombre de limitations (par exemple, il n'y a aucun moyen de créer le masque capillaire correct, par conséquent que l'UE ne sait pas rendre les masques translucides). Nous avons expérimenté le traçage de rayons en temps réel (RTX) pendant un certain temps, mais, n'ayant pas reçu une augmentation significative de la qualité d'image, nous avons abandonné son utilisation.

Nous utilisons Arnold pour le rendu dans Houdini. Il s'agit d'un rendu CPU, et cela fonctionne assez lentement par rapport aux moteurs GPU et RealTime, mais le choix s'est porté sur lui, car des tests comparatifs ont montré que les matériaux de dispersion sous-surface (et le matériau de la peau n'est que cela) et le matériau des cheveux d'Arnold fonctionnent sur l'ordre est meilleur que dans Redshift et Octane, et V-ray, malheureusement, produit au hasard des artefacts sur des matériaux de diffusion sous-surface.

5. Interactif

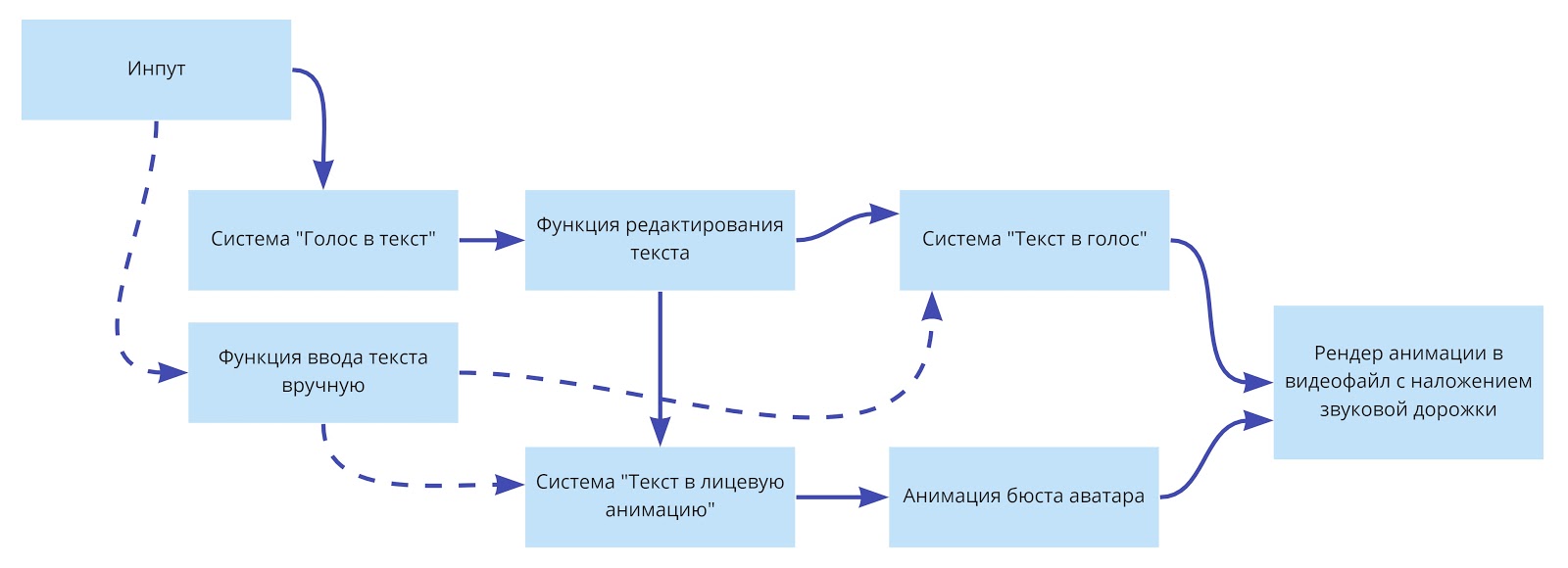

Le plus prometteur (mais aussi le plus difficile), de notre point de vue, le sens de développement des avatars numériques est leur combinaison avec des produits logiciels - assistants vocaux, robots de discussion, systèmes speech2text, etc. Ces intégrations ouvrent la porte à la création de produits évolutifs. Nous travaillons actuellement activement dans ce sens, en construisant des hypothèses et des prototypes. Si vous avez des idées pour utiliser des avatars numériques de cette manière, je serais ravi d'en discuter.

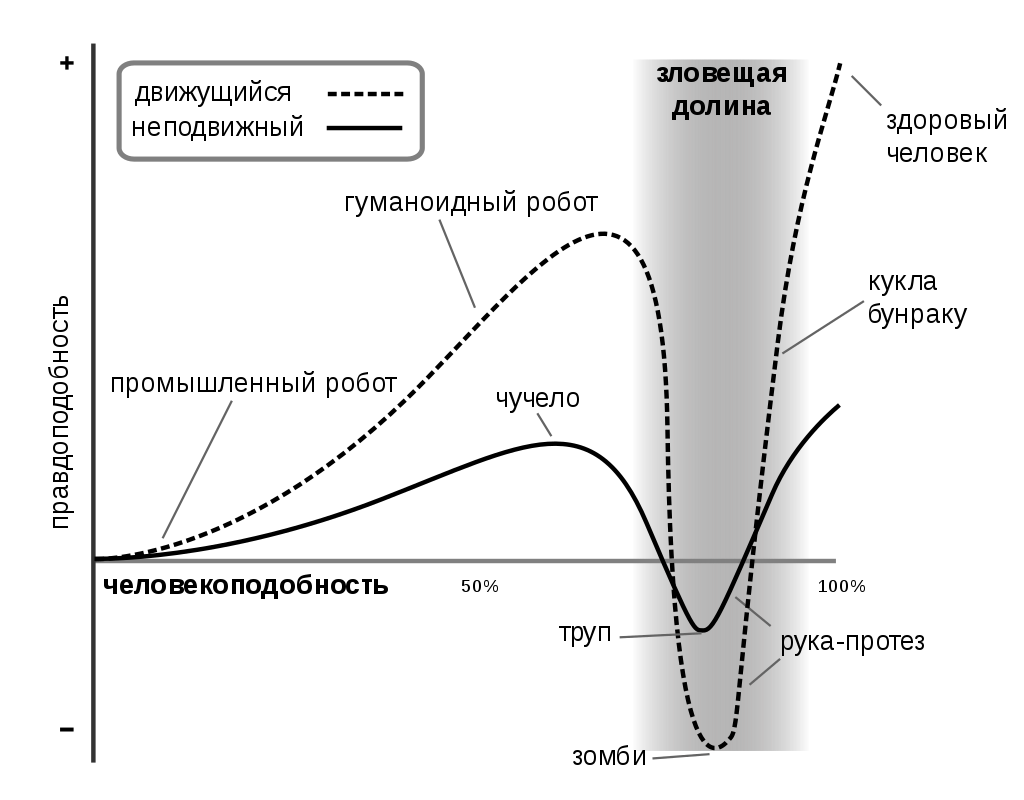

Mignon ou dégoûtant? Le mouvement renforcera cet effet.

Peut-être que Maxim vous rappellera quelqu'un que vous connaissez. Ou peut-être avez-vous négocié avec une personne similaire hier. Était-il mignon ou ennuyeux avec sa façon de communiquer? Dans tous les cas, l'image de Maxim évoque des émotions.

En cours de création, nous avons testé sur notre propre expérience l'effet de la «vallée du mal» décrite par le Japonais Masahiro Mori, qui a étudié la perception des robots humanoïdes par les humains. Ceci est détaillé dans le Wiki, mais en bref: plus un robot ressemble à un humain, plus nous ressentons de la sympathie pour lui. Cet effet augmente jusqu'à un certain point. Quand un robot est presque impossible à distinguer d'une personne, nous, en le regardant, commençons à ressentir de l'inconfort et même de la peur - tout cela parce que le robot reçoit les plus petits détails que nous ne pouvons même pas identifier et nommer le plus souvent. Ce changement brusque de nos réactions (qui correspond à l'échec du graphe) s'appelle la "Evil Valley". Dans le même temps, l'animation améliore à la fois les effets négatifs et positifs, cependant, comme le montre le graphique, une ressemblance totale avec une personne ne peut être obtenue qu'à l'aide de l'animation.

Ainsi, notre Maxim a traversé la «vallée menaçante», mais une nuance affecte négativement sa perception - sans animation, il n'a aucune expression faciale, tous les muscles du visage sont détendus, ce qui n'arrive pas chez une personne vivante. Par conséquent, il a l'air très détaché, ne regarde pas l'interlocuteur, mais comme si à travers lui, ce qui est très désagréable.

Maxim nous semble un digne représentant de la famille des avatars. Alors que Digital Human devient de plus en plus populaire, nous espérons que nos clients et partenaires décideront bientôt d'acquérir un avatar à des fins de marketing. Ensuite, Maxim aura des frères et sœurs dans la raison - artificielle, bien sûr.

En attendant, Maxim explore seul les opportunités que le marché B2B ouvre aux avatars numériques: en octobre 2020, il participera à la conférence«Smart Solutions - Smart Country: Technologies innovantes pour une nouvelle réalité» et l'exposition d'art numérique Disartive feront la promotion des produits et services de LANIT sur les réseaux sociaux et donneront éventuellement plusieurs interviews.

Le marché émergent de l'humain numérique

Il y a des entreprises en Russie qui travaillent dans une direction similaire à la nôtre. Mais tous ne sont pas publics - beaucoup interagissent avec les studios gamedev et créent des personnages pour les jeux (et ce monde vit selon ses propres règles, et très souvent les studios utilisent le modèle hollywoodien sans révéler leurs sous-traitants).

La société la plus connue est peut-être Malivar , dans laquelle la Sberbank a investi 10 millions de roubles. Elle possède le personnage virtuel Aliona Pole - artiste, mannequin et auteur de collections de «vêtements numériques».

En une fraction de seconde, une maquette numérique change un chemisier rouge pour un chemisier bleu, essaie de nouveaux looks sans arrêter le mouvement. Et le spectateur, élevé sur Instagram Stories et TikTok, est heureux de regarder de courtes vidéos avec un nombre fantastique de transformations qui ne sont pas disponibles pour un modèle vivant.

Aliona s'éloigne progressivement de l'image d'un mannequin, acquérant tous les nouveaux traits humains sur son Instagram - elle promeut une attitude respectueuse de l'environnement envers le monde, philosophe sur le sujet des frontières de la personnalité, mêlant réalité ordinaire et virtuelle et «se noie» pour l'individualité et la positivité corporelle.

Il existe un projet d'avatar numérique intéressant sur le marché mondial: Samsung - Neon... Bien sûr, les développeurs sont encore loin de créer une nouvelle forme de vie, mais ils ont appris à bien bouger leurs modèles 3D. Grâce à une interface qui peut transformer la voix en texte, le modèle analyse les informations entrantes, les transforme en solutions et donne des commandes internes pour déplacer les mains et d'autres parties du corps. Au CES 2019, la société a présenté les avatars d'une infirmière, d'un présentateur de télévision, d'un dépisteur de parc national, d'un entraîneur physique et de plusieurs autres. J'ai écrit

sur le projet néo-zélandais de création d'assistants Soulmachines ci - dessus. Il existe probablement d'autres projets dignes d'attention, mais ils ont peu de fils d'actualité significatifs, bien que des fonds sérieux investissent maintenant dans le développement d'avatars numériques.

Que pensez-vous des avatars? J'adorerais avoir mon clone numérique pour assister aux réunions Zoom et communiquer avec le patron et, bien sûr, un ensemble de vêtements numériques - toujours une chemise repassée, une veste, une cravate - tout.