Source de la photo

Musaraigne naine à dents blanches , le plus petit mammifère en masse. Il y a un petit cerveau holistique et complexe à l'intérieur, qui en principe peut être cartographié.La

réponse courte est possible, mais pas complète et pas très précise. Autrement dit, nous ne pouvons pas encore copier sa conscience, mais nous en sommes plus proches que jamais. Vivez encore vingt ans - et, peut-être, votre cerveau sera-t-il également capable de sauvegarder.

Pour vous rapprocher de la numérisation de la conscience et d'un type d'immortalité aussi exotique, vous devez d'abord vous occuper de réseaux de neurones vivants. Leur rétro-ingénierie nous montre comment le processus de réflexion (informatique) peut généralement être organisé dans des systèmes bien optimisés.

Il y a 60 ans, le 13 septembre 1960, des scientifiques réunissaient le premier symposium de biologistes et d'ingénieurs afin de comprendre quelle est la différence entre une machine complexe et un organisme. Et est-ce même là. La science s'appelait bionique et le but était l'application de méthodes de systèmes biologiques à l'ingénierie appliquée et aux nouvelles technologies. Les biosystèmes étaient considérés comme des prototypes très efficaces de nouvelles technologies.

Le neuroanatomiste militaire Jack Steele est devenu l'une des personnes qui ont considérablement influencé les progrès technologiques ultérieurs, y compris dans le domaine de l'IA, où des domaines tels que l'ingénierie neuromorphique et l'informatique bio-inspirée ont été développés. Steele était un médecin, versé en psychiatrie, aimait l'architecture, savait piloter un avion et réparait son propre équipement, c'est-à-dire qu'il était un assez bon ingénieur appliqué. Le travail scientifique de Steele est devenu le prototype du scénario du film Cyborg. Donc, avec un peu d'étirement, vous pouvez l'appeler l'arrière-grand-père du Terminator. Et là où se trouve le Terminator, il y a Skynet, comme vous le savez.

Cet article est basé sur des matériaux du futur livre de notre collègue Sergei Markov "Chasse au mouton électrique: un grand livre de l'intelligence artificielle."

En général, la question de la relation entre les processus physiologiques se produisant dans le système nerveux humain et les phénomènes mentaux est l'une des questions les plus intrigantes de la science moderne. Imaginez qu'un processeur informatique secret soit tombé entre vos mains et que vous vouliez le copier. Vous pouvez le découper en fines couches et le copier soigneusement couche par couche. Mais à quel point avez-vous besoin d'une copie exacte pour être pleinement ou au moins partiellement fonctionnelle? Il est extrêmement difficile de répondre à une telle question sans expériences.

La bionique, ou biomimétique, a copié les principes des biosystèmes ou les a pris comme base. De même que Léonard de Vinci observait le vol des oiseaux et inventait un ornithoptère (malheureusement, aucun matériau ni aucune source d'énergie appropriés n'ont été trouvés à l'époque), nous avons donc copié au XXe siècle des systèmes de plus en plus complexes. Puces RFID, adhésifs médicaux (adhésifs), structures hydrophobes, nanocapteurs - tout cela et bien plus encore a été créé à l'aide de bioprototypes. Quelque part, l'existence même d'un prototype dans la nature a permis de comprendre que la technologie est, en principe, possible. Si les plantes sont capables de synthétiser des sucres et de l'amidon à partir du dioxyde de carbone et de l'eau, alors un appareil peut être créé qui remplit la même fonction.

Et si l'évolution optimise les systèmes vers l'adaptabilité à l'environnement, alors nous pourrions les optimiser pour nos tâches. Du point de vue de l'évolution, le cerveau humain doit consommer peu d'énergie, doit être résistant aux influences physiques (il est peu probable que vous l'aimiez si vous perdez complètement la mémoire de la chute de la pomme sur votre tête), la tête du bébé doit franchir librement le canal génital à la naissance, et ainsi de suite.

Dans le cas du développement d'un appareil utilisant les mêmes principes, nous n'avons pas ces restrictions. Comme des centaines d'autres.

À propos, nos ancêtres adhéraient souvent à la théorie «terminale» de la pensée, suggérant que les processus se déroulent quelque part à distance (dans l'âme) et sont transmis sous forme de commandes par un organe. Aristote et ses collègues croyaient que le terminal de l'âme est dans le cœur. Mais les expériences des anciens médecins étaient limitées par le niveau technique de la civilisation. Cela a continué à peu près jusqu'à ce que Luigi Galvani découvre en 1791 que le courant provoque la contraction des muscles. Ces expériences ont donné lieu à des recherches dans le domaine des phénomènes bioélectriques. À un moment donné, Cato a décidé de mesurer le potentiel de tout autour et a commencé à ouvrir les animaux pour ses mesures. Il a constaté que la surface externe de la matière grise était chargée plus positivement que les structures profondes du cerveau. Il a également noté que les courants électriques dans le cerveau semblent être liés aux fonctions de base."Quand j'ai montré les raisins secs au singe, mais que je ne les ai pas donnés, il y a eu une légère diminution de l'ampérage . " Grâce à lui, l'électroencéphalographie non invasive (c'est-à-dire non associée à la pénétration à travers les barrières externes du corps) est née. En 1890, le physiologiste Adolf Beck de Pologne a découvert des fluctuations à basse tension et haute fréquence des potentiels électriques qui se produisent entre deux électrodes placées dans le cortex occipital du cerveau d'un lapin.

À ce moment-là, il est devenu clair pour de nombreux scientifiques que le cerveau est une chose fondamentalement reconnaissable. Peut-être que ce n'est même pas un «terminal» pour une âme divine, mais une machine électrique tout à fait compréhensible, mais seulement très complexe. Ou il contient un tel composant d'ingénierie et peut être étudié. Cato a créé les conditions préalables à l'apparition ultérieure de l'EEG. L'électroencéphalographie moderne a été créée par Berger, bien qu'il ait eu des prédécesseurs tels que Pravdich-Neminsky et d'autres.

Deux ans avant les expériences de Caton, en 1873, la méthode Golgi (du nom de son auteur, le physiologiste italien Camillo Golgi) a été découverte, qui permet de colorer les neurones individuels (bien que le mot «neurone» n'ait été utilisé qu'en 1891).

Avant la découverte du Golgi en biologie, un concept était populaire, proposé par l'histologue allemand Joseph von Gerlach, qui croyait que les fibres émergeant de divers corps cellulaires étaient connectées en un seul réseau appelé «réticulum». La popularité des idées de Gerlach était due au fait que, contrairement au cœur ou au foie, le cerveau et le système nerveux ne pouvaient pas être divisés en unités structurelles distinctes: bien que les cellules nerveuses aient été décrites dans les tissus par de nombreux chercheurs de l'époque, la connexion entre les cellules nerveuses et les axones les reliant et les dendrites n'était pas clair. La raison principale en était le manque de microscopie. Grâce à sa découverte, Golgi a vu que les processus ramifiés d'un corps cellulaire ne se confondent pas avec les autres. Il n'a cependant pas rejeté le concept de Gerlach, suggérant que les longs et minces appendices étaient probablementconnecté en un seul réseau continu.

C'était comme ce que les mécaniciens et les électriciens savaient déjà. L'approche mécaniste a triomphé. Certes, on ne savait toujours pas comment cela fonctionne. Ou du moins comment cela pourrait fonctionner.

Quatorze ans plus tard, en 1887, le neuroanatomiste espagnol Santiago Ramon y Cajal a prouvé que les processus longs et minces qui émergent des corps cellulaires ne sont pas du tout connectés en un seul réseau. Le système nerveux, comme tous les autres tissus vivants, se composait d'éléments séparés. En 1906, Ramon y Cajal et Camillo Golgi ont reçu le prix Nobel de physiologie et médecine pour leurs travaux sur la structure du système nerveux . Les croquis de Ramon-i-Cajal, dont environ 3000 ont survécu à ce jour , restent aujourd'hui l'une des descriptions les plus détaillées de la diversité structurelle du cerveau et du système nerveux.

Croquis de Santiago Ramon y Cajal

Des recherches plus poussées ont montré de plus en plus de détails que nous pouvons fondamentalement comprendre comment nous pensons - au niveau de l'ingénierie. Cela signifie que nous pouvons faire de la biomimétique appliquée.

Bien que l'on savait depuis l'époque de Galvani que les nerfs pouvaient être excités électriquement, les stimuli utilisés pour exciter les nerfs étaient assez difficiles à contrôler. Quelle devrait être la force et la durée du signal? Et comment le lien entre stimulus et excitabilité peut-il être expliqué par la biophysique sous-jacente? Ces questions ont été posées au tournant des XIXe et XXe siècles par les pionniers de l'étude de l'excitabilité nerveuse Jan Horweg (Jan Leendert Hoorweg, 1841-1919, parfois mal interprété par «Hoorweg»), Georges Weiss (Jules Adolphe Georges Weiss, 1851-1931) etLouis Lapicque (1866-1952) . Dans sa première étude en 1907, Lapik présente un modèle du nerf, qu'il compare avec des données obtenues en stimulant le nerf d'une grenouille. Ce modèle, basé sur un simple circuit de condensateur, servira de base aux futurs modèles de la membrane cellulaire du neurone.

Juste pour que vous compreniez les complexités de la science au cours de ces années, il convient de donner quelques exemples. Le stimulus utilisé par Lapik était une courte impulsion électrique qui était délivrée par deux électrodes conçues et fabriquées spécifiquement à cet effet. Idéalement, les expériences de stimulation pourraient utiliser des impulsions de courant, mais des sources de courant appropriées n'étaient pas faciles à créer. Au lieu de cela, Lapik a utilisé une source de tension - une batterie. La régulation de tension a été effectuée à l'aide d'un diviseur de tension, qui était un long fil avec un curseur, semblable à un potentiomètre moderne. Il était également difficile d'obtenir des impulsions précises d'une durée de seulement quelques millisecondes, un outil inventé un peu plus tôt pour cela s'appelait un "rhéotome". L'appareil se composait d'un pistolet avec une serrure à capsule,dont la balle a d'abord cassé le premier cavalier, créant un courant dans le circuit de stimulation, puis a cassé le second cavalier sur son chemin, rompant le contact.

Les travaux de 1907 ont conduit Lapik à un certain nombre de considérations théoriques. Il a postulé que l'activation d'une chaîne de cellules nerveuses dépend de la stimulation électrique séquentielle de chaque cellule par une impulsion ou un potentiel d'action de la précédente. Lapik a proposé une théorie des processus neuronaux qui ressemblait à l'accord ou à la résonance entre les circuits radio oscillatoires.

En 1943, le livre La machine nerveuse de Lapik a été publié , résumant les nombreuses années de recherche du scientifique.

Editeur Paris: Maison parisienne Neurdein (ND. Phot.), Sd

Souvent, lorsqu'on discute des travaux de Lapik pour les neurosciences computationnelles, on peut rencontreravec la déclaration que Lapik est le créateur et le chercheur du premier modèle de neurone appelé "intégrer-et-feu". Conformément à ce modèle, l'algorithme d'un neurone peut être décrit comme suit: lorsqu'un courant est appliqué à l'entrée d'un neurone, la différence de potentiel (tension) aux bornes de la membrane augmente avec le temps jusqu'à ce qu'elle atteigne une certaine valeur de seuil à laquelle un changement semblable à un saut du potentiel de sortie se produit, la tension est réinitialisée au potentiel résiduel, après quoi le processus peut être répété encore et encore. En fait, le lien entre l'excitation nerveuse et la formation d'une impulsion nerveuse à l'époque de Lapik n'était toujours pas clair, et le scientifique ne fait aucune hypothèse à ce sujet ou sur la façon dont la membrane revient à son état d'origine après l'émission de l'impulsion.

Le développement ultérieur des idées de Lapik dans le cadre de la neurobiologie computationnelle a conduit à l'émergence de nombreux modèles plus précis et plus complets de neurones biologiques. Celles-ci incluent le modèle d'intégration et d'incendie à fuite, le modèle d'intégration et d'incendie à fuite d'ordre fractionnaire, le modèle de Galves-Löckerbach [ Galves - modèle de Locherbach], le modèle exponentiel d'intégration et de tir, et bien d'autres. Le prix Nobel 1963 a été décerné pour les recherches de Sir Alan Lloyd Hodgkin (1914-1998) et de Sir Andrew Fielding Huxley (1917-2012, à ne pas confondre avec un écrivain).

Une source

Le calmar côtier à longues pattes (Doryteuthis pealeii), comme d'autres calamars, est un organisme modèle extrêmement pratique pour les neurophysiologistes en raison de la présence d'axones géants. L'axone du calmar géant est un très grand axone (généralement d'environ 0,5 mm de diamètre, mais parfois jusqu'à 1,5 mm) qui contrôle une partie du système réactif à l'eau du calmar, qu'il utilise principalement pour des mouvements courts mais très rapides dans l'eau. Un siphon est situé entre les tentacules de calmar, à travers lequel l'eau peut être rapidement expulsée en raison des contractions des muscles de la paroi corporelle de l'animal. Cette contraction est initiée par les potentiels d'action dans l'axone géant. Étant donné que la résistance électrique est inversement proportionnelle à la section transversale d'un objet, les potentiels d'action se propagent plus rapidement dans un axone plus grand que dans un plus petit.Par conséquent, une augmentation du diamètre de l'axone géant a été maintenue dans le processus d'évolution, car elle a permis une augmentation de la vitesse de réaction musculaire. C'était un vrai cadeau pour Hodgkin et Huxley, qui s'intéressaient au mécanisme ionique des potentiels d'action - après tout, grâce au grand diamètre de l'axone, il était possible d'installer des électrodes de serrage dans sa lumière!

Source

Le modèle Hodgkin-Huxley est un système d'équations différentielles non linéaires qui décrit approximativement les caractéristiques électriques des cellules excitées. Le résultat a été un modèle qui a servi de base à des recherches plus détaillées - c'était une percée majeure dans la neurophysiologie du XXe siècle.

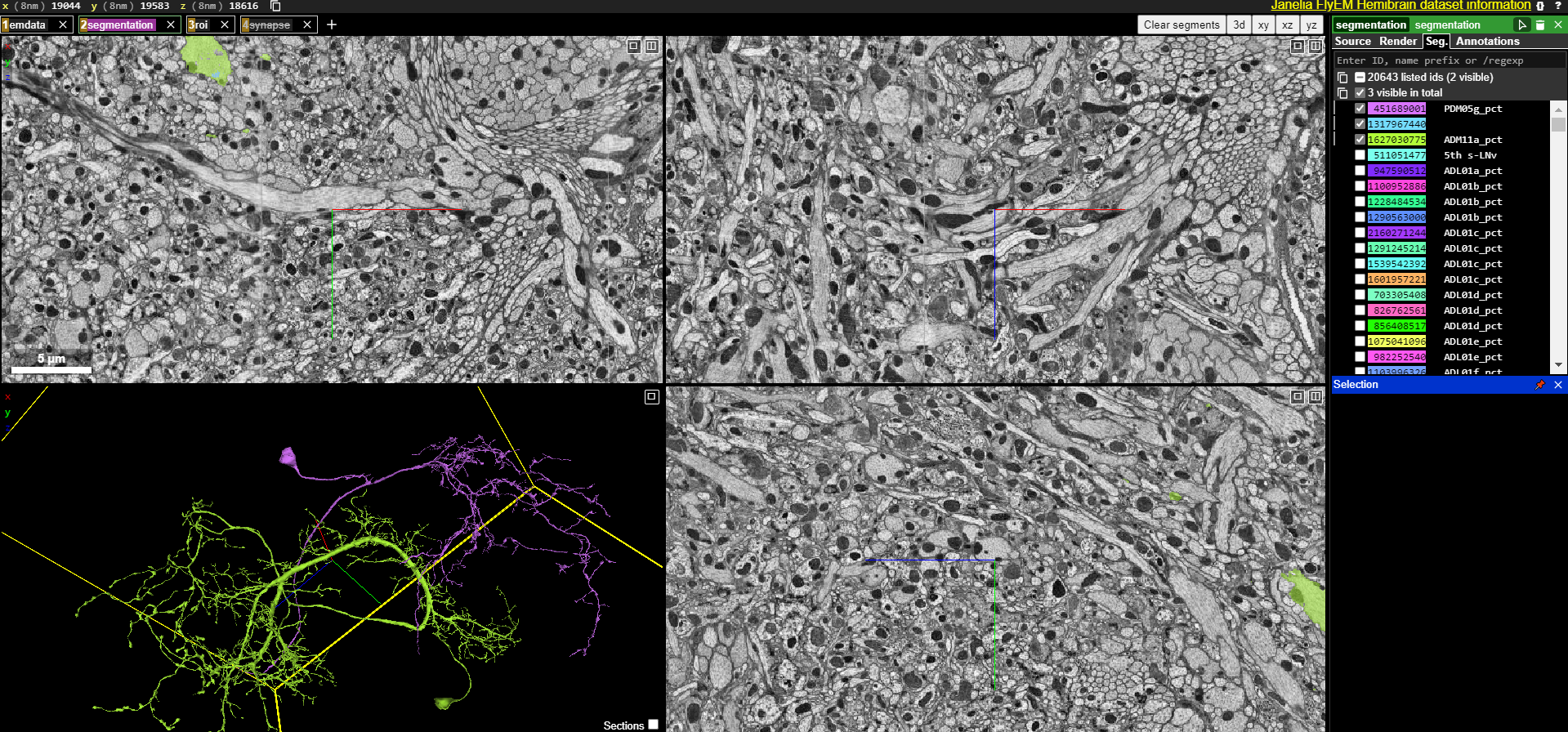

L'un des projets les plus intéressants est réalisé par des scientifiques du laboratoire de Sebastian Seung. L'objectif immédiat du projet était de créer une carte des connexions entre les neurones de la rétine d'une souris nommée Harold. La rétine a été choisie comme objet modèle pour tester les technologies nécessaires pour atteindre un objectif scientifique à long terme - une description complète du connectome cérébral humain. Le cerveau de la souris a été retiré du crâne et découpé en fines couches.

Les coupes obtenues ont été passées au microscope électronique. Lorsque le personnel du laboratoire s'est rendu compte que la reconstruction d'une carte des connexions d'un seul neurone nécessite environ cinquante heures de travail de spécialiste et que la cartographie de la rétine d'une souris dans un groupe de cent scientifiques prendrait près de deux cents ans, il est devenu clair qu'une solution fondamentalement différente était nécessaire. Et il a été trouvé. Il a créé le jeu en ligne EyeWire, dans lequel les joueurs s'affrontent pour photographier en couleur des tranches de cerveaux de souris.

En 2014, deux ans après le lancement d'EyeWire, le personnel du laboratoire a fait la première découverte et l'a rapporté dans la revue Nature. Les scientifiques ont compris exactement comment les mammifères reconnaissent le mouvement. Lorsque la lumière atteint les cellules photoréceptrices, elles transmettent un signal aux cellules bipolaires, puis aux cellules amacrines et enfin aux cellules ganglionnaires. Les scientifiques ont analysé 80 neurones en étoile amacrine (dont 29 joueurs d'EyeWire ont aidé à décrire) et les cellules bipolaires qui y sont connectées. Ils ont remarqué que différents types de cellules bipolaires se lient différemment aux neurones amacrines: les cellules bipolaires d'un type sont situées loin du «soma» (corps) de la cellule étoilée et transmettent rapidement un signal, les cellules d'un autre type sont situées à proximité, mais le signal est transmis avec un retard.

Si le stimulus dans le champ de vision s'éloigne du corps (soma) de la cellule amacrine étoilée, alors la cellule bipolaire "lente" est activée en premier, puis la cellule "rapide". Puis, malgré le retard, les signaux des deux types de cellules atteignent le neurone amacrine étoilé en même temps, il émet un signal fort et le transmet aux cellules ganglionnaires. Si le stimulus se déplace vers le soma, les signaux de différents types de neurones bipolaires ne se "rencontrent" pas et le signal de la cellule amacrine est faible .

Les données étiquetées par les joueurs ont été utilisées pour former les modèles d'apprentissage automatique correspondants sur eux, qui peuvent ensuite effectuer la coloration eux-mêmes.... Une sorte d'ironie réside dans le fait que ces modèles sont basés sur des réseaux de neurones convolutifs (nous en parlerons en détail un peu plus tard), créés, quant à eux, sous l'influence de données scientifiques obtenues lors de l'étude du cortex visuel du cerveau.

Le 2 avril 2013, l'Initiative BRAIN a débuté. La première brique de la fondation était un article de Paul Alivizatos, qui décrivait des plans expérimentaux pour un projet plus modeste, y compris des méthodes pouvant être utilisées pour construire un «connectome fonctionnel» et énumère également les technologies qui devront être développées au cours du projet. Il était prévu de passer des vers et des mouches à des biosystèmes plus grands, en particulier la musaraigne pygmée. C'est le plus petit mammifère connu en termes de poids corporel et son cerveau ne comprend qu'environ un million de neurones. Il sera possible de passer des musaraignes aux primates, y compris, au dernier stade, aux humains.

Le premier connectome d'une créature vivante, à savoir le nématode C. elegans, a été construit en 1986 par un groupe de chercheurs dirigé par le biologiste Sydney Brenner (1927-2019) de Cambridge. Brenner et ses collègues ont soigneusement coupé les vers millimétriques en fines tranches et ont photographié chaque section à l'aide d'une caméra à pellicule montée sur un microscope électronique, puis ont tracé manuellement toutes les connexions entre les neurones à partir des images . Cependant, C. elegans ne possède que 302 neurones et environ 7 600 synapses. En 2016, une équipe de scientifiques de l'Université Dalhousie au Canada a répété l'exploit de ses collègues pour la larve du tunicier Ciona intestinalis, dont le système nerveux central, il s'est avéré, était composé de 177 neurones et de 6618 connexions synaptiques.... Cependant, il convient de noter que les méthodes utilisées pour construire le connectome sont inefficaces pour les grands systèmes nerveux. Les chercheurs n'ont pas sérieusement envisagé de se lancer dans des projets beaucoup plus importants jusqu'en 2004, lorsque le physicien Winfried Denk et le neuroanatomiste Heinz Horstmann ont proposé d'utiliser un microscope automatisé pour disséquer et visualiser le cerveau, et un logiciel pour collecter et combiner les images résultantes .

En 2019, la revue Nature a publié une publication du Dr Scott Emmons avec un rapport détaillé sur la reconstruction du nématode Caenorhabditis elegans connectome à l'aide d'une nouvelle méthode... Un an plus tôt, un groupe de scientifiques dirigé par Zhihao Zheng de l'Université de Princeton a achevé ses travaux sur le balayage du cerveau de la drosophile, qui comprend environ 100 000 neurones. Le système, développé par Zheng et ses collègues, a permis de passer à travers un microscope électronique à balayage à transmission plus de 7000 sections plus minces du cerveau d'une mouche, chacune d'une épaisseur d'environ 40 nm, et la taille totale des images résultantes était de 40 billions de pixels .

En avril 2019, des employés de l'Institut du Cerveau. Allen à Seattle a célébré le franchissement de la dernière étape dans un projet de cartographie d'un millimètre cube du cerveau de la souris avec ses 100 000 neurones et un milliard de connexions entre eux. Pour traiter un échantillon de la taille d'une graine de moutarde, les microscopes ont fonctionné en continu pendant cinq mois, collectant plus de 100 millions d'images à partir de 25 000 sections du cortex visuel. Ensuite, le logiciel développé par les scientifiques de l'institut a mis environ trois mois pour combiner les images en un seul tableau tridimensionnel de 2 pétaoctets. Toutes les images de notre planète, collectées pendant plus de 30 ans par les missions Landsat, n'occupent qu'environ 1,3 pétaoctet, ce qui permet à la souris de scanner pratiquement «le monde entier dans un grain de sable». L'objectif ultime - un connectome cérébral humain à l'échelle nanométrique - est encore loin.Le nombre de neurones qu'il contient est comparable au nombre d'étoiles de la Voie lactée (environ 1011). Avec la technologie d'imagerie d'aujourd'hui, il faudra des dizaines de microscopes fonctionnant 24 heures sur 24 pendant des milliers d'années pour collecter les données nécessaires pour atteindre l'objectif ultime. Mais les progrès de la microscopie, ainsi que le développement d'ordinateurs et d'algorithmes plus puissants pour l'analyse d'images, ont propulsé le domaine de la connectomique si rapidement que les chercheurs eux-mêmes sont surpris. «Il y a cinq ans, il était trop ambitieux de penser à un millimètre cube», dit Reid. Aujourd'hui, de nombreux chercheurs pensent qu'une cartographie complète du cerveau de la souris, d'un volume d'environ 500 millimètres cubes, sera possible au cours de la prochaine décennie. «Aujourd'hui, cartographier le cerveau humain au niveau synaptique peut sembler incroyable. Mais si les progrès se poursuivent au même rythme,à la fois en puissance de calcul et en méthodes scientifiques, une nouvelle multiplication par mille des capacités déjàne nous paraît pas inconcevable . "

La source de l'

initiative BRAIN n'est pas le seul programme à grande échelle dans ce domaine. Les scientifiques du Blue Brain Project et du Human Brain Project sont également engagés dans la création d'un modèle fonctionnel du cerveau de rat (avec un œil sur le cerveau humain). Le China Brain Project n'est pas non plus en reste.

En fait, maintenant que vous comprenez la complexité de ces prototypes biologiques, vous pouvez passer à une approche d'ingénierie et commencer progressivement à discuter de l'application des principes dans l'informatique moderne. Mais plus à ce sujet la prochaine fois. Ou - plus en détail cette partie et les suivantes - dans le livre de Sergei Markov "La chasse au mouton électrique: un grand livre d'intelligence artificielle", qui est en préparation pour publication par la maison d'édition "Alpina Non-Fiction". Vous ne pouvez pas encore acheter le livre, mais vous pouvez déjà lire les articles sur les matériaux. Eh bien, en généraloulenspiegel spécialiste très cool.