Les cas où un inventeur crée un appareil électrique complexe à partir de rien, tout en se basant uniquement sur ses propres recherches, sont extrêmement rares. En règle générale, ces ou ces appareils sont nés à la jonction de plusieurs technologies et normes à la fois, créées par différentes personnes à des moments différents. Prenons un lecteur flash banal comme exemple. Il s'agit d'un support de stockage portable basé sur une mémoire NAND non volatile et équipé d'un port USB intégré utilisé pour connecter le lecteur à un périphérique client. Ainsi, pour comprendre comment un tel dispositif, en principe, pourrait apparaître sur le marché, il est nécessaire de retracer l'historique de l'invention non seulement des puces mémoire elles-mêmes, mais également de l'interface correspondante, sans laquelle les lecteurs flash auxquels nous sommes habitués n'existeraient tout simplement pas. Essayons de faire ça.

Les dispositifs de mémoire à semi-conducteurs qui prennent en charge l'effacement des données enregistrées sont apparus il y a près d'un demi-siècle: la première EPROM a été créée par l'ingénieur israélien Dov Frohman en 1971.

Dov Frohman, développeur EPROM

Innovantes pour leur époque, les ROM ont été utilisées avec succès dans la production de microcontrôleurs (par exemple, Intel 8048 ou Freescale 68HC11), mais elles se sont révélées décidément inadaptées à la création de périphériques de stockage portables. Le principal problème de l'EPROM était la procédure trop compliquée d'effacement des informations: pour cela, le circuit intégré devait être irradié dans le spectre ultraviolet. Cela fonctionnait de la manière suivante: les photons du rayonnement UV donnaient à l'excès d'électrons une énergie suffisante pour dissiper la charge sur la grille flottante.

Les puces EPROM étaient équipées de fenêtres spéciales pour l'effacement des données, recouvertes de plaques de quartz,

ce qui ajoutait deux inconvénients importants. Premièrement, il était possible d'effacer les données sur une telle puce dans un laps de temps adéquat uniquement à l'aide d'une lampe à mercure suffisamment puissante, et même dans ce cas, le processus a pris plusieurs minutes. En comparaison, une lampe fluorescente conventionnelle effacerait les informations sur plusieurs années, et si elle était laissée en plein soleil, il faudrait des semaines pour la nettoyer complètement. Deuxièmement, même si ce processus pouvait être en quelque sorte optimisé, la suppression sélective d'un fichier spécifique était toujours impossible: les informations sur l'EPROM ont été entièrement effacées.

Ces problèmes ont été résolus dans la prochaine génération de puces. En 1977, Eli Harari (qui a plus tard fondé SanDisk, qui est devenu l'un des plus grands fabricants mondiaux de supports de stockage basés sur la mémoire flash), en utilisant la technologie d'émission autoélectronique, a créé le premier prototype EEPROM - ROM, dans lequel l'effacement des données, comme la programmation, a été réalisée purement électriquement.

Eli Harari, fondateur de SanDisk, tenant l'une des premières cartes SD entre ses mains

Le principe de fonctionnement de l'EEPROM était presque identique à celui de la mémoire NAND moderne: une grille flottante était utilisée comme porteur de charge, et des électrons étaient transférés à travers les couches diélectriques grâce à l'effet tunnel. L'organisation même des cellules mémoire était un tableau bidimensionnel, qui permettait déjà d'écrire et de supprimer des données de manière adressable. De plus, l'EEPROM avait une très bonne marge de sécurité: chaque cellule pouvait être réécrite jusqu'à 1 million de fois.

Mais là aussi, tout s'est avéré loin d'être aussi rose. Pour pouvoir effacer les données électriquement, un transistor supplémentaire a dû être inséré dans chaque cellule de mémoire pour contrôler le processus d'écriture et d'effacement. Il y avait maintenant 3 conducteurs par élément de réseau (1 conducteur de colonne et 2 conducteurs de rangée), ce qui compliquait la disposition des composants de la matrice et causait de graves problèmes de mise à l'échelle. Cela signifie que la création d'appareils miniatures et volumineux était hors de question.

Puisqu'il existait déjà un modèle prêt à l'emploi de ROM à semi-conducteurs, d'autres recherches scientifiques se sont poursuivies en vue de créer des microcircuits capables de fournir un stockage de données plus dense. Et ceux-ci ont été couronnés de succès en 1984, lorsque Fujio Masuoka, qui travaillait chez Toshiba Corporation, a présenté un prototype de mémoire flash non volatile à l'International Electron Devices Meeting, qui s'est tenue à l'Institut des ingénieurs électriciens et électroniciens (IEEE).

Fujio Masuoka, le «père» de la mémoire flash

À propos, le nom lui-même n'a pas été inventé par Fujio, mais par l'un de ses collègues, Shoji Ariizumi, à qui le processus d'effacement des données rappelait un éclair brillant (de l'anglais «flash» - «flash»). Contrairement à l'EEPROM, la mémoire flash était basée sur des MOSFET avec une grille flottante supplémentaire située entre la couche p et la grille de contrôle, ce qui éliminait les éléments inutiles et créait des puces vraiment miniatures.

Les premiers périphériques de mémoire flash commerciaux étaient les puces NOR (Not-Or) d'Intel, lancées en 1988. Comme dans le cas de l'EEPROM, leurs matrices étaient un réseau bidimensionnel, dans lequel chaque cellule de mémoire était située à l'intersection d'une ligne et d'une colonne (les conducteurs correspondants étaient connectés à différentes grilles du transistor et la source était connectée à un substrat commun). Cependant, déjà en 1989, Toshiba a présenté sa propre version de mémoire flash appelée NAND. Le tableau avait une structure similaire, mais dans chacun de ses nœuds, au lieu d'une cellule, il y en avait maintenant plusieurs connectés séquentiellement. De plus, deux transistors MOS ont été utilisés dans chaque ligne: un pilote situé entre la ligne de bit et une colonne de cellules, et un transistor de masse.

La densité de remplissage plus élevée a contribué à augmenter la capacité de la puce, mais en même temps, l'algorithme de lecture / écriture est devenu plus compliqué, ce qui ne pouvait qu'affecter le taux de transfert d'informations. Pour cette raison, la nouvelle architecture n'a pas été en mesure de supplanter complètement NOR, qui a trouvé une application dans la création de ROM embarquées. Dans le même temps, c'est NAND qui s'est avéré être idéal pour la production de périphériques de stockage de données portables - cartes SD et, bien sûr, clés USB.

À propos, l'apparition de ce dernier n'est devenue possible qu'en 2000, lorsque le coût de la mémoire flash a suffisamment baissé et que la sortie de tels appareils pour le marché de détail pourrait porter ses fruits. L'idée originale de la société israélienne M-Systems est devenue la première clé USB au monde: une clé USB compacte DiskOnKey (qui peut se traduire par «disque sur porte-clés», car un anneau métallique était fourni sur le corps de l'appareil qui permettait de transporter un lecteur flash avec un tas de clés) a été développé Amir Banom, Dov Moran et Oran Ogdan. Pour un appareil miniature capable de contenir 8 Mo d'informations et de remplacer les talons de disquettes de 3,5 pouces, à ce moment-là, ils ont demandé 50 $.

DiskOnKey - le premier lecteur flash au monde de la société israélienne M-Systems

Un fait intéressant: aux États-Unis, DiskOnKey avait un éditeur officiel, qui était IBM. Les clés USB «localisées» n'étaient pas différentes des clés d'origine, à l'exception du logo sur le devant, c'est pourquoi de nombreuses personnes attribuent à tort la création de la première clé USB à une société américaine.

DiskOnKey, IBM Edition

Suivant le modèle original, littéralement quelques mois plus tard, des modifications DiskOnKey plus spacieuses de 16 et 32 Mo ont vu le jour, pour lesquelles ils ont demandé respectivement 100 $ et 150 $. Malgré le coût élevé, la combinaison de taille compacte, d'espace et de vitesse de lecture / écriture élevée (qui s'est avérée être environ 10 fois supérieure à celle des disquettes standard) a été appréciée par de nombreux acheteurs. Et à partir de ce moment, les clés USB ont commencé leur marche triomphale à travers la planète.

Un sur le terrain: Battle for USB

Cependant, une clé USB n'aurait pas été une clé USB si la spécification Universal Serial Bus n'était pas apparue cinq ans plus tôt - c'est ainsi que l'abréviation USB à laquelle nous sommes habitués. Et l'histoire de l'origine de cette norme peut être qualifiée de presque plus intéressante que l'invention de la mémoire flash elle-même.

En règle générale, les nouvelles interfaces et normes informatiques sont le fruit d'une coopération étroite de grandes entreprises, souvent même en concurrence les unes avec les autres, mais obligées d'unir leurs forces pour créer une solution unifiée qui simplifierait considérablement le développement de nouveaux produits. Cela s'est produit, par exemple, avec les cartes mémoire SD: la première version de la Secure Digital Memory Card a été créée en 1999 avec la participation de SanDisk, Toshiba et Panasonic, et la nouvelle norme a connu un tel succès qu'elle a remporté le titre de l'industrie après seulement un an. Aujourd'hui, la SD Card Association compte plus de 1000 sociétés membres, dont les ingénieurs sont engagés dans le développement de nouvelles spécifications et le développement de spécifications existantes décrivant divers paramètres des cartes flash.

Et à première vue, l'histoire de l'USB est complètement identique à ce qui s'est passé avec la norme Secure Digital. Pour rendre les ordinateurs personnels plus conviviaux, les fabricants de matériel avaient besoin, entre autres, d'une interface universelle pour travailler avec des périphériques prenant en charge le branchement à chaud et ne nécessitant pas de configuration supplémentaire. De plus, la création d'un standard unifié permettrait de se débarrasser du «zoo» des ports (COM, LPT, PS / 2, port MIDI, RS-232, etc.), ce qui à l'avenir contribuerait à simplifier et réduire considérablement le coût de développement de nouveaux équipements. ainsi que l'introduction d'un support pour certains appareils.

Dans le contexte de ces prérequis, un certain nombre de sociétés développant des composants informatiques, des périphériques et des logiciels, dont les plus importants étaient Intel, Microsoft, Philips et US Robotics, se sont associées pour tenter de trouver le même dénominateur commun qui conviendrait à tous les acteurs actuels, qui est finalement devenu USB. ... La vulgarisation de la nouvelle norme a été largement facilitée par Microsoft, qui a ajouté la prise en charge de l'interface dans Windows 95 (le correctif correspondant faisait partie de Service Release 2), puis a introduit le pilote nécessaire dans la version commerciale de Windows 98. Dans le même temps, l'aide est venue de nulle part sur le front du fer. En attendant: en 1998, l'iMac G3 a vu le jour - le premier ordinateur tout-en-un d'Apple, dans lequel seuls des ports USB étaient utilisés pour connecter des périphériques d'entrée et d'autres périphériques (à l'exception d'un microphone et d'un casque).À bien des égards, ce virage à 180 degrés (après tout, à l'époque, Apple comptait sur FireWire) était dû au retour de Steve Jobs au poste de PDG de l'entreprise, qui avait eu lieu un an plus tôt.

L'iMac G3 original - le premier "ordinateur USB"

En fait, la naissance du bus série universel a été beaucoup plus douloureuse, et l'émergence de l'USB en soi est en grande partie le mérite de ne pas méga-sociétés et même pas d'un seul département de recherche agissant dans le cadre d'un ou une autre société, mais une personne très spécifique - un ingénieur Intel d'origine indienne nommé Ajay Bhatt.

Ajay Bhatt, le principal idéologue et créateur de l'interface USB

En 1992, Ajay pensait que «l'ordinateur personnel» n'était pas vraiment à la hauteur de son nom. Même une tâche aussi simple à première vue que la connexion d'une imprimante et l'impression d'un document nécessitait une certaine qualification de la part de l'utilisateur (même si cela semblerait, pourquoi un employé de bureau qui doit créer un rapport ou une déclaration pour comprendre les technologies sophistiquées?) Ou forcé de se tourner vers des spécialistes spécialisés ... Et si tout est laissé tel quel, le PC ne deviendra jamais un produit de masse, ce qui signifie qu'il ne vaut pas la peine de rêver d'aller au-delà du chiffre de 10 millions d'utilisateurs dans le monde.

Intel et Microsoft comprenaient à l'époque la nécessité d'une certaine normalisation. En particulier, les recherches dans ce domaine ont conduit à l'émergence du bus PCI et du concept de Plug & Play, ce qui signifie que l'initiative de Bhatt, qui a décidé de concentrer ses efforts sur la recherche d'une solution universelle pour connecter les périphériques, aurait dû être accueillie positivement. Mais ce n'était pas le cas: le supérieur immédiat d'Ajay, après avoir écouté l'ingénieur, a déclaré que cette tâche était si difficile qu'elle ne valait pas la peine de perdre du temps.

Puis Ajay a commencé à chercher du soutien dans des groupes parallèles et l'a trouvé en la personne de l'un des éminents chercheurs d'Intel (Intel Fellow) Fred Pollack, qui à l'époque était connu pour son travail en tant qu'ingénieur principal pour Intel iAPX 432 et architecte principal pour Intel i960, qui a donné le feu vert au projet. ... Cependant, ce n'était que le début: la mise en œuvre d'une idée d'une telle ampleur serait devenue impossible sans la participation d'autres acteurs du marché. A partir de ce moment, la véritable «agonie» a commencé, car Ajay devait non seulement convaincre les membres des groupes de travail Intel des perspectives de cette idée, mais aussi s'assurer le soutien d'autres fabricants de matériel.

De nombreuses discussions, accords et séances de brainstorming ont duré près d'un an et demi. Pendant ce temps, Ajay a été rejoint par Bala Kadambi, qui dirigeait l'équipe de développement PCI et Plug & Play, puis est devenu le directeur des normes technologiques d'E / S d'Intel, et Jim Pappas, un expert des E / S. À l'été 1994, il a finalement été possible de former un groupe de travail et d'entamer une coopération plus étroite avec d'autres entreprises.

Au cours de l'année suivante, Ajay et son équipe ont rencontré des représentants de plus de 50 entreprises, allant des petites entreprises hautement spécialisées aux géants tels que Compaq, DEC, IBM et NEC. Le travail battait son plein, 24 heures sur 24, 7 jours sur 7: dès le matin, les trois sont allés à de nombreuses réunions, et le soir, ils se sont rencontrés au restaurant le plus proche pour discuter d'un plan d'action pour le lendemain.

Peut-être que ce style de travail peut sembler une perte de temps pour certains. Néanmoins, tout cela a porté ses fruits: en conséquence, plusieurs équipes multidimensionnelles ont été formées, qui comprenaient des ingénieurs d'IBM et de Compaq spécialisés dans la création de composants informatiques, des personnes impliquées dans le développement de puces d'Intel et de NEC lui-même, des programmeurs qui ont travaillé à la création d'applications, des pilotes. et les systèmes d'exploitation (y compris de Microsoft), et de nombreux autres spécialistes. C'est le travail simultané sur plusieurs fronts qui a finalement contribué à créer une norme véritablement flexible et universelle.

Ajay Bhatt et Bala Kadambi au Prix de l'inventeur européen

Bien que l'équipe d'Ajay ait réussi à résoudre avec brio les problèmes d'ordre politique (ayant réussi l'interaction de diverses entreprises, y compris celles qui étaient des concurrents directs) et technique (ayant rassemblé de nombreux experts dans divers domaines sous un même toit), il y avait un autre aspect qui exigeait une attention particulière - le côté économique de la question. Et ici, nous avons dû faire des compromis importants. Ainsi, par exemple, c'est le désir de réduire le coût du fil qui a conduit au fait que l'USB Type-A habituel, que nous utilisons à ce jour, est devenu unilatéral. En effet, pour créer un câble véritablement universel, il faudrait non seulement changer la conception du connecteur, le rendant symétrique, mais aussi doubler le nombre de noyaux conducteurs, ce qui conduirait à un doublement du coût du fil.Mais maintenant, nous avons un mème intemporel sur la nature quantique de l'USB.

D'autres participants au projet ont également insisté pour réduire les coûts. À cet égard, Jim Pappas aime rappeler un appel de Betsy Tanner de Microsoft, qui a déclaré un jour que, malheureusement, la société avait l'intention d'abandonner l'utilisation de l'interface USB dans la production de souris informatiques. Le fait est que la bande passante de 5 Mbit / s (c'était le taux de transfert de données initialement prévu) était trop élevée, et les ingénieurs craignaient de ne pas pouvoir répondre aux spécifications d'interférences électromagnétiques, ce qui signifie qu'une telle "souris turbo" pourrait interférer avec le fonctionnement normal à la fois le PC lui-même et d'autres périphériques.

À un argument raisonnable sur le blindage, Betsy a répondu que l'isolation supplémentaire augmenterait le coût du câble: 4 cents sur le dessus pour chaque pied, ou 24 cents pour un fil standard de 1,8 mètre (6 pieds), rendant le tout inutile. De plus, le câble de la souris doit rester suffisamment flexible pour ne pas restreindre les mouvements de la main. Pour résoudre ce problème, il a été décidé d'ajouter une séparation en modes haut débit (12 Mbps) et bas débit (1,5 Mbps). Le stock de 12 Mbit / s permettait d'utiliser des répartiteurs et des concentrateurs pour connecter simultanément plusieurs appareils sur un port, et 1,5 Mbit / s était optimal pour connecter des souris, des claviers et d'autres appareils similaires à un PC.

Jim lui-même considère cette histoire comme une pierre d'achoppement qui a finalement assuré le succès de l'ensemble du projet. En effet, sans le soutien de Microsoft, il serait beaucoup plus difficile de promouvoir le nouveau standard sur le marché. De plus, le compromis trouvé a contribué à rendre l'USB beaucoup moins chère, et donc plus attractive aux yeux des fabricants d'équipements périphériques.

Qu'y a-t-il dans mon nom pour vous, ou rebranding fou

Et puisque nous parlons aujourd'hui de clés USB, clarifions en même temps la situation avec les versions et les caractéristiques de vitesse de cette norme. Tout ici n'est pas du tout aussi simple que cela puisse paraître à première vue, car depuis 2013, le Forum des implémenteurs USB s'est efforcé de confondre complètement non seulement les consommateurs ordinaires, mais aussi les professionnels du monde informatique.

Auparavant, tout était assez simple et logique: nous avons un USB 2.0 lent avec une bande passante maximale de 480 Mbit / s (60 Mo / s) et un USB 3.0 10 fois plus rapide, qui a un taux de transfert de données maximal de 5 Gb / s ( 640 Mo / s). En raison de la rétrocompatibilité, une clé USB 3.0 peut être branchée sur un port USB 2.0 (ou vice versa), mais la vitesse de lecture et d'écriture des fichiers sera limitée à 60 Mo / s, car l'appareil le plus lent agira comme un «goulot d'étranglement».

Le 31 juillet 2013, l'USB-IF a introduit beaucoup de confusion dans ce système élancé: c'est ce jour-là que l'adoption de la nouvelle spécification - USB 3.1 - a été annoncée. Et non, le point n'est pas du tout la numérotation fractionnaire des versions, qui a été rencontrée auparavant (bien que pour être honnête, il convient de noter que l'USB 1.1 était une version modifiée de 1.0, et pas quelque chose de qualitativement nouveau), mais que le Forum des implémenteurs USB pour une raison quelconque a également décidé de renommer l'ancienne norme. Surveillez vos mains:

- L'USB 3.0 est devenu l'USB 3.1 Gen 1. Il s'agit d'un pur changement de nom: aucune amélioration n'a été apportée et la vitesse maximale est restée la même - 5 Gb / s et pas plus.

- - USB 3.1 Gen 2: 128b/132b ( 8b/10b) full-duplex 10 /, 1280 /.

Mais ce n'était pas suffisant pour les gars de USB-IF, ils ont donc décidé d'ajouter quelques noms alternatifs: USB 3.1 Gen 1 est devenu SuperSpeed et USB 3.1 Gen 2 - SuperSpeed +. Et cette étape est tout à fait justifiée: pour un acheteur au détail, loin du monde de l'informatique, il est beaucoup plus facile de se souvenir d'un nom accrocheur qu'une séquence de lettres et de chiffres. Et ici tout est intuitif: nous avons une interface "ultra-rapide", qui, comme son nom l'indique, est très rapide, et il y a une interface "ultra-rapide +", qui est encore plus rapide. Mais pourquoi, dans ce cas, il était nécessaire de procéder à un "rebranding" aussi spécifique des indices de génération est absolument incompréhensible.

Cependant, il n'y a pas de limite à l'imperfection: le 22 septembre 2017, avec la publication de la norme USB 3.2, la situation s'est encore aggravée. Commençons par la bonne nouvelle: le connecteur USB Type-C réversible, dont les spécifications ont été développées pour la génération précédente de l'interface, a doublé la bande passante maximale du bus en utilisant des broches en double comme canal de transmission de données séparé. C'est ainsi qu'est apparu l'USB 3.2 Gen 2 × 2 (pourquoi on ne pouvait pas l'appeler USB 3.2 Gen 3, là encore un mystère), fonctionnant à des vitesses allant jusqu'à 20 Gb / s (2560 Mo / s), qui, en particulier, a trouvé une application dans la production de disques SSD (c'est le port dont le WD_BLACK P50 haute vitesse est équipé, destiné aux joueurs).

Et tout irait bien, mais, en plus de l'introduction d'un nouveau standard, le changement de nom des précédents ne s'est pas fait attendre: USB 3.1 Gen 1 s'est transformé en USB 3.2 Gen 1, et USB 3.1 Gen 2 - en USB 3.2 Gen 2. Même les noms marketing ont subi des changements, et L'USB-IF s'est écarté du concept précédemment adopté de «intuitif et sans chiffres»: au lieu d'étiqueter USB 3.2 Gen 2 × 2 comme SuperSpeed ++ ou UltraSpeed, ils ont décidé d'ajouter une indication directe du taux de transfert de données maximal:

- USB 3.2 Gen 1 est devenu SuperSpeed USB 5Gbps,

- USB 3.2 Gen 2 - SuperSpeed USB 10 Gbps,

- USB 3.2 Gen 2 × 2 - USB SuperSpeed 20 Gbit / s.

Alors, comment gérez-vous le zoo aux normes USB? Pour vous faciliter la vie, nous avons compilé une fiche-mémo récapitulative, à l'aide de laquelle il ne sera pas difficile de comparer différentes versions d'interfaces.

Version standard |

Nom marketing |

Vitesse, Gbps |

|||

USB 3.0 |

USB 3.1 |

USB 3.2 |

USB 3.1 |

USB 3.2 |

|

USB 3.0 |

USB 3.1 Gen 1 |

USB 3.2 Gen 1 |

SuperSpeed |

SuperSpeed USB 5Gbps |

5 |

– |

USB 3.1 Gen 2 |

USB 3.2 Gen 2 |

SuperSpeed+ |

SuperSpeed USB 10Gbps |

10 |

– |

– |

USB 3.2 Gen 2×2 |

– |

SuperSpeed USB 20Gbps |

20 |

USB- SanDisk

Mais revenons directement au sujet de la discussion d'aujourd'hui. Les lecteurs flash sont devenus partie intégrante de notre vie, ayant reçu de nombreuses modifications, parfois très bizarres. Le portefeuille SanDisk offre la compréhension la plus complète des capacités des clés USB modernes.

Tous les modèles actuels de lecteurs flash SanDisk prennent en charge la norme de transfert de données USB 3.0 (alias USB 3.1 Gen 1, alias USB 3.2 Gen 1, alias SuperSpeed - presque comme dans le film "Moscou ne croit pas aux larmes"). Parmi eux, vous pouvez trouver à la fois des lecteurs flash assez classiques et des appareils plus spécialisés. Par exemple, si vous recherchez un lecteur tout-en-un compact, la gamme SanDisk Ultra est logique.

SanDisk Ultra

La disponibilité de six modifications de différentes capacités (de 16 à 512 Go) vous permet de choisir la meilleure option en fonction de vos besoins et de ne pas payer trop cher les gigaoctets supplémentaires. Des vitesses de transfert de données allant jusqu'à 130 Mo / s vous permettent de télécharger rapidement même des fichiers volumineux, et un boîtier coulissant pratique protège de manière fiable le connecteur contre les dommages.

Pour les amateurs de formes élégantes, nous recommandons les clés USB SanDisk Ultra Flair et SanDisk Luxe.

SanDisk Ultra Flair

Techniquement, ces lecteurs flash sont complètement identiques: les deux séries se caractérisent par des vitesses de transfert allant jusqu'à 150 Mo / s, et chacune d'entre elles comprend 6 modèles avec des capacités de 16 à 512 Go. Les différences résident uniquement dans la conception: Ultra Flair a reçu un élément structurel supplémentaire en plastique durable, tandis que le corps de la version Luxe est entièrement en alliage d'aluminium.

SanDisk Luxe

Outre le design spectaculaire et la vitesse de transfert de données élevée, ces disques ont une autre caractéristique très intéressante: leurs connecteurs USB sont une continuation directe du boîtier monolithique. Cette approche offre le plus haut niveau de sécurité pour le lecteur flash: il est tout simplement impossible de casser accidentellement un tel connecteur.

En plus des disques de taille standard, la collection SanDisk comprend également des solutions plug-and-forget. Nous parlons, bien sûr, de l'ultra-compact SanDisk Ultra Fit, dont les dimensions ne sont que de 29,8 x 14,3 x 5,0 mm.

SanDisk Ultra Fit

Ce bébé dépasse à peine de la surface du connecteur USB, ce qui le rend idéal pour étendre le stockage sur un appareil client, que ce soit un ultrabook, un système audio de voiture, une télévision intelligente, une console de jeu ou un ordinateur monocarte.

Les clés USB Dual Drive et iXpand sont les plus intéressantes de la collection SanDisk. Les deux familles, malgré les différences de conception, sont unies par un seul concept: ces lecteurs flash ont reçu deux ports de types différents, ce qui leur permet d'être utilisés pour transférer des données entre un PC ou un ordinateur portable et des gadgets mobiles sans câbles ni adaptateurs supplémentaires.

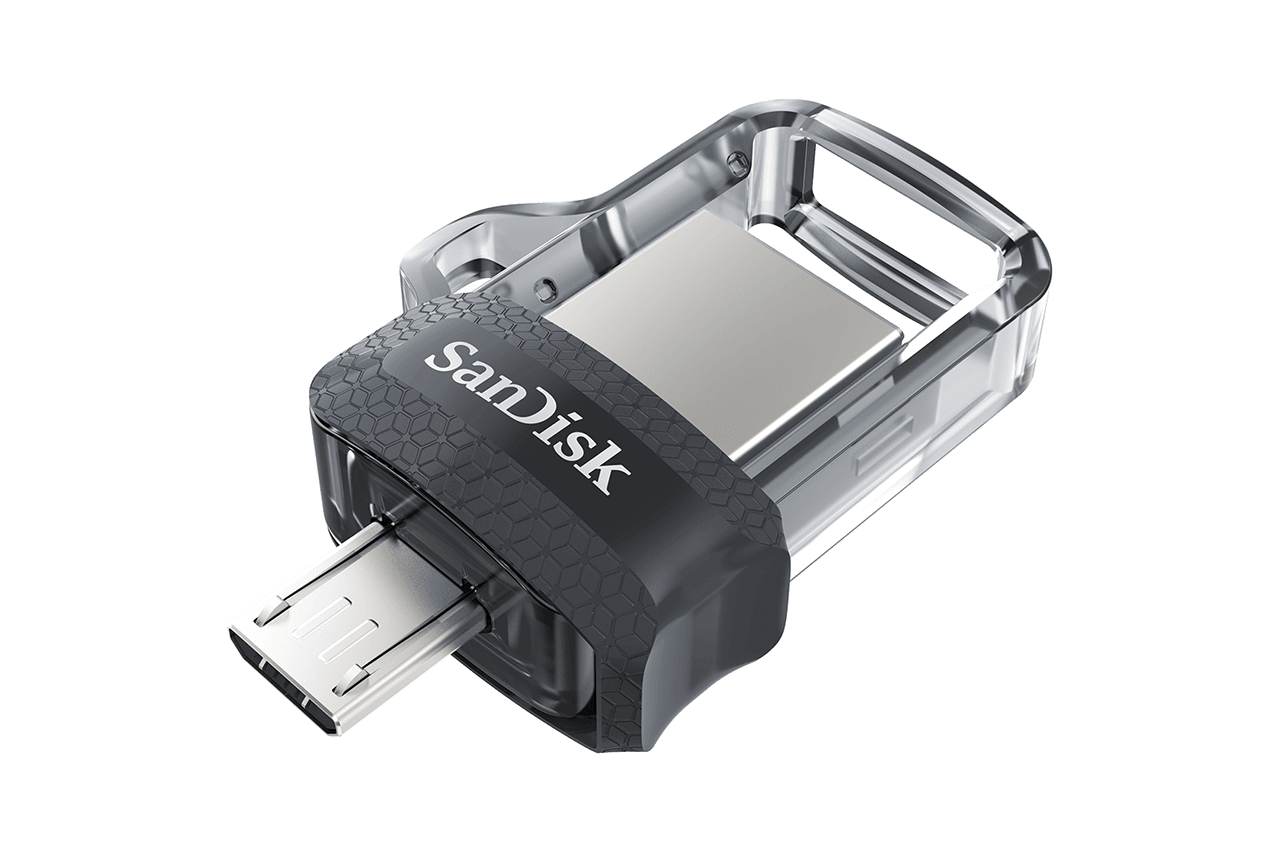

La famille Dual Drive est conçue pour être utilisée avec les smartphones et les tablettes exécutant le système d'exploitation Android et prenant en charge la technologie OTG. Cela comprend trois lignes de lecteurs flash.

Le SanDisk Dual Drive m3.0 miniature, en plus de l'USB Type-A, est équipé d'un connecteur microUSB, qui offre une compatibilité avec les appareils du passé, ainsi qu'avec les smartphones d'entrée de gamme.

SanDisk Dual Drive m3.0

SanDisk Ultra Dual Type-C, comme vous pouvez le deviner d'après son nom, a un connecteur bidirectionnel plus moderne. Le lecteur flash lui-même est devenu plus grand et plus massif, mais cette conception du boîtier offre une meilleure protection et il est devenu beaucoup plus difficile de perdre l'appareil.

SanDisk Ultra Dual Type-C

Si vous recherchez quelque chose d'un peu plus élégant, nous vous recommandons de consulter le SanDisk Ultra Dual Drive Go. Ces lecteurs implémentent le même principe que dans le SanDisk Luxe mentionné précédemment: l'USB Type-A pleine taille fait partie du boîtier du lecteur flash, ce qui l'empêche de casser même avec une manipulation imprudente. Le connecteur USB Type-C, quant à lui, est bien protégé par un capuchon pivotant, qui a également un œillet pour un porte-clés. Cette disposition a permis de rendre la clé USB vraiment élégante, compacte et fiable.

SanDisk Ultra Dual Drive Go

La série iXpand est complètement similaire à Dual Drive, à l'exception du fait que le connecteur Apple Lightning a remplacé l'USB Type-C. L'appareil le plus inhabituel de la série peut être appelé le SanDisk iXpand: ce lecteur flash a un design original en forme de boucle.

SanDisk iXpand a l'air

impressionnant, en plus, vous pouvez enfiler une sangle dans l'œillet résultant et porter le lecteur, par exemple, autour de votre cou. Et utiliser une telle clé USB avec un iPhone est beaucoup plus pratique qu'une clé traditionnelle: une fois connectée, la majeure partie de l'étui est derrière le smartphone, reposant contre sa coque arrière, ce qui permet de minimiser les risques d'endommagement du connecteur.

Si un design similaire pour une raison ou une autre ne vous convient pas, il est logique de se tourner vers le SanDisk iXpand Mini. Techniquement, nous avons le même iXpand: la gamme comprend également quatre lecteurs de 32, 64, 128 ou 256 Go, et la vitesse maximale de transfert de données atteint 90 Mo / s, ce qui est bien suffisant même pour regarder des vidéos 4K directement à partir d'un lecteur flash. La seule différence réside dans le design: la boucle a disparu, mais un capuchon de protection pour le connecteur Lightning est apparu.

SanDisk iXpand Mini

Le troisième membre de la glorieuse famille, SanDisk iXpand Go, est le frère jumeau du Dual Drive Go: leurs dimensions sont presque identiques, de plus, les deux disques ont reçu un capuchon pivotant, bien que légèrement différent dans la conception. Cette gamme comprend 3 modèles: 64, 128 et 256 Go.

SanDisk iXpand Go La

liste des produits de marque SanDisk ne se limite pas aux clés USB répertoriées. Vous pouvez vous familiariser avec d'autres appareils de la célèbre marque sur le portail officiel Western Digital .