Les disques durs modernes (HDD) combinent de manière intéressante l'aboutissement de l'ingénierie de précision dans la production de masse et la technologie de stockage la plus méprisée. Malgré des surnoms aussi peu flatteurs que «rouille tournante», la plupart des disques parviennent à faire tourner des plaques magnétiques extrêmement lisses à quelques nanomètres des têtes d'enregistrement et de lecture tout au long de leur vie. Les supports de ce dernier, à leur tour, tirent les solénoïdes, capables de positionner la tête exactement sur la piste magnétique microscopique en quelques millisecondes.

Malgré le fait que pendant de nombreuses décennies, de plus en plus de ces pistes magnétiques ont été entassées dans un millimètre carré de plateaux et que les têtes de lecture et d'écriture sont constamment remplacées par des têtes de plus en plus complexes, la fiabilité des disques durs ne cesse de croître. Dans un rapport du deuxième trimestre 2020 de la société de stockage Backblaze, il est clair que le taux de défaillance annuel de leurs disques durs est nettement inférieur à celui de l'année dernière.

La question est de savoir si cela signifie que les disques durs deviendront encore plus fiables au fil du temps, et comment les nouvelles technologies comme MAMR et HAMR peuvent influencer ce processus dans les décennies à venir.

De méga à tera

Mécanisme interne et ses cinquante plateaux de 610 mm IBM 350

HDD Les premiers disques durs ont été vendus dans les années 50. L'IBM 350 avait une capacité de stockage de 3,75 Mo et disposait de cinquante disques de 24 "(610 mm) dans une armoire de 152 x 172 x 74 cm. Le 3,5" (14,7 X 10,2 x 2,6 cm) peut contenir jusqu'à 18 To en utilisant la technologie d'enregistrement conventionnelle (sans mosaïque ).

Les cymbales de l'IBM 350 tournaient à 1200 tr / min. Les nouveaux disques durs se concentrent sur la réduction de la taille des plaquettes et l'augmentation de la vitesse de la broche (5400 - 15 000 tr / min). D'autres améliorations incluent le placement des têtes de lecture et d'écriture plus près de la surface du plateau.

L'IBM 1301 DSU (Disk Storage Unit) de 1961 était une innovation importante - elle utilisait des supports séparés avec des têtes de lecture et d'écriture pour chacun des plateaux. Une autre innovation a utilisé l'aérodynamique - les têtes étaient en vol libre au-dessus de la surface des plaques, soutenues par un coussin d'air, ce qui permettait de réduire considérablement la distance entre elles et la surface.

Après 46 ans de développement, IBM a vendu en 2003 son activité HDD à Hitachi. À ce moment-là, la capacité des disques avait augmenté de 48 000 fois et le volume avait considérablement diminué. 29 161 fois. La consommation électrique est passée de 2,3 kW à 10 W (modèles de bureau) et le coût par mégaoctet est passé de 68 000 $ à 0,002 $. Dans le même temps, le nombre de plaques est passé de dizaines à un maximum d'un couple.

Nous stockons plus de données dans moins d'espace

La

miniaturisation Seagate MicroDrive de 1 ″ a toujours été l'objectif principal de tous les domaines - que ce soit la mécanique, l'électronique ou l'informatique. Le tube géant ou les monstres informatiques relais des années 1940 et 1950 ont évolué en systèmes de transistors plus petits, puis en merveilles ASIC modernes et élancées. La technologie de stockage a subi les mêmes changements.

L'électronique d'entraînement des disques durs a bénéficié de tous les avantages de la popularité croissante des circuits VLSI, ainsi que de la précision et de la consommation d'énergie croissantes des servos. La densité d'enregistrement par unité de surface a augmenté avec le développement de la science des matériaux, grâce à laquelle des plaques de moins en moins lourdes et plus lisses (verre ou aluminium) sont apparues, et la qualité du revêtement magnétique s'est améliorée. Au fur et à mesure que nous comprenions mieux les propriétés des composants individuels (boîtiers ASIC, alliages de soudure, solénoïdes, aérodynamique du support, etc.), les révolutions ont été progressivement remplacées par des améliorations progressives.

Six disques durs ouverts d'une taille allant de 8 "à 1"

Bien qu'ils aient déjà essayé de se rapprocher de la miniaturisation extrême des disques durs déjà deux fois ( microdrive HP Kittyhawk de 1,3 " en 1992 et Microdrive de 1"1999), le marché a finalement opté pour les facteurs de forme 3,5 "et 2,5". Le facteur de forme Microdrive a été présenté comme une alternative aux cartes CompactFlash qui utilisaient la technologie NAND Flash - une alternative avec une capacité plus élevée et des réécritures pratiquement infinies qui était bien adaptée aux systèmes embarqués.

Comme dans d'autres domaines, les limitations physiques de la vitesse d'écriture et des temps d'accès aléatoire rendent les disques durs plus utiles là où de grandes quantités de stockage sont importantes pour peu d'argent, ainsi qu'une fiabilité élevée. En conséquence, le marché des disques durs a été optimisé pour les ordinateurs de bureau et serveurs, ainsi qu'à des fins de vidéosurveillance et de sauvegarde (en concurrence avec le film).

Comprendre les raisons d'une panne de disque dur

Bien que l'on pense généralement que le point faible des disques durs est leurs pièces mécaniques, diverses raisons peuvent être à l'origine de pannes, à savoir:

- Erreur humaine;

- Panne d'équipement, à la fois mécanique et électronique;

- Dommages au firmware;

- Facteurs externes (chaleur, humidité);

- Nutrition.

Le disque dur se voit attribuer la valeur d'impact physique admissible lorsque l'alimentation est coupée ou pendant le fonctionnement (lorsque les plaques tournent et que les têtes ne sont pas stationnées). Le dépassement de cette valeur peut endommager les solénoïdes qui déplacent les bras ou la tête peut heurter la surface de la plaque. Si ces valeurs ne sont pas dépassées, alors la principale cause de défaillance sera l'usure naturelle, dont le degré est déterminé par le nombre de MTBF (Temps moyen entre pannes, «temps moyen entre pannes »).

Le MTBF est obtenu en extrapolant à partir de l'usure observée au fil du temps. Le MTBF pour un disque dur est généralement de 100 000 à 1 million d'heures, et pour tester les performances du disque sur toute cette période, il faudrait qu'il reste allumé pendant 10 à 100 ans [pas tout à fait -voici une explication plus correcte / env. trad.]. Ce nombre suppose que le disque dur fonctionne dans les conditions recommandées.

Évidemment, soumettre le disque dur à des chocs violents (le laisser tomber sur un sol en béton) ou à des surtensions (surtensions, décharges électrostatiques) réduira sa durée de vie. Les défauts de fabrication qui peuvent être trouvés sur n'importe quel produit sont moins évidents, de sorte que la plupart des produits ont un «taux de défaillance acceptable».

Il ne s'agit pas de vous, mais de la chaîne de production

Malgré le fort MTBF et l'effort apparent de Backblaze pour s'assurer que ses 130000 disques durs tournent joyeusement pour la vie, puis dans le paradis du disque dur (généralement via un broyeur de métaux), Backblaze a rapporté qu'au premier trimestre 2020, la probabilité annuelle de défaillance (AFR ) était de 1,07%. Heureusement, il s'agit du chiffre le plus bas pour l'entreprise depuis qu'elle a commencé à publier des rapports en 2013. Par exemple, au premier trimestre 2019, l'AFR était de 1,56%.

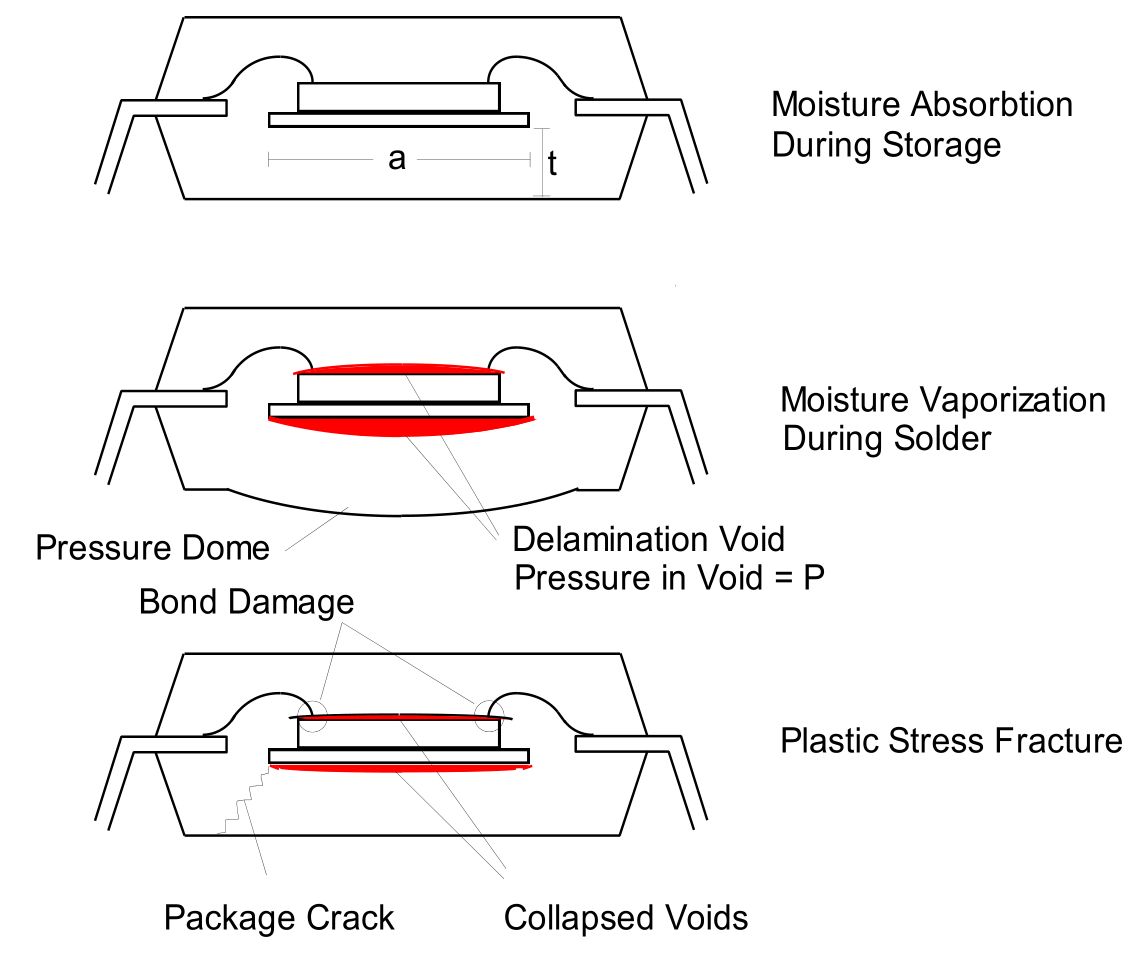

Comme nous l'avons déjà mentionné, lors de la production et de l'installation des circuits intégrés , des défauts peuvent apparaître , qui se manifesteront déjà lors du fonctionnement du disque dur. Au fil du temps, des choses comme l' électromigration, la chaleur et le stress mécaniquepeut provoquer des pannes de circuit, de la rupture des fils à l'intérieur du boîtier du CI, à l'usure des points de soudure ou des circuits à l'intérieur du CI en raison de l'électromigration (en particulier en raison d'une décharge électrostatique).

Les composants mécaniques des disques durs sont soumis à des tolérances d'ingénierie de précision ainsi qu'à une lubrification appropriée. Dans le passé, il peut y avoir eu un problème d' adhérence de la tête où les propriétés du lubrifiant ont changé avec le temps jusqu'à ce que les supports perdent la capacité de se déplacer hors de la position de stationnement. Aujourd'hui, une lubrification améliorée a plus ou moins résolu ce problème.

Pourtant, à chaque étape du processus de fabrication, il existe une possibilité de défauts qui finissent par s'accumuler et peuvent gâcher le beau MTBF brillant, plaçant le produit du mauvais côté du graphique du taux de rebond (en forme de « bain »). Cette courbe représente un pic précoce du taux de défaillance dû à de graves défauts de fabrication, après quoi le taux de défaillance diminue jusqu'à ce que le graphique approche la fin de la durée de vie de l'appareil.

Regarder vers l'avant

Les disques durs d'aujourd'hui reflètent clairement la maturité du processus de production - bon nombre des vieux problèmes qui les ont tourmentés au cours de la dernière décennie ont été résolus ou contournés. Certaines innovations majeures, comme le passage aux variateurs à hélium , n'ont pas encore permis de gains significatifs d'efficacité ou de fiabilité. D'autres changements, tels que la transition de PMZ, enregistrement magnétique perpendiculaire , à HAMR, enregistrement thermomagnétique, ne devraient pas affecter considérablement la durée de vie du disque dur, à l'exception des problèmes liés à la technologie elle-même.

En fait, l'avenir de la technologie des disques durs semble terne pour quiconque aime le stockage à haut volume pour peu d'argent, qui devrait durer au moins dix ans. Les principes de base des lecteurs de disque dur, c'est-à-dire le stockage des orientations magnétiques sur une tranche, peuvent même être transférés à des molécules individuelles. Des innovations telles que HAMR devraient augmenter la stabilité à long terme de ces orientations magnétiques.

C'est un énorme avantage des disques durs par rapport à la mémoire flash NAND, qui utilise de petits condensateurs pour stocker les charges et une méthode d'écriture qui les endommage physiquement. Là, les contraintes physiques sont beaucoup plus sévères, et elles ont conduit à des conceptions plus complexes, telles que la mémoire flash à cellule à quatre niveaux (QLC), qui doit distinguer 16 valeurs de tension différentes dans chacune des cellules. Cette complexité signifie que les disques QLC sont à peine plus rapides que les disques durs à 5400 tr / min dans de nombreux cas, en particulier en ce qui concerne la latence.

Ralentir la rotation

Le premier disque dur que j'ai utilisé dans mon propre ordinateur était un Seagate de 20 ou 30 Mo dans l'IBM PS / 2 (386SX), que mon père m'a donné après être passé à de nouveaux PC au travail - apparemment, ils avaient besoin de libérer place dans l'entrepôt. À l'époque de MS-DOS, cela suffisait pour le système d'exploitation, un tas de jeux, WordPerfect 5.1 et bien plus encore. À la fin des années 90, c'était déjà un volume ridicule, et quand il s'agissait de disques durs, on parlait déjà de gigaoctets.

Malgré le fait que depuis, j'ai changé de nombreux PC et ordinateurs portables, jusqu'à présent, seuls les disques SSD meurent. Ceci, ainsi que les indicateurs de l'industrie - comme ces rapports de Backblaze - me donnent confiance que les nouveaux disques durs tourneront pendant longtemps. Peut-être que lorsque la mémoire 3D XPoint deviendra bon marché et suffisamment grande, la situation changera.

Jusque-là, faites-vous tourner.