La révolution moderne de l'intelligence artificielle a commencé par un concours de recherche discret. Cela s'est produit en 2012, la troisième année du concours ImageNet. Le défi pour les équipes était de construire une solution qui reconnaîtrait mille images, des animaux et des personnes aux paysages.

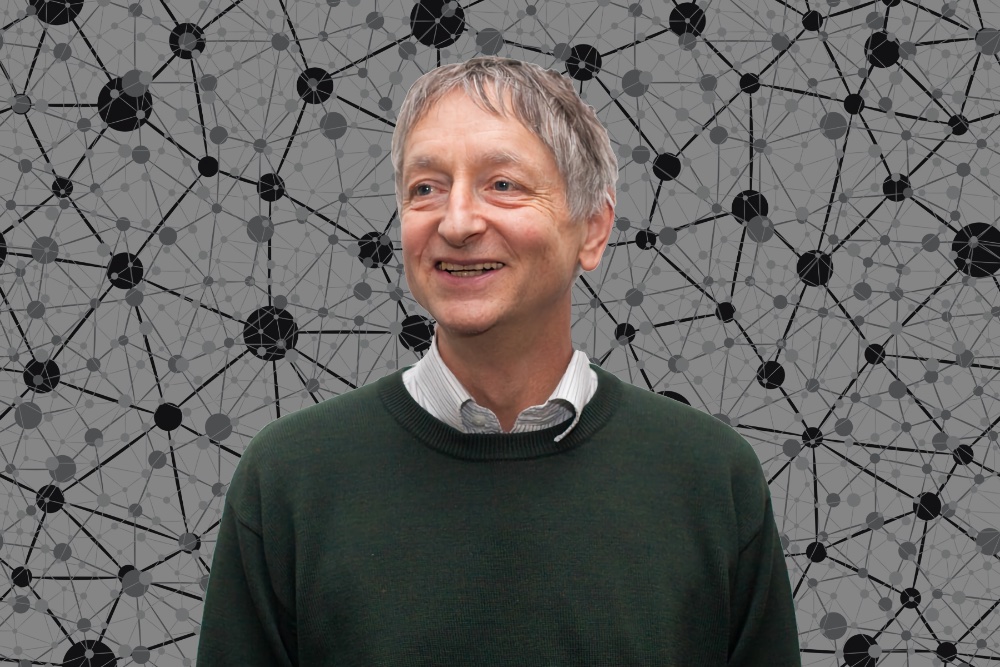

Au cours des deux premières années, les meilleures équipes n'ont pas atteint plus de 75% de précision. Au cours de la troisième année, une équipe de chercheurs - un professeur et ses étudiants - a brusquement franchi ce plafond. Ils ont remporté le concours avec un taux stupéfiant de 10,8%. Le nom du professeur était Jeffrey Hinton et sa méthode était l'apprentissage en profondeur.

Hinton travaille dans le domaine du deep learning depuis les années 1980, mais l'efficacité a été limitée par le manque de données et de puissance de calcul. Sa foi inébranlable dans la méthode a finalement porté ses fruits. Au cours de la quatrième année de la compétition, presque toutes les équipes ont appliqué un apprentissage en profondeur, obtenant des gains miraculeux de précision. Bientôt, l'apprentissage en profondeur a commencé à être appliqué dans diverses industries, et pas seulement dans les tâches de reconnaissance d'images.

L'année dernière, Hinton, ainsi que les pionniers de l'intelligence artificielle Jan Lecun et Joshua Bengio, ont reçu le prix Turing pour les contributions fondamentales à ce domaine scientifique.

Vous pensez que l'apprentissage en profondeur suffira à reproduire toute l'intelligence humaine. Qu'est-ce qui vous rend si confiant?

Je pense que l'apprentissage en profondeur peut tout faire, mais je pense qu'il doit y avoir pas mal de percées conceptuelles. Par exemple, en 2017, Ashish Vaswani et ses collègues ont introduit des transformateurs qui produisent de très bons vecteurs qui représentent le sens des mots. C'était une percée conceptuelle. Il est maintenant utilisé dans presque tous les meilleurs traitements de langage naturel. Nous aurons besoin d'un tas de telles avancées.

Et si nous réalisons de telles avancées, rapprocherons-nous l'intelligence artificielle de l'intelligence humaine en utilisant le deep learning?

Oui. Surtout les avancées liées à la façon dont vous obtenez de grands vecteurs d'activité neuronale pour mettre en œuvre des choses comme la pensée. Mais nous avons également besoin d'une échelle énorme. Le cerveau humain a environ cent mille milliards de paramètres ou synapses. Le très gros modèle que nous appelons maintenant le GPT-3 avec 175 milliards de paramètres. C'est mille fois plus petit que le cerveau. GPT-3 peut désormais générer du texte assez crédible, mais il est encore minuscule par rapport au cerveau.

Lorsque vous parlez d'échelle, parlez-vous de grands réseaux de neurones, de données ou des deux?

Tous les deux. Il y a un décalage entre ce qui se passe en informatique et ce qui se passe chez les humains. Les gens ont un grand nombre de paramètres par rapport à la quantité de données qu'ils reçoivent. Les réseaux de neurones fonctionnent étonnamment bien avec beaucoup moins de données et plus de paramètres, mais les humains sont encore meilleurs.

De nombreux spécialistes de l'IA pensent que la santé mentale de l'IA est une capacité qui doit être approfondie. Êtes-vous d'accord?

Je reconnais que c'est l'une des choses les plus importantes. Je pense également que le contrôle des mouvements est très important et que les réseaux d'apprentissage en profondeur deviennent bons dans ce domaine aujourd'hui. En particulier, certains travaux récents de Google ont montré qu'il est possible de combiner la motricité fine et la parole de manière à ce que le système puisse ouvrir un tiroir de bureau, supprimer un bloc et dire en langage naturel ce qu'il a fait.

Pour des choses comme GPT-3, qui génère de bons textes, il est clair qu'il doit comprendre beaucoup de choses pour générer du texte, mais ce n'est pas vraiment clair à quel point il comprend. Mais quand quelque chose ouvre le tiroir, sort le bloc et dit: «Je viens d'ouvrir le tiroir et de sortir le bloc», il est difficile de dire qu'il ne comprend pas ce qu'il fait.

Les spécialistes de l'IA ont toujours considéré le cerveau humain comme une source d'inspiration inépuisable, et différentes approches de l'IA sont issues de différentes théories des sciences cognitives. Pensez-vous que le cerveau construit vraiment une vision du monde pour le comprendre, ou est-ce juste une façon de penser utile?

En sciences cognitives, il y a longtemps eu un débat entre les deux écoles de pensée. Le chef de la première école, Stephen Kosslin, pensait que lorsque le cerveau fonctionne avec des images visuelles, on parle de pixels et de leurs mouvements. La deuxième école était plus conforme à l'IA traditionnelle. Ses adhérents ont dit: «Non, non, c'est un non-sens. Ce sont des descriptions structurelles hiérarchiques. L'esprit a une certaine structure symbolique, nous contrôlons cette structure même. "

Je pense que les deux écoles ont fait la même erreur. Kosslin pensait que nous manipulions des pixels parce que les images externes sont constituées de pixels et que les pixels sont la représentation que nous comprenons. La deuxième école pensait que parce que nous manipulons la représentation symbolique et représentons les choses à travers des symboles, c'est la représentation symbolique que nous comprenons. Je pense que ces erreurs sont équivalentes. À l'intérieur du cerveau se trouvent de grands vecteurs d'activité neuronale.

Il y a des gens qui croient encore que la représentation symbolique est une approche de l'IA.

Tout à fait raison. J'ai de bons amis, comme Hector Levesque, qui croit vraiment en l'approche symbolique et a fait un excellent travail dans ce sens. Je ne suis pas d'accord avec lui, mais l'approche symbolique est une chose parfaitement raisonnable à essayer. Cependant, je pense qu'au final on se rend compte que les symboles existent simplement dans le monde extérieur, et on effectue des opérations internes sur de grands vecteurs.

Quelle vision de l'IA considérez-vous comme la plus opposée par rapport aux autres?

Eh bien, mon problème est que j'avais ces points de vue opposés, et après cinq ans, ils sont devenus courants. La plupart de mes opinions opposées des années 80 sont maintenant largement acceptées. Il est maintenant assez difficile de trouver des personnes qui ne sont pas d'accord avec eux. Alors oui, mes opinions opposées ont été sapées d'une certaine manière.

Qui sait, peut-être que vos points de vue et vos méthodes de travail avec l'IA seront également souterrains et deviendront dans quelques années la norme de l'industrie. L'essentiel est de ne pas s'arrêter dans votre progression. Et nous serons heureux de vous aider en vous présentant un code promo spécial HABR , qui ajoutera 10% à la réduction sur la bannière.

- Cours avancé "Machine Learning Pro + Deep Learning"

- Cours "Mathématiques et apprentissage automatique pour la science des données"

- Cours d'apprentissage automatique

- Formation aux métiers de la Data Science

- Data Analyst

- - Data Analytics

E

- JavaScript

- -

- Java-

- «Python -»

- SQL

- C++

- DevOps

- iOS-

- Android-

- Data Scientist -

- 450

- Machine Learning 5 9

- : 2020

- Machine Learning Computer Vision