Au cours des dernières années, des progrès significatifs ont été réalisés dans le domaine du traitement du langage naturel (PNL) , où des modèles tels que BERT , ALBERT , ELECTRA et XLNet ont atteint une précision étonnante dans diverses tâches. Lors de la pré-formation , des représentations vectorielles sont formées sur la base d'un corpus textuel étendu (par exemple, Wikipedia ), qui sont obtenues en masquant des mots et en essayant de les prédire ( modélisation du langage masqué). Les représentations résultantes codent une grande quantité d'informations sur le langage et la relation entre les concepts, par exemple entre un chirurgien et un scalpel. Ensuite, la deuxième étape de la formation commence - la mise au point - dans laquelle le modèle utilise des données affinées pour une tâche spécifique afin d'apprendre à effectuer des tâches spécifiques telles que la classification à l' aide de représentations générales pré-entraînées . Compte tenu de l'utilisation répandue de ces modèles dans divers problèmes de PNL, il est essentiel de comprendre quelles informations ils contiennent et comment les relations apprises affectent les résultats du modèle dans ses applications, afin de s'assurer qu'ils sont conformes aux principes de l'intelligence artificielle (IA) .

L'article « Mesurer les corrélations de genre dans les modèles de PNL pré-formés» explore le modèle BERT et son cousin léger ALBERT à la recherche de relations liées au genre, et formule un certain nombre de bonnes pratiques pour l'utilisation de modèles de langage pré-formés. Les auteurs présentent des résultats expérimentaux sous la forme de pondérations de modèles publics et d'un ensemble de données exploratoires pour démontrer l'application des meilleures pratiques et fournir une base pour une enquête plus approfondie sur les paramètres, ce qui dépasse le cadre de cet article. En outre, les auteurs prévoient de définir un ensemble de poids Zari , dans lequel le nombre de corrélations de genre est réduit, mais la qualité est maintenue élevée sur les problèmes de PNL standard.

Mesurer les corrélations

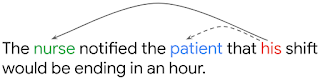

, , , . , . , , his («») nurse ( «»), patient («»).

– OntoNotes (Hovy et al., 2006). F1-, ( Tenney et al. 2019). OntoNotes , WinoGender, , , . ( 1) WinoGender , (.. nurse , ). , , , - , .

BERT ALBERT OntoNotes () WinoGender ( ). WinoGender , , .

, (Large) BERT, ALBERT WinoGender, ( 100%) (accuracy) OntoNotes. , . : , . , .. , , , , .

: NLP- ?

- : , , , . , BERT ALBERT 1% , 26% . : , WinoGender , , , , , , (male nurse).

- : , . , , , , . , , - (dropout regularization), : (dropout rate) BERT ALBERT, . , , , .

- : : , , WinoGender - . , OntoNotes ( BERT'), , - , . (. ).

, NLP-, . , . , , , , . , , , .

- — Kellie Webster

- Traduction - Ekaterina Smirnova

- Montage et mise en page - Sergey Shkarin