Transformation du centre de données

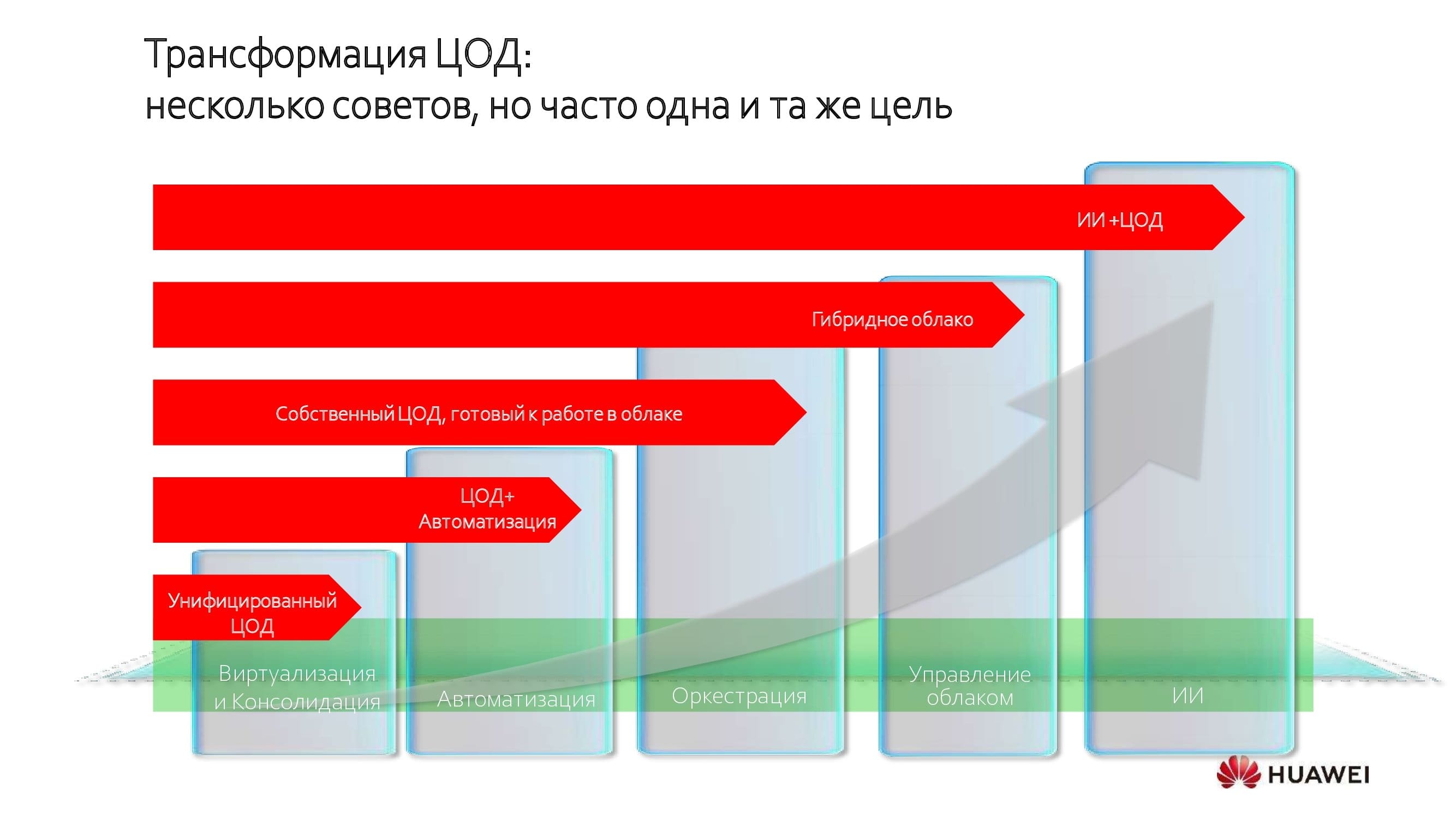

Les centres de données changent conceptuellement et changent radicalement. La tendance est devenue relativement répandue il y a une dizaine d'années, mais, disons, dans le secteur bancaire, elle a commencé beaucoup plus tôt. Quelle que soit la voie choisie, les objectifs des transformations sont plus ou moins similaires - l'unification et la consolidation des ressources.

Il s'agit de la première étape, suivie d'une nouvelle amélioration de l'efficacité du datacenter grâce à l'automatisation, l'orchestration et la transition vers le mode cloud hybride. Et la limite la plus éloignée de la transformation que l'on puisse atteindre aujourd'hui est l'introduction de systèmes d'intelligence artificielle.

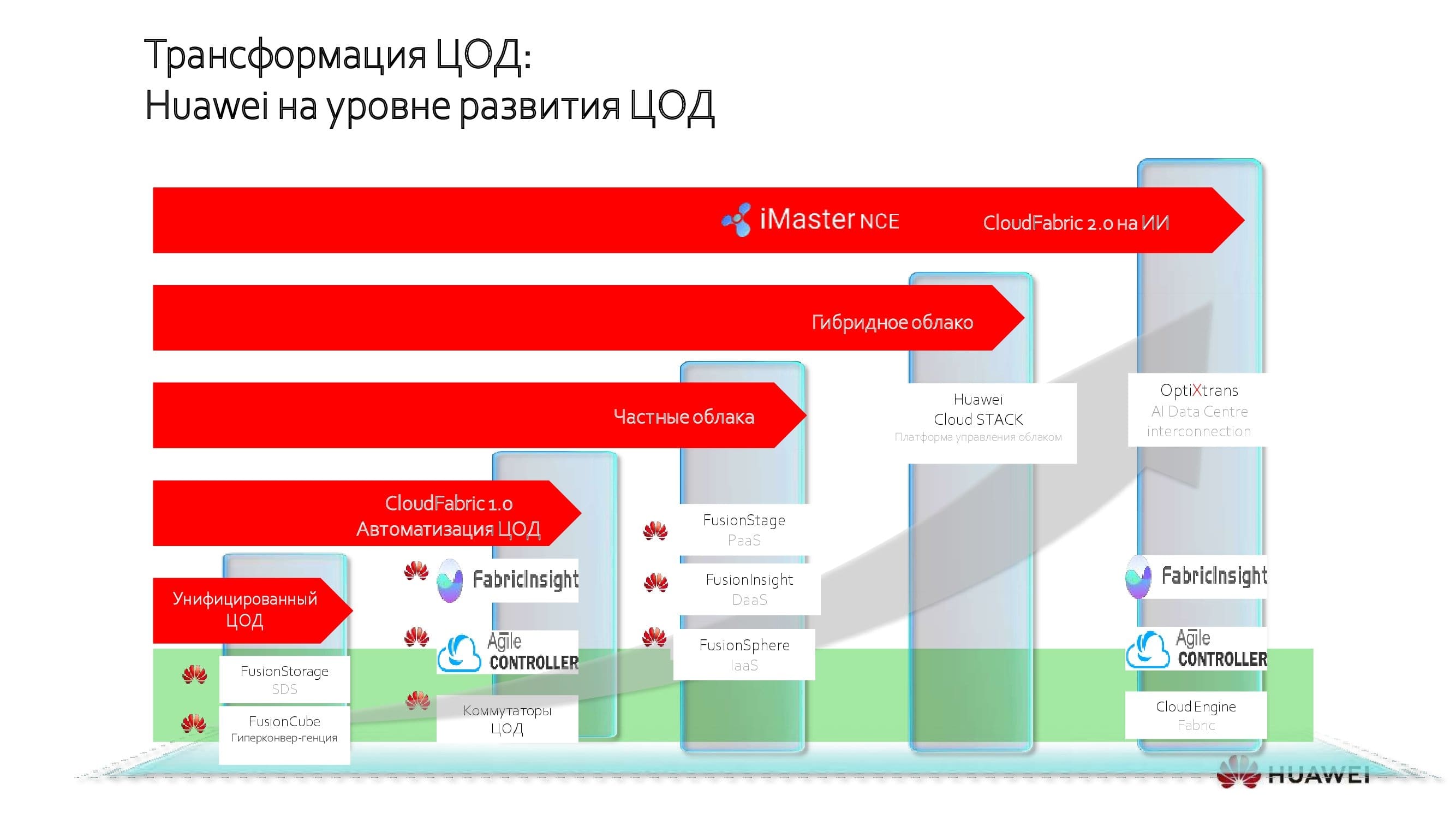

Des solutions Huawei pour chaque étape de la transformation

À chaque étape, en fonction de la «maturité informatique» du client, Huawei propose ses propres solutions conçues pour fournir le meilleur résultat de mise à niveau sans dépenses inutiles. Aujourd'hui, je voudrais parler plus en détail de la «cerise sur le gâteau» - les systèmes d'IA dans les centres de données modernes.

Pour faire une analogie avec le corps humain, les commutateurs de réseau de centre de données agissent comme le système circulatoire, assurant la connectivité entre divers composants: nœuds informatiques, systèmes de stockage de données, etc.

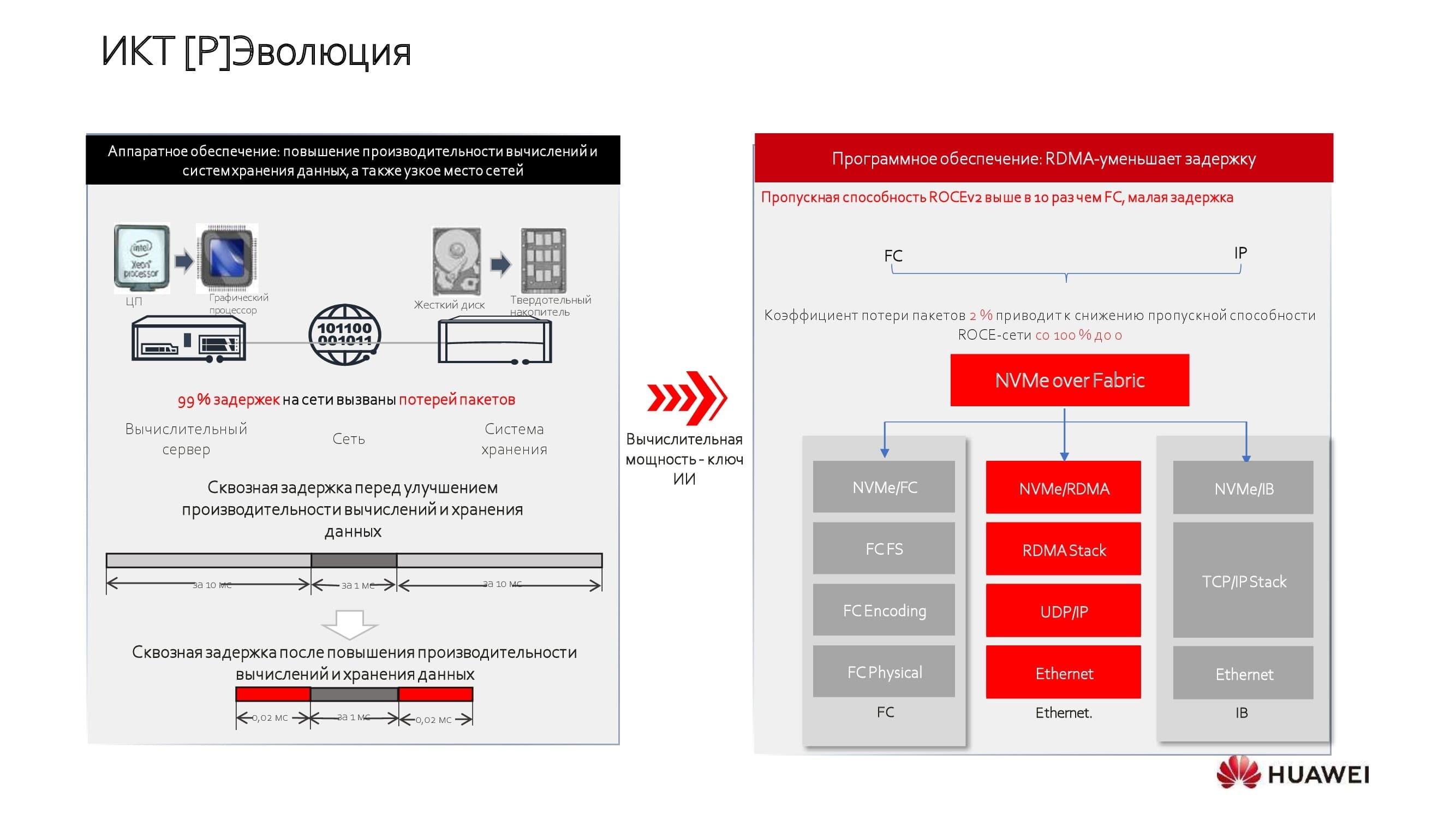

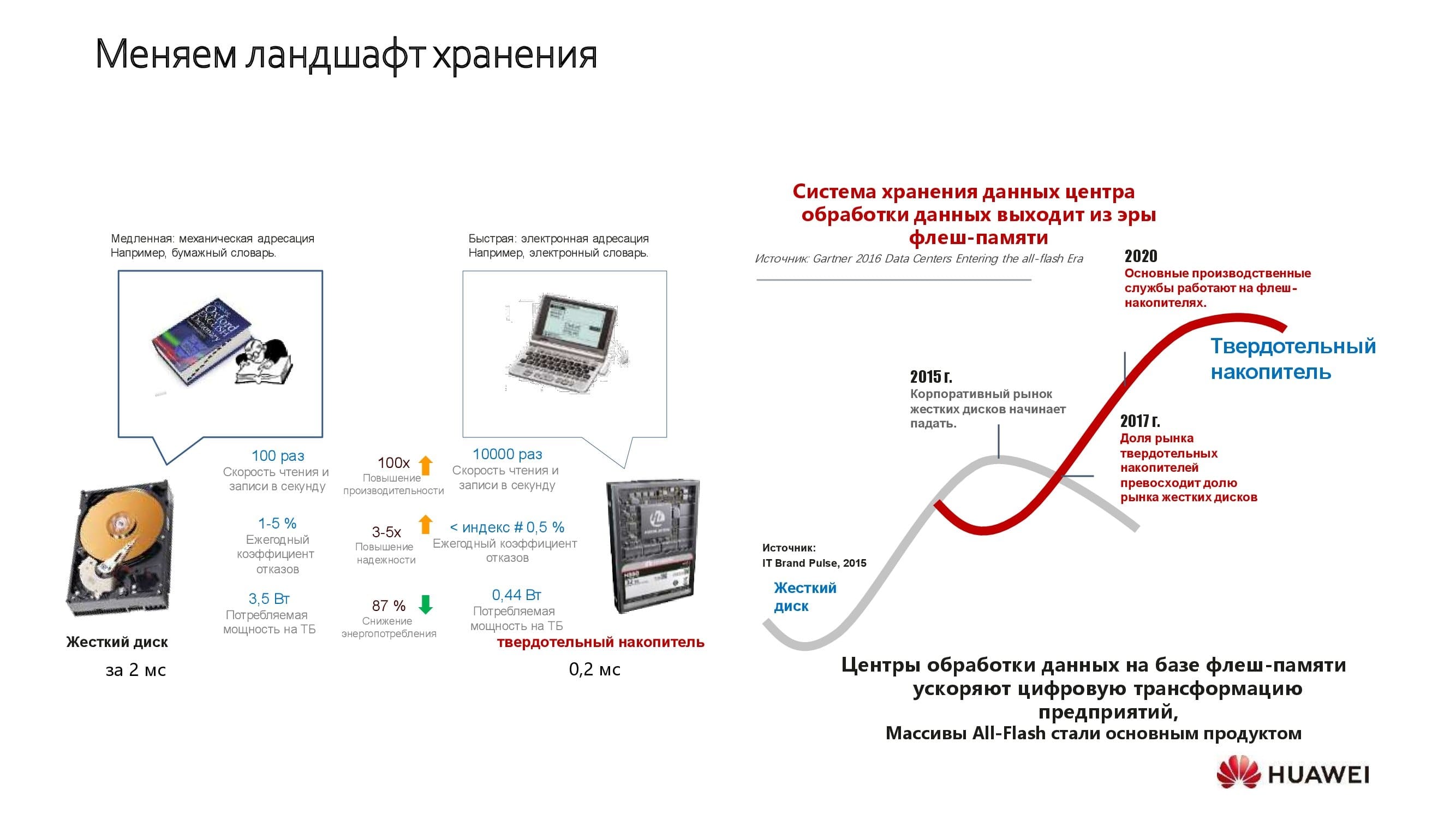

Il y a quelques années à peine, les technologies de stockage SSD sont devenues largement disponibles et les performances du processeur continuent de croître. Avec cela, les nœuds de stockage et de calcul ne sont plus les principales causes de latence. Mais le réseau des centres de données est resté longtemps dans la structure des centres de données comme une sorte de «petit frère».

Les fabricants ont essayé de résoudre le problème de différentes manières. Quelqu'un a choisi les technologies sous licence InfiniBand (IB) pour construire un réseau . Le réseau s'est avéré être spécialisé et capable de résoudre uniquement des tâches à profil restreint. Quelqu'un a préféré construire des usines de réseau en utilisant les protocoles Fibre Channel(FC). Les deux approches avaient leurs limites: soit la bande passante du réseau s'est avérée relativement modeste, soit le coût total de la solution limité, ce qui était encore aggravé par la dépendance à un fournisseur.

Notre entreprise est passée par l'utilisation de technologies ouvertes. Les solutions de Huawei sont basées sur la deuxième version de RoCE , dont les capacités ont été étendues grâce à l'utilisation d'algorithmes sous licence supplémentaires dans nos commutateurs. Cela nous a permis d'optimiser sérieusement les capacités des réseaux.

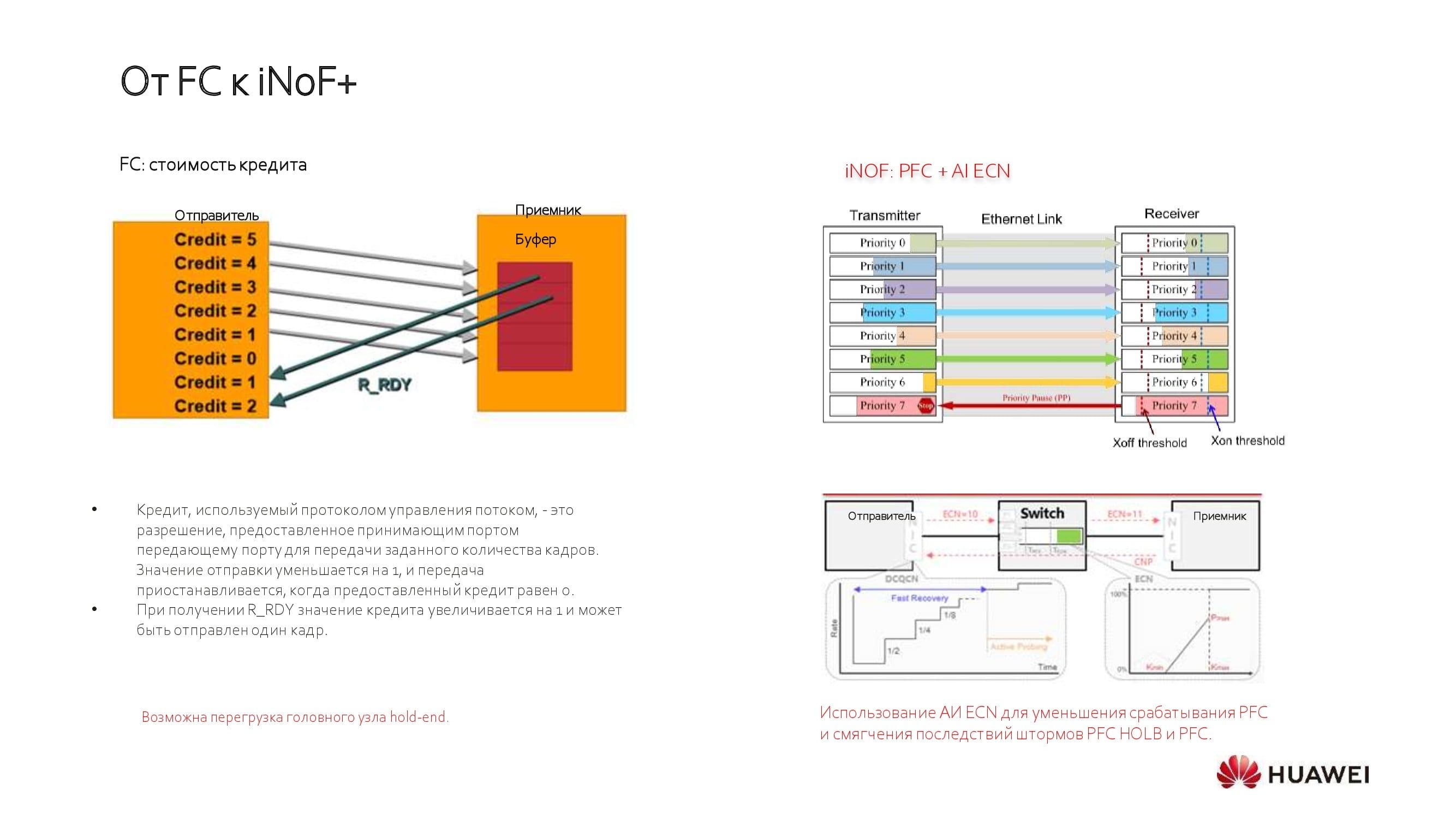

Pourquoi ne voyons-nous pas l'avenir derrière les solutions FC classiques? Le fait est qu'ils fonctionnent sur le principe de l'allocation de crédit statique, ce qui nécessite de régler la structure du réseau pour répondre aux besoins de vos applications pendant une période limitée.

Récemment, FC a fait un pas en avant vers des réseaux de stockage autonomes, mais continue de présenter des limitations de performances. Maintenant le grand public - la sixième génération de la technologie, permettant d'atteindre un débit de 32 Gbps, des solutions de 64 Gbps commencent à être mises en œuvre. Dans le même temps, avec l'aide d'Ethernet, aujourd'hui, en utilisant des tables de priorité, nous pouvons acheminer 100, 200 et même 400 Gbit / s vers le serveur.

La valeur ajoutée du réseau de datacenter est d'une importance particulière dans un monde où les disques SSD avec interfaces à haut débit gagnent de plus en plus de parts de marché, remplaçant les entraînements de broche classiques. Huawei s'est engagé à permettre au stockage SSD d'atteindre son plein potentiel.

Réseau de centres de données de nouvelle génération

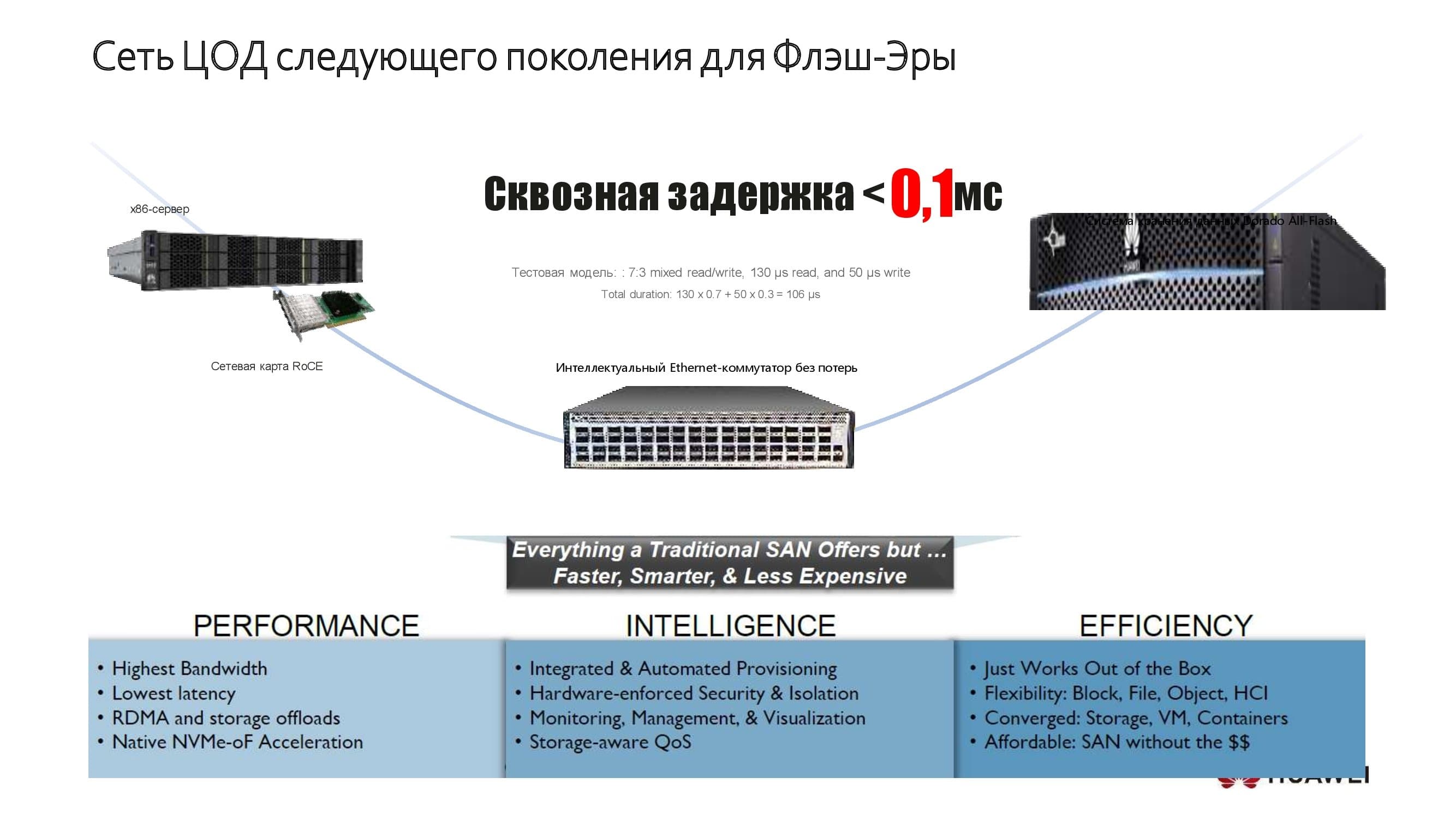

Un petit exemple de la façon dont nous le faisons. Le diagramme montre l'un de nos systèmes de stockage, reconnu comme le plus rapide au monde. Voici nos serveurs x86 ou ARM, offrant des performances qui répondent aux attentes de clients très exigeants. Dans les centres de données, sur la base de ces solutions, nous parvenons à atteindre une latence de bout en bout de 0,1 ms maximum. L'utilisation de nouvelles technologies d'application nous aide à obtenir un tel résultat.

Les technologies classiques utilisées dans les systèmes de stockage étaient limitées, en particulier, par les latences assez élevées provoquées par le bus SAS. Le passage à de nouveaux protocoles tels que NVMe a considérablement amélioré ce paramètre et, en même temps, le réseau lui-même est devenu un facteur limitant des performances.

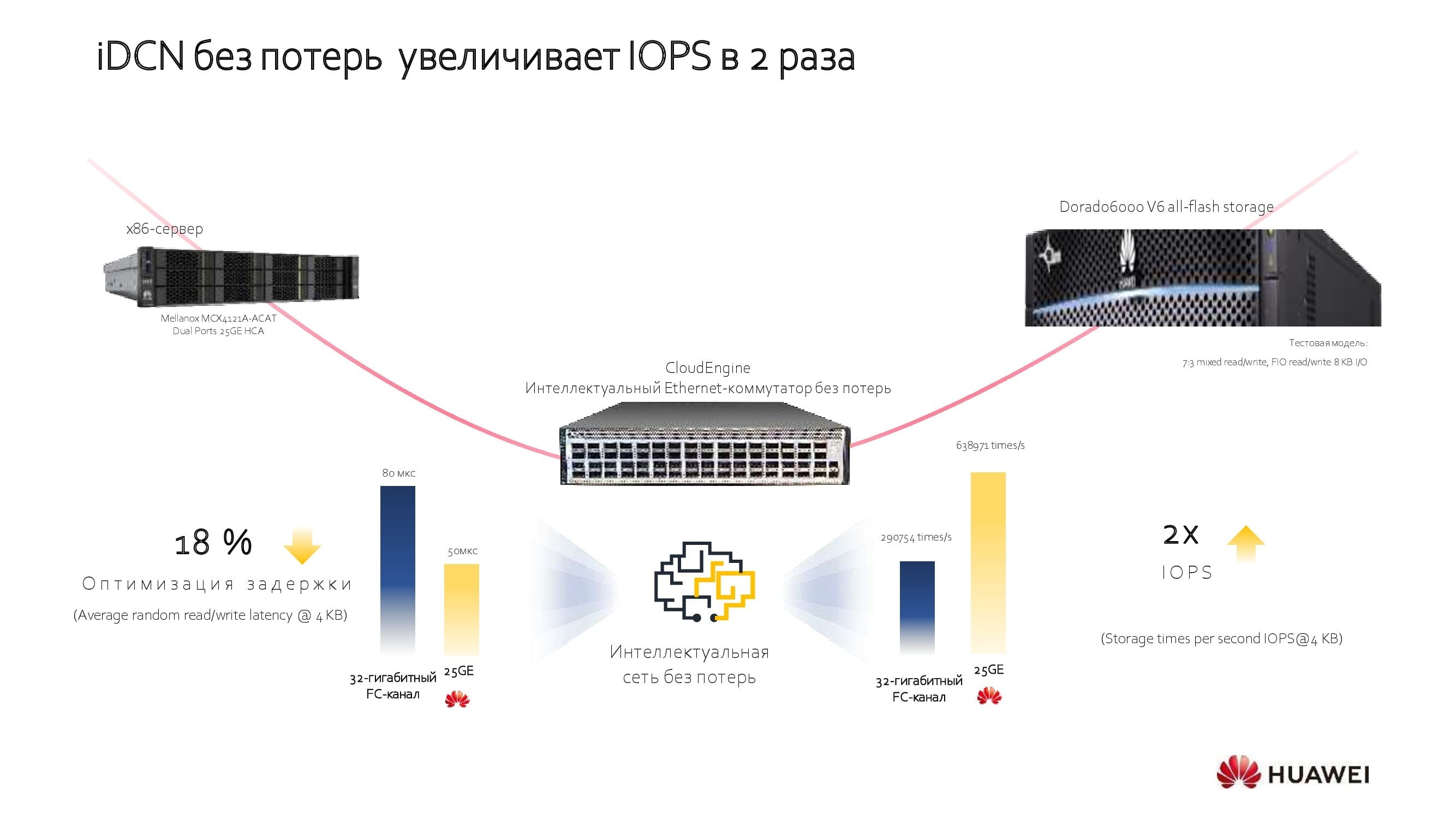

Considérons, dans le même exemple, l'utilisation de réseaux avec des algorithmes sous licence supplémentaires. Ils optimisent la latence de bout en bout, augmentent considérablement le débit du réseau et augmentent les opérations d'E / S par unité de temps. Cette approche permet d'éviter le «double achat», parfois nécessaire pour atteindre les paramètres de performance requis, et les économies totales (en termes de TCO) lors de l'introduction d'un nouveau réseau atteignent 18-40%, selon les équipements utilisés.

Quels sont ces algorithmes wow?

Les technologies conventionnelles ont apporté avec elles les problèmes habituels, puisqu'elles fonctionnaient avec des seuils statiques de la file d'attente. Ce seuil signifiait qu'il existait une relation de base entre la vitesse et la latence pour toutes les applications. Le mode de contrôle manuel ne permettait pas un ajustement dynamique des paramètres du réseau.

En utilisant des chipsets d'apprentissage automatique supplémentaires dans les commutateurs, nous avons appris au réseau à fonctionner dans un mode qui permet de créer des réseaux de centres de données intelligents sans perte de paquets (nous l'avons appelé iDCN ).

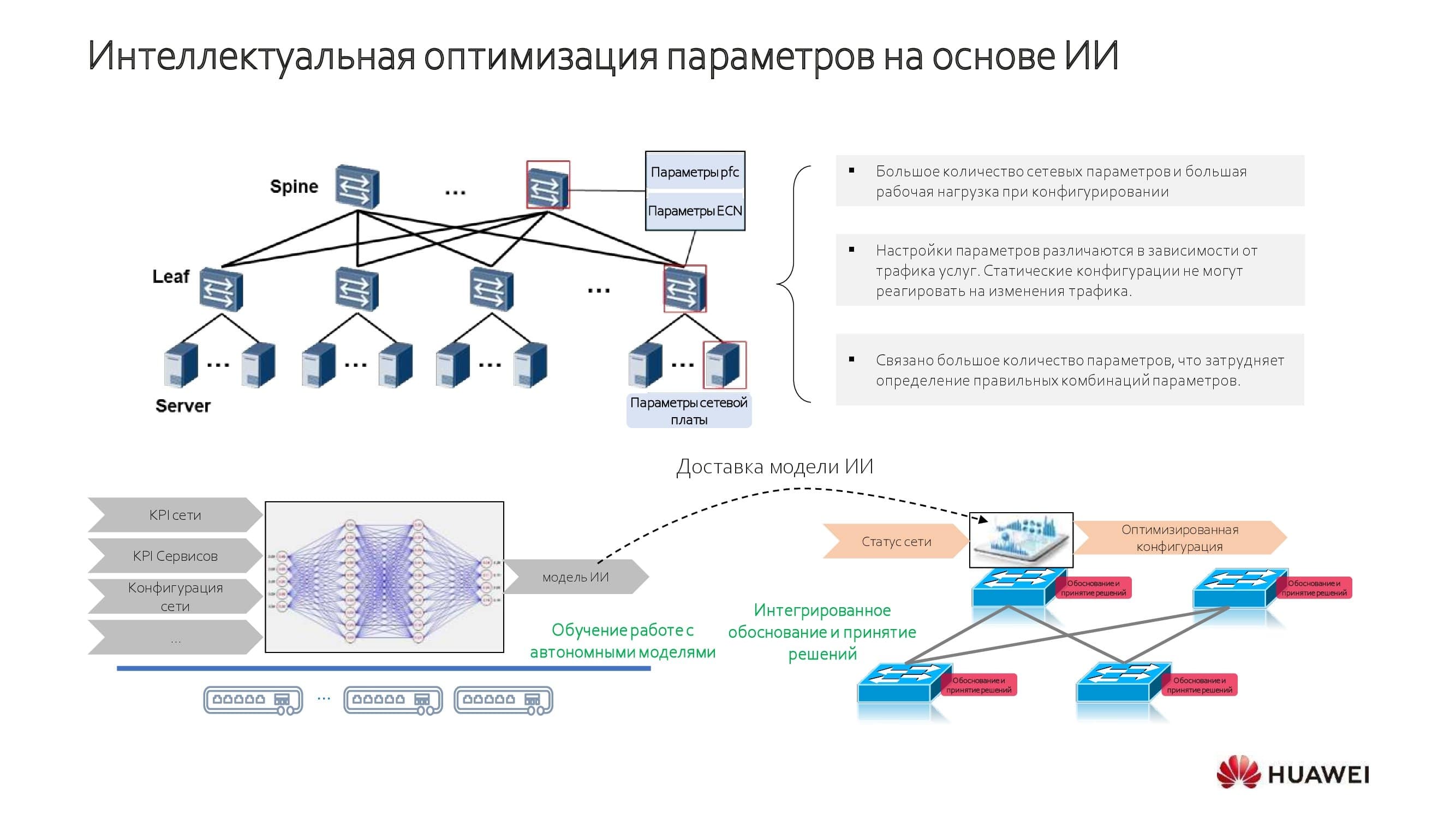

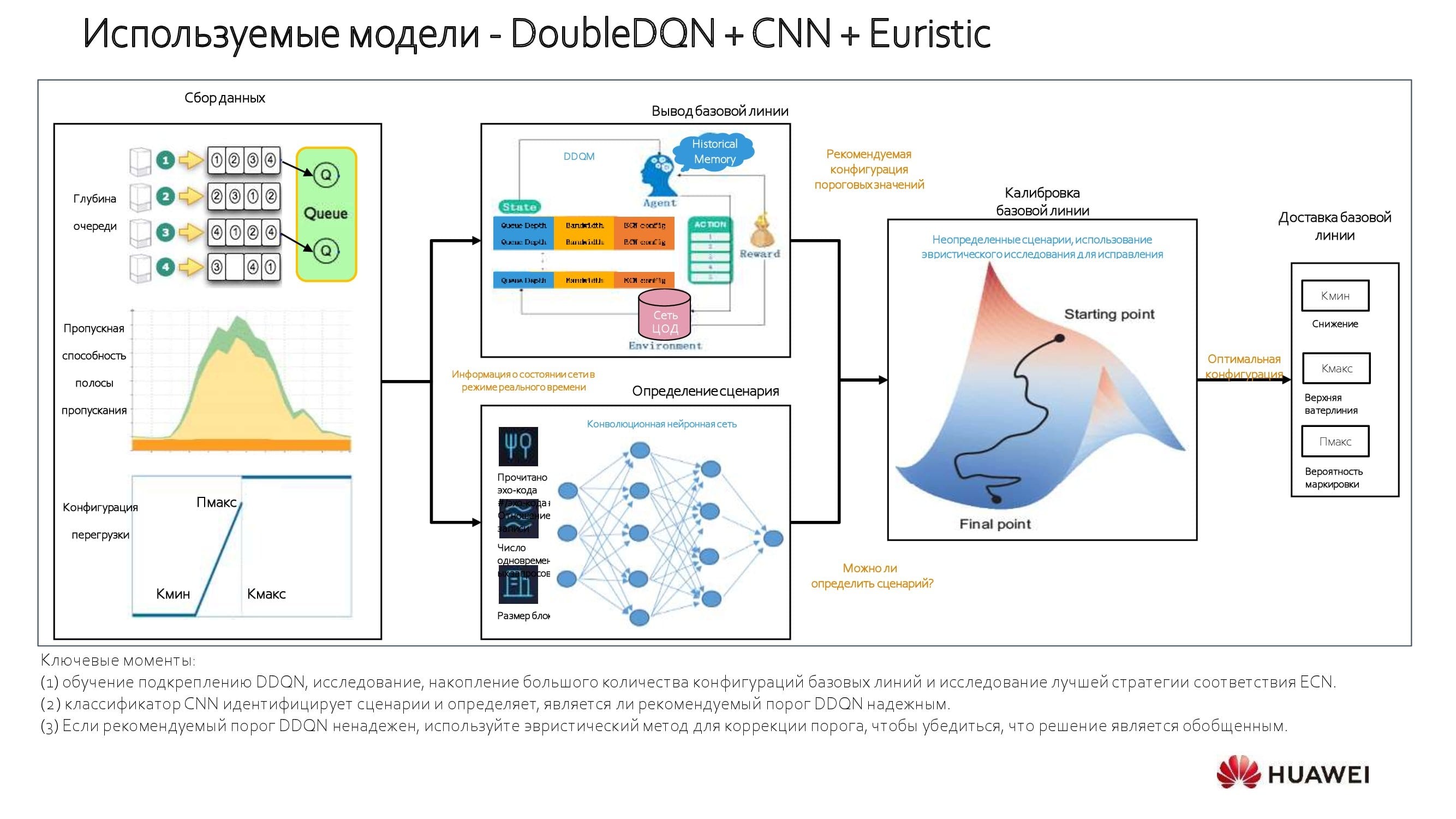

Comment l'optimisation intelligente est-elle réalisée? Ceux qui sont engagés dans des réseaux de neurones trouveront facilement des éléments et des mécanismes d'entraînement / d'inférence familiers sur le diagramme. Nos solutions combinent des modèles embarqués avec la capacité d'apprendre sur un réseau spécifique.

Le système d'IA accumule une certaine quantité de connaissances sur le réseau, qui est ensuite approchée et utilisée dans la configuration dynamique du réseau. Les appareils basés sur nos propres solutions matérielles utilisent une puce AI spéciale. Les modèles construits sur des chipsets sous licence de fabricants américains utilisent un module complémentaire et un bus logiciel.

À propos des modèles utilisés. Nous utilisons une approche qui repose sur un modèle d'apprentissage par renforcement. Le système analyse 100% des données transitant par le périphérique réseau et sélectionne la ligne de base. Si, par exemple, vous connaissez la bande passante et les délais critiques pour une application particulière, il n'est pas difficile de déterminer la ligne de base. Avec un grand nombre d'applications, vous pouvez effectuer des calculs «médians» et effectuer des réglages en mode automatique, améliorant considérablement les performances.

Le diagramme montre le processus plus en détail. Au début de l'optimisation du réseau, nous calculons les valeurs de seuil - minimum et maximum. Vient ensuite le réseau neuronal convolutif(CNN). Ainsi, il est possible d'égaliser la bande passante et les taux de latence pour chaque application, ainsi que de déterminer son "poids" total au sein des services réseau. En utilisant cette approche stratifiée, nous obtenons des informations vraiment intéressantes.

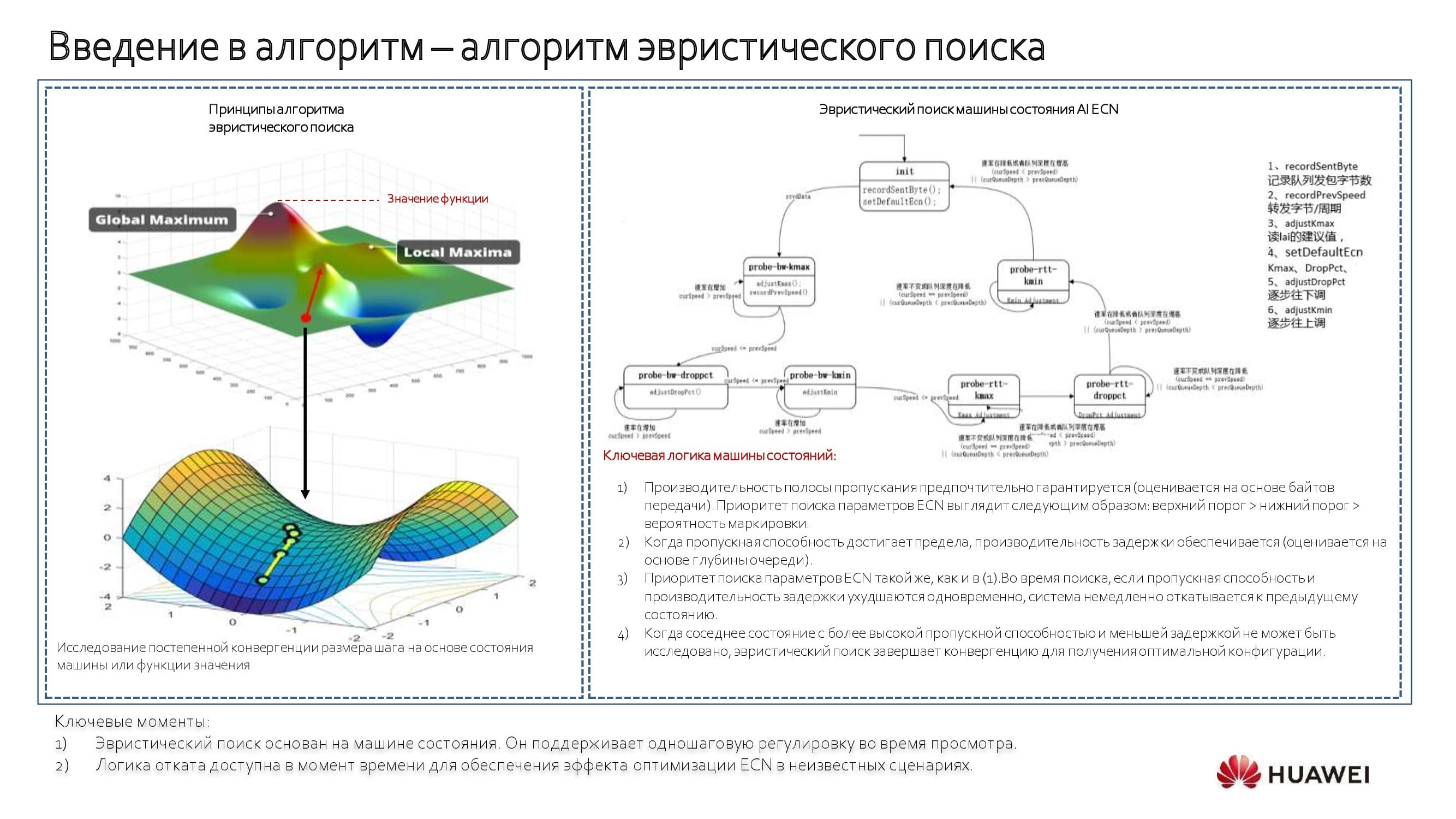

Lorsque l'application est inconnue, un algorithme de recherche heuristique est utilisé en conjonction avec une " machine d'état ". Avec son aide, nous commençons à nous déplacer dans le sens antihoraire le long du diagramme ci-dessus, en identifiant les valeurs de seuil et en construisant un modèle. C'est un processus automatique qui peut être manipulé selon les besoins. Si cela n'est pas nécessaire, il est plus facile de s'appuyer sur le commutateur et ses services.

De la théorie à la pratique

En appliquant de tels algorithmes et en travaillant au niveau de l'ensemble du réseau, et non de ses tranches individuelles, nous résolvons tous les principaux problèmes de performances. Il existe déjà des cas intéressants de mise en œuvre et d'utilisation de telles technologies dans le secteur bancaire. Ces mécanismes sont également demandés dans d'autres secteurs, par exemple parmi les opérateurs de télécommunications.

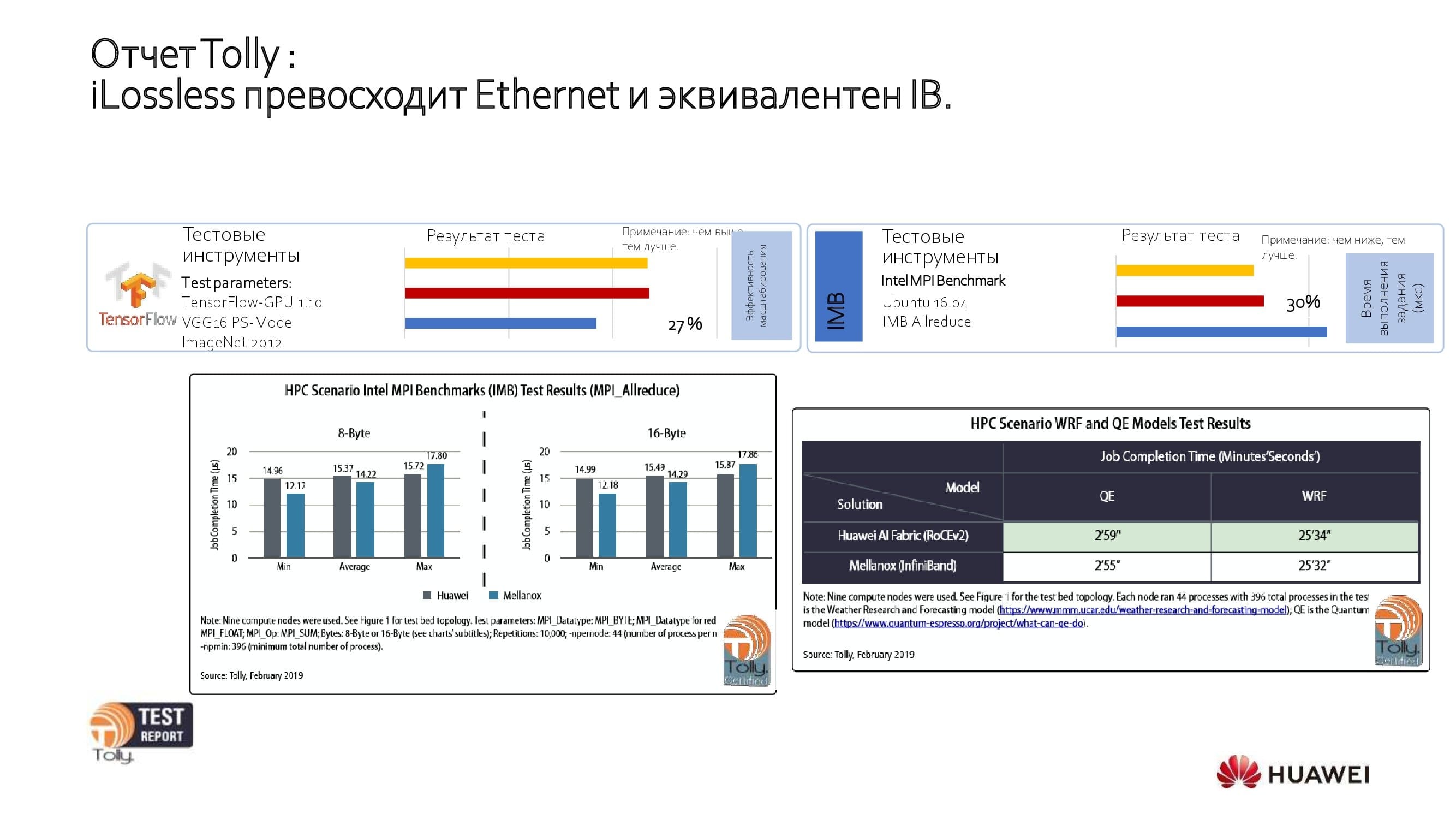

Regardons les résultats des tests ouverts. Le laboratoire indépendant du groupe Tolly a testé notre solution et l'a comparée aux solutions Ethernet et IB d'autres fabricants. Des tests ont montré que les performances des produits Huawei sont équivalentes à celles d'IB et 27% meilleures que celles des autres principaux produits Ethernet.

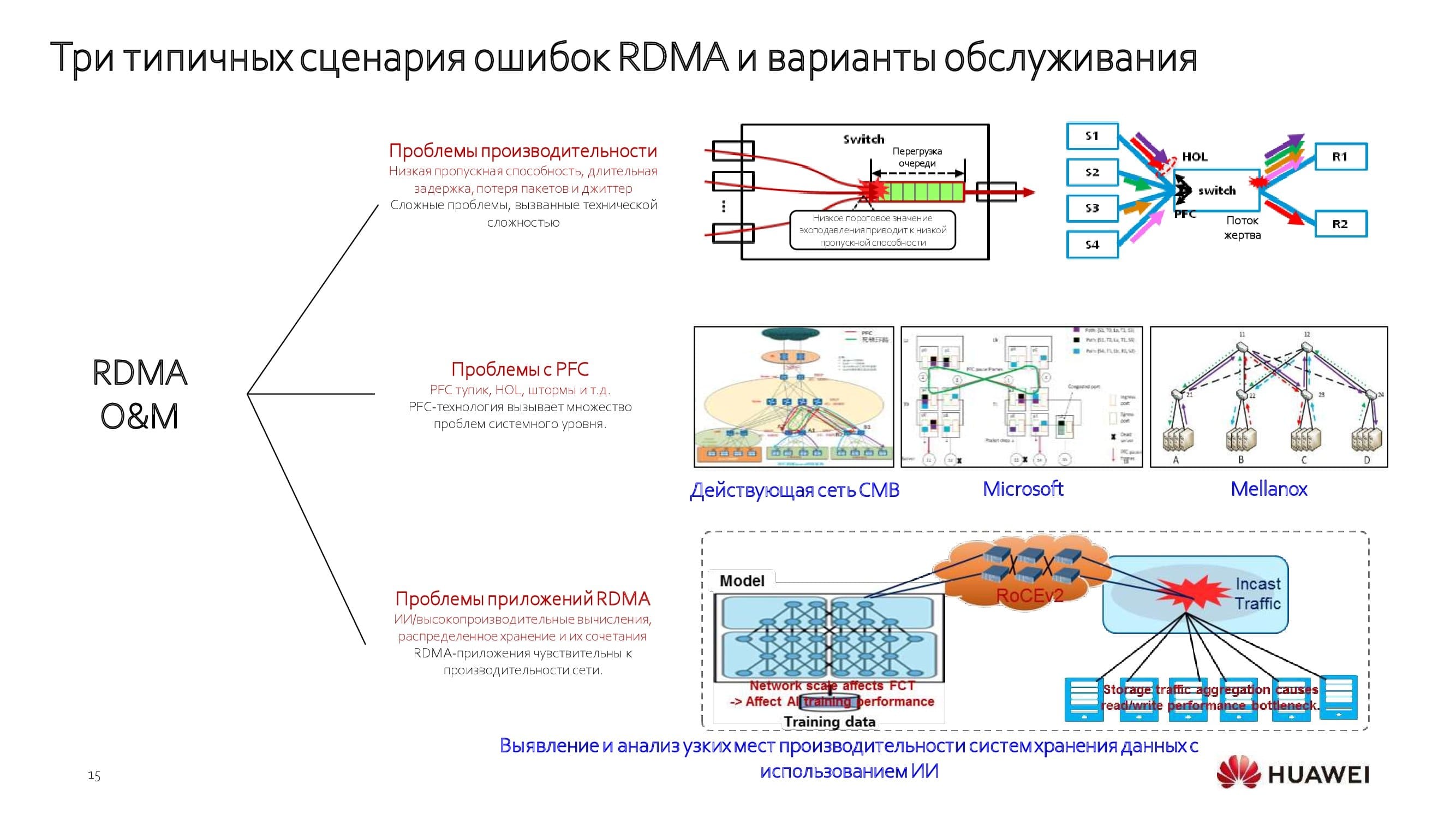

Le «réseau de centre de données sans perte» démontre une efficacité maximale dans plusieurs scénarios, tels que:

- Formation en IA;

- stockage centralisé;

- stockage distribué;

- calcul GPU haute performance.

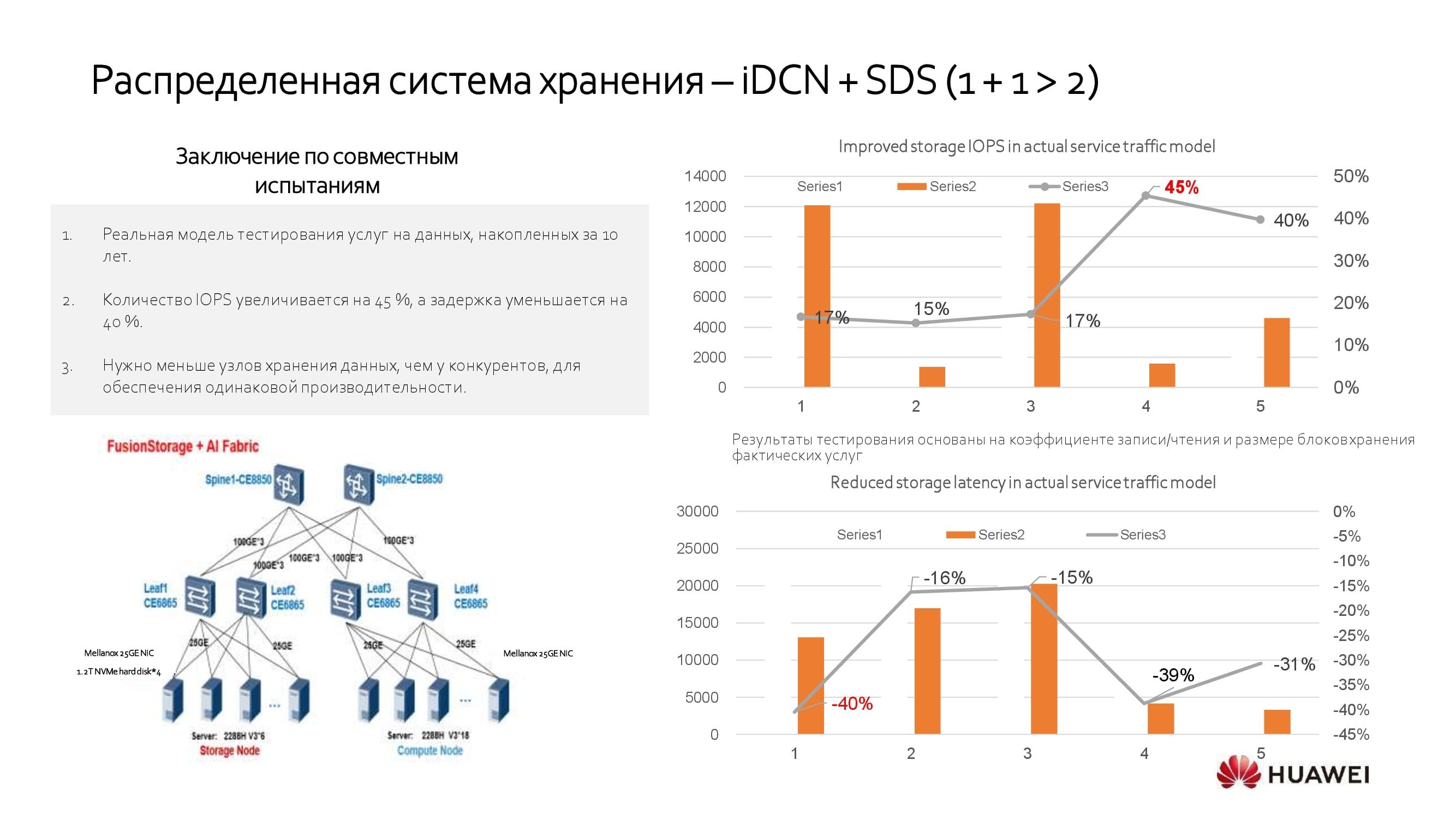

En conclusion, nous examinerons l'un des scénarios d'utilisation d'un réseau de datacenter intelligent. De nombreux clients utilisent des systèmes de stockage distribués (SDS). En intégrant des systèmes de stockage de logiciels de différents fabricants à l'aide de notre solution, vous pouvez obtenir des performances 40% plus élevées que sans elle. Cela signifie que lorsque vous connaissez le niveau de performance requis de votre SDS, il peut être atteint en utilisant 40% de serveurs en moins.

***

En passant, n'oubliez pas nos nombreux webinaires organisés non seulement dans le segment russophone, mais également au niveau mondial. La liste des webinaires de décembre est disponible ici .