assistance de 1000 mots explique que la sur-réflexion est l'ennemi de la créativité et conseille d'être prudent: «Pour faire quelque chose, il se peut que nous ayons besoin de moins réfléchir. Cela semble contre-intuitif, mais je trouve que parfois nos pensées peuvent entraver le processus de création. Parfois, nous pouvons mieux travailler lorsque nous nous «déconnectons» du monde extérieur, en nous concentrant sur ce qui est devant nous. "

Le message a été rédigé par GPT-3, un énorme réseau de neurones Open AI avec 175 milliards de paramètres formés en près d'un demi-billion de mots. Liam Porr, étudiant à l'UC Berkeley, vient d'écrire le titre et de laisser l'algorithme écrire le texte. Une " expérience amusante " pour voir si l'IA peut tromper les gens. En effet, GPT-3 a frappé les nerfs avec ce post atteignant le numéro un sur Hacker News.

Il y a donc un paradoxe avec l'IA d'aujourd'hui. Bien que certains des papiers GPT-3 puissent satisfaire au test de Turing pour convaincre les gens qu'ils sont humains, ils échouent clairement dans les tâches les plus simples. Le chercheur en intelligence artificielle Gary Marcus a demandéGPT-2, le prédécesseur de GPT-3, termine cette phrase:

«Que se passe-t-il lorsque vous mettez du bois de chauffage et des bûches dans la cheminée et que vous lancez ensuite quelques allumettes? Habituellement, cela commencera ... »

« Feu »est ce que tout enfant criera immédiatement. Mais GPT-2 répond: "Ick" L'

expérience a échoué. L'affaire est close?

Matière noire du langage naturel

La communication humaine est un processus d'optimisation. L'orateur minimise le nombre d'énoncés nécessaires pour transmettre ses pensées à l'auditeur. Tout ce qui est négligé s'appelle le bon sens. Et parce que l'auditeur a le même bon sens que l'orateur, il peut donner un sens à l'énoncé.

Ainsi, par définition, le bon sens n'est jamais écrit. Comme l'a souligné Walid Saba, spécialiste de la NLU , nous ne disons pas:

Charles, qui est un jeune adulte vivant qui était aux études supérieures, a abandonné ses études supérieures pour rejoindre une société de logiciels à la recherche d'un nouvel employé.

Nous le disons plus simplement:

Charles a abandonné ses études supérieures pour travailler pour une société de logiciels

et nous supposons que notre interlocuteur sait déjà:

- Vous devez être en vie pour fréquenter l'école ou rejoindre l'entreprise.

- Vous devez être aux études supérieures pour arrêter.

- L'entreprise doit avoir une position ouverte pour la fermer.

Etc. Tous les énoncés humains sont comme ça, ils sont remplis de règles invisibles de bon sens que nous n'énonçons jamais explicitement. Ainsi, le bon sens peut être comparé à la matière noire en physique: elle est invisible, mais constitue l'essentiel.

Alors, comment enseigner aux machines le bon sens artificiel? Comment peuvent-ils savoir que nous lançons une allumette parce que nous voulons allumer un feu?

Bon sens artificiel: la méthode Brute Force

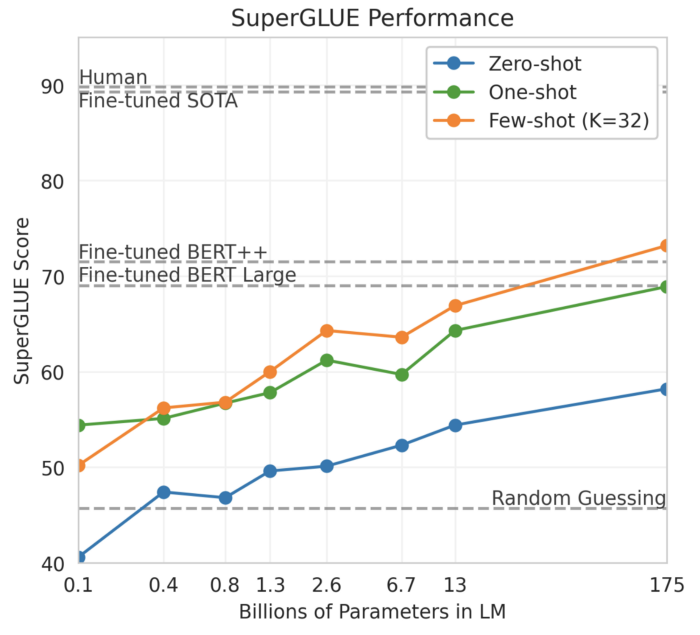

Il y a des raisons de croire que nous pouvons utiliser la force brute dans le sens commun artificiel, et cette raison est la pente de la courbe dans le graphique suivant:

Performances de GPT-3 sur SuperGLUE

Ce graphique du travail GPT-3 " FSL Language Models " montre les performances du modèle SuperGLUE en fonction du nombre de paramètres du modèle, avec le modèle GPT-3 complet à l' extrême droite. SuperGLUE contient des tâches sémantiques assez complexes telles que les schémas de Winograd:

le trophée ne rentre pas dans une valise brune car il est trop petit.

Qu'est-ce qui est trop peu?

La réponse est une valise.

Il est à noter qu'à 175 milliards de paramètres, la courbe continue de croître: le point maximum n'est pas encore atteint. Une hypothèse est donc que nous devrions être en mesure de construire des modèles encore plus grands avec des milliards de paramètres ou plus et que le bon sens artificiel émergera éventuellement. Appelons cette hypothèse l'hypothèse de la «force brute».

Cependant, ce n'est qu'une hypothèse, et nous ne savons pas si c'est réellement vrai ou non. Le contre-argument ici est qu'une machine ne peut tout simplement pas apprendre de quelque chose qui n'est pas explicitement déclaré.

Des règles infinies

Si nous voulons enseigner le bon sens aux machines, pourquoi ne pas simplement tout écrire sous forme de règles et les transmettre ensuite à la machine? C'est exactement ce que Douglas Lenat a entrepris dans les années 1980. Il a embauché des informaticiens et des philosophes pour créer la base de connaissances de bon sens connue aujourd'hui sous le nom de Cyc. Aujourd'hui, Cyc contient 15 millions de règles, telles que:

1. Une chauve-souris a des ailes.

2. Puisqu'elle a des ailes, la chauve-souris peut voler.

3. Puisque la chauve-souris peut voler, elle peut voyager d'un endroit à l'autre.

Le problème avec un système codé en dur comme Cyc est que les règles sont infinies: pour chaque règle, il y a une exception, une exception à une exception, etc. Puisqu'une chauve-souris a des ailes, elle peut voler, à moins qu'elle ne casse son aile. Cette boucle sans fin rend l'ensemble de règles de plus en plus complexe, rendant plus difficile pour les humains de maintenir la mémoire d'une machine, et pour les machines de la maintenir.

Il n'est donc pas surprenant que malgré des décennies d'efforts, Cyc ne fonctionne toujours pas et pourrait ne jamais fonctionner. Le professeur de l'Université de Washington, Pedro Domingos, qualifie Cyc de "plus grand échec de l'histoire de l'intelligence artificielle". Oren Etzioni, PDG de l'Allen Institute for Artificial Intelligence, un autre critique, a fait remarquer dans une interview avec Wired: "Si cela fonctionnait, les gens sauraient que cela fonctionne."

Résumons. Pour une «vraie» IA, nous devons créer du bon sens artificiel. Mais il existe des arguments convaincants contre l'hypothèse de la force brute. D'un autre côté, il existe des arguments convaincants contre les règles codées en dur. Et si nous combinions le meilleur dans ces approches?

Approche hybride

Rencontrez COMET , un modèle basé sur un transformateur développé par le professeur de l'Université de Washington Yejin Choi et ses collaborateurs. L'essence du modèle est qu'il apprend sur la base de connaissances «germe» du bon sens, puis élargit cette base, générant de nouvelles règles basées sur chaque nouvelle déclaration. Ainsi, COMET est un moyen de "charger" du bon sens artificiel. Dans leur article, les chercheurs écrivent que COMET "fournit souvent de nouvelles connaissances de bon sens que les évaluateurs jugent correctes".

En guise de test, j'ai tapé le texte: "Gary met du bois de chauffage et des bûches dans la cheminée, puis lance quelques correspondances" dans l' API COMET , et voici une partie du graphique de sortie:

Certains des graphiques déduits de COMET du bon sens de COMET

concluent correctement que Gary * voulait * allumer le feu. Le système indique également que "Gary se réchauffe en conséquence". À mon avis, cela sonne beaucoup mieux que la réponse GPT-3 à la même demande.

Alors, COMET est-il une solution au problème du bon sens artificiel? Cela reste à voir. Si, par exemple, COMET atteint des performances de niveau humain sur SuperGLUE, ce sera sans aucun doute une percée dans le domaine.

D'un autre côté, les critiques pourraient soutenir que le bon sens ne peut pas être mesuré avec des ensembles de données de référence artificielles. Il existe un risque qu'après avoir créé un tel ensemble de données de référence, les chercheurs commencent à un moment donné à recycler le modèle, rendant le résultat de référence dénué de sens. Une ligne de pensée consiste à tester l'IA avec les mêmes tests d'intelligence que les humains. Par exemple, les chercheurs Stellan Olsson et le personnel de l'Université de l'Illinois à Chicago suggèrent de tester le bon sens artificiel en utilisant des tests de QI sur de jeunes enfants.

Ne laissez pas l'IA d'aujourd'hui vous tromper

Enfin, ne laissez pas l'IA d'aujourd'hui vous tromper. En repensant à l'article GPT-3, je comprends que bon nombre de ses déclarations sont superficielles et généralisées, comme dans le cookie de fortune:

Il est important de rester ouvert d'esprit et d'essayer de nouvelles choses.

Et cette superficialité est probablement la raison pour laquelle tant de gens peuvent être trompés. Après tout, la superficialité cache un manque de vraie compréhension.

- Formation aux métiers de la Data Science

- Formation d'analyste de données

- Cours d'apprentissage automatique

Autres professions et cours

- Java-

- Frontend-

- -

- C++

- Unity

- iOS-

- Android-

- «Machine Learning Pro + Deep Learning»

- «Python -»

- JavaScript

- « Machine Learning Data Science»

- DevOps