Lorsque vous travaillez avec du Big Data, les erreurs ne peuvent pas être évitées. Vous devez aller au fond des données, prioriser, optimiser, visualiser les données, obtenir les bonnes idées. Selon les enquêtes , 85% des entreprises s'efforcent de gérer leurs données, mais seulement 37% déclarent réussir dans ce domaine. En pratique, étudier les expériences négatives est difficile, car personne n'aime parler d'échecs. Les analystes seront heureux de parler de succès, mais dès qu'il s'agit d'erreurs, soyez prêts à entendre parler d '«accumulation de bruit», de «fausse corrélation» et d' «endogénéité aléatoire», et sans aucun détail. Les problèmes du Big Data sont-ils vraiment théoriques?

Aujourd'hui, nous explorerons l'expérience de vraies erreurs qui ont un impact tangible sur les utilisateurs et les analystes.

Erreurs d'échantillonnage

Dans l'article « Big data: une grosse erreur? »Se souvient d'une histoire intéressante avec une startup Street Bump. L'entreprise a invité les habitants de Boston à surveiller l'état de la chaussée à l'aide d'une application mobile. Le logiciel a enregistré la position du smartphone et les écarts anormaux par rapport à la norme: fosses, bosses, nids de poule, etc. Les données reçues ont été transmises en temps réel au destinataire souhaité aux services municipaux.

Cependant, à un moment donné, le bureau du maire a remarqué qu'il y avait beaucoup plus de plaintes des régions riches que des pauvres. Une analyse de la situation a montré que les résidents aisés avaient des téléphones avec une connexion permanente à Internet, conduisaient plus souvent et étaient des utilisateurs actifs de diverses applications, y compris Street Bump.

En conséquence, l'objet principal de l'étude était un événement dans l'application, mais une unité d'intérêt statistiquement significative était censée être une personne utilisant un appareil mobile. Compte tenu de la démographie des utilisateurs de smartphones (à l'époque, il s'agissait principalement d'Américains blancs à revenu moyen et élevé), il est devenu clair à quel point les données se sont avérées peu fiables.

Le problème du biais involontaire erre d'une étude à l'autre depuis des décennies: il y aura toujours des gens qui utiliseront plus activement les réseaux sociaux, les applications ou les hashtags que d'autres. Les données elles-mêmes ne suffisent pas - la qualité est d'une importance primordiale. De la même manière que les questionnaires influencent les résultats des enquêtes, les plates-formes électroniques utilisées pour collecter des données déforment les résultats de la recherche en influençant le comportement des gens lorsqu'ils travaillent avec ces plates-formes.

Selon les auteurs de l' étude «Review of Selectivity Processing Methods in Big Data Sources», il existe de nombreuses sources de Big Data qui ne sont pas destinées à une analyse statistique précise - enquêtes Internet, pages vues sur Twitter et Wikipédia, Google Trends, analyse de fréquence de hashtag, etc.

L'une des erreurs les plus flagrantes de ce type est de prédire la victoire d'Hillary Clinton à l'élection présidentielle américaine de 2016. Selon un sondage Reuters / Ipsos publié quelques heures avant le début du vote, Clinton avait 90% de chances de gagner. Les chercheurs suggèrent que sur le plan méthodologique, l'enquête elle-même aurait pu être menée sans problème, mais la base, composée de 15000 personnes dans 50 États, s'est comportée de manière irrationnelle - très probablement, beaucoup n'ont tout simplement pas admis qu'ils voulaient voter pour Trump.

Erreurs de corrélation

Des corrélations incompréhensibles et des relations causales déroutantes déroutent souvent le data scientist novice. Le résultat est des modèles sans faille en termes de mathématiques et totalement non viables en réalité.

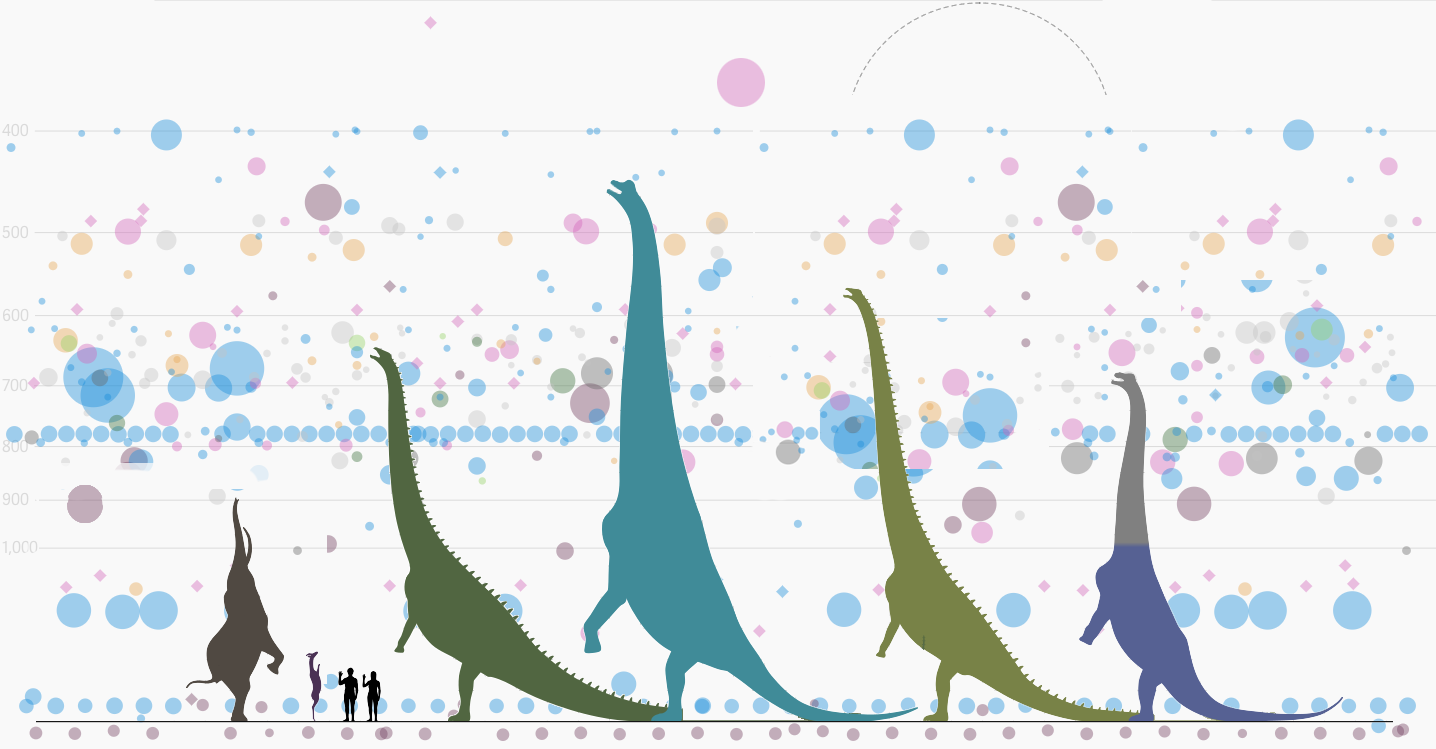

Le graphique ci-dessus montre le nombre total d'observations d'OVNIS depuis 1963. Le nombre de cas signalés à partir de la base de données du National UFO Reporting Center est resté à peu près le même pendant de nombreuses années, mais en 1993, il y a eu une forte augmentation.

Ainsi, nous pouvons tirer une conclusion tout à fait logique qu'il y a 27 ans, les extraterrestres se sont sérieusement lancés dans l'étude des terriens. La vraie raison était que le premier épisode de The X-Files est sorti en septembre 1993 (à son apogée, il était regardé par plus de 25 millions de personnes aux États-Unis).

Jetez maintenant un œil aux données qui montrent la fréquence des observations d'OVNI en fonction de l'heure et du jour de la semaine: la fréquence la plus élevée des observations est de couleur jaune-orange. De toute évidence, les extraterrestres débarquent sur Terre plus souvent le week-end car ils vont travailler le reste du temps. Alors, rechercher des gens est un passe-temps pour eux?

Ces corrélations hilarantes ont des implications profondes. Par exemple, une étude sur l'accès à l'impression dans les communautés à faible revenu a révélé que les écoliers ayant accès à plus de livres recevaient de meilleures notes. Guidées par les données des travaux scientifiques, les autorités de Philadelphie (USA) ont commencé à réorganiser le système éducatif.

Le projet de cinq ans comprenait la conversion de 32 bibliothèques pour offrir une chance égale à tous les enfants et familles de Philadelphie. À première vue, le plan avait l'air super, mais malheureusement, l'étude n'a pas tenu compte du fait que les enfants lisent réellement les livres - elle a seulement examiné la question de savoir si les livres sont disponibles ou non.

En conséquence, aucun résultat significatif n'a été obtenu. Les enfants qui n'avaient pas lu de livres avant l'étude ne sont pas tombés soudainement amoureux de la lecture. La ville a perdu des millions de dollars, les notes des écoliers des zones défavorisées ne se sont pas améliorées et les enfants élevés par l'amour des livres ont continué à apprendre comme eux.

Perte de données

( c )

Parfois, l'échantillon peut être correct, mais les auteurs perdent simplement les données dont ils ont besoin pour analyser. Cela s'est produit dans un ouvrage largement diffusé dans le monde sous le nom de "Freakonomics". Le livre, dont le tirage total dépasse 4 millions d'exemplaires, explore le phénomène de l'émergence de relations de cause à effet non évidentes. Par exemple, parmi les idées très médiatisées du livre, il y a l'idée que la raison de la baisse de la criminalité chez les adolescents aux États-Unis n'était pas la croissance de l'économie et de la culture, mais la légalisation de l'avortement.

Les auteurs de "Freakonomics", professeur d'économie à l'Université de Chicago Stephen Levitt et journaliste Stephen Dubner, ont admis quelques années plus tardque tous les chiffres collectés n'ont pas été inclus dans l'enquête finale sur l'avortement, car les données ont tout simplement disparu. Levitt a expliqué l'erreur de calcul méthodologique par le fait qu'à ce moment-là "ils étaient très fatigués", et a évoqué l'insignifiance statistique de ces données pour la conclusion générale de l'étude.

La question de savoir si l'avortement réduit réellement le nombre de crimes futurs est encore discutable. Cependant, les auteurs ont remarqué de nombreuses autres erreurs, et certaines d'entre elles sont étonnamment similaires à la situation avec la popularité de l'ufologie dans les années 1990.

Erreurs d'analyse

( c ) La

biotechnologie est devenue un nouveau rock and roll pour les entrepreneurs technologiques. Il est également appelé le «nouveau marché informatique» et même le «nouveau monde de la cryptographie», en référence à la popularité explosive parmi les investisseurs des entreprises impliquées dans le traitement de l'information biomédicale.

La question de savoir si les données sur les biomarqueurs et les cultures cellulaires sont une «nouvelle huile» est une question secondaire. Les conséquences de l'injection d'argent rapide dans l'industrie sont intéressantes. Après tout, la biotechnologie peut non seulement constituer une menace pour les portefeuilles VC, mais aussi affecter directement la santé humaine.

Par exemple, comme le souligneGénéticien Stephen Lipkin, le génome a la capacité de faire des analyses de haute qualité, mais les informations de contrôle de qualité sont souvent interdites aux médecins et aux patients. Parfois, avant de commander un test, vous ne savez peut-être pas à l'avance la profondeur de votre couverture de séquençage. Lorsqu'un gène n'est pas lu suffisamment de fois pour une couverture adéquate, le logiciel trouve la mutation là où il n'y en a pas. Souvent, nous ne savons pas quel algorithme est utilisé pour classer les allèles géniques en allèles bénéfiques et nocifs.

Il y a un grandle nombre d'articles scientifiques dans le domaine de la génétique contenant des erreurs. Une équipe de chercheurs australiens a analysé environ 3,6 mille articles génétiques publiés dans un certain nombre de revues scientifiques de premier plan. En conséquence, il a été constaté qu'environ une œuvre sur cinq incluait des gènes d'erreur dans leurs listes.

La source de ces erreurs est frappante: au lieu d'utiliser des langages spéciaux pour le traitement statistique des données, les scientifiques ont résumé toutes les données dans une feuille de calcul Excel. Excel a automatiquement converti les noms de gènes en dates calendaires ou en nombres aléatoires. Il est tout simplement impossible de revérifier manuellement des milliers et des milliers de lignes.

Dans la littérature scientifique, les gènes sont souvent désignés par des symboles: par exemple, le gène Septin-2 est abrégé en SEPT2 et le doigt en anneau associé à la membrane (C3HC4) 1 - en MARCH1. Excel a utilisé les paramètres par défaut pour remplacer ces chaînes par des dates. Les chercheurs ont noté qu'ils n'avaient pas été les pionniers du problème - cela avait été souligné il y a plus de dix ans.

Dans un autre cas, Excel a porté un coup dur à l'économie. Les célèbres économistes de l'Université de Harvard Carmen Reinhart et Kenneth Rogoff ont analysé 3700 cas différents d'augmentation de la dette publique et son impact sur la croissance économique dans 42 pays sur 200 ans dans leurs travaux de recherche.

L'ouvrage «Croissance sur la durée de la dette» a indiqué sans équivoque qu'avec un niveau de dette publique inférieur à 90% du PIB, cela n'affectait pratiquement pas la croissance économique. Si la dette nationale dépasse 90% du PIB, le taux de croissance médian baisse de 1%.

L'étude a eu un impact énorme sur la façon dont le monde a fait face à la dernière crise économique. Le travail a été largement cité pour justifier des coupes budgétaires aux États-Unis et en Europe.

Cependant, quelques années plus tard, Thomas Herndorn, Michael Ash et Robert Pollin de l'Université du Massachusetts, après avoir analysé point par point les travaux de Rogoff et Reinhart, ont révélé des inexactitudes banales lors de l'utilisation d'Excel. Les statistiques, en fait, ne montrent aucune relation entre la croissance du PIB et la dette publique.

Conclusion: les corrections de bogues comme source de bogues

( c )

Compte tenu de la grande quantité d'informations à analyser, certaines idées fausses surgissent simplement parce que c'est la nature des choses. Si les erreurs sont rares et proches du hasard, les conclusions de l'analyse finale peuvent ne pas en souffrir. Dans certains cas, il est inutile de les traiter, car la lutte contre les erreurs de collecte de données peut conduire à de nouvelles erreurs.

Le célèbre statisticien Edward Deming a formulé la description de ce paradoxe comme suit: mettre en place un processus stable pour compenser les petits écarts disponibles afin d'obtenir les meilleurs résultats peut conduire à des résultats moins bons que s'il n'y avait pas d'intervention dans le processus.

Pour illustrer les problèmes de sur-correction des données, nous utilisons la simulation des corrections dans le processus de chute accidentelle de balles dans un entonnoir. Le processus peut être ajusté à l'aide de plusieurs règles dont le principal objectif est de fournir une opportunité de se rapprocher le plus possible du centre de l'entonnoir. Cependant, plus vous respectez les règles, plus les résultats seront frustrants.

Le moyen le plus simple d'expérimenter un entonnoir est en ligne, pour lequel un simulateur a été créé . Écrivez dans les commentaires les résultats que vous avez obtenus.

Nous pouvons vous apprendre à analyser correctement le Big Data à la MADE Academy , un projet éducatif gratuit du groupe Mail.ru. Nous acceptons les demandes de formation jusqu'au 1er août inclus.