50 ans d'histoire des cartes vidéo (1970-2020): une histoire complète des cartes vidéo et de leurs géniteurs

Partie 1

Infographie. En entendant ces mots, nous présentons des effets spéciaux époustouflants de grands blockbusters, de magnifiques modèles de personnages de jeux AAA et tout ce qui a à voir avec la beauté visuelle de la technologie moderne. Mais l'infographie, comme tout aspect technologique, se développe depuis plus d'une décennie, ayant surmonté le chemin de l'affichage de plusieurs personnages sur un écran monochrome à des paysages et des héros étonnants, chaque année de plus en plus difficile à distinguer de la réalité. Aujourd'hui, nous allons commencer une histoire sur la façon dont l'histoire de l'infographie a commencé, rappelez-vous comment le terme «carte vidéo» et l'abréviation de GPU sont apparus, et quelles limites techniques les leaders du marché ont surmontées année après année dans le but de conquérir un nouveau public.

Avant-propos de l'époque. La naissance de l'informatique (années 40/50)

L'ère de la technologie informatique, beaucoup associent avec le début de l'ère des ordinateurs personnels au début des années 80, mais en fait, les premiers ordinateurs sont apparus beaucoup plus tôt. Le premier développement de telles machines a commencé avant même la Seconde Guerre mondiale, et des prototypes, ressemblant vaguement à de futurs PC, ont été lancés dès 1947. Le premier appareil de ce type était l'IBM 610, un ordinateur expérimental développé par John Lenz du laboratoire Watson de l'Université de Columbia. Ce fut le premier de l'histoire à recevoir le fier nom de «Personal Automatic Computer» (PAC), bien que légèrement exagéré - la machine coûtait 55 000 $, et seulement 150 copies furent réalisées.

Les premiers systèmes visuels impressionnants sont apparus dans les mêmes années. Déjà en 1951, IBM, avec la participation de General Electric et d'un certain nombre d'entrepreneurs militaires, a développé un simulateur de vol pour les besoins de l'armée. Il utilisait la technologie de la virtualisation tridimensionnelle - le pilote, qui était derrière le simulateur, voyait la projection du cockpit et pouvait agir comme il le ferait aux commandes d'un avion réel. Plus tard, le prototype graphique a été utilisé par Evans & Sutherland, qui a créé un simulateur pilote CT5 à part entière, basé sur un ensemble d'ordinateurs DEC PDP-11. Pensez-y, nous sommes toujours dans les années 50 et nous avions déjà des graphismes en trois dimensions!

1971-1972. Magnavox Odyssey et PONG

Le boom de la technologie des semi-conducteurs et de la fabrication de microcircuits a complètement changé l'équilibre du pouvoir sur le marché, anciennement détenu par de gros ordinateurs analogiques qui occupaient des halls entiers. S'éloignant des tubes à vide et des cartes perforées, l'industrie est entrée dans l'ère du divertissement familial, introduisant le monde occidental aux «systèmes de jeux vidéo domestiques», les arrière-grands-mères des consoles modernes.

Un pionnier du divertissement de jeu vidéo était un appareil appelé Odyssey Magnavox, le premier système de jeu officiellement lancé. L'Odyssey avait des contrôleurs bizarres selon les normes modernes, et l'ensemble du système graphique n'affichait qu'une ligne et deux points sur l'écran du téléviseur, qui étaient contrôlés par les joueurs. Les créateurs de l'appareil ont abordé la question avec imagination, et la console est venue avec des superpositions colorées spéciales sur l'écran qui pourraient «peindre» les mondes de jeu de plusieurs projets qui viennent avec Odyssey. Un total de 28 jeux ont été publiés pour l'appareil, parmi lesquels un ping-pong apparemment simple, qui a inspiré les passionnés de la jeune société Atari à sortir une machine à sous appelée Pong avec un jeu identique. C'est Pong qui est devenu le début de la magie des machines à sous, qui, soit dit en passant, ont complètement capturé le Japon et le monde occidental au début des années 80.

Malgré leur simplicité évidente, le Magnavox Odyssey utilisait de vraies cartouches - mais à bien des égards uniquement pour l'effet. Il n'y avait pas de puces de mémoire en eux - les cartouches servaient de jeu de cavaliers, transformant comme par magie un arrangement d'une ligne avec des points en un autre, changeant ainsi la donne. Le décodeur primitif était loin d'être une puce vidéo à part entière, mais la popularité de Magnavox Odyssey montrait un intérêt clair du public, et de nombreuses entreprises ont commencé à développer leurs propres appareils, ressentant le potentiel de profit.

1976-1977. Fairchild Channel F et Atari 2600

Il n'a pas fallu longtemps pour attendre la première bataille sérieuse pour le marché des jeux pour nouveau-nés. En 1975, la Magnavox Odyssey, qui vieillissait rapidement, a disparu des étagères et, à sa place, deux appareils se sont battus pour le titre de la meilleure console de nouvelle génération - Channel F de Fairchild et Atari VCS de la société même qui a donné au monde Pong.

Malgré le fait que le développement des consoles se soit déroulé presque simultanément, Atari n'a pas eu le temps - et Fairchild a été le premier à sortir son appareil appelé Fairchild Video Entertainment System (VES).

La console Fairchild est arrivée dans les rayons des magasins en novembre 1976 et est un trésor de forces techniques. Au lieu de contrôleurs Odyssey indistincts, des contrôleurs pratiques sont apparus, de fausses cartouches ont été remplacées par des vraies (à l'intérieur desquelles se trouvaient des puces ROM avec des données de jeu), et un haut-parleur a été installé à l'intérieur de la console qui reproduisait les sons et la musique d'un jeu en cours d'exécution. La pièce jointe a pu dessiner une image à l'aide d'une palette de 8 couleurs (en mode ligne noir et blanc ou en couleur) avec une résolution de 102x54 pixels. Par ailleurs, il convient de noter que le processeur Fairchild F8 installé dans le système VES a été développé par Robert Noyce, qui a fondé en 1968 une petite mais prometteuse société Intel.

Atari était au bord du désespoir - le projet Stella, base de la future console, était loin derrière dans le rythme du développement, et le marché, comme vous le savez, n'attendra pas. Beaucoup de choses qui semblaient innovantes avec la sortie de Fairchild VES étaient sur le point de faire partie intégrante de toutes les futures consoles. Réalisant que tout est en jeu, le fondateur d'Atari, Nolan Bushnell, signe un accord avec Warner Communications, vendant son idée originale pour 28 millions de dollars à la condition que la console Atari arrive sur le marché le plus tôt possible.

Warner n'a pas déçu et le travail sur la console a commencé à bouillir avec une vigueur renouvelée. Pour simplifier la logique et réduire les coûts de production, le célèbre ingénieur Jay Miner a été impliqué dans le développement, qui a retravaillé la sortie vidéo et le traitement audio des puces TIA (Television Interface Adapter) en un seul élément, qui était la touche finale avant que la console ne soit prête. Pour agacer Fairchild, les spécialistes du marketing d'Atari ont nommé la console VCS (Video Computer System), obligeant le concurrent à renommer Channel F.

Mais cela n'a pas aidé Channel F à concurrencer avec succès le nouveau produit - bien qu'au stade de la sortie de la console en 1977, seuls 9 jeux étaient prêts, les développeurs ont rapidement réalisé le début d'une nouvelle ère technologique et ont commencé à utiliser pleinement la puissance de la console. L'Atari VSC (qui deviendra plus tard l'Atari 2600) fut le premier décodeur basé sur une puce complexe, traitant non seulement la vidéo et l'audio, mais également les commandes reçues du joystick. Les ventes modestes, qui initialement embarrassaient Warner, ont été remplacées par un succès phénoménal après la décision de licence de l'arcade Space Invaders par la société japonaise Taito. Les cartouches, initialement limitées à 4 Ko de mémoire, sont finalement passées à 32 Ko, et le nombre de jeux se comptent par centaines.

Le secret du succès d'Atari réside dans la logique simplifiée au maximum de l'appareil, la capacité des développeurs à programmer de manière flexible des jeux en utilisant 2600 ressources (par exemple, pouvoir changer la couleur du sprite en dessinant), ainsi que l'attrait externe et les contrôleurs pratiques appelés joysticks (du joystick littéral - le bâton du bonheur) ... Donc, si vous ne savez pas d'où vient ce terme, vous pouvez en remercier les développeurs Atari. Ainsi que pour l'image principale de tous les jeux rétro - un extraterrestre drôle de Space Invaders.

Après que le succès de l'Atari 2600 ait dépassé toutes les valeurs prévues, Fairchild a quitté le marché du jeu vidéo, décidant que la direction allait bientôt disparaître. Très probablement, l'entreprise regrette toujours une telle décision.

1981-1986. L'ère du PC IBM.

Malgré le fait que déjà en 1979, Apple a présenté l'Apple II, qui a changé à jamais l'image de l'ordinateur accessible, le concept d '«ordinateur personnel» est apparu un peu plus tard et appartenait à une société complètement différente. IBM monumental, avec des décennies de mainframes encombrants (bruit de bobine et lumières scintillantes) derrière lui, s'est soudainement écarté et a créé un marché qui n'avait jamais existé auparavant.

En 1981, le légendaire IBM PC est mis en vente, précédé par l'une des meilleures campagnes publicitaires de l'histoire du marketing. «Personne n'a jamais été licencié pour avoir acheté IBM», lit-on dans le même slogan qui restera à jamais dans l'histoire de la publicité.

Cependant, ce ne sont pas seulement des slogans et des encarts publicitaires flashy qui ont fait le nom de l'ordinateur personnel IBM. C'est pour lui que, pour la première fois de l'histoire, un système graphique complexe a été développé à partir de deux adaptateurs vidéo - un adaptateur d'affichage monochrome (MDA, adaptateur d'affichage monochrome) et un adaptateur graphique couleur (CGA, adaptateur graphique couleur).

MDA a été conçu pour la saisie avec prise en charge de 80 colonnes et 25 lignes à l'écran pour les caractères ASCII à une résolution de 720 × 350 pixels. L'adaptateur utilisait une mémoire vidéo 4K et affichait du texte vert sur un écran noir. Dans ce mode, il était facile et pratique de travailler avec des équipes, des documents et d'autres tâches quotidiennes du secteur commercial.

Le CGA, en revanche, pourrait être qualifié de percée en termes de capacités graphiques. L'adaptateur prenait en charge une palette de 4 bits dans une résolution de 640x200 pixels, avait 16 Ko de mémoire et formait la base de la norme d'infographie pour la gamme en expansion active d'ordinateurs IBM PC.

Cependant, l'utilisation de deux adaptateurs de sortie vidéo différents présentait de sérieux inconvénients. De nombreux problèmes techniques possibles, le coût élevé des appareils et un certain nombre d'autres limitations ont poussé les passionnés à travailler sur une solution universelle - un adaptateur graphique capable de fonctionner dans deux modes simultanément. Le premier produit de ce type sur le marché était la carte graphique Hercules (HGC), développée par la société éponyme Hercules en 1984.

Carte graphique Hercules (HGC)

Selon la légende, le fondateur de la société Hercules, Van Suwannukul, a développé un système spécifiquement pour travailler sur sa thèse de doctorat dans sa langue thaïlandaise natale. L'adaptateur IBM MDA standard n'a pas rendu correctement la police thaïlandaise, ce qui a incité le développeur à commencer à créer HGC en 1982.

La prise en charge de 720x348 pixels pour le texte et les graphiques, ainsi que la possibilité de travailler en modes MDA et CGA, ont assuré une longue durée de vie à l'adaptateur Hercules. L'héritage de la société sous la forme de normes de sortie vidéo universelles HGC et HGC + a été utilisé par les développeurs d'ordinateurs compatibles IBM et plus tard par un certain nombre d'autres systèmes jusqu'à la fin des années 90. Cependant, le monde ne s'est pas arrêté et le développement rapide de l'industrie informatique (ainsi que de sa partie graphique) a attiré de nombreux autres passionnés - parmi lesquels quatre migrants de Hong Kong - Hwo Yuan Ho, Lee Lau, Francis Lau (Francis Lau) et Benny Lau (Benny Lau), qui ont fondé Array Technology Inc, une entreprise que le monde entier reconnaîtra comme ATI Technologies Inc.

1986-1991. Le premier boom du marché des cartes graphiques. Premiers succès d'ATI

Après la sortie de l'IBM PC, IBM n'est pas resté longtemps à la pointe de la technologie informatique. Déjà en 1984, Steve Jobs a présenté le premier Macintosh avec une interface graphique impressionnante, et il est devenu évident pour beaucoup que la technologie graphique était sur le point de faire un véritable bond en avant. Mais malgré la perte de son leadership dans le secteur, IBM s'est démarqué d'Apple et des autres concurrents dans sa vision. La philosophie d'IBM des normes ouvertes a ouvert la porte à tout appareil compatible, ce qui a attiré de nombreuses startups de son époque sur le terrain.

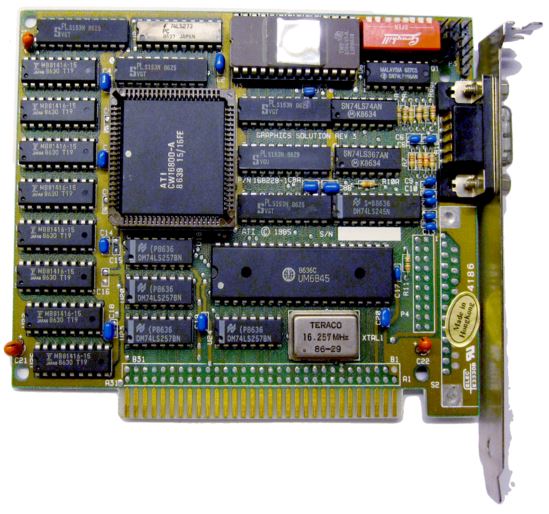

Parmi eux, la jeune société ATI Technologies. En 1986, les spécialistes de Hong Kong ont présenté leur premier produit commercial, la carte d'émulation de couleur OEM.

Carte d'émulation de couleur

En étendant les capacités des contrôleurs monochromes standard, les ingénieurs ATI ont fourni trois couleurs de police sur un écran noir: vert, ambre et blanc. L'adaptateur avait 16 Ko de mémoire et s'est avéré faire partie des ordinateurs Commodore. Au cours de sa première année de ventes, le produit a rapporté à ATI plus de 10 millions de dollars.

Bien sûr, ce n'était que la première étape pour ATI - après la solution graphique étendue avec 64 Ko de mémoire vidéo et la possibilité de fonctionner en trois modes (MDA, CGA, EGA), la ligne ATI Wonder est entrée sur le marché, avec l'avènement de laquelle les normes précédentes pouvaient être écrites dans des archaïsmes. ...

Cela semble trop audacieux? Jugez par vous-même - les adaptateurs de la série Wonder ont reçu une mémoire tampon de 256 Ko de mémoire vidéo (4 fois plus!), Et au lieu d'une palette de quatre couleurs, 16 couleurs étaient affichées à l'écran à une résolution de 640x350. Dans le même temps, il n'y avait aucune restriction lors du travail avec différents formats de sortie - ATI Wonder a émulé avec succès l'un des premiers modes (MDA, CGA, EGA) et, à partir de la 2ème série, il a reçu la prise en charge de la dernière norme Extend EGA.

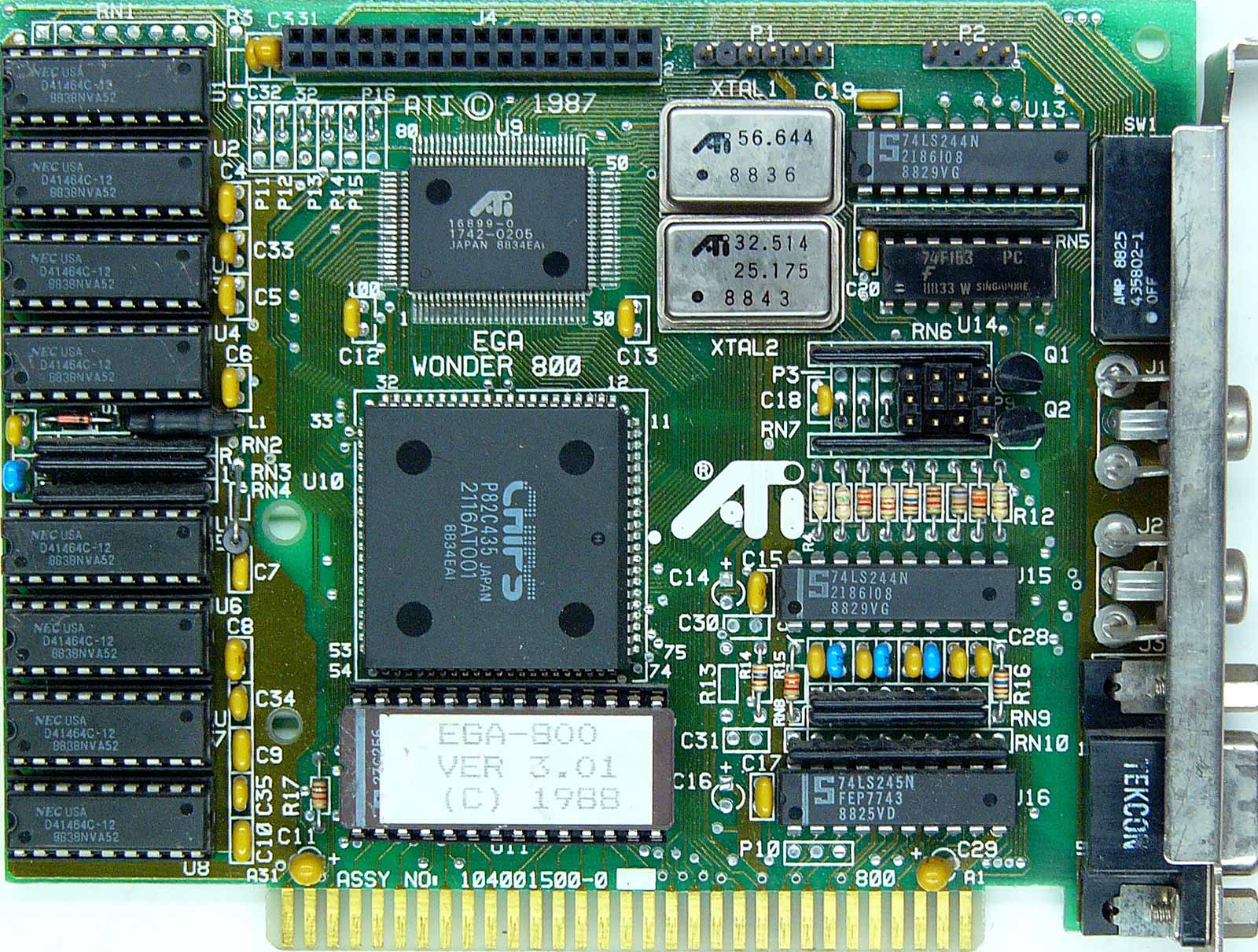

ATi Wonder

Le point culminant du développement de la ligne en 1987 fut le célèbre ATI EGA Wonder 800, qui affichait une palette de 16 couleurs déjà au format VGA dans une résolution incroyablement élevée de 800x600. L'adaptateur a été vendu au format VIP (Enhanced Performance Card) VGA plus abordable avec une prise en charge limitée de la sortie VGA.

Le premier apogée du marché de la carte vidéo. Innovations ATI, le début de la compétition

Le succès significatif d'ATI dans le développement d'adaptateurs graphiques commerciaux a attiré l'attention de nombreuses autres entreprises - de 1986 à 1987, des marques telles que Trident, SiS, Tamarack, Realtek, Oak Technology, LSI (G-2 Inc), Hualon, Cornerstone Imaging et Windbond. En plus de nouveaux visages, les représentants actuels de la Silicon Valley - des sociétés telles que AMD, Western Digital / Paradise Systems, Intergraph, Cirrus Logic, Texas Instruments, Gemini et Genoa - se sont intéressés à entrer sur le marché graphique - chacun d'eux a présenté le premier produit graphique en la même période.

En 1987, ATI est entré sur le marché OEM en tant que fournisseur avec la série de produits Graphics Solution Plus. Cette ligne a été conçue pour fonctionner avec le bus 8 bits des ordinateurs IBM PC / XT basés sur la plate-forme Intel 8086/8088. Les adaptateurs GSP ont également pris en charge les formats de sortie MDA, CGA et EGA, mais avec la commutation d'origine entre eux sur la carte elle-même. L'appareil a été bien accueilli sur le marché, et même un modèle similaire de Paradise Systems avec 256 Ko de mémoire vidéo (le GSP n'avait que 64 Ko) n'a pas empêché Ati d'ajouter un nouveau produit à succès à son portefeuille.

Au cours des prochaines années, l'entreprise canadienne ATI Technologies Inc. est resté au sommet de l'innovation graphique, surpassant constamment la concurrence. La gamme d'adaptateurs Wonder alors bien connue a été la première sur le marché à passer à la couleur 16 bits; a reçu le support pour EVGA (dans les adaptateurs Wonder 480 et Wonder 800+) et SVGA (dans Wonder 16). En 1989, ATI a baissé les prix de la gamme Wonder 16 et a ajouté un connecteur VESA pour la possibilité de connecter deux adaptateurs l'un à l'autre - nous pouvons dire qu'il s'agissait des premiers fantasmes sur les ensembles de plusieurs appareils qui apparaîtront sur le marché beaucoup plus tard.

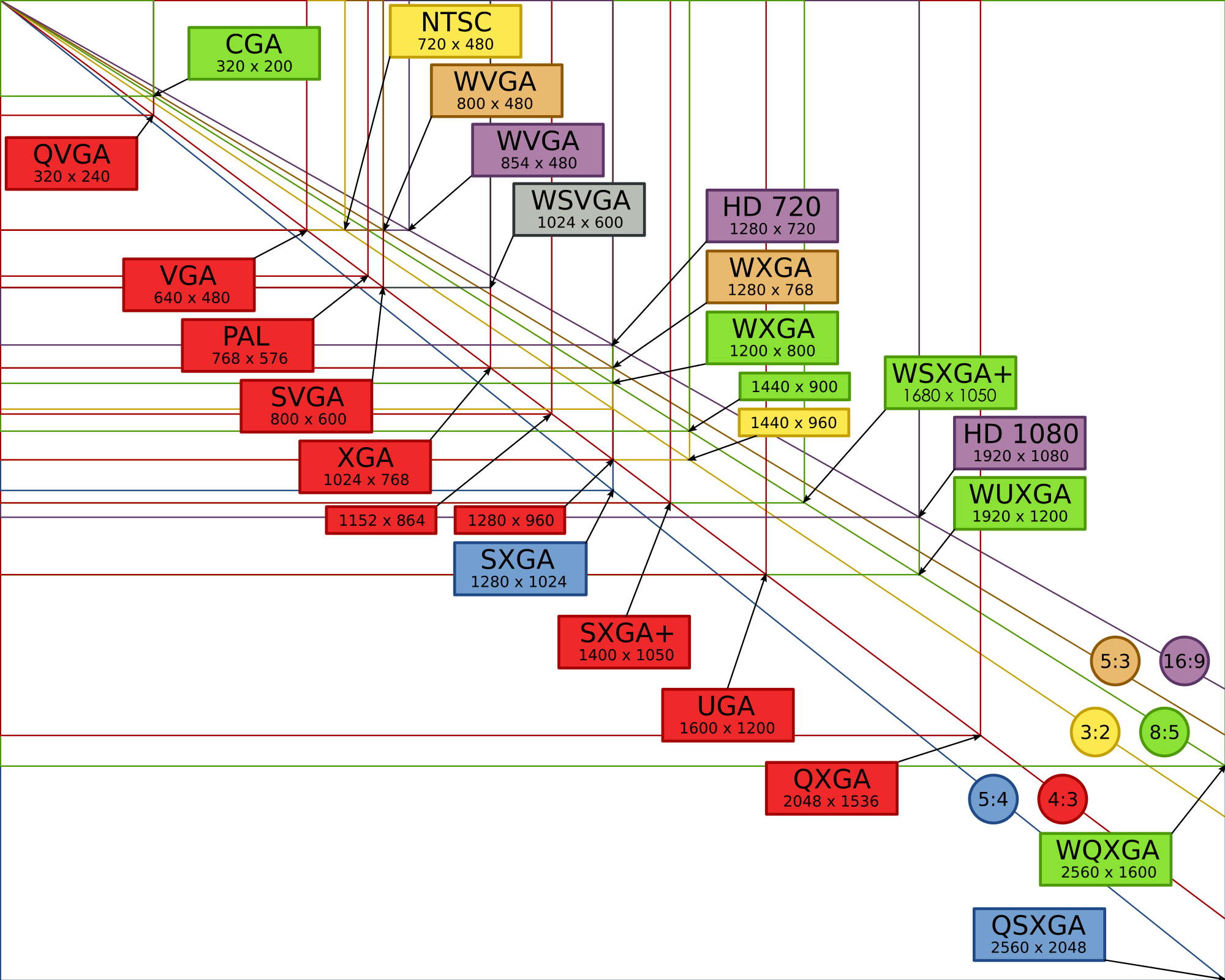

En raison de la prolifération d'un marché avec d'innombrables formats et fabricants, une organisation dédiée a été nécessaire pour les réglementer et développer des normes clés pour les acteurs du marché. En 1988, VESA (Video Electronics Standard Association) a été fondée grâce aux efforts de six fabricants clés, qui ont repris la centralisation des normes et des formats de résolution, ainsi que la palette de couleurs des adaptateurs graphiques. Le premier format était SVGA (800x600 pixels), qui était déjà utilisé dans les cartes Ati Wonder 800. Plus tard, il y en avait plus, et certains (y compris HGC et HGC +) ont été utilisés pendant des décennies.

Le leadership technologique d'ATi s'est poursuivi au début des années 1990. En 1991, Wonder XL a été mis en vente - le premier adaptateur graphique prenant en charge 32000 couleurs et une résolution de 800x600 à un taux de rafraîchissement de 60 Hz. Ceci a été réalisé grâce à l'utilisation du convertisseur Sierra RAMDAC. De plus, Wonder XL est devenu le premier adaptateur avec 1 Mo de mémoire vidéo intégrée.

En mai de la même année, ATI a présenté Mach8, le premier d'une nouvelle gamme de Mach à gérer des opérations 2D simples telles que le dessin au trait, le remplissage de couleur et le bitmapping. Mach8 était disponible à l'achat à la fois en tant que puce (pour une intégration ultérieure - par exemple, dans des systèmes d'entreprise au format OEM) et en tant que carte à part entière. Maintenant, beaucoup trouveront étrange de publier un adaptateur séparé pour de telles choses, mais il y a 30 ans, de nombreux calculs spéciaux reposaient encore sur les épaules du processeur central, tandis que les adaptateurs graphiques étaient destinés à un éventail restreint de tâches.

Cependant, cette façon de faire n'a pas duré longtemps - suite à l'intéressant VGA Stereo F / X, une symbiose d'un adaptateur graphique et d'une carte Sound Blaster pour émuler un codec en mono "à la volée", le leader de l'industrie a présenté un produit permettant de travailler avec des graphiques 2D et 3D - VGA Wonder GT. En combinant les capacités de Mach8 et Wonder Ati ont été les premiers à résoudre le problème de la nécessité d'un adaptateur supplémentaire pour fonctionner avec différents types de tâches. La sortie du populaire système d'exploitation Windows 3.0, qui pour la première fois se concentrait sur un large éventail de tâches liées à l'utilisation de graphiques 2D, a contribué au succès significatif des nouveaux produits. Wonder GT était en demande parmi les intégrateurs de systèmes, ce qui a eu un effet bénéfique sur les bénéfices de l'entreprise - en 1991, le chiffre d'affaires d'ATI dépassait 100 millions de dollars. L'avenir s'annonçait prometteur, mais la concurrence sur le marché ne s'est jamais affaiblie - de nouveaux défis attendaient les dirigeants.

1992-1995. Développement OpenGL. Le deuxième boom du marché des cartes graphiques. Nouvelles frontières en 2D et 3D

En janvier 1992, Silicon Graphics Inc. a introduit la première interface de programmation multi-plateforme OpenGL 1.0, prenant en charge les graphiques 2D et 3D.

Le futur standard ouvert est basé sur la bibliothèque propriétaire IRIS GL (Integrated Raster Imaging System Graphical Library, Integrated system library for processing raster graphics). Consciente que de nombreuses entreprises vont bientôt introduire leurs bibliothèques de ce type sur le marché, SGI a décidé de faire d'OpenGL un standard ouvert, compatible avec toutes les plates-formes du marché. La popularité de cette approche était difficile à surestimer - l'ensemble du marché a attiré l'attention sur OpenGL.

Initialement, Silicon Graphics s'adressait au marché professionnel UNIX, prévoyant des tâches spécifiques pour une future bibliothèque ouverte, mais grâce à sa disponibilité auprès des développeurs et des passionnés, OpenGL a rapidement pris place sur le marché émergent des jeux 3D.

Cependant, tous les principaux acteurs du marché n'ont pas accueilli favorablement cette approche SGI. À peu près à la même époque, Microsoft développait sa propre bibliothèque de logiciels Direct3D et n'était pas pressé d'intégrer la prise en charge d'OpenGL dans le système d'exploitation Windows.

Direct3D a été ouvertement critiqué par le célèbre auteur de Doom John Carmack, qui a personnellement porté Quake sur OpenGL pour Windows, soulignant les avantages d'un code simple et compréhensible d'une bibliothèque ouverte dans le contexte d'une version complexe et "garbage" de Microsoft.

John Carmack

Mais la position de Microsoft est restée inchangée et, après la sortie de Windows 95, la société a refusé de délivrer une licence pour le pilote OpenGL MCD, grâce à laquelle l'utilisateur pouvait décider indépendamment via quelle bibliothèque lancer une application ou un nouveau jeu. SGI a trouvé une faille en publiant un pilote ICD (Installable Client Driver), qui, en plus de la rastérisation OpenGL, a reçu un support pour le traitement des effets d'éclairage.

La croissance explosive de la popularité d'OpenGL a conduit au fait que la solution SGI est devenue populaire dans le segment des postes de travail, ce qui a obligé Microsoft à consacrer toutes les ressources possibles pour créer sa bibliothèque propriétaire dans les plus brefs délais. La base de la future API a été fournie par le studio RenderMorphics, acheté en février 1995, dont la bibliothèque logicielle Reality Lab formait les principes de base de Direct3D.

La renaissance du marché de la carte vidéo. La vague de fusions et acquisitions

Mais revenons un peu dans le passé. En 1993, le marché de la carte vidéo a connu une renaissance et de nombreuses nouvelles entreprises prometteuses ont attiré l'attention du public. L'un d'eux était NVidia, fondé par Jensen Huang, Curtis Prahm et Chris Malachowski en janvier 1993. Huang, qui travaillait comme ingénieur logiciel chez LSI, avait depuis longtemps l'idée de créer une société de cartes graphiques, et ses collègues de Sun Microsystems venaient de travailler sur l'architecture graphique GX. En unissant leurs forces et en amassant 40 000 $, les trois passionnés ont lancé une entreprise destinée à jouer un rôle clé dans l'industrie.

Jensen Huang

Cependant, au cours de ces années, personne n'osait regarder vers l'avenir - le marché évoluait rapidement, de nouvelles API et technologies propriétaires apparaissaient presque tous les mois, et il était évident que tout le monde ne survivrait pas dans le cycle turbulent de la concurrence. De nombreuses entreprises qui sont entrées dans la course aux armements graphiques à la fin des années 1980 ont été contraintes de déclarer faillite - y compris Tamerack, Gemini Technology, Genoa Systems et Hualon, tandis que Headland Technology a été acquise par SPEA et Acer, Motorola et Acumos sont devenus propriété Cirrus Logic.

Comme vous l'avez peut-être deviné, ATI s'est démarquée dans ce groupe de fusions et acquisitions. Les Canadiens ont continué à travailler fort et à fabriquer des produits novateurs quoi qu'il arrive, même si cela devenait beaucoup plus difficile.

En novembre 1993, ATI a lancé la carte de capture vidéo VideoIt! qui était basé sur la puce de décodeur 68890, capable d'enregistrer un signal vidéo dans une résolution de 320x240 à 15 images par seconde ou 160x120 à 30 images par seconde. Grâce à l'intégration de la puce Intel i750Pd VCP, le propriétaire de la nouveauté pouvait effectuer une compression-décompression du signal vidéo en temps réel, ce qui était particulièrement utile lorsque l'on travaillait avec de grandes quantités de données. VideoIt! le premier sur le marché a appris à utiliser le bus central pour communiquer avec l'accélérateur graphique, et aucun câble ni connecteur n'était nécessaire, comme auparavant.

Problèmes ATI et succès de S3 Graphics

Pour ATI, 1994 a été un véritable test - en raison d'une concurrence sérieuse, l'entreprise a subi une perte de 4,7 millions de dollars. La principale cause de problèmes pour les développeurs canadiens était le succès de S3 Graphics. L'accélérateur graphique S3 Vision 968 et l'adaptateur Trio64 ont obtenu une douzaine de contrats OEM majeurs pour la société américaine avec des leaders du marché tels que Dell, HP et Compaq. Quelle était la raison d'une telle popularité? Un niveau d'unification sans précédent - la puce graphique Trio64 a réuni un convertisseur numérique-analogique (DAC), un synthétiseur de fréquence et un contrôleur graphique sous un même capot. Nouveauté de S3 utilisé un framebuffer groupé et une superposition vidéo matérielle prise en charge (implémentée en allouant une partie de la mémoire vidéo pendant le rendu).La masse des avantages et l'absence de lacunes évidentes de la puce Trio64 et de son compatriote 32 bits Trio32 ont conduit à l'émergence de nombreuses options pour les versions partenaires de cartes mères basées sur elles. Diamond, ELSA, Sparkle, STB, Orchid, Hercules et Number Nine ont proposé leurs solutions. Les variations allaient des adaptateurs de base basés sur VirGe pour 169 $ à l'ultra-puissant Diamond Stealth64 avec 4 Mo de mémoire vidéo pour 569 $.

En mars 1995, ATI revient au grand jeu avec un tas d'innovations avec l'introduction de Mach64, le premier accélérateur graphique 64 bits sur le marché et aussi le premier à fonctionner sur les systèmes PC et Mac. En plus du populaire Trio 958, Mach64 offrait des capacités vidéo accélérées par le matériel. Mach64 a ouvert la voie à ATI pour entrer sur le marché professionnel - les premières solutions des Canadiens dans ce secteur étaient les accélérateurs 3D Pro Turbo et 3DProTurbo + PC2TV. De nouveaux articles ont été offerts au prix de 899 $ pour jusqu'à 4 Mo de mémoire vidéo.

La startup technologique 3Dlabs est un autre nouveau venu important sur le marché des accélérateurs graphiques. La direction prioritaire pour la jeune entreprise était la sortie d'accélérateurs graphiques haut de gamme pour le marché professionnel - Fujitsu Sapphire2SX avec 4 Mo de mémoire vidéo était proposé au prix de 1600 $, et ELSA Gloria 8 avec 8 Mo de mémoire embarquée coûtait un incroyable 2600 $ pour ces années. 3Dlabs a tenté de pénétrer le marché des graphiques de jeu de masse avec le Gaming Glint 300SX, mais le prix élevé et seulement 1 Mo de mémoire vidéo n'ont pas apporté de popularité à l'adaptateur.

D'autres entreprises ont également présenté leurs produits au marché de la consommation. Trident, un fournisseur OEM de solutions graphiques 2D, a dévoilé la puce 9280 qui offre tous les avantages du Trio64 à un prix abordable de 170 $ à 200 $. Dans le même temps, Power Player 9130 de Weitek et ProMotion 6410 d'Alliance Semiconductor ont été mis en vente, ce qui a fourni une excellente fluidité lors de la lecture vidéo.

NV1 - Début de NVidia et zones problématiques

En mai 1995, NVIDIA rejoint les nouveaux venus, présentant son premier accélérateur graphique avec le nom symbolique NV1. Le produit a été le premier sur le marché commercial à combiner les capacités de rendu 3D, d'accélération vidéo matérielle et d'une interface graphique. Un succès commercial restreint n'a en rien dérangé la jeune entreprise - Jen-Hsun Huang et ses collègues étaient bien conscients qu'il serait très difficile de «tourner» dans un marché où de nouvelles solutions sont présentées chaque mois. Mais les bénéfices de la vente de NV1 étaient suffisants pour maintenir l'entreprise à flot et inciter à continuer à travailler.

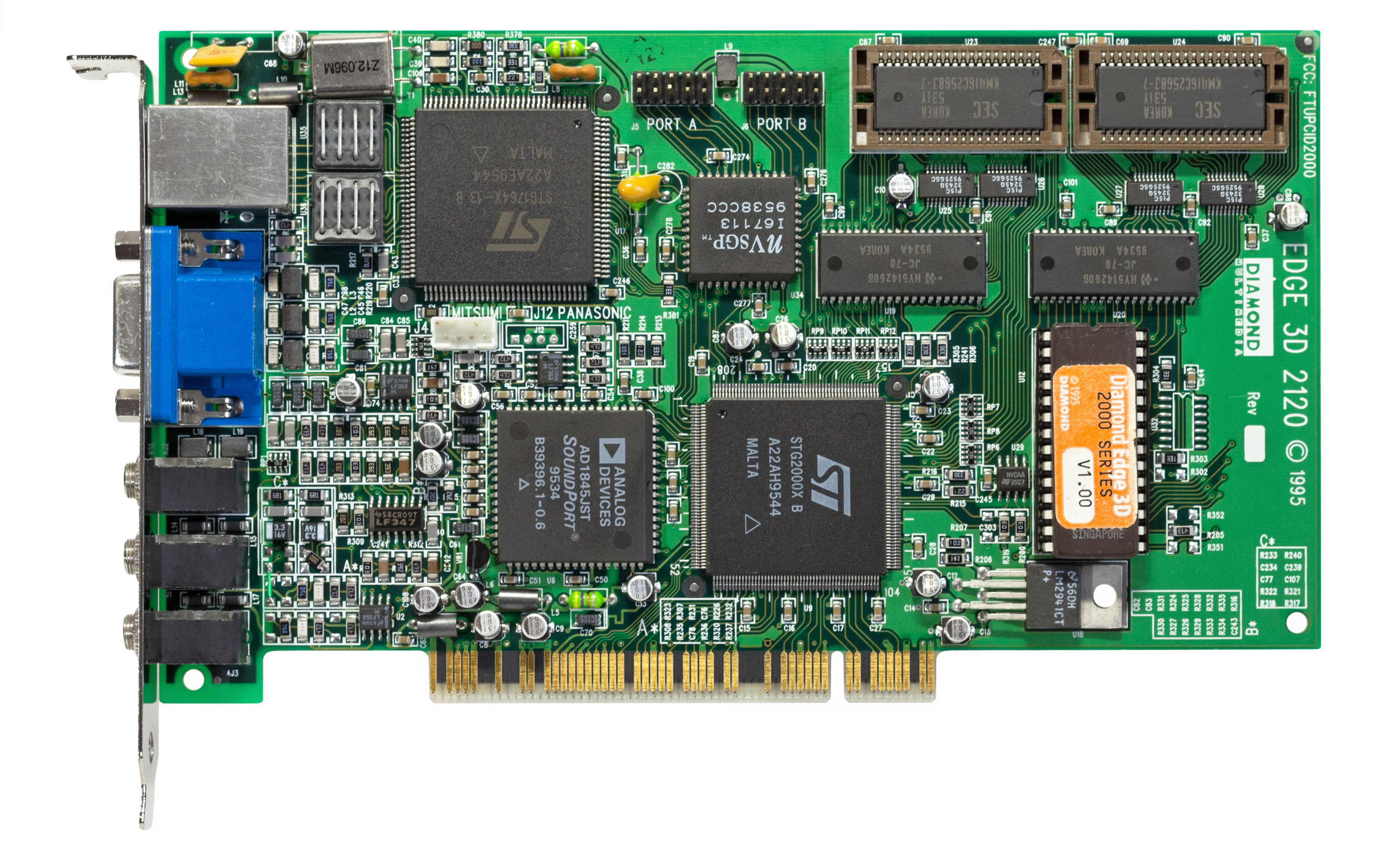

Diamant EDGE 3D 2120 (NV1)

ST Microelectronics était en charge de la production de puces basées sur la technologie de processus 500 nm, mais malheureusement pour Nvidia, à peine quelques mois après l'introduction de solutions partenaires basées sur NV1 (par exemple, Diamond Edge 3D), Microsoft a présenté la première version de l'API graphique DirectX 1.0 tant attendue. "Finalement!" - s'exclamaient des joueurs du monde entier, mais les fabricants d'accélérateurs graphiques ne partageaient pas un tel enthousiasme.

La principale caractéristique de DirectX est les polygones triangulaires. Beaucoup de gens croient à tort que les triangles notoires ont toujours existé, mais en fait, c'est une illusion. Les ingénieurs de Nvidia ont inclus le mappage de texture quadratique dans leur premier produit (au lieu des triangles-polygones, il y avait des carrés), c'est pourquoi les applications et les premiers jeux avec le support DirectX ont causé beaucoup de problèmes de compatibilité pour les propriétaires de NV1. Pour résoudre le problème, Nvidia a inclus un gestionnaire pour convertir les marques de texture carrées en triangulaires dans le pilote, mais les performances dans ce format laissaient beaucoup à désirer.

La plupart des jeux avec prise en charge du mappage de texture quadratique ont été portés depuis la console Sega Saturn. Nvidia a considéré ces projets si importants qu'ils ont placé deux ports de la nouvelle console sur le modèle 4 Mo NV1, connectés à la carte via des connecteurs à ruban. Lors de sa mise en vente (septembre 1995), le premier produit de Nvidia coûtait 450 dollars aux clients.

Au moment du lancement de l'API de Microsoft, la plupart des fabricants d'accélérateurs graphiques dépendaient fortement des solutions propriétaires d'autres sociétés - lorsque les développeurs de la société de Bill Gates commençaient tout juste à travailler sur leur propre bibliothèque graphique, il y avait déjà de nombreuses API sur le marché, telles que S3d (S3), Matrox Simple Interface, Creative Graphics Library, C Interface (ATI) et SGL (PowerVR), et plus tard inclus NVLIB (Nvidia), RRedline (Rendition) et le célèbre Glide. Cette diversité a grandement compliqué la vie des développeurs du nouveau matériel, car les API étaient incompatibles les unes avec les autres et différents jeux supportaient différentes bibliothèques. La sortie de DirectX a mis fin à toutes les solutions tierces, car l'utilisation d'autres API propriétaires dans les jeux pour Windows n'avait tout simplement pas de sens.

Mais on ne peut pas dire que le nouveau produit de Microsoft était dépourvu de graves défauts. Après la présentation du SDK DirectX, de nombreux fabricants d'accélérateurs graphiques ont perdu la capacité de contrôler les ressources matérielles des cartes vidéo lors de la lecture de vidéos numériques. De nombreux problèmes de pilote sur le Windows 95 récemment sorti ont irrité les utilisateurs habitués au fonctionnement stable de Windows 3.1. Au fil du temps, tous les problèmes ont été résolus, mais la principale bataille pour le marché était à venir - ATI, qui avait fait une pause, se préparait à conquérir l'univers des jeux en trois dimensions avec une nouvelle ligne de 3D Rage.

ATI Rage - Rage 3D

La démonstration du nouvel accélérateur graphique a eu lieu à l'exposition Los Angeles E3 1995. Les ingénieurs d'ATI ont combiné les avantages de la puce Mach 64 (et ses capacités graphiques 2D exceptionnelles) avec une nouvelle puce de traitement 3D, tirant pleinement parti des conceptions précédentes. Le premier accélérateur 3D ATI 3D Rage (également connu sous le nom de Mach 64 GT) est entré sur le marché en novembre 1995.

ATI 3D Rage

Comme dans le cas de Nvidia, les ingénieurs ont dû faire face à de nombreux problèmes - les dernières révisions de DirectX 1.0 ont causé de nombreux problèmes liés à l'absence de tampon profond. La carte ne disposait que de 2 Mo de RAM EDO, de sorte que les applications et les jeux 3D ont été lancés avec une résolution ne dépassant pas 640x480 en couleur 16 bits ou 400x300 en couleur 32 bits, tandis qu'en mode 2D, la résolution de l'écran était beaucoup plus élevée - jusqu'à 1280x1024. Les tentatives d'exécuter le jeu en couleur 32 bits à 640x480 ont généralement abouti à des artefacts de couleur sur l'écran, et les performances de jeu de 3D Rage n'étaient pas exceptionnelles. Le seul avantage incontestable de la nouveauté était la possibilité de lire des fichiers vidéo au format MPEG en mode plein écran.

ATI a travaillé sur les bugs et a repensé la puce avec la sortie de Rage II en septembre 1996. Après avoir corrigé les défauts matériels et ajouté la prise en charge du codec MPEG2, les ingénieurs, pour une raison quelconque, n'ont pas pensé à la nécessité d'augmenter la taille de la mémoire - les premiers modèles avaient encore une mémoire vidéo ridicule de 2 Mo à bord, ce qui a inévitablement affecté les performances lors du traitement de la géométrie et de la perspective. Le défaut a été corrigé dans les révisions ultérieures de l'adaptateur - par exemple, dans Rage II + DVD et 3D Xpression +, la mémoire tampon est passée à 8 Mo.

Mais la guerre pour le marché de la 3D ne faisait que commencer, alors que trois nouvelles entreprises préparaient leurs produits pour les derniers jeux - Rendition, VideoLogic et 3dfx Interactive. C'est ce dernier qui a réussi à présenter une puce graphique dans les plus brefs délais, devançant nettement tous ses concurrents et ouvrant une nouvelle ère dans le graphisme 3D -Graphiques Voodoo 3Dfx .

1996-1999. L'ère de 3Dfx. La plus grande start-up graphique jamais créée. La dernière étape d'une grande concurrence pour le marché

L'incroyable histoire de 3Dfx est devenue une incarnation classique d'une startup, symbolisant à la fois un succès incroyable et des profits vertigineux, ainsi que l'incompétence d'un leadership confiant, et par conséquent - l'effondrement et l'oubli. Mais la triste fin et l'expérience amère ne peuvent nier l'évidence: 3Dfx a créé à lui seul une révolution graphique, prenant de nombreux concurrents par surprise et établissant une nouvelle barre de performances phénoménalement élevée. Ni avant ni après cette période incroyable de l'histoire du développement des cartes vidéo, nous n'avons rien vu de similaire à la montée folle de 3Dfx dans la seconde moitié des années 90.

3Dfx Voodoo Graphics était un adaptateur graphique destiné exclusivement à travailler avec des graphiques 3D. Il a été supposé que l'acheteur de la nouveauté utilisera une autre carte pour travailler avec des charges bidimensionnelles, en la connectant à Voodoo via un deuxième connecteur VGA.

Cette approche n'a pas dérouté de nombreux passionnés, et la solution innovante a immédiatement attiré de nombreux fabricants partenaires qui ont sorti leurs propres variantes de Voodoo.

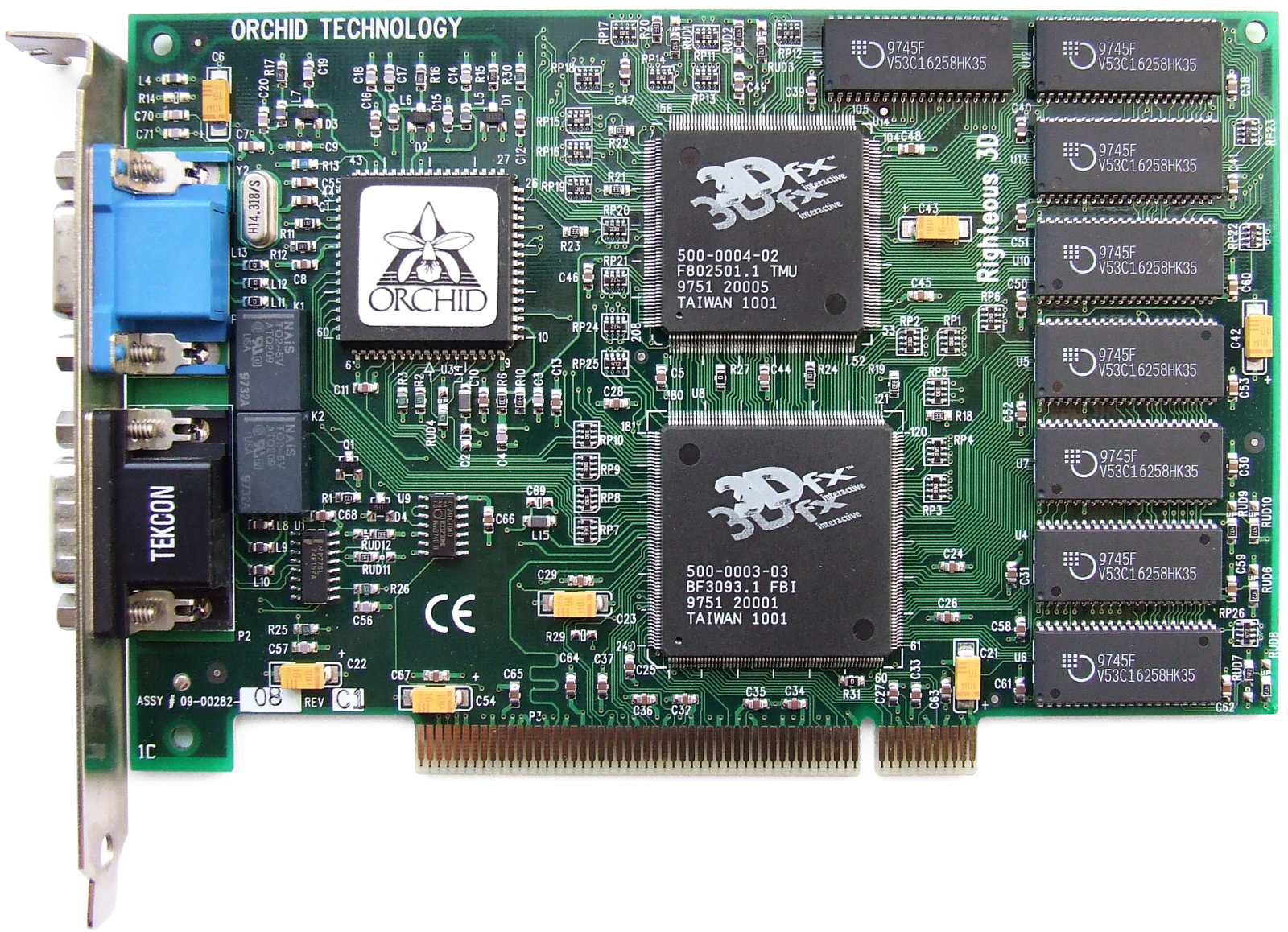

L'une des cartes intéressantes basées sur la première puce 3Dfx était Orchid Righteous 3D d'Orchid Technologies. La marque de commerce de l'adaptateur à 299 $ était des relais mécaniques qui émettent des clics caractéristiques lors du lancement d'applications ou de jeux 3D.

Orchidée vertueuse 3D

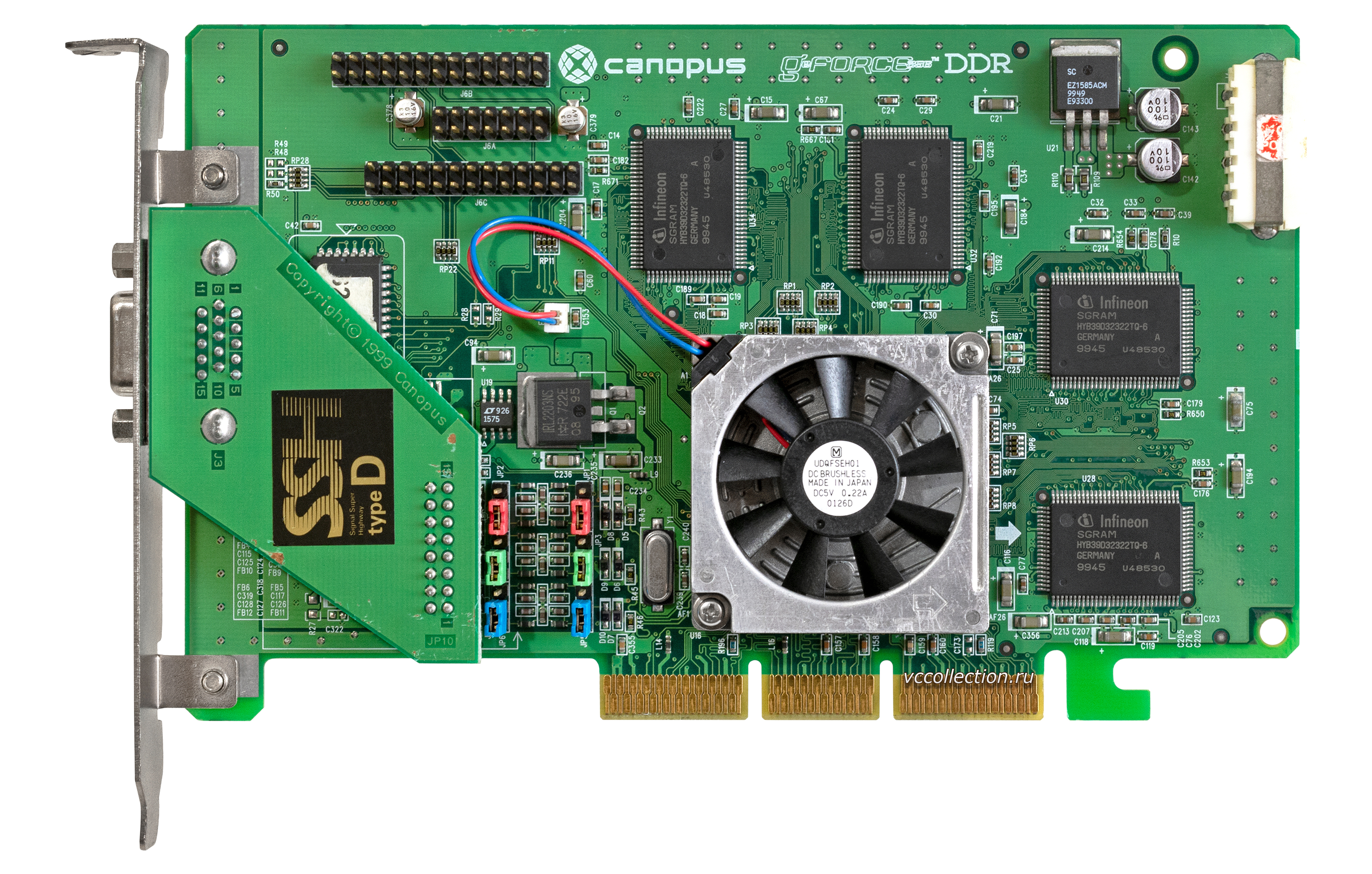

Dans les révisions ultérieures, ces relais ont été remplacés par des composants à semi-conducteurs, et l'ancien charme a été perdu. Avec Orchid, Diamond Multimedia (Monster 3D), Colormaster (Voodoo Mania), Canopus (Pure3D et Quantum3D), Miro (Hiscore), Skywell (Magic3D) et le plus prétentieux d'une série de titres, 2theMAX Fantasy FX Power 3D, ont également présenté leurs versions du dernier accélérateur. ... Auparavant, ils n'hésitaient pas à nommer les cartes vidéo!

Les raisons de cette excitation autour de la nouveauté étaient évidentes - avec toutes les lacunes possibles, Voodoo Graphics avait des performances incroyables et son apparence a immédiatement rendu de nombreux autres modèles obsolètes - en particulier ceux qui ne pouvaient fonctionner qu'avec des graphiques 2D. Malgré le fait qu'en 1996, plus de la moitié du marché des accélérateurs 3D appartenait à S3, 3Dfx gagnait rapidement des millions de fans et à la fin de 1997, l'entreprise détenait 85% du marché. Ce fut un succès phénoménal.

Concurrents 3Dfx. Rendition et VideoLogic

Les succès retentissants du nouveau venu d'hier n'ont pas exclu les concurrents du jeu, dont nous avons parlé plus tôt - VideoLogic et Rendition. VideoLogic a créé la technologie TBRD (Tiled Deferred Rendering) qui élimine le besoin de mise en mémoire tampon pré-Z d'une image. Lors de la dernière étape du rendu, les pixels cachés ont été nettoyés et le traitement de la géométrie n'a commencé qu'après l'application des textures, des ombres et de l'éclairage. La technologie TBRD fonctionnait sur le principe de la division d'un cadre en cellules rectangulaires, dans lesquelles les polygones étaient rendus indépendamment les uns des autres. Dans ce cas, les polygones situés en dehors de la zone visible du cadre ont été éliminés, et le rendu du reste n'a commencé qu'après le calcul du nombre total de pixels. Cette approche a permis d'économiser beaucoup de ressources informatiques au stade du rendu d'image,amélioration significative des performances globales.

La société a mis sur le marché trois générations de puces graphiques de NEC et ST Micro. La première génération était un produit exclusif sur les ordinateurs Compaq Presario appelé Midas 3 (les Midas 1 et 2 étaient des prototypes utilisés dans les machines d'arcade). Les PSX1 et PSX2 publiés plus tard étaient axés sur le marché OEM.

Les puces de deuxième génération ont constitué la base de la Sega Dreamcast, la plate-forme japonaise qui a joué un rôle dans le triste sort de 3Dfx. Dans le même temps, VideoLogic n'a pas eu le temps d'entrer sur le marché grand public des cartes graphiques - au moment de la première, leur modèle Neon 250 était devenu obsolète, perdant face à toutes les solutions budgétaires, et ce n'est pas surprenant, car la nouveauté n'a atteint les rayons qu'en 1999.

Rendition a également excellé dans les innovations graphiques et a créé la première puce graphique Vérité 1000 avec la possibilité de travailler non seulement avec 2D, mais aussi avec des graphiques 3D simultanément grâce au cœur de processeur sur l'architecture RISC, ainsi que l'utilisation de pipelines de pixels. Le processeur était responsable du traitement des polygones et du mécanisme des pipelines de rendu.

Microsoft était intéressé par cette approche de la construction et du traitement des images - la société a utilisé Vérité 1000 lors du développement de DirectX, mais l'accélérateur avait ses propres défauts architecturaux. Par exemple, cela ne fonctionnait que sur les cartes mères prenant en charge la technologie Direct Memory Access (DMA), qui transférait les données via le bus PCI. En raison de son bon marché et de ses nombreux avantages logiciels, notamment l'anti-aliasing et l'accélération matérielle dans Quake d'id Software, la carte était populaire jusqu'à la sortie de Voodoo Graphics. Le nouveau produit de 3Dfx s'est avéré plus de 2 fois plus productif et la technologie DMA a rapidement perdu sa popularité parmi les développeurs de jeux, envoyant le V1000 autrefois prometteur dans la poubelle de l'histoire.

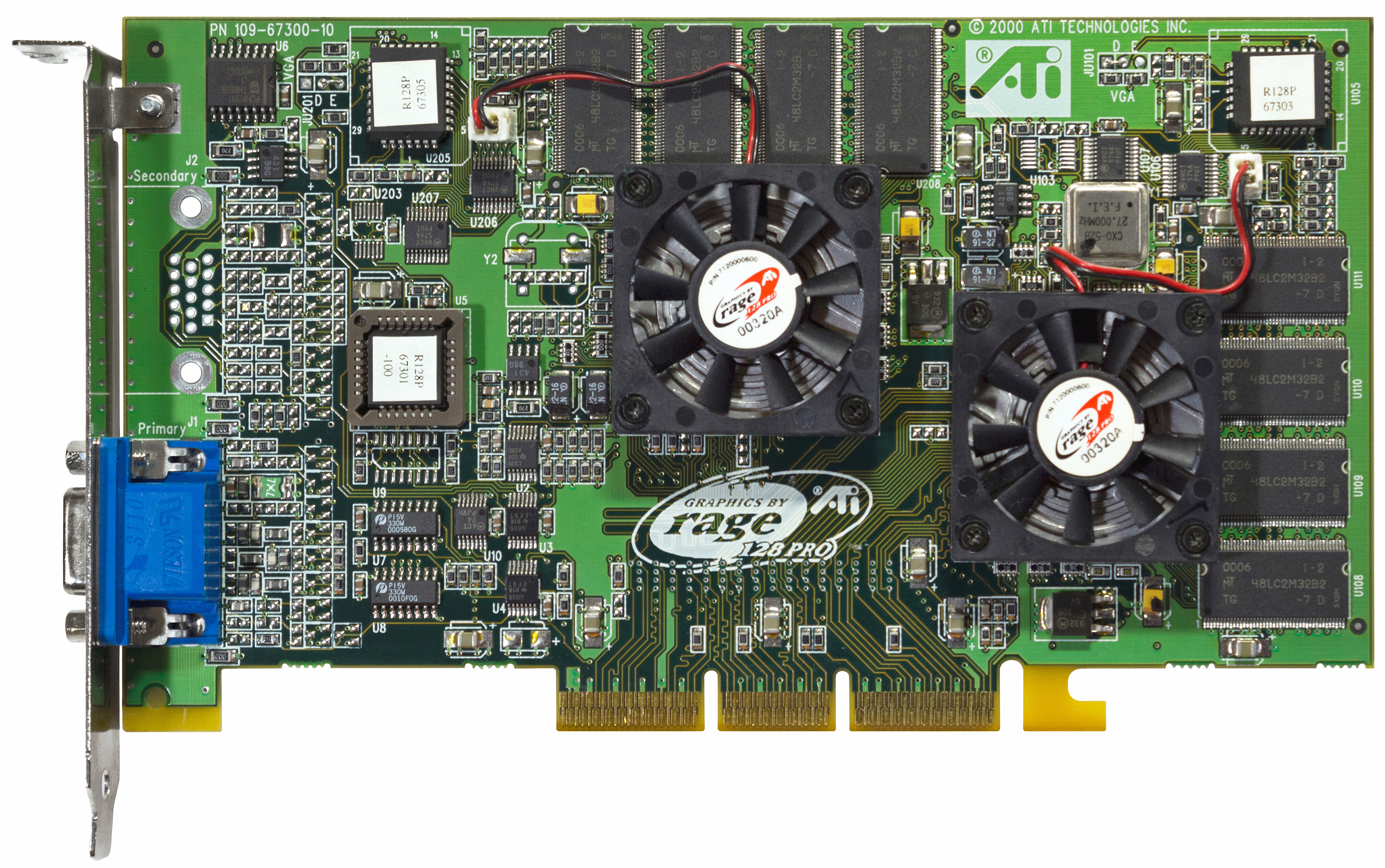

ATI - Race for Voodoo avec Rage II et Rage Pro

Pendant ce temps, ATI n'a pas arrêté de travailler sur de nouvelles révisions de Rage. Après la Rage II en mars 1997, la Rage Pro a été introduite - la première carte vidéo AGP du groupe ATI 3D Engineering, formée la veille.

Rage Pro avec 4 Mo de mémoire vidéo à bord a presque rattrapé le légendaire Voodoo en performances, et la version sur le bus AGP avec 8 Mo de mémoire vidéo a même dépassé le célèbre concurrent dans un certain nombre de jeux. Dans la version Pro de la carte, les ingénieurs ATI ont amélioré la correction de perspective et le traitement de la texture, ainsi que la prise en charge de l'anti-crénelage matériel et du filtrage trilinéaire grâce à l'augmentation du cache de 4 Ko. Pour réduire la dépendance des performances de l'adaptateur sur le processeur central de l'ordinateur, une puce séparée a été soudée sur la carte pour traiter les opérations en virgule flottante. Les fans de multimédia moderne ont apprécié la prise en charge de l'accélération matérielle lors de la lecture de vidéos à partir d'un support DVD.

L'entrée de Rage Pro a permis à ATI d'améliorer ses finances et d'augmenter son bénéfice net à 47,7 millions de dollars sur un chiffre d'affaires total de plus de 600 millions de dollars.La majeure partie du succès financier du produit provenait de contrats OEM, de la mise en œuvre de la puce graphique sur les cartes mères et de la sortie d'une variante mobile. La carte, qui était souvent en vente dans les variantes Xpert @ Work et Xpert @ Play, avait de nombreuses configurations de 2 à 16 Mo de mémoire vidéo pour différents besoins et segments de marché.

Un avantage stratégique important pour le personnel d'ATI a été l'acquisition de 3 millions de dollars de Tseng Labs, qui a travaillé sur des technologies d'intégration de puces RAMDAC sur les cartes graphiques. L'entreprise développait sa propre carte graphique, mais a rencontré des problèmes techniques, ce qui a conduit à une contre-offre de la part des leaders du marché canadien. Outre la propriété intellectuelle, 40 ingénieurs de haut niveau ont été transférés au personnel d'ATI et ont immédiatement commencé à travailler.

Nouveaux concurrents. Permedia et RIVA 128

Les professionnels de 3DLabs n'ont jamais abandonné l'espoir de capter les intérêts des joueurs. Pour cela, une série de produits Permedia a été lancée, fabriqués à l'aide de la technologie de processus Texas Instruments 350 nm. Le Permedia original avait des performances relativement médiocres, ce qui a été corrigé dans Permedia NT. La nouvelle carte avait une puce Delta séparée pour le traitement des polygones et un algorithme d'anti-aliasing, mais en même temps, elle coûtait cher - jusqu'à 600 $. Lorsque la ligne Permedia 2 mise à jour était prête à la fin de 1997, elle ne pouvait plus rivaliser avec les produits de jeu - 3DLabs a changé le marketing et a présenté de nouveaux éléments sous forme de cartes professionnelles pour travailler avec des applications 2D et un support 3D limité.

Un mois à peine après les dernières versions de 3DLabs et ATI, Nvidia est de retour sur le marché avec son RIVA 128, un portefeuille de jeu hautement compétitif. Un prix abordable et d'excellentes performances dans Direct3D ont assuré au nouveau produit une reconnaissance universelle et un succès commercial, permettant à l'entreprise de conclure un contrat avec TSMC pour la production de puces pour le RIVA 128ZX mis à jour. À la fin de 1997, deux cartes vidéo à succès ont apporté à Jensen Huang 24% du marché - presque tout ce que le tout-puissant 3Dfx n'a pas eu le temps d'écraser.

Ironiquement, les chemins entre Nvidia et le leader du marché ont commencé à se croiser déjà lorsque Sega, préparant le développement de la nouvelle console Dreamcast, a conclu plusieurs contrats préliminaires avec des fabricants de solutions graphiques. Parmi eux, Nvidia (avec la conception de la puce NV2) et 3Dfx (avec le prototype Blackbelt). La direction de 3Dfx était pleinement confiante dans l'obtention du contrat, mais, à leur grande surprise, a été refusée - les Japonais ont choisi de ne pas le risquer et se sont tournés vers NEC pour le développement, qui s'était auparavant avéré être une collaboration avec Nintendo. Des représentants de 3Dfx ont intenté une action en justice contre Sega, accusant l'entreprise d'avoir l'intention de détourner des développements propriétaires au cours des travaux sur le prototype - un long litige s'est terminé en 1998 avec le versement d'une indemnité d'un montant de 10,5 millions de dollars en faveur de la société américaine.

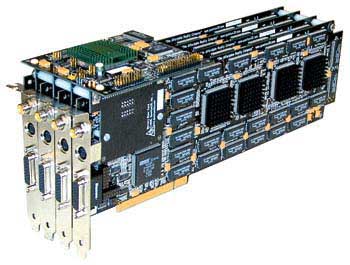

Quantum3D et la première utilisation de SLI

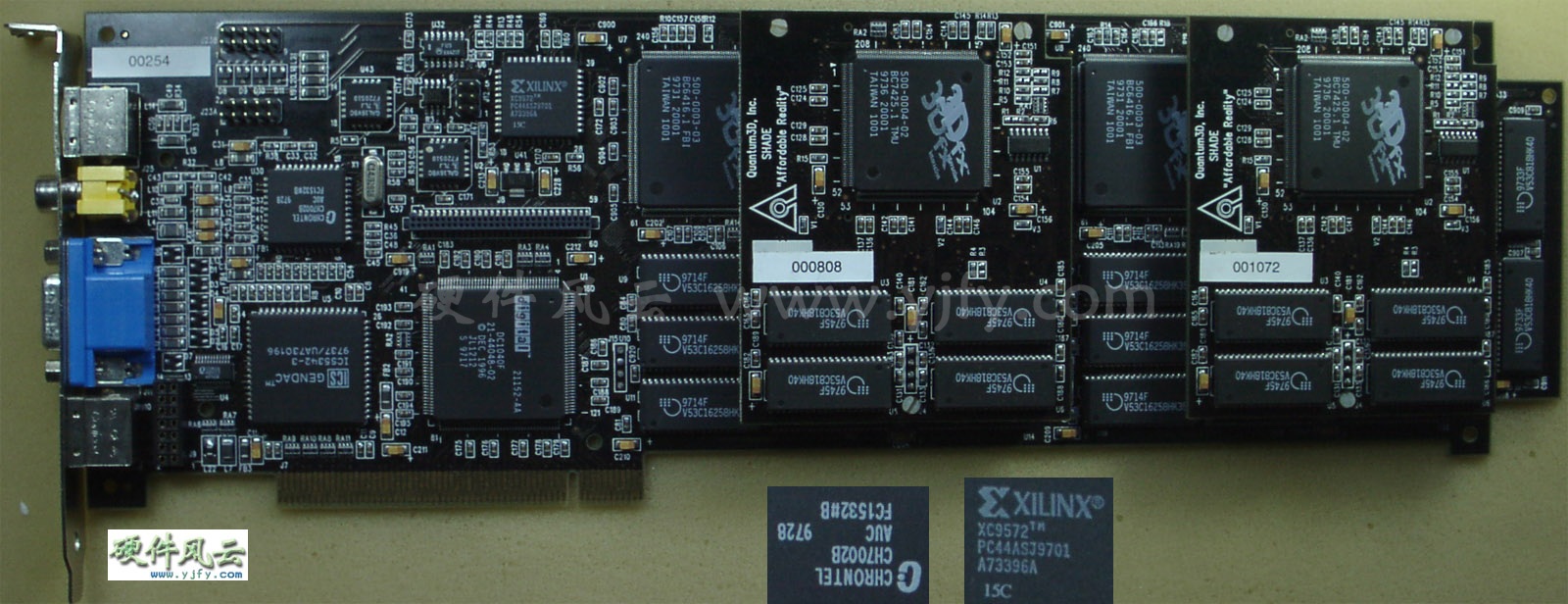

Dans l'intervalle, ont-ils poursuivi, 3Dfx a réussi à acquérir une filiale. Elle était Quantum3D, qui a reçu plusieurs contrats lucratifs pour le développement de solutions graphiques professionnelles du plus haut niveau de SGI et Gemini Technology. Les futurs produits étaient basés sur le développement innovant de la technologie 3Dfx - SLI (Scan-Line Interleave) .

La technologie supposait la possibilité d'utiliser deux puces graphiques (chacune avec son propre contrôleur de mémoire et tampon) dans une carte ou de connecter deux cartes séparées à l'aide d'un câble ruban spécial. De même, des cartes connectées (au format d'une carte à double puce ou de deux cartes séparées) divisaient le traitement d'image par deux. La technologie SLI permettait d'augmenter la résolution de l'écran de 800x600 à 1024x768 pixels, mais un tel luxe n'était pas bon marché: l'Obsidian Pro 100DB-4440 (deux cartes appariées avec des puces Amethyst) était proposée au prix de 2500 $, tandis que la carte à double puce 100SB-4440 / 4440V aurait coûté à l'acheteur. à 1895 $.

Obsidian Pro 100DB-4440

Les solutions spécialisées n'ont cependant pas distrait les leaders du marché du développement de nouvelles cartes Voodoo.

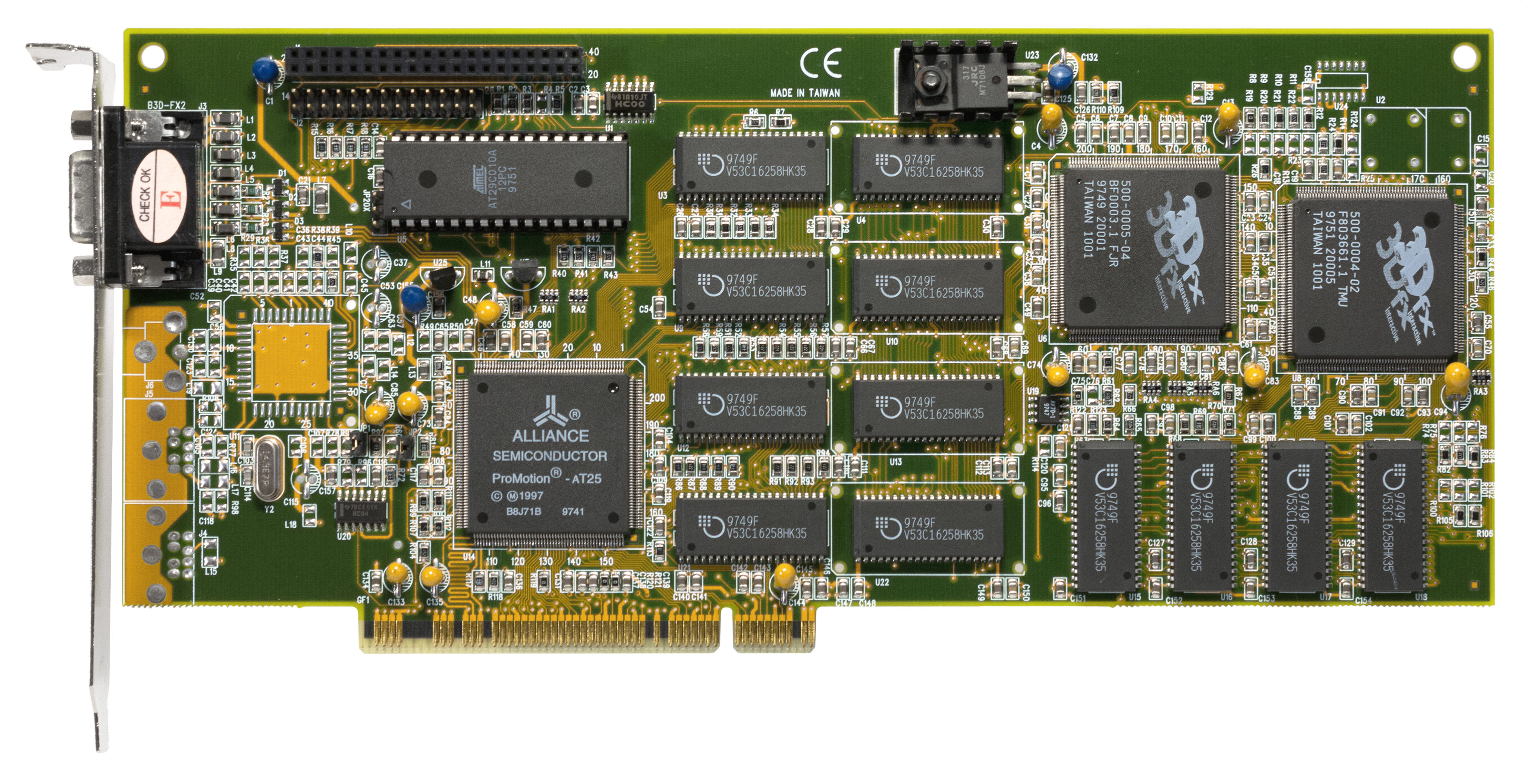

3Dfx Voodoo Rush. Rush, budget et frustration

À l'été 1997, 3Dfx est devenu public et a tenté de consolider le succès écrasant de Voodoo en lançant Voodoo Rush, une carte qui fonctionne simultanément avec des graphiques 2D et 3D, et ne nécessite plus un deuxième adaptateur. Initialement, il était censé être basé sur la nouvelle puce Rampage, mais en raison de problèmes techniques, sa sortie a été retardée et Rush était basé sur une version allégée du Voodoo original. Pour s'adapter aux deux types de charges de travail graphiques, la carte abritait deux puces - la SST-1 était responsable du traitement des jeux 3D à l'aide de l'API Glide, tandis que la puce plus médiocre d'Alliance ou de Macronix était responsable d'autres applications et jeux 2D et 3D. En raison de la désynchronisation, les puces fonctionnaient à des fréquences différentes (50 et 72 MHz), provoquant des artefacts aléatoires sur l'écran et de la confusion pour les propriétaires.

Ruée vers le vaudou

En outre, Voodoo Rush avait un tampon de mémoire vidéo commun, que les deux puces utilisaient simultanément. La résolution d'écran maximale en souffrait - elle n'était que de la moitié de 1024x768 (512x384 pixels), et les basses fréquences RAMDAC ne permettaient pas de fournir les 60 Hz souhaités dans le rafraîchissement de l'écran.

Rendition V2100 et V2200. Quitter le marché

Au milieu de gros problèmes avec 3Dfx, Rendition a fait une autre tentative pour surprendre agréablement le marché de masse avec les Rendition V2100 et V2200. Les nouveautés sont entrées sur le marché peu de temps après la première de Voodoo Rush, mais, à la déception des passionnés, elles ne pouvaient même pas rivaliser avec le Voodoo dépouillé. Les cartes graphiques non réclamées ont forcé Rendition à être le premier d'une multitude à quitter le marché des cartes graphiques.

En conséquence, de nombreux projets de l'entreprise sont restés au stade du prototype - l'un d'entre eux était une version modifiée du V2100 / V2200 avec un processeur géométrique Fujitsu FXG-1 (dans un format à double puce). Cependant, il y avait aussi une variante à puce unique avec FXG-1, qui est entrée dans l'histoire comme le produit avec le nom le plus exquis de l'histoire - Hercules Thrilled Conspiracy. Avec d'autres développements (par exemple, les puces V3300 et 4400E), la société a été vendue à Micron pour 93 millions de dollars en septembre 1998.

Économie agressive. Bataille pour le segment budgétaire

La croissance continue des performances et l'émergence de nouveaux avantages techniques ont rendu extrêmement difficile pour les fabricants de second rang de rivaliser avec les solutions d'ATI, Nvidia et 3Dfx, qui ont occupé non seulement le créneau des passionnés et des professionnels, mais aussi le segment «populaire» du marché des adaptateurs à moins de 200 $.

Matrox a présenté sa carte graphique Mistique à un prix savoureux de 120 $ à 150 $, mais en raison du manque de support OpenGL, le nouveau produit est immédiatement tombé dans la catégorie des outsiders. S3 a commencé à vendre la nouvelle ligne ViRGE, avec la présence de la plus large gamme de modèles - la version mobile de l'adaptateur avec gestion dynamique de l'alimentation (ViGRE / MX) et une version spéciale du ViRGE principal avec prise en charge de la sortie TV, du connecteur S-Vidéo et de la lecture de DVD (ViRGE / GX2). Deux principaux adaptateurs conçus pour se battre pour le marché du budget (modèles ViRGE, VIRGE DX et ViRGE GX) coûtent de 120 $ pour le plus jeune à 200 $ pour le plus ancien au moment de la sortie.

C'est difficile à imaginer, mais la catégorie ultra-budget était aussi un lieu de concurrence féroce. Laguna3D de CirrusLogic, les modèles 9750/9850 de Trident et SiS 6326 se disputaient des portefeuilles d'utilisateurs prêts à ne pas payer plus de 99 $ pour un accélérateur graphique, toutes ces cartes étaient des solutions de compromis avec un minimum de fonctionnalités.

Après la sortie de Laguna3D, CirrusLogic a quitté le marché - des graphismes 3D de mauvaise qualité, des performances médiocres (et incohérentes), ainsi que des concurrents beaucoup plus intéressants (le même ViRGE, qui coûte un peu plus) n'ont pas laissé aux vétérans de l'industrie une chance de survivre. Les seules sources de revenus pour CirrusLogic étaient la vente de cartes graphiques 16 bits antédiluviennes pour 50 $, intéressantes uniquement pour les clients les plus économiques.

Trident a également vu un potentiel dans le segment de marché «inférieur à la moyenne» - en mai 1997, le 3D Image 9750 est sorti, et un peu plus tard, le 9850 est sorti avec le support d'un bus AGP à double canal. Après avoir résolu de nombreux problèmes de bus PCI du 9750, le 9850 a souffert d'une gestion de texture médiocre et n'a reçu que peu d'éloges.

Parmi les cartes vendues pour presque rien, la plus réussie est la SiS 6326, lancée en juin 1997 pour moins de 50 $. Avec une bonne qualité d'image et des performances relativement élevées, le 6326 s'est vendu à plus de 8 millions d'unités en 1998. Mais à la fin des années 90, le monde des passionnés a été secoué par une start-up pleine de promesses sérieuses - c'était BitBoys.

BitBoys - Des gars audacieux dans un monde 3D fabuleux

BitBoys s'est annoncé en juin 1997 avec l'annonce du projet intrigant Pyramid3D. La puce graphique révolutionnaire a été développée conjointement par la startup elle-même avec Silicon VLSI Solutions Oy et TriTech. Malheureusement pour les passionnés, à part les mots forts lors des présentations de Pyramid3D, il n'est jamais apparu nulle part, et la société TriTech a été condamnée pour s'approprier le brevet de quelqu'un d'autre pour une puce audio, c'est pourquoi elle a ensuite fait faillite et a fermé ses portes.

Mais BitBoys n'a pas arrêté de fonctionner et a annoncé un deuxième projet appelé Glaze3D. Un réalisme incroyable, des performances de premier ordre et une foule des dernières technologies ont été présentés au public au SIGGRAPH99. Le prototype fonctionnel de l'adaptateur graphique utilisait le RAMBUS et 9 Mo de DRAM vidéo d'Infineon.

Hélas, tout comme la première fois, des problèmes matériels et des transferts ont conduit au fait que la révolution attendue ne s'est pas reproduite.

Capture d'écran promotionnelle, conçue pour souligner le réalisme que les cartes Glaze3D étaient censées atteindre

Bien plus tard, le projet a été renommé à nouveau Axe, et les jeux avec le support DirectX 8.1 ont été choisis comme champ de compétition - le prototype a même réussi à obtenir le nom officiel Avalanche3D et a promis de "faire exploser" le marché en 2001, mais pas C'est arrivé. Au cours de la dernière étape de développement, Axe est passé à Hammer, qui a été promis de prendre en charge DirectX 9.0. L'histoire de la construction à long terme la plus prétentieuse de l'histoire du graphisme s'est terminée avec la faillite d'Infineon, après quoi BitBoys a abandonné le «projet de rêve» et est passé au segment du graphisme mobile. Revenons maintenant à cosy 1998.

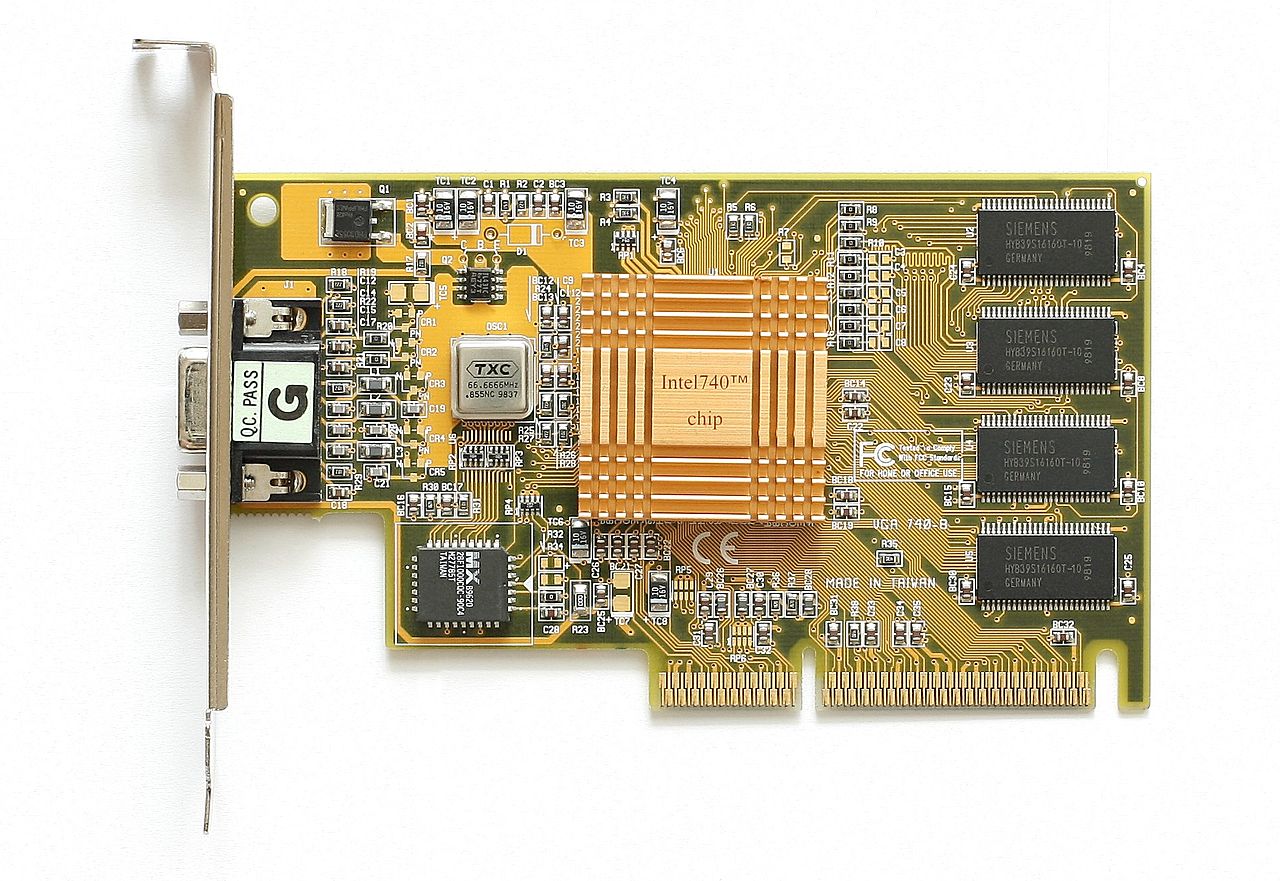

Intel i740 - Gros échec des grands professionnels

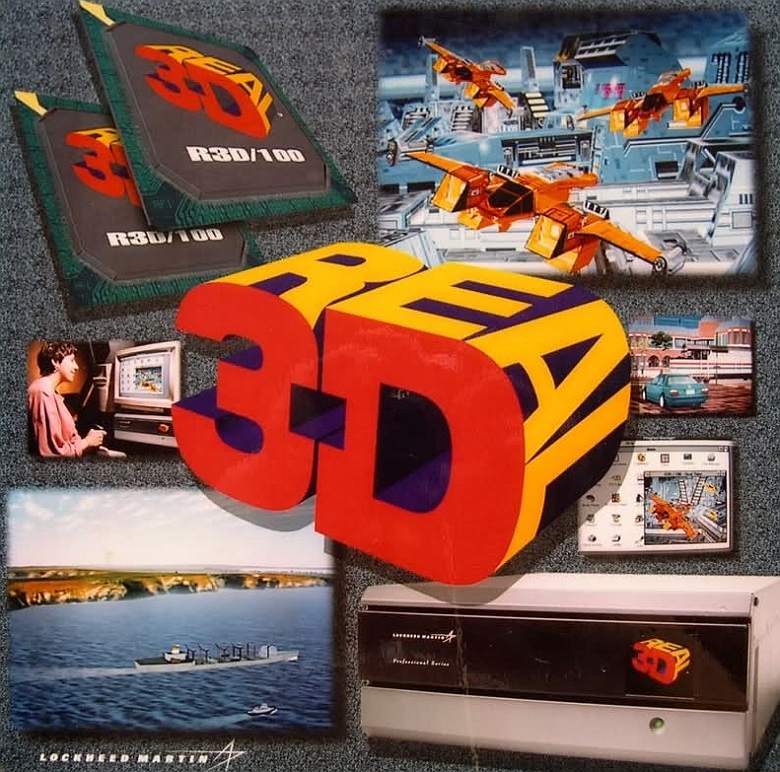

Intel a sorti sa première (et jusqu'à présent la dernière) carte graphique pour les jeux 3D appelée Intel i740 en janvier 1998. Le projet avait une histoire intéressante, car il était enraciné dans un programme de simulation de vol spatial que la NASA et General Electric ont créé pour la célèbre série Apollo de missions lunaires. Plus tard, les développements ont été vendus à Martin Marietta, une société qui est devenue plus tard une partie du géant de la défense Lockheed (et c'est ainsi que Lockheed-Martin est apparu). Lockheed-Martin sur la base du projet a créé une ligne d'appareils professionnels Read3D, composée de deux modèles d'adaptateurs graphiques - Real3D / 100 et Real3D / Pro-1000. Ironiquement, malgré l'origine militaire des appareils, l'une des applications des technologies exceptionnelles est devenue ... une machine d'arcade Sega utilisant deux cartes Pro-1000.

Un peu plus tard, Lockheed-Martin a annoncé le lancement du projet Aurora, une collaboration avec Intel et Chips and Technologies. Un mois avant la sortie du i740, Intel a acquis 20% du projet Real3D et, en juillet 1997, il avait complètement acquis Chips and Technologies.

Une caractéristique clé du projet Real3D était l'utilisation de deux puces séparées pour le traitement des textures et des graphiques - Intel les a combinées pour créer le i740. L'adaptateur a utilisé une approche originale de la mise en mémoire tampon des données - le contenu du tampon de trame et les textures ont été chargés directement dans la RAM de l'ordinateur via le bus AGP. Dans les versions partenaires du i740, l'accès à la RAM se produisait uniquement si la propre mémoire tampon de l'adaptateur était complètement remplie ou fortement segmentée. La même approche est souvent utilisée aujourd'hui - lorsque la mémoire à bord de la carte vidéo est épuisée, le système augmente la mémoire tampon en utilisant la RAM libre.

Mais à une époque où les tampons étaient comptés en mégaoctets, et les textures n'étaient pas encore gonflées à des tailles indécentes, cette approche pouvait au moins sembler étrange.

Pour réduire les latences possibles lors du travail avec le bus, Intel a utilisé l'une de ses fonctionnalités - un accès direct à la mémoire tampon (Direct Memory Execute ou DiME). Cette méthode était également appelée texturation AGP et permettait d'utiliser la RAM de l'ordinateur pour mapper les textures, en les traitant de manière sélective. Des performances moyennes couplées à une qualité d'image médiocre ont permis à l'i740 d'atteindre le niveau des cartes de l'année dernière dans son segment de prix.

Pour le modèle avec 4 Mo de mémoire vidéo, ils ont demandé 119 $, et la version avec 8 Mo pour 149 $. De plus, en plus de la version de base d'Intel, seules deux options partenaires ont vu le jour - Real3D StarFighter et Diamond Stealth II G450.

Comptant sur le succès, Intel a commencé à développer la prochaine puce i752, mais ni les OEM ni les passionnés ne se sont montrés intéressés par un adaptateur économique qui est sérieusement en retard par rapport aux solutions actuelles. Et ce n'est pas surprenant, car en même temps ViRGE de S3 était en vente, dont l'achat plairait beaucoup plus à l'utilisateur. La production d'adaptateurs a été progressivement abandonnée et les puces i752 entrées sur le marché ont été réutilisées pour être utilisées en tant que solutions graphiques intégrées.

En octobre 1999, Lockheed-Martin a éliminé Real3D, et la main-d'œuvre aisée est allée à Intel et ATI.

ATI - De retour dans le jeu avec Rage Pro et Rage 128

ATI s'est rétabli avec le Rage Pro Turbo en février 1998, mais cette carte s'est avérée être juste une nouvelle image de la Rage Turbo avec des réglages de pilote pour des résultats exceptionnels dans des textes synthétiques. Les critiques de certaines publications ont été agréablement surpris, mais le prix de 449 $ était très difficile à justifier. Néanmoins, c'est avec le Rage Pro Turbo que le phénomène Finewine est apparu pour la première fois - les pilotes amélioraient progressivement les performances de l'adaptateur à chaque nouvelle révision.

ATI a tenté beaucoup plus sérieusement d'influencer l'équilibre des forces avec la sortie du Rage 128 GL et du Rage 128 VR en août de la même année. En raison de problèmes d'approvisionnement, ATI n'a pas pu assurer la disponibilité des modèles en magasin presque jusqu'aux vacances d'hiver, ce qui a grandement affecté la promotion des nouveaux produits. Contrairement aux contrats OEM, qui apportent systématiquement de sérieux bénéfices aux Canadiens, les passionnés ordinaires ne pouvaient pas apprécier le nouveau produit en raison du manque d'adaptateurs sur le marché. Mais il y avait une autre raison pour laquelle les ventes du Rage 128 étaient inférieures aux attentes.

ATI a préparé le Rage 128 pour un avenir graphique brillant en équipant le nouveau produit de 32 Mo de mémoire vidéo (des variantes de 16 Mo ont été produites sous la marque All-In-Wonder 128), qui a travaillé sur un sous-système rapide et efficace - en couleur 32 bits, le concurrent direct de NVidia Riva TNT n'avait pas aucune chance. Hélas, au moment de la sortie de la nouveauté, la plupart des jeux et des applications fonctionnaient toujours en mode 16 bits, où le Rage 128 ne se démarquait en rien sur le fond de NVidia et S3 (et en termes de qualité d'image, il était même inférieur aux modèles de Matrox). Le grand public n'a pas apprécié l'approche d'ATI, mais c'est alors que les Canadiens ont été en avance sur leur temps pour la première fois - seule leur approche a été appréciée beaucoup plus tard.

1998 a été une année record pour ATI - avec un chiffre d'affaires de 1,15 milliard de dollars, le bénéfice net de la société s'est élevé à 168,4 millions de dollars. L'entreprise canadienne a terminé l'année avec 27% du marché des accélérateurs graphiques.

En octobre 1998, ATI a acquis Chromatic Research pour 67 millions de dollars. La société, célèbre pour ses processeurs multimédia MPACT, était un fournisseur de solutions TV PC de Compaq et Gateway, offrant d'excellentes performances MPEG2, une qualité audio élevée et d'excellentes performances 2D. Ironiquement, c'est le seul inconvénient de MPACT sous la forme de mauvaises performances 3D qui a poussé Chromatic Research au bord de la faillite à peine 4 ans après sa fondation. Le temps des solutions universelles se rapprochait de plus en plus.

3Dfx Voodoo 2 et Voodoo Banshee - Échec réussi du leader du marché

Alors qu'Intel tentait de pénétrer le marché graphique, son leader en la personne de 3Dfx a introduit Voodoo 2, qui est devenu une percée technologique dans plusieurs domaines à la fois. Le nouvel adaptateur graphique de 3Dfx avait un design unique - en plus de la puce centrale, la carte avait deux processeurs de texture appariés, grâce auxquels la carte n'était pas seulement à trois puces, mais offrait également la possibilité de traitement multi-texture dans OpenGL (lorsque deux textures étaient appliquées à un pixel en même temps, accélérant le rendu global de la scène) qui n'a jamais été utilisé auparavant. Comme la Voodoo originale, la carte fonctionnait exclusivement en mode 3D, mais contrairement à ses concurrents qui combinaient les traitements 2D et 3D dans une seule puce, 3Dfx n'a fait aucun compromis, poursuivant l'objectif principal de défendre sa position de leader du marché.

Les versions professionnelles du nouvel adaptateur ne se sont pas fait attendre - la filiale 3Dfx Quantum3D a sorti trois accélérateurs remarquables basés sur la nouveauté - un Obsidian2 X-24 à deux puces, qui pourrait être utilisé en tandem avec une carte 2D, SB200 / 200Sbi avec 24 Mo de mémoire EDO à bord, ainsi que Mercury Heavy Metal - un sandwich exotique dans lequel les 200Sbi jumelés étaient interconnectés par une carte de contact Aalchemy, qui devint à l'avenir le prototype du célèbre pont NVidia SLI.

Mercury Heavy Metal

Ce dernier a été conçu pour des simulations graphiques complexes et était disponible pour un prix d'espace de 9999 $ . Le monstre MHM nécessitait une carte mère de serveur Intel BX ou GX avec quatre emplacements PCI pour fonctionner correctement.

Conscient de l'importance du contrôle sur le marché du budget, 3Dfx a présenté en juin 1998 Voodoo Banshee - le premier accélérateur graphique prenant en charge les modes de fonctionnement 2D et 3D. Contrairement aux attentes et aux espoirs, la légendaire puce Rampage n'était jamais prête, et la carte ne comportait qu'une seule unité de traitement de texture à bord, ce qui détruisait pratiquement les performances de la nouveauté dans le rendu multi-polygonal - Voodoo 2 était plusieurs fois plus rapide. Mais même si une production économique avec une marque reconnaissable assurait de bonnes ventes à Banshee, la déception des fans n'a disparu nulle part - on attendait beaucoup plus de la part des créateurs de «that very Voodoo», qui a transformé du jour au lendemain le marché graphique.

De plus, malgré le leadership de Voodoo 2, l'écart avec les concurrents diminuait rapidement. Après avoir imposé une concurrence sérieuse à ATI et à NVidia, 3Dfx a fait face à des solutions de plus en plus avancées, et uniquement grâce à une gestion efficace (3Dfx a produit et vendu les cartes elle-même, sans la participation de partenaires), la société a réalisé un bénéfice significatif des ventes. Mais la direction de 3Dfx a vu de nombreuses opportunités en acquérant ses propres usines pour la production de plaquettes de silicium.La société a donc acheté STB Technologies pour 131 millions de dollars dans l'espoir de réduire considérablement les coûts de production et d'imposer la concurrence aux fournisseurs Nvidia (TSMC) et ATI (UMC). Cet accord est devenu fatal dans l'histoire de 3Dfx - les usines mexicaines de STB étaient désespérément en retard par rapport aux concurrents asiatiques en termes de qualité des produits, et ne pouvaient pas rivaliser dans la course au processus technologique.

Après l'acquisition de STB Technologies, la plupart des partenaires 3Dfx n'ont pas soutenu la décision douteuse et sont passés aux produits NVidia.

Nvidia TNT - Demande de leadership technique

Et la raison en était le Riva TNT introduit par Nvidia le 23 mars 1998. En ajoutant un pipeline de pixels parallèle à l'architecture Riva, les ingénieurs ont doublé la vitesse de rendu et de rendu, ce qui, associé à 16 Mo de mémoire SDR, a considérablement augmenté les performances. Le Voodoo 2 utilisait une mémoire EDO beaucoup plus lente - et cela donnait au nouveau produit de Nvidia un avantage significatif. Hélas, la complexité technique de la puce a porté ses fruits - en raison d'erreurs matérielles dans la production de la puce TSMC 350 nm ne fonctionnant pas sur le 125 MHz conçu par les ingénieurs - la fréquence a souvent chuté à 90 MHz, c'est pourquoi Voodoo 2 a pu conserver le titre de leader formel de la performance.

Mais même avec tous ses défauts, le TNT était un nouveau produit impressionnant. Grâce à l'utilisation du bus AGP à double canal, la carte a pris en charge des résolutions de jeu jusqu'à 1600x1200 avec des couleurs 32 bits (et un tampon Z 24 bits pour assurer la profondeur de l'image). Dans le contexte de Voodoo 2 16 bits, le nouveau produit de nVidia ressemblait à une véritable révolution graphique. Si TNT n'était pas le leader des benchmarks, il restait dangereusement proche du Voodoo 2 et du Voodoo Banshee, offrant plus de nouvelles technologies, une meilleure mise à l'échelle à la fréquence du processeur et un traitement 2D et de texture de meilleure qualité grâce au bus AGP progressif. Le seul inconvénient, comme dans le cas du Rage 128, était les retards de livraison - un grand nombre d'adaptateurs ne sont apparus en vente qu'à l'automne, en septembre 1998.

Une autre tache sur la réputation de Nvidia en 1998 a été un procès intenté par SGI, selon lequel NVidia a violé les droits de brevet pour sa technologie interne de mappage de texture. À la suite du litige, qui a duré un an, un nouvel accord a été conclu, selon lequel NVidia a eu accès aux technologies SGI, et SGI a eu l'opportunité d'utiliser les développements de Nvidia. Dans le même temps, la division graphique de SGI elle-même est dissoute, ce qui ne profite qu'au futur leader graphique.

Numéro neuf - Étape latérale

Pendant ce temps, le 16 juin 1998, le fabricant de graphiques OEM Number Nine a décidé de tenter sa chance sur le marché des cartes graphiques en lançant une carte Revolution IV sous sa propre marque.

En retard sur les solutions phares d'ATI et de Nvidia, Number Nine s'est concentré sur le secteur des affaires, offrant aux grandes entreprises ce que les cartes classiques pour les jeux et les graphiques 3D étaient faibles: la prise en charge de hautes résolutions en couleur 32 bits.

Pour susciter l'intérêt des grandes entreprises, Number Nine a intégré un connecteur propriétaire OpenLDI à 36 broches dans sa Revolution IV-FP et a vendu la carte avec un moniteur SGI 1600SW de 17,3 pouces (prenant en charge une résolution de 1600x1024). L'ensemble coûte 2795 $.

L'offre n'a pas eu beaucoup de succès et Number Nine est revenu au partenariat des cartes S3 et Nvidia jusqu'à ce qu'il soit acheté par S3 en décembre 1999, puis vendu aux anciens ingénieurs de la société qui ont formé Silicon Spectrum en 2002.

S3 Savage3D - Une alternative économique à Voodoo et TNT pour 100 $

Le champion du budget en la personne de S3 Savage a fait ses débuts à l'E3 1998, et contrairement aux dominateurs qui souffrent depuis longtemps dans le segment ci-dessus (Voodoo Banshee et Nvidia TNT) sont arrivés dans les rayons des magasins un mois après l'annonce. Malheureusement, le rush ne pouvait pas passer inaperçu - les pilotes étaient "bruts" et le support d'OpenGL n'était implémenté que dans Quake, car S3 ne pouvait pas se permettre d'ignorer l'un des jeux les plus populaires de l'année.

Les fréquences du S3 Savage n'étaient pas non plus lisses. En raison de défauts de fabrication et d'une consommation d'énergie élevée, les modèles d'adaptateur de référence sont devenus très chauds et n'ont pas fourni le seuil de fréquence prévu de 125 MHz - la fréquence flottait généralement entre 90 et 110 MHz. Dans le même temps, des critiques de publications de premier plan ont mis la main sur des échantillons d'ingénierie qui fonctionnaient correctement à 125 MHz, ce qui a fourni de beaux chiffres dans toutes sortes de repères, ainsi que les éloges de la presse spécialisée. Plus tard, dans les modèles partenaires, les premiers problèmes ont été résolus - Savage3D Supercharged fonctionnait de manière stable à 120 MHz, et Terminator BEAST (Hercules) et Nitro 3200 (STB) ont conquis la barre convoitée de 125 MHz.Malgré les pilotes bruts et les performances médiocres dans le contexte des dirigeants des Big Three, le prix démocratique à moins de 100 $ et la possibilité de lire des vidéos de haute qualité ont permis au S3 de réaliser de bonnes ventes.

1997 et 1998 ont été une autre période d'acquisitions et de faillites - de nombreuses entreprises n'ont pas pu supporter la concurrence dans la course à la performance et ont été contraintes de quitter l'industrie. Ainsi, Cirrus Logic, Macronix et Alliance Semiconductor ont été laissés pour compte, tandis que Dynamic Pictures a été vendu à 3DLabs, Tseng Labs et Chromatic Research ont été rachetés par ATI, Rendition a quitté Micron, AccelGraphics a acquis Evans & Sutherland et Chips and Technologies est devenu une partie d'Intel.

Trident, S3 et SiS - La bataille finale du millénaire pour les graphiques budgétaires

Le marché OEM a toujours été la dernière goutte pour les fabricants à la traîne désespérément derrière la concurrence en matière de graphismes 3D et de performances. C'était également le cas pour SiS, qui a débloqué le budget SiS 300 pour les besoins du secteur des entreprises. Malgré des performances 3D déplorables (limitées par un seul pipeline de pixels) et un décalage 2D désespéré par rapport à tous les concurrents du marché grand public, le SiS 300 a conquis les OEM avec certains avantages - un bus mémoire de 128 bits (64 bits dans le cas du SiS 305 plus simplifié), prise en charge de la couleur 32 bits, DirectX 6.0 (et même 7.0 dans le cas du 305), prise en charge du rendu multi-textures et du décodage matériel MPEG2. Il y avait une carte graphique et une sortie TV.

En décembre 2000, le SiS 315 modernisé a vu le jour, doté d'un deuxième pipeline de pixels et d'un bus de 256 bits, ainsi que d'une prise en charge complète de DirectX 8.0 et de l'anti-crénelage plein écran. La carte dispose d'un nouveau moteur de traitement d'éclairage et de texture, de compensation des retards lors de la lecture de vidéo à partir d'un DVD et de la prise en charge du connecteur DVI. Le niveau de performance était dans la région de la GeForce 2 MX 200, mais cela ne dérangeait pas du tout l'entreprise.

SiS 315 est également entré sur le marché OEM, mais déjà dans le cadre du chipset SiS 650 pour cartes mères sur socket 478 (Pentium IV) en septembre 2001, et également dans le cadre du système SoC SiS552 en 2003.

Mais SiS était loin d'être le seul constructeur à proposer des solutions intéressantes dans le segment des budgets. Trident s'est également battu pour attirer l'attention des acheteurs avec le Blade 3D, dont les performances globales étaient comparables à celles de l'Intel i740 en panne, mais le prix de 75 $ a plus que couvert de nombreuses lacunes. Plus tard, Blade 3D Turbo est entré sur le marché, dans lequel les fréquences sont passées de 110 à 135 MHz, et les performances globales ont atteint le niveau de i752. Malheureusement, Trident a mis trop de temps à développer ses solutions pour le marché, où de nouveaux produits étaient présentés tous les deux mois, donc déjà en avril 2000, cela a porté le premier coup dur à l'entreprise - VIA, pour laquelle Trident développait des graphiques intégrés, a acquis la société S3 et a cessé de coopérer avec la première. partenaire.

Cependant, Trident a pleinement exploité son modèle commercial, combinant des expéditions en vrac et des coûts de fabrication bas pour ses solutions budgétaires. Le marché mobile est resté relativement vacant, et Trident a développé plusieurs modèles Blade3D Turbo spécialement pour lui - le T16 et T64 (fonctionnant à 143 MHz) et XP (fonctionnant à 165 MHz). Mais le marché OEM qui attirait de nombreuses entreprises ne soutenait plus la simplicité de Trident - le SiS 315, sorti un peu plus tard, donnait un échec et un échec à toute la gamme de produits Trident. Incapable de développer rapidement une alternative viable, Trident a décidé de vendre la division graphique à la filiale XGI de SiS en 2003.

S3 Savage4 se démarque des autres solutions du secteur budgétaire. Annoncé en février et mis en vente en mai 1999, le nouveau produit offrait 16 et 32 Mo de mémoire embarquée, un bus AGP à quatre canaux 64 bits et sa propre technologie de compression de texture, grâce à laquelle l'adaptateur pouvait gérer des blocs avec des résolutions allant jusqu'à 2048x2048 sans trop de difficulté (bien que cela et a été implémenté plus tôt dans Savage3D). La carte était également capable de rendu multitextural, mais même les pilotes débogués et les caractéristiques techniques impressionnantes ne pouvaient pas cacher le fait que les offres de l'année dernière de 3Dfx, Nvidia et ATI étaient nettement plus productives. Et cet état de fait s'est répété un an plus tard, lorsque le Savage 2000 est entré sur le marché. À basse résolution (1024x768 et moins), le nouveau produit pourrait concurrencer Nvidia TNT et Matrox G400.mais quand une résolution plus élevée a été choisie, l'équilibre des forces a changé radicalement.

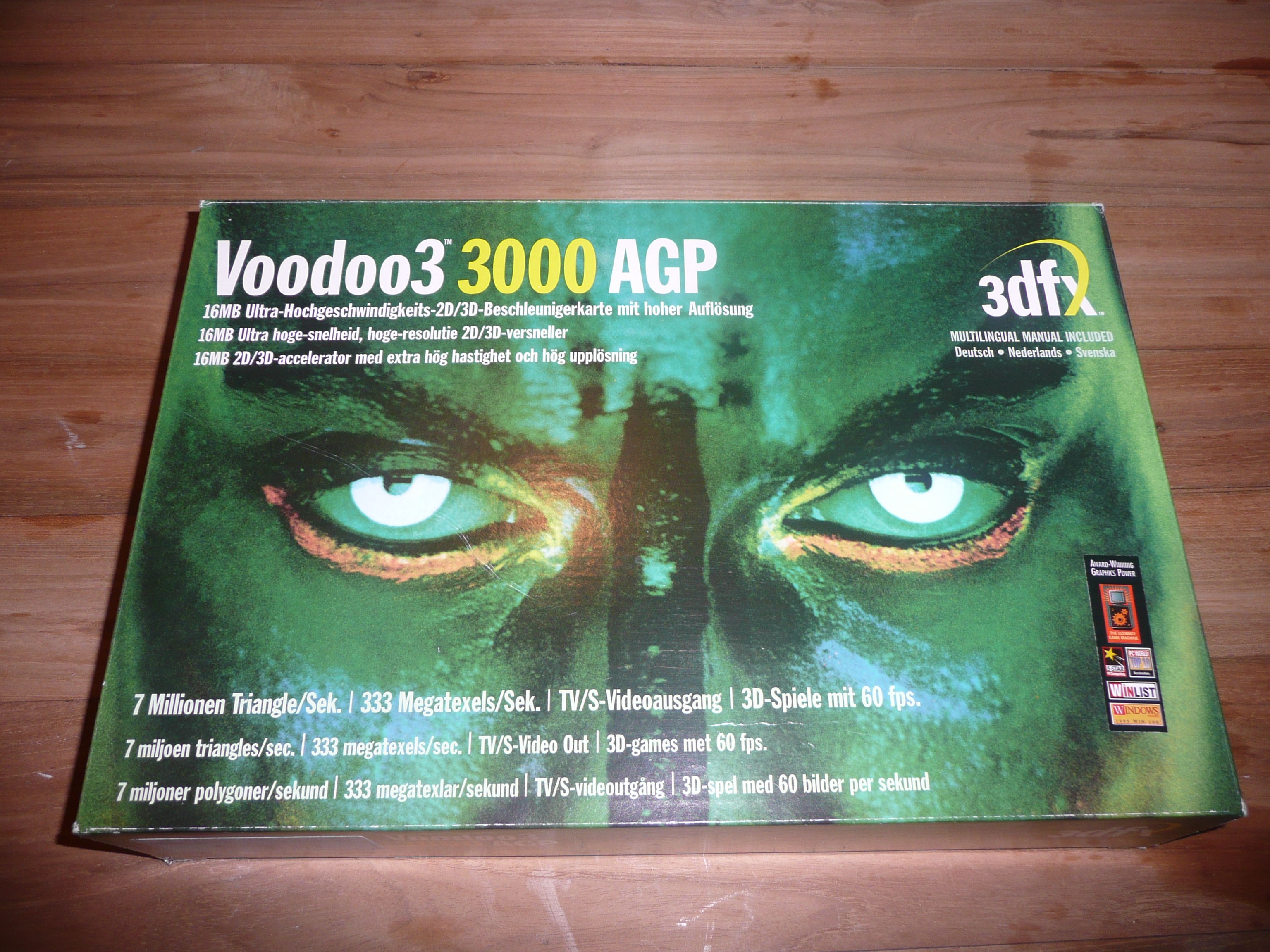

3Dfx Voodoo3 - Paphos, bruit et excuses vides

3Dfx ne pouvait pas laisser son nouveau produit se perdre dans le contexte de concurrents progressistes, de sorte que la première de Voodoo3 en mars 1999 a été accompagnée d'une vaste campagne publicitaire - la carte a été vivement promue dans la presse et à la télévision, et le design audacieux de la boîte a attiré les yeux des acheteurs potentiels qui rêvaient d'une nouvelle révolution graphique.

Hélas, le chipset Rampage, qui est devenu le sujet de conversation de la ville, n'était toujours pas prêt, et la nouveauté architecturale était un parent du Voodoo2 basé sur la puce Avenger. Les technologies archaïques comme la prise en charge de la résolution de couleurs et de texture 16 bits exclusivement de 256x256 n'ont pas plu aux fans de la marque, tout comme l'absence totale de prise en charge du traitement matériel de l'éclairage et de la géométrie. De nombreux fabricants ont déjà introduit la mode pour les textures haute résolution, le rendu multi-polygonal et la couleur 32 bits, donc pour la première fois, 3dfx était parmi les retardataires à tous égards.

Les investisseurs ont dû expliquer la perte de 16 millions de dollars due au récent tremblement de terre à Taiwan, qui a cependant eu peu d'impact sur le succès financier d'ATI et de Nvidia. Consciente des avantages évidents de la distribution gratuite des bibliothèques DirectX et OpenGL, la société a annoncé en décembre 1998 que son API Glide serait disponible en open source. Certes, à cette époque, il n'y avait guère trop de gens disposés.

Riva TNT2 et G400 - Les concurrents en avance

Simultanément à la première explosive de Voodoo3 de 3Dfx, Nvidia a modestement présenté son RIVA TNT 2 (avec les premières cartes de la série Ultra de leur histoire, où les joueurs ont reçu des fréquences de cœur et de mémoire plus élevées), et Matrox a présenté le tout aussi impressionnant G400.

Riva TNT2 a été fabriqué à l'aide de la technologie 250 nm dans les usines TSMC et a pu fournir à Nvidia un niveau de performance sans précédent. La nouveauté a écrasé Voodoo3 presque partout - l'exception était seulement quelques jeux qui utilisaient AMD 3DNow! Combiné avec OpenGL. Nvidia a également suivi la technologie - la série TNT2 comportait un connecteur DVI pour prendre en charge les derniers moniteurs à écran plat.

Une vraie surprise pour tout le monde a été Matrox G400, qui s'est avéré être encore plus productif que TNT2 et Voodoo3, à la traîne uniquement dans les jeux et les applications utilisant OpenGL. Pour son prix abordable de 229 $, le nouveau produit de Matrox offrait une excellente qualité d'image, des performances enviables et la possibilité de connecter deux moniteurs via un connecteur DualHead couplé. Le deuxième moniteur était limité à une résolution de 1280x1024, mais beaucoup de gens ont aimé l'idée.

Le G400 comprend également EMBM (Environment Mapped Bump Mapping) pour améliorer le rendu global des textures. Pour ceux qui ont toujours préféré acheter le meilleur, il y avait la G400 MAX, qui détenait le titre de la carte la plus productive du marché jusqu'à la sortie de la GeForce 256 avec mémoire DDR début 2000.

Matrox Parhelia 3DLabs Permedia –

Le grand succès sur le marché des accélérateurs graphiques de jeu n'a pas inspiré Matrox, qui est revenu sur le marché professionnel, une seule fois tenté de répéter le succès du G400 avec Parhelia, mais en 2002, les concurrents maîtrisaient déjà DirectX 9.0 avec puissance et principal, et le support de trois moniteurs s'est effacé simultanément sur fond de performances de jeu déplorables.

Alors que le public avait déjà réussi à digérer les sorties bruyantes de trois entreprises, 3DLabs a présenté Permedia 3 Create! La principale caractéristique de la nouveauté était le positionnement de niche - 3DLabs espérait attirer l'attention des professionnels qui préféraient passer leur temps libre dans les jeux. L'entreprise s'est concentrée sur la haute performance en 2D et a attiré des spécialistes de Dynamic Pictures acquis en 1998, les auteurs de la gamme professionnelle d'adaptateurs Oxygène.

Malheureusement pour 3DLabs, la modélisation de polygones complexes était une priorité dans les cartes professionnelles, et souvent des performances élevées dans cette direction étaient fournies par une diminution importante de la vitesse de traitement des textures. Les adaptateurs de jeu avec priorité en 3D fonctionnaient exactement le contraire - au lieu de calculs complexes, la vitesse de rendu et le traitement des textures avec une qualité d'image élevée étaient au premier plan.

Loin derrière les Voodoo3 et TNT 2 dans les jeux, et pas trop loin de la concurrence dans les applications de travail et les tâches, Permedia était la dernière tentative de 3DLabs pour amener un produit sur le marché des adaptateurs de jeu. En outre, les célèbres ingénieurs graphiques ont continué à développer et à soutenir leurs lignes spécialisées - GLINT R3 et R4 sur l'architecture Oxygen, où l'abondance de modèles allait du budget VX-1 pour 299 $ au GVX 420 haut de gamme pour 1499 $.

Le répertoire de la société comprenait également la gamme d'adaptateurs Wildcat, basée sur les développements d'Intense3D, achetés à Integraph en juillet 2000. En 2002, alors que 3DLabs achevait activement le développement de puces graphiques avancées pour les nouveaux adaptateurs Wildcat, la société a été rachetée par Creative Technology avec ses plans pour les lignes P9 et P10.

En 2006, la société a quitté le marché des ordinateurs de bureau, se concentrant sur des solutions pour le marché des médias, puis est devenue une partie du Creative SoC, et est devenue connue sous le nom de ZiiLab. L'histoire de 3DLabs s'est finalement terminée en 2012 lorsque la société a été rachetée par Intel.

ATI Rage MAXX - Lagging de folie à double puce

Depuis la sortie du Rage 128 à succès, ATI a rencontré un certain nombre de difficultés avec le développement ultérieur de la ligne. À la fin de 1998, les ingénieurs ont mis en œuvre avec succès la prise en charge du bus AGP 4x dans une version mise à jour de l'adaptateur Rage 128 Pro, ajoutant une sortie TV au nombre de connecteurs. En général, la puce graphique s'est montrée approximativement au niveau de TNT 2 en termes de performances de jeu, mais après la sortie de TNT 2 Ultra, le championnat est de nouveau passé à Nvidia, que les Canadiens ne voulaient pas supporter - les travaux sur le projet Aurora ont commencé.

Lorsqu'il est devenu clair que la course à la performance était perdue, les ingénieurs ont eu recours à une astuce qui deviendra l'une des caractéristiques de nombreuses générations de cartes rouges à l'avenir: ils ont sorti la Rage Fury MAXX, une carte graphique à double puce, sur laquelle étaient alimentés deux Rage 128 Pros.

Rage Fury MAXX