L'IA apprend à générer des images à partir de signatures et commence à mieux comprendre notre monde

De tous les modèles d'intelligence artificielle, c'est le GPT-3 d'OpenAI qui a le plus captivé l'imagination du public. Elle, sans trop de motivation, peut cracher des poèmes, des histoires courtes et des chansons, vous faisant penser que ce sont le travail d'une personne. Mais l'éloquence n'est qu'un gadget et ne doit pas être confondue avec la vraie intelligence.

Cependant, les chercheurs pensent que les mêmes techniques utilisées pour créer GPT-3 cachent un secret pour créer une IA plus avancée . GPT-3 a été formé sur une énorme quantité d'informations textuelles. Et si les mêmes techniques étaient entraînées simultanément sur du texte et des images?

Une nouvelle étude appelée AI2 de l'Institut Paul Allen pour l'intelligence artificielle a porté cette idée au niveau supérieur. Les chercheurs ont créé un modèle spécial visu-linguistique. Il fonctionne avec du texte et des images et peut générer ces derniers à partir de signatures. Les images semblent troublantes et étranges, pas du tout comme les deepfakes hyperréalistes créés par les réseaux antagonistes génératifs (GAN). Mais ils peuvent montrer une nouvelle direction pour une intelligence plus pratique, et peut-être rendre les robots plus intelligents.

Comblez le vide

Le GPT-3 appartient à un groupe de modèles appelés «transformateurs». Ils ont d'abord gagné en popularité grâce au succès de BERT, l'algorithme de Google. Avant BERT, les modèles de langage étaient plutôt mauvais. Leurs capacités prédictives étaient suffisantes pour la saisie semi-automatique, mais pas pour la composition de phrases longues, où les règles de grammaire et le bon sens sont observés.

BERT a changé la situation en introduisant une nouvelle technique appelée masquage ( note - le nom d'origine est masquage). Cela implique que différents mots se cachent dans la phrase et que le modèle doit combler le vide. Exemples:

- La femme est allée à ___ pour pratiquer.

- Ils ont acheté ___ pain pour faire des sandwichs.

L'idée est que si vous forcez le modèle à faire ces exercices, souvent un million de fois, il commencera à découvrir des modèles dans la façon dont les mots sont assemblés en phrases et les phrases sont assemblées en paragraphes. En conséquence, l'algorithme génère et interprète mieux le texte, se rapprochant de la compréhension du sens de la langue. (Google utilise maintenant BERT pour fournir des résultats de recherche plus pertinents.) Après que le masquage s'est avéré extrêmement efficace, les chercheurs ont essayé de l'appliquer aux modèles de langage visuel en cachant des mots dans les signatures. De cette façon:

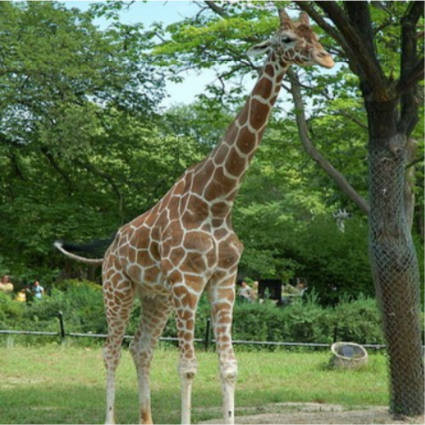

____ est au sol à côté d'un arbre. Source: AI2

Cette fois, le modèle pourrait examiner les mots environnants et le contenu de l'image pour combler le vide. Après un million de répétitions, elle a appris à détecter non seulement les modèles de mots, mais aussi la connexion des mots avec les éléments de chaque image.

En conséquence, les modèles peuvent lier les relations textuelles à des exemples visuels de la façon dont les bébés établissent des liens entre les mots appris et les choses qu'ils voient. Les mannequins peuvent prendre la photo ci-dessous et créer une légende significative, telle que «Les femmes jouent au hockey sur gazon». Ou ils peuvent répondre à une question comme «De quelle couleur est la balle» en associant le mot «balle» à un objet circulaire dans une photographie.

Un modèle de langage visuel peut faire une légende significative pour cette photographie: «Les femmes jouent au hockey sur gazon». Source: JOHN TORCASIO / UNSPLASH

Mieux vaut voir une photo une fois

Les chercheurs voulaient savoir si ces modèles développaient une compréhension conceptuelle du monde visuel. Un enfant qui a appris un mot pour un objet peut non seulement le nommer, mais aussi dessiner l'objet en fonction de l'indice, même si l'objet lui-même est absent. L'équipe du projet AI2 a donc suggéré aux modèles de faire de même: générer des images à partir de légendes. Tous les modèles ont donné des déchets de pixels inutiles.

Est-ce un oiseau? C'est un avion? Non, c'est du charabia, généré par l'intelligence artificielle. Source: AI2

Cela a du sens: convertir du texte en image est plus difficile que de faire le contraire. «La signature ne définit pas tout sur l'image», déclare Ani Kembhavi, chef de l'équipe de vision par ordinateur d'AI2. Ainsi, le modèle doit s'appuyer sur une grande quantité de connaissances sur notre monde pour ajouter des détails manquants.

Par exemple, si on demande à un mannequin de dessiner une «girafe marchant le long d'une route», alors elle doit conclure que la route sera grise plutôt que rose vif et passera à côté d'un champ plutôt que de la mer. Bien que toutes ces informations ne soient pas explicites.

Kembhavi et ses collègues Jemin Cho, Jiasen Lu et Hannane Hajishirzi ont donc décidé de voir s'ils pouvaient enseigner au modèle toutes ces connaissances visuelles cachées en peaufinant l'approche du masquage. Au lieu d'entraîner l'algorithme pour simplement prédire les mots "masqués" dans les légendes des photos correspondantes, ils l'ont également entraîné pour prédire les pixels "masqués" dans les photos sur la base des légendes correspondantes.

Les images finales créées par le modèle ne sont pas entièrement réalistes. Mais ce n'est pas important. Ils contiennent les bons concepts visuels de haut niveau. L'IA se comporte comme un enfant dessinant un bâton de tableau de bord pour représenter une personne. (Vous pouvez tester le modèle vous-même ici ).

Exemples d'images générées par le modèle AI2 à partir de légendes. Source: AI2

La capacité des modèles de langage visuel à générer de telles images représente une étape importante dans la recherche sur l'intelligence artificielle. Cela suggère que le modèle est en fait capable d'un certain niveau d'abstraction - une compétence fondamentale pour comprendre le monde.

À long terme, la compétence peut avoir des implications importantes pour la robotique. Mieux le robot comprend l'environnement et utilise le langage pour communiquer, plus il pourra effectuer des tâches complexes. À court terme, note Hajishirzi, la visualisation aidera les chercheurs à mieux comprendre ce que le modèle apprend, qui fonctionne maintenant comme une boîte noire.

À l'avenir, l'équipe prévoit d'expérimenter davantage, d'améliorer la qualité de la génération d'images et d'élargir le visuel et le vocabulaire du modèle: pour inclure plus de sujets, d'objets et d'adjectifs.

«La création des images était vraiment la pièce manquante du puzzle», explique Lu. "En l'ajoutant, nous pouvons enseigner au modèle à mieux comprendre notre monde."