Systèmes de recommandation à partir de zéro, chatbots et plus

Après avoir plongé dans l'abîme des données textuelles, nous avons formé en octobre de cette année les modèles ruGPT-3 - des modèles pour la langue russe basés sur l'architecture d'OpenAI. Mais de quoi ces modèles sont-ils capables? Dans cet article, nous rassemblerons les premiers exemples d'application du modèle - et en essayerons de nouveaux.

Nous présentons les premiers résultats du plus grand modèle entraîné, ruGPT-3 Large, développé en collaboration avec les équipes SberDevices , Sber.AI et SberCloud . Explorons avec vous les limites de son application.

Lors de AI Journey de cette année, nous avons préparé un concours d' applications ruGPT-3 - toute solution utilisant un modèle, évaluée à trois échelles - innovation, engagement émotionnel et applicabilité commerciale - peut être soumise à la piste.

Divulgacher:

1

Comment recycler le modèle pour une nouvelle tâche?

Les modèles et leur code se trouvent dans le référentiel sberbank-ai : vous pouvez utiliser la bibliothèque de transformers ou Megatron-LM.

Dans cet article, je donne des exemples utilisant huggingface / transformers - le code des cas est donné ici:

- Mise au point des modèles d' ordinateurs portables Colab

- Générer simplement un ordinateur portable Colab

Cartes de modèle dans la bibliothèque de transformateurs: Grand Moyen Petit

Lorsque vous exécutez le script de génération, il est plus facile de tout exécuter - puis d'attendre un peu le chargement du modèle.

Le script dans la dernière cellule vous demandera d'entrer le début du texte - ma graine préférée: "Les scientifiques brésiliens ont découvert une espèce rare de licornes naines qui vivent dans l'ouest du Jutland." Nous obtenons : Seul le ruGPT-3 Small s'intègre dans un ordinateur portable Colab, il est donc préférable d'utiliser des cartes avec plus de 14 Go de mémoire.

ruGPT-3 Small: , . Agence France-Presse. , Pygmaliona (. Pygmaliona pygmalioni), . 30 , — 1 . . , .

D'ailleurs, pendant toute la durée de la compétition, nous donnons aux participants de la piste accès aux installations de Christofari!

Pour les participants de la piste ruGPT-3, nous avons alloué 100 comptes - dans chaque compte 1 GPU Tesla V100-SXM3 32 Go gratuitement pendant la compétition.

Comment obtenir un compte?

1) Inscrivez-vous à la piste ruGPT-3 (AI 4 Humanities) ods.ai/tracks/aij2020

2) Écrivez une courte lettre avec le nom de votre équipe et la tâche à AIJ_ruGPT-3@sberbank.ru

Quelques coups vs réglage fin

Dans le cas de grands modèles génératifs tels que les architectures de type GPT, il existe plusieurs façons de les «gérer».

?

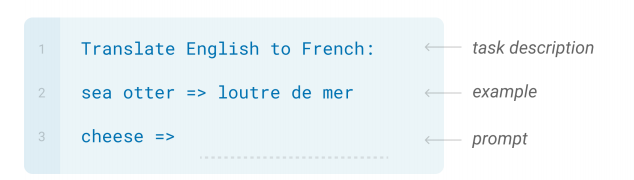

Il peut être très coûteux de recycler les grands modèles, donc cette façon de «communiquer» avec eux vous permet même d'éviter cela. L'essence de la programmation des semences est de sélectionner de tels exemples préparés et des débuts de génération, de sorte que le modèle produise exactement ce qui est nécessaire.

En choisissant les hyperparamètres "seed" et générateur (température, top_n, top_k), il est possible d'obtenir des réponses tout à fait tolérables grâce à un seul apprentissage préalable du modèle.

Un exemple de départ avec 1 exemple et une description du problème.

Nous testerons les deux méthodes dans la pratique - nous essaierons de résoudre des problèmes courants à partir de zéro et des problèmes spécifiques - avec une formation supplémentaire.

Systèmes de recommandation

Faisons un système de recommandation sans formation: nous soumettrons à ruGPT-3 De grandes informations sur les préférences de l'utilisateur sous forme de texte, et nous verrons comment le modèle continue. Nous pouvons générer plusieurs options à la fois pour obtenir plus de recommandations.

Recommandations de films: pas mal! Au moins, les films semblent être générés en fonction de la graine. Comme je ne suis pas un connaisseur du cinéma soviétique, je ne connaissais même pas le film "Trois plus deux", mais c'est le cas. Pour la génération, nous avons utilisé les hacks suivants - nous avons spécialement fourni le texte avec un guillemet ouvert pour forcer le modèle à générer des noms propres, et également couper tout ce qui est inutile après la première phrase. Recommandations musicales:

: — “”, “”, “

ruGPT-3 Large: — “”, “”, “ ”, “ ”, “ ”.

ruGPT-3 Large: — “”, “”, “ ”, “”, “” (, , , ).

ruGPT-3 Large: — “”, “”, “” .”

: : “ ”, “

ruGPT-3 Large: : “ ”, “ ” “ ”.

ruGPT-3 Large: : “ ”, “ ”.

ruGPT-3 Large: : “ ”, “ ”, “ ” .

: “ , “ ”, “ #( , )

ruGPT-3 Large: , “ ”, “” “”.

ruGPT-3 Large: , “ ”, “” “ ”.

ruGPT-3 Large: , “ ”, “”, “ ”, “ ”, “” “”.

Les résultats sont différents tout le temps - vous pouvez potentiellement générer N variantes, extraire tous les noms de groupe et collecter le compteur des plus populaires - voilà, un système de recommandation à partir de zéro.

Générer des avis

Prenons une tâche plus difficile - faisons en sorte que le modèle imite une personne dans des discussions ou des magasins: Comme vous pouvez le voir, pour des sujets répandus sur Internet, le modèle peut générer des textes cohérents sans formation. Mais où est-il toujours impossible sans formation supplémentaire? Il existe 3 cas de ce type:

: “ .

- ”

ruGPT-3 Large: “ .

- . , .”

: “ .

”

ruGPT-3 Large: “ .

.

, .

, , . , , .”

: .

"1+1"

ruGPT-3 Large: .

"1+1" — , . . . . " ", .

- format de données complexe - si, pendant la génération sans formation, vous perdez de la qualité en raison d'une génération dans le mauvais format - problème NER, génération de code, calculs symboliques, etc.

- , — QA , , , ;

- , , , — , .

StackOverflow

Élevons la barre de la complexité: téléchargez le [stack overflow] russe (https://ru.stackoverflow.com/) et essayez de créer un système de questions-réponses. Pourrons-nous apprendre immédiatement le style des réponses, des connaissances et plusieurs langages de programmation? Il n'est pas facile d'obtenir un bon résultat dans un problème de taoki tout de suite, mais nous pouvons nous amuser - sur 5 époques, le modèle a appris à reproduire le style, devenant très confus dans le contenu. Mais j'ai bien appris les liens vers la documentation - un assez bon résultat pour 5 époques d'apprentissage.

Format de la formation: nous soumettons les textes des questions et des meilleures réponses au format Q: «blabla» A: «blabla». (il n'existe en fait aucune bibliothèque de ce type, le modèle a généré un lien vers la documentation)

Q: python?

A: : push.log("Shalom").

- , .

set.log()**)

rGet = puts.random(extents) log.findIndex(puts.current) void join($window, command='unsetMainServer onManager') }

,

Q: python?

A: import pycode as pyc;

// ( href=https://docs.python.org/3/library/pycode.html )

Pour de telles tâches, vous pouvez entrer des arguments supplémentaires - par exemple, le nom de la section / sujet / langage de programmation, à propos de laquelle vous voulez répondre, et entraîner le modèle sur des données de la forme {"paramètre": "valeur", "question": "text_question", "réponse": "Answer_text"}.

En ce qui concerne à la fois le code et le texte, nous avons un fichier tout de suite - peut-être que quelqu'un fera mieux dans la piste? Il existe déjà des implémentations assez réussies sur le modèle de langue anglaise avec code: écriture de code html d'éléments de page Web, génération de modèles Figma.

Essayer d'autres langues! Twitter et plus

La langue principale d'enseignement du modèle est le russe, mais est-il possible d'appliquer le modèle à des tâches multilingues? Quelques autres langues font toujours partie de l'échantillon de formation sur le Web, il y a donc de l'espoir. Une approche simple avec des graines montre que le modèle en sait un peu plus sur le modèle anglais: Eh bien, presque: Parfois cela ne fonctionne pas du tout: Pourquoi ne pas pratiquer sur des données purement anglaises: j'ai pris le jeu de données de classification Twitter-text du concours Kaggle. Après 5 époques sur 5000 premiers commentaires (20 minutes en Colab ), nous obtenons une génération assez tolérable de commentaires très toxiques en anglais:

ruGPT-3 Large:

—> cat

—> dog

—> pear

—> coder

—> cat

—> dog

—> pear

—> Python

—> cat

—> dog

—> pear

—> bunch #

—> dog

—> cat

—> dog

Context >>> Is it

ruGPT-3 Small: Is it's the case that #Microsoft is using #SAP to manage #Microsoft’s business?

Context >>> It is

ruGPT-3 Small: It is the only one that I've been trying to do. Siri is on the verge of death, and I'm not aware of why she has to be on the verge.

Context >>> Why

ruGPT-3 Small: Why do I go here? I'm wondering if I can use the #Microsoft Windows 8 Pro for the #WindowsPhone phone? Thanks!

Systèmes de dialogue

Déjà, sans pré-formation, l'application du modèle aux systèmes de dialogue fonctionne plutôt bien: le modèle peut exécuter la fonction de bavardage (ne parler de rien), en discutant librement sur divers sujets. Avec une formation supplémentaire sur des scénarios et des domaines spécifiques, vous pouvez implémenter des applications métier.

L'exemple ci-dessous est un exemple de dialogue sans formation, sur un sujet étroitement ciblé - l'assistance d'un fournisseur Internet.

Semis: 2 premières lignes - génération supplémentaire. Bien sûr, sans pré-formation, le modèle n'a pas une idée claire des scripts et des scripts des spécialistes du support, cependant, même un tel démarrage à froid montre déjà la manière standard de «découvrir ce qui s'est passé - traîner - rediriger l'appel». Vous vous souvenez des classiques:

User1: , ! ?

User2: .

User1: ?

User2: 500

User1: ?

User2: . .. .

User1: ?

User2: . , - ...

User1: , , , , ?

User2:

User1: , . , .

User2: , . .

User1: . , , .

User2: , , ?

User1: ?

User2: . .

User1: ?

User2:

User1: . .

User1: , . - .

User2: , .

User1:

User2:

User1: «», 656, , .

User2: , 766—1669, : , , , , , , ?

User1: 1 . , , .

User2: , , , - ?

User1: , 1 . , - , , , . .

User2: , , , , - .

User1: .

User2: , ?

User1: , , .

User2: , , .

En général, «il faut être patient». Le modèle s'est même souvenu que le nom de User1 est Dmitry, et User2 lui a dit au revoir en conséquence.

Au lieu d'une conclusion

Pour continuer à développer l'orientation des modèles génératifs et améliorer les architectures dans les problèmes de PNL, il est toujours nécessaire de comprendre les limites d'applicabilité d'une technologie particulière - et sa pertinence.

Désormais, avec chaque version d'architectures similaires - Reformer, Longformer, BigBird, etc. - nous regardons les grands modèles pré-formés d'une manière légèrement nouvelle, leur posant de nouveaux défis.

En plus des cas mentionnés ci-dessus, ruGPT-3 peut certainement être appliqué et bénéfique dans des pratiques telles que:

- augmentation des données texte pour les tâches ML

- modèles de dialogue pour l'automatisation

- tâches de sommation générative

- réécriture, génération d'actualités, notes sportives basées sur des informations structurées.

Espérons que les démos et les modèles profiteront à la communauté - et amusants!

Et, bien sûr, nous attendons vos décisions sur la piste ruGPT-3 jusqu'à la fin du 22 novembre!