L'iPad 11 Pro d'Apple équipé de lidar offre une reconnaissance plus profonde et plus détaillée des objets 3D. Pour cela, les caméras ToF sont également utilisées avec différentes technologies pour mesurer la plage de la position du point.

Apple a lancé une course à l'utilisation des lidars sur une variété de produits. Apple a intégré le lidar à son iPad Pro 11 et il semble maintenant que tout le monde veuille utiliser le lidar.

La manœuvre et la réaction d'Apple ont eu un impact sur l'ensemble de l'industrie électronique. Les vendeurs de puces et de capteurs reconsidèrent leurs plans. Certains ont déjà changé leurs modèles commerciaux.

Mais qu'est-ce que le lidar? Apple a choisi ce terme pour décrire un nouveau capteur qui mesure la profondeur - en d'autres termes, un capteur qui reconnaît les objets en trois dimensions.

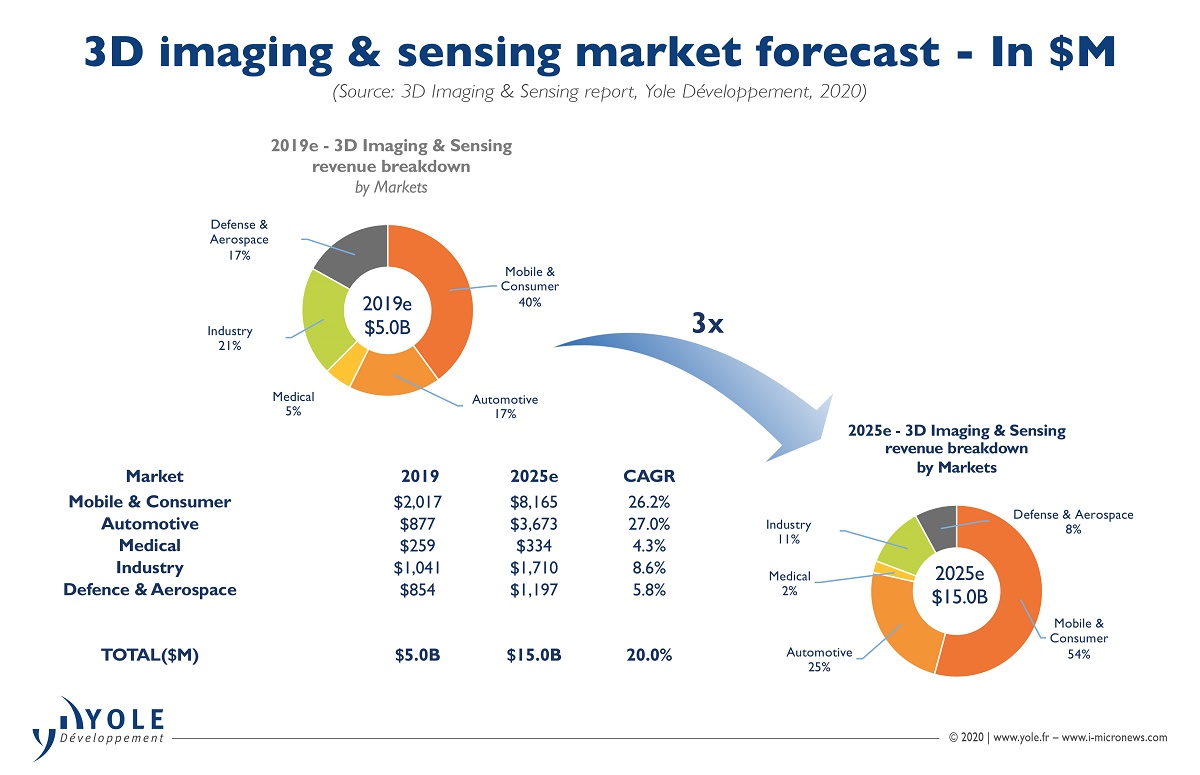

Le lidar dans les tablettes et les smartphones est essentiellement «une sorte de technologie de reconnaissance d'objets tridimensionnels», explique Pierre Cambu, analyste en chef de la division photonique et écrans de l'entreprise chez Yole Développement.

De nombreux ingénieurs dans divers domaines - qu'il s'agisse de voitures autonomes, de smartphones ou de tablettes - ont exploré des moyens d'utiliser les informations de «profondeur» des données en conjonction avec les pixels et les couleurs obtenus à partir de capteurs qui reconnaissent des objets bidimensionnels. Par exemple, les lidars sont utilisés dans l'industrie automobile pour déterminer les distances par rapport aux objets situés autour de véhicules hautement automatisés.

L'iPad 11 Pro récemment dévoilé par Apple utilise le lidar pour améliorer son expérience de réalité augmentée. Ce lidar est conçu pour le kit de développement ARkit 3.5 d'Apple.

La technologie spéciale utilisée pour déterminer et mesurer la profondeur rend ce lidar essentiel. C'est cette technologie qui a permis à ce capteur d'être surveillé par d'autres fabricants d'appareils mobiles, notamment Huawei et Vivo.

Différentes méthodes de reconnaissance d'objets tridimensionnels

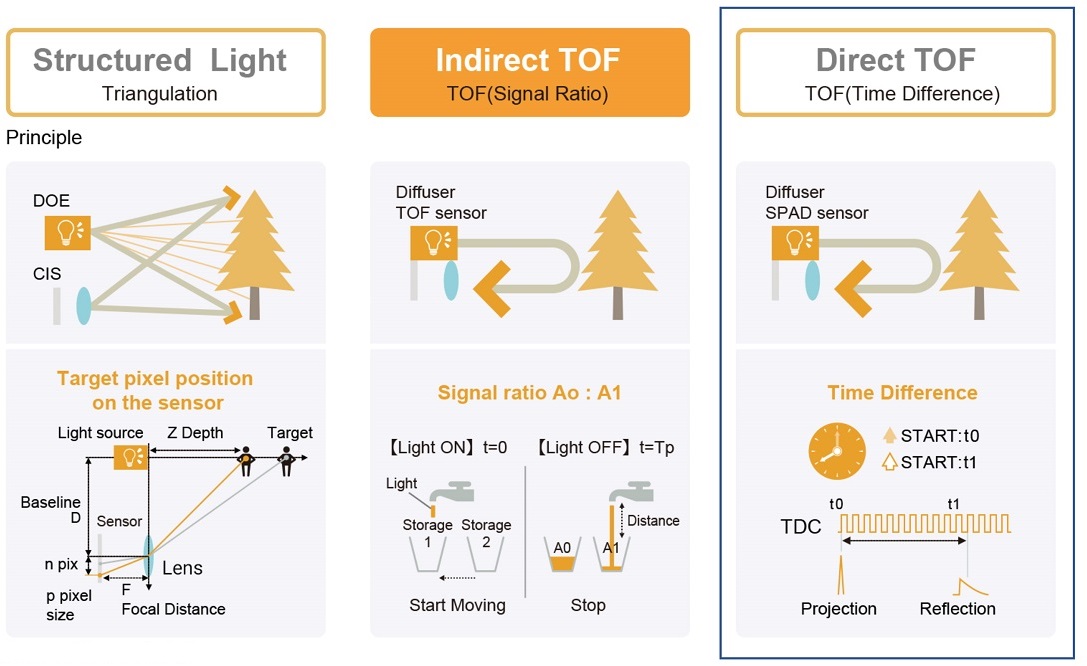

Les ingénieurs utilisent diverses techniques pour reconnaître les objets 3D . Il s'agit notamment de la vision stéréo, de la structuration de la lumière et des mesures du temps de vol (ToF). Pour compliquer encore les choses, la technologie ToF est désormais disponible en deux versions: iToF et dToF. iToF mesure le déphasage et dToF le temps de vol direct.

Apple iPhone X dispose d'une reconnaissance faciale structurée légère. Son estimation de profondeur fonctionne avec un émetteur IR qui envoie 30 000 points dans un ordre fixe. Les points sont invisibles pour les humains, mais pas pour la caméra infrarouge, qui lit les déformations du modèle se reflétant sur les surfaces à différentes profondeurs.

Avec la sortie de l'iPad 11 Pro, la reconnaissance d'objets 3D est devenue plus profonde et plus détaillée grâce à l'utilisation de la technologie dToF. À ce jour, l'iPad Pro d'Apple est le seul produit grand public à utiliser la technologie dToF. De nombreux fabricants de smartphones utilisent déjà iToF pour de meilleures photos (l'appareil photo ToF peut brouiller l'arrière-plan des photos), mais pas dToF.

La méthode de structuration de l'éclairage offre une grande précision dans la détermination de la profondeur, mais son inconvénient est le post-traitement complexe nécessaire pour calculer la profondeur lors de l'appariement avec l'échantillon.

L'avantage de la méthode dToF, en revanche, est sa capacité à faciliter le post-traitement. Cependant, on pense que la difficulté d'utiliser cette technologie réside dans le fait que des photodétecteurs à haute sensibilité (par exemple, photodiodes à avalanche à photon unique) et de grande taille sont nécessaires pour mesurer le temps de vol avec un petit nombre de photons dans une dimension.

De nos jours, iToF est la méthode de reconnaissance d'objets 3D la plus courante. Il fournit une détection de profondeur très précise, un post-traitement facile et une résolution spatiale élevée à l'aide de photodétecteurs de petite taille couramment utilisés dans les capteurs d'imagerie 2D.

Cependant, Apple a emprunté un chemin moins battu pour reconnaître les objets 3D. L'entreprise a décidé d'utiliser la lumière structurée pour identifier les visages. Pour la réalité augmentée, Apple utilise dToF.

Alors, voici les questions que tout le monde dans le monde de la reconnaissance d'objets 3D se pose: Qu'est-ce que dToF? De quoi est faite cette technologie? Et qui a développé ses composants?

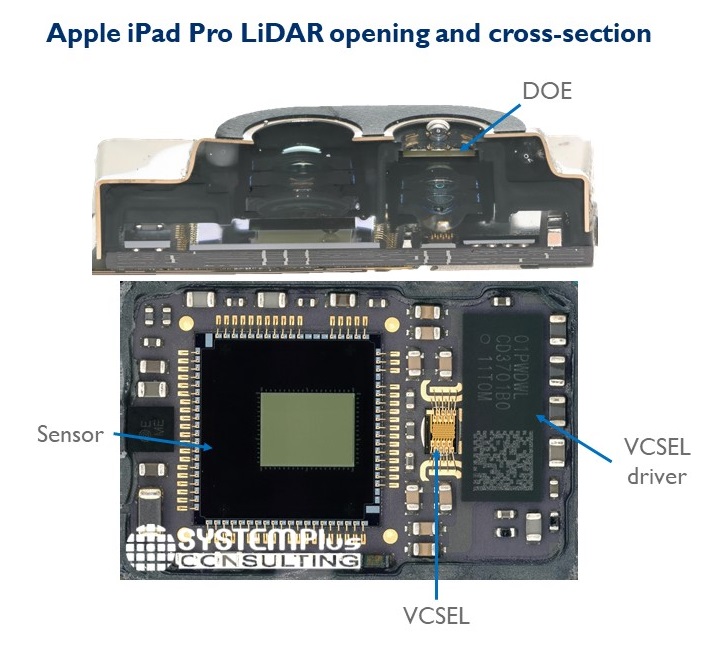

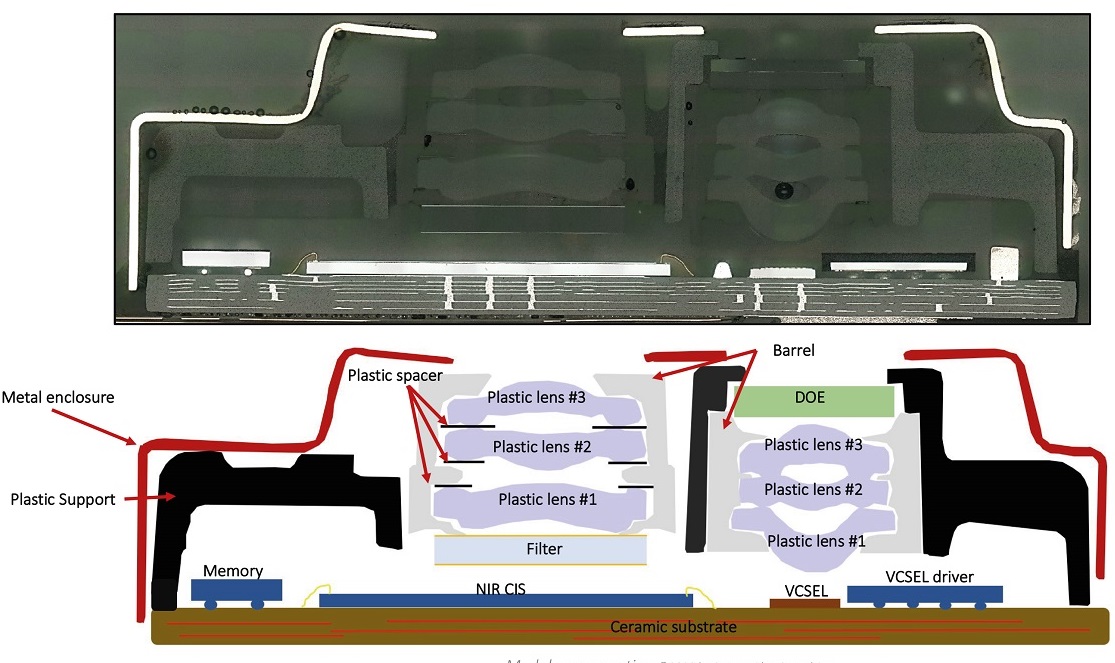

L'analyse de System Plus Consulting, une division de Yole Développement, a présenté les détails du module de reconnaissance d'objets 3D de l'Apple iPad 11 Pro.

Dans une interview accordée au EE Times, Sylvain Hallero, analyste principal de la technologie et de la valeur chez System Plus, a expliqué que le lidar de l'iPad 11 Pro se compose d'un laser à émission verticale (VCSEL) de Lumentum et d'un récepteur développé par Sony, un capteur CMOS à champ proche. portée infrarouge (NIR), qui mesure le temps de vol.

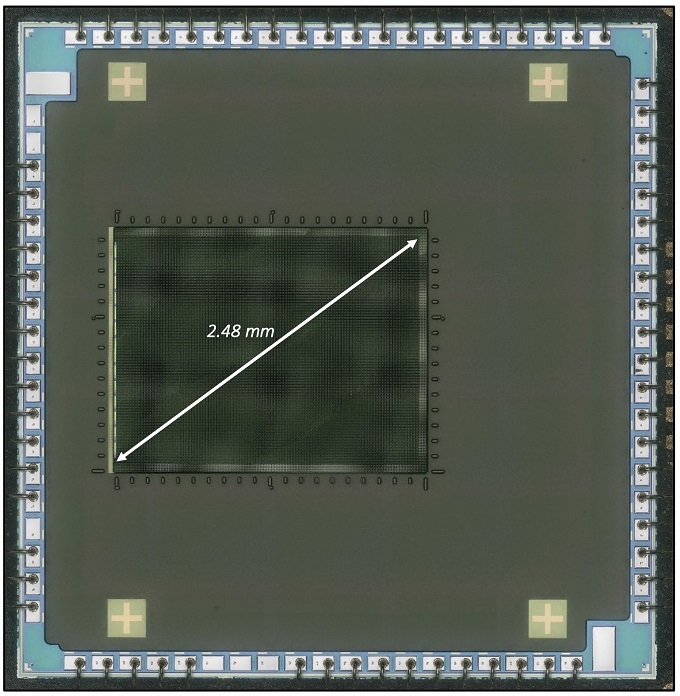

Capteur CMOS proche infrarouge utilisant des photodiodes à avalanche à un photon Sony

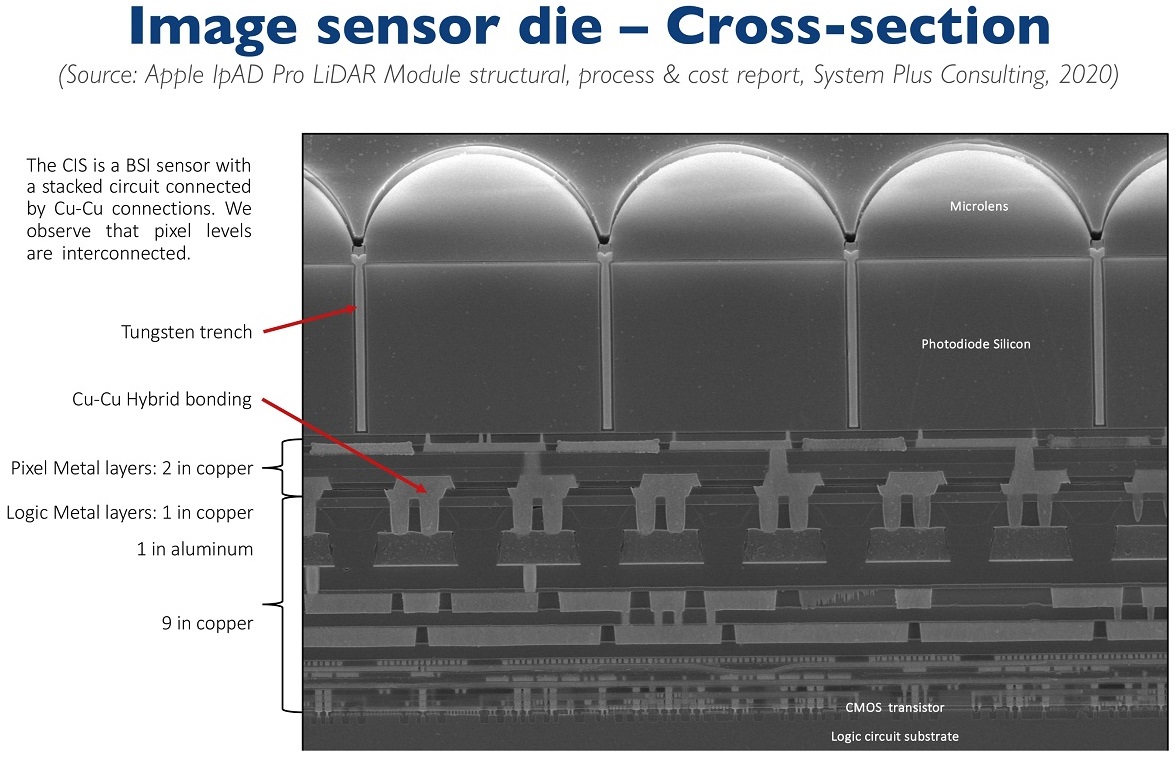

Découper un capteur Sony CMOS, dans le cadre d'une étude de son appareil, a été une révélation pour les experts suite au développement de la photonique. Y compris pour Kambu, qui travaille pour Yole. Dans un récent article de blog , il a écrit que ce qui "ressemblait à un ancien appareil avec iToF et des pixels de 10 microns" s'est avéré être le premier capteur CMOS grand public avec une connexion intra-pixel - et, oui, nous parlons d'un tableau de diodes à avalanche à photon unique. "

La connexion intra-pixel est une propriété importante. Sony est le premier à intégrer un capteur CMOS utilisant l'empilement 3D pour les capteurs ToF. La connexion intra-pixel a permis au capteur d'image CMOS d'être placé avec le substrat logique. Grâce au réseau logique intégré, le capteur peut effectuer des calculs simples de la distance entre l'iPad et les objets, a expliqué Hallero.

Sony a fait son chemin dans le segment dToF avec le développement d'une nouvelle génération de capteurs CMOS avec des barrettes de diodes à avalanche à photon unique de 10 microns et 30 kilopixels.

Ce n'est pas seulement une prouesse technologique de Sony, cependant. Il s'agit également du fait que Sony a changé le concept de son entreprise.

Traditionnellement, le géant japonais a davantage travaillé sur le traitement d'image. pas sur la numérisation. Cependant, Kambu déclare que "Sony a renommé son activité de semi-conducteurs il y a un an en Imagerie et numérisation". Ensuite, Sony a franchi deux étapes. Le premier a été la livraison de capteurs iToF à Huawei et Samsung en 2019, qui a rapporté à Sony environ 300 millions de dollars. La deuxième étape est de gagner le concours pour le développement de capteurs dToF pour l'iPad d'Apple. "

Kambu soupçonne que les capteurs dToF pourraient éventuellement entrer dans l'iPhone. Dans son analyse, il note que «les revenus des capteurs de Sony devraient dépasser 1 milliard de dollars en 2020 dans un marché qui vient de dépasser la barre des 10 milliards de dollars. Cette transition réussie du traitement d'image à la numérisation a contribué à renforcer continuellement la position de Sony sur le marché des capteurs CMOS. Tout cela sera la base de la prospérité de la nouvelle division. "

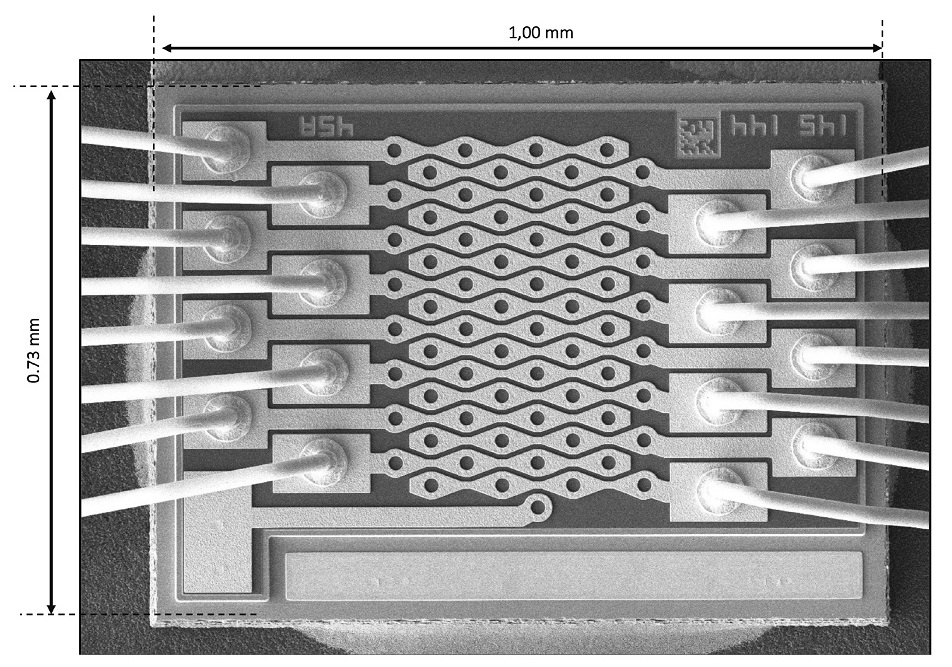

Lasers à émission verticale Lumentum

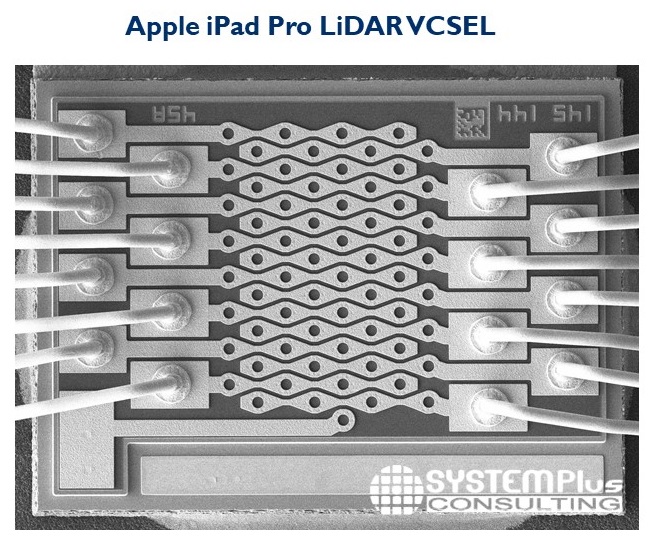

En plus du capteur CMOS de Sony, le lidar est équipé de lasers à émission verticale de Lumentum. Dans la conception de ces lasers, plusieurs électrodes sont connectées à l'émetteur.

Taha Ayari, analyste de la technologie et de la valeur chez System Plus, s'est concentré sur une nouvelle étape de traitement (appelée contact mesa) que Lumentum a ajoutée à son laser vertical. Un laser Lumentum émet de la lumière depuis la surface du substrat. Le réglage fin de l'émission nécessite une gestion de l'alimentation et l'application de diverses commandes aux réseaux émetteurs. Ayari pense que Lumentum a ajouté cette technologie pour améliorer les tests de composants sur les substrats.

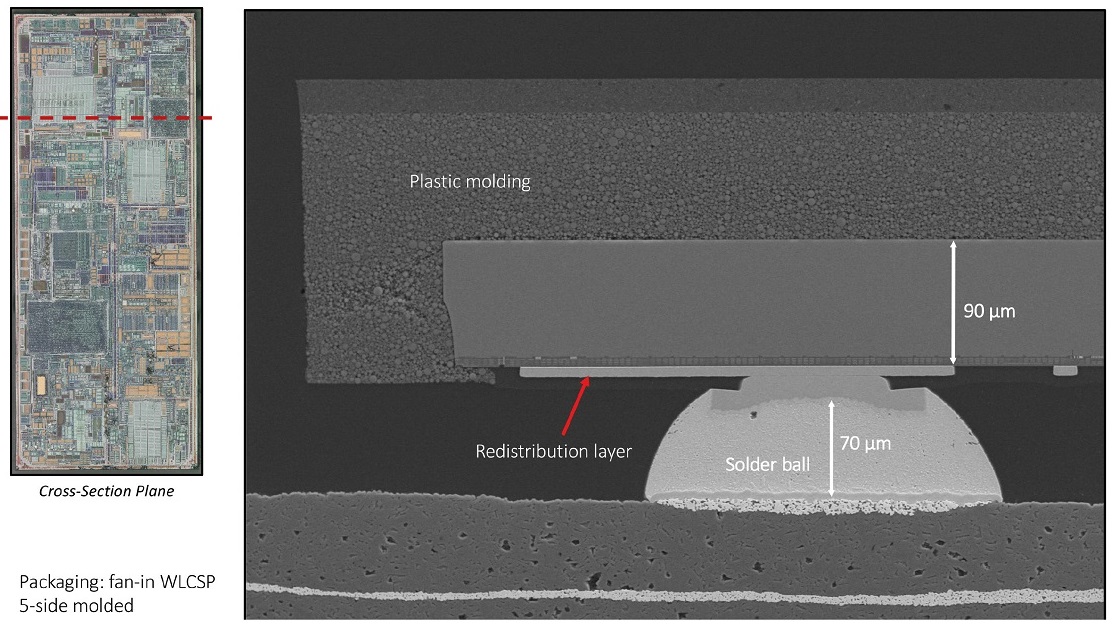

Pour la génération d'impulsions et le contrôle de la puissance et de la forme du faisceaul'émetteur utilise un pilote IC de Texas Instruments. Le circuit utilise un boîtier à base de plaquettes (WLCSP) moulé sur cinq côtés.

Enfin, System Plus affirme que le laser de Lumentum utilise un nouvel élément optique diffractif (DOE) d'Himax pour créer le motif de points.

Sur les pages suivantes, nous partageons quelques diapositives créées par System Plus qui illustrent ce qui a été trouvé lors du démontage, et nous avons également ajouté quelques diapositives décrivant les perspectives du marché lidar.

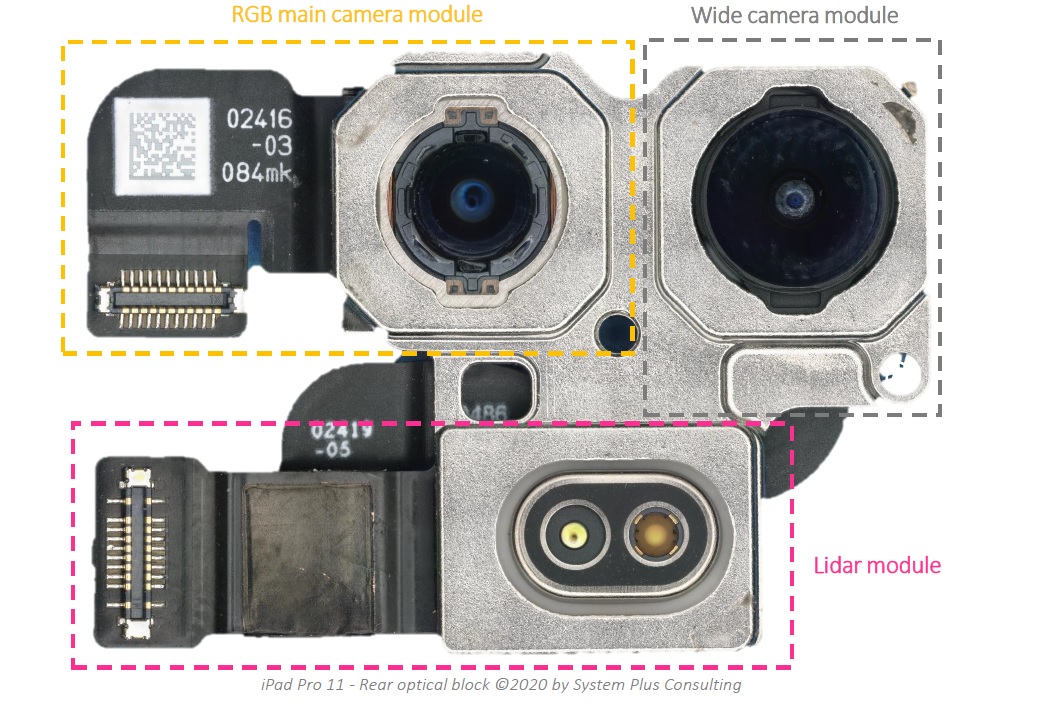

Fonctionnalités de l'Apple iPad Pro: module de caméra principale RVB, module de caméra large et module LiDAR arrière

Voici à quoi ressemble la section transversale du module LiDAR.

Vue d'ensemble du capteur d'image À

quoi ressemble la matrice VCSEL

VCSEL Driver IC emballé dans Fan-in WLCSP 5-Side VCSEL Driver Die

Diffractive Optical Element

Abonnez-vous aux canaux:

@TeslaHackers - une communauté de hackers Tesla russes, formation à la location et à la dérive sur Tesla

@AutomotiveRu - Actualités de l'industrie automobile, matériel et psychologie de la conduite

À propos d'ITELMA

Lisez d'autres articles utiles:

- Cours en ligne gratuits en automobile, aérospatiale, robotique et ingénierie (50+)

- [Prévisions] Transport du futur ( horizons à court terme , moyen terme , long terme )

- Les meilleurs matériaux sur les voitures de piratage de DEF CON 2018-2019

- [Prévisions] Motornet - réseau d'échange de données pour le transport robotisé

- 16 , 8

- open source

- McKinsey: automotive

- …