Des scientifiques britanniques ont formé l'intelligence artificielle à transformer la langue parlée en vidéo avec un interprète virtuel en langue des signes. L'algorithme évalue indépendamment la qualité du travail. Le réseau neuronal aidera les personnes souffrant de perte auditive partielle ou totale à améliorer la perception du contenu et à se sentir plus libres lors d'événements publics.

Il y a des dizaines de millions de personnes sourdes et malentendantes dans le monde qui utilisent la langue des signes comme principal moyen de communication. D'une part, dans le monde en ligne, le problème de la communication pour les personnes malentendantes est résolu à l'aide de sous-titres. Mais d'un autre côté, les webinaires, flux et autres contenus désormais populaires doivent être traduits en langue des signes en temps réel. Les scientifiques étudient ce problème depuis longtemps et recherchent une solution.

Les chercheurs se tournent désormais vers la neurotechnologie. À l' Université de Surrey, les développeurs ont créé un algorithme de traduction en langue des signes de nouvelle génération. L'IA convertit la langue parlée en mouvements du squelette humain. Le squelette prend alors une apparence humaine et une séquence réaliste est créée. Avec l'aide de la technologie, vous pouvez également produire des vidéos basées sur du texte.

Pourquoi de telles difficultés et pourquoi le mouvement de tout le squelette est-il important? La langue des signes n'est pas seulement des signes de la main, elle implique toutes les parties du corps et même les expressions faciales. Les technologies précédentes généraient souvent des modèles flous, ce qui entraînait une distorsion des significations ou même une incompréhension du discours de l'interprète virtuel en langue des signes.

Photo: ru.freepik.com

Comment fonctionne le nouveau réseau neuronal

L'algorithme est basé sur ce qui suit: le signal de réception se présente sous forme audio, puis il est converti en un modèle schématique du squelette humain, qui reproduit la parole avec les gestes appropriés. La séquence de poses est ensuite transmise au réseau neuronal convolutif U-Net. Le Web convertit les mouvements et les poses en vidéos réalistes.

Algorithme d'un interprète virtuel en langue des signes

Pour obtenir des résultats élevés, des scientifiques ont formé un réseau neuronal à l'aide de vidéos d'interprètes en langue des signes réels.

Pour évaluer le modèle résultant, les développeurs ont mené des expériences avec des volontaires. Ainsi, ils leur ont demandé de comparer la nouvelle méthode avec d'autres méthodes de transformation de la parole précédemment utilisées. Sur les 46 personnes, 13 étaient des locuteurs de la langue des signes. La comparaison a été effectuée selon quatre paramètres, pour chacun desquels le nouvel algorithme a surpassé les versions précédentes en qualité.

Résultats d'une étude sur des volontaires

Pas seulement des scientifiques britanniques

Depuis le début du siècle, les chercheurs se développent dans le domaine de la traduction en langue des signes. L'un des produits les plus connus est le traducteur virtuel animé d'IBM . Mais le projet n'a pas été développé. Plusieurs années plus tard, il se réincarne à Novossibirsk. Le programme , inventé par des scientifiques du Novosibirsk Academgorodok, reconnaît la parole, analyse le sens et se traduit en langage des signes. Ensuite, l'avatar montre le texte à l'écran.

Traducteur en langue des signes animée par les développeurs de Novossibirsk

À cette époque, on pensait que le développement deviendrait aussi populaire que Google Translator. Vous pouvez maintenant tester le programme dans l'application Adaptis pour l' AppStore et Google Play .

Capture d'écran de l'application Adaptis dans l'App Store

Il y a quelques années, des scientifiques belges ont imprimé une main 3D contrôlée par Arduino qui fonctionne également comme un interprète en langue des signes. Le projet a été nommé ASLAN. Le bras se composait de 25 pièces PLA distinctes. À l'avenir, ils avaient l'intention d'ajouter une autre main et un visage robotique pour transmettre des émotions.

La traduction de la langue des signes dans la langue à laquelle nous sommes habitués est également très difficile. Scientifiques russes de l'Institut pour les problèmes de gestion. VIRGINIE. L'institut Trapeznikov des sciences de contrôle de l'Académie des sciences de Russie (UIP RAS) a commencé il y a quelques années le développement d'une telle IA. On supposait qu'à l'avenir, il aiderait à traduire les gestes en mots, phrases et lettres. Les scientifiques ont ensuite signalé que la création d'un algorithme pouvait prendre plus d'un an.

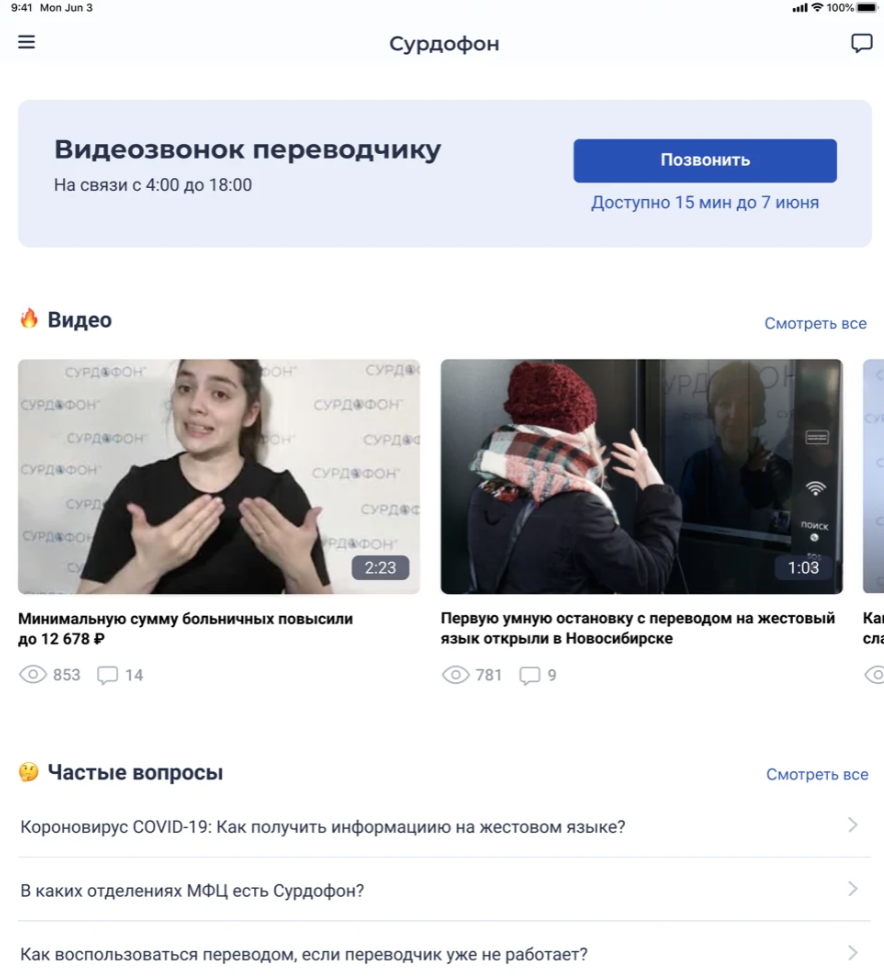

Photo: ru.freepik.com Le

programme russe sera basé sur un site créé par un employé malentendant de l'Institut des sciences de contrôle de l'Académie des sciences de Russie. Elle développe le site Web Surdoserver depuis plusieurs années. Dans le même temps, il a été signalé que des scientifiques russes travaillaient sur une application mobile «Surdoservice» et un nuage sourd pour l'échange d'informations par les personnes malentendantes.