Il arrive souvent que des centres de données apparemment cachés constituent l'épine dorsale de notre Internet. Ils transportent, stockent et transmettent les informations que nous créons chaque jour.

Plus nous créons de données, plus les centres de données deviennent vitaux.

Aujourd'hui, de nombreux centres de données sont inappropriés, pas efficaces et obsolètes. Pour les maintenir opérationnels, les opérateurs de centres de données, de FAMGA aux centres de colocation, travaillent à leur mise à niveau pour répondre aux tendances d'un monde en constante évolution.

Dans ce rapport, nous abordons de nombreux aspects de l'avenir des centres d'information et de leur évolution. En partant de l'endroit et de la façon dont ils sont créés, de l'énergie qu'ils utilisent et du matériel qui s'y trouve.

Localisation

L'accès aux réseaux de fibre optique, les tarifs des sources d'énergie et l'environnement jouent tous un rôle important dans le choix de l'emplacement des centres de données.

Selon certaines estimations, le marché mondial de la construction de centres de données pourrait atteindre jusqu'à 57 milliards de dollars d'ici 2025. C'est tout un challenge, puisque le géant de l'immobilier commercial CBRE a lancé une division entière dédiée aux data centers

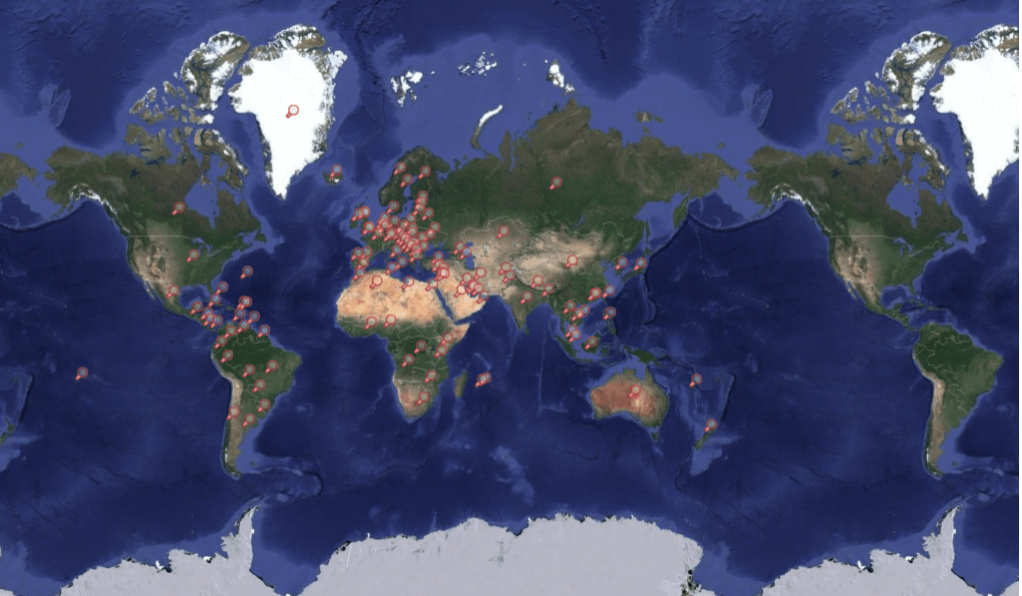

Carte des data centers

Construire à proximité de sources d'énergie bon marché

Placer des centres de données gourmands en énergie à côté de sources d'alimentation bon marché peut les rendre plus abordables à exploiter. Alors que les émissions augmentent et que les grandes entreprises technologiques utilisent de plus en plus d'énergie sale pour alimenter les centres de données, les sources d'énergie verte sont un facteur important.

Apple et Facebook ont construit des centres de données à proximité des ressources hydroélectriques. Au centre-ville de l'Oregon, Apple a acquis un projet hydroélectrique pour fournir de l'énergie verte à son centre de données de Prinville. La société a déclaré que les marchés de l'électricité déréglementés de l'Oregon sont la principale raison pour laquelle ils ont construit plusieurs centres de données dans la région. La déréglementation permet à Apple d'acheter de l'électricité directement auprès de fournisseurs tiers qui utilisent des sources d'énergie renouvelables, pas seulement des services publics locaux.

À Luleå, en Suède, Facebook a construit un méga-centre de données à côté d'une centrale hydroélectrique. En Suède, des centres de données ont commencé à apparaître dans la région du nord, car, en plus du climat frais et de l'emplacement peu propice aux tremblements de terre, il y a beaucoup de sources d'énergie renouvelables (hydroélectrique et éolienne) dans cette partie.

Création de Facebook à Lulea, Suède, en 2012. Source: Facebook

Plusieurs grands centres de données ont déjà déménagé dans la région Nord, certains ne font que le regarder.

En décembre 2018, Amazon Web Services a annoncé l'ouverture de son centre de données AWS Europe Region, situé à environ une heure de route de Stockholm. Au cours du même mois, Microsoft a acquis 130 hectares de terrain dans deux régions voisines de la Suède, à Gavle et Sandviken, dans le but d'y construire des centres de données.

En plus d'être proches de sources d'énergie propres et bon marché, les entreprises de centres de données prêtent également attention au climat frais. Des emplacements proches du cercle polaire arctique, comme le nord de la Suède, pourraient permettre aux centres de données d'économiser sur les coûts de refroidissement.

La société de télécommunications Altice Portugal affirme que son centre de données de Covilhã utilise 99% de l'air extérieur pour refroidir ses serveurs. Et l'ancien centre de données Google à Hamina, en Finlande, utilise l'eau de mer du golfe de Finlande pour refroidir l'installation et réduire la consommation d'énergie.

Verne Global a ouvert un campus en Islande qui se connecte aux sources géothermiques et hydroélectriques locales. Il est situé sur une ancienne base de l'OTAN et se situe entre l'Europe et l'Amérique du Nord, les deux plus grands marchés de données au monde.

La construction dans les économies émergentes

Placer un centre de données à un point de trafic Internet croissant réduit la charge et augmente le taux de transfert de données dans la région.

Par exemple, en 2018, la société chinoise Tencent, qui possède Fortnite et WeChat, a mis en place des centres de données à Mumbai. Cette étape est devenue le signe que la région utilise activement Internet et que les plates-formes de jeux Tencent sont de plus en plus populaires.

La construction de centres de données dans les zones à forte intensité d'Internet est également une décision commerciale stratégique. Si des entreprises locales se développent, elles envisageront de déplacer leurs opérations vers le centre de données le plus proche.

De plus, les centres de données ont une fonction de colocation. Cela signifie qu'ils fournissent au bâtiment le refroidissement, l'alimentation, la bande passante et la sécurité physique, puis louent l'espace aux clients qui y installent leurs serveurs et leur stockage. Le service de colocation se concentre généralement sur les entreprises ayant de petits besoins, il aide également les entreprises à économiser de l'argent sur les infrastructures.

Incitations fiscales et lois locales

Les centres de données sont une nouvelle source importante de revenus pour les producteurs d'électricité et, par conséquent, l'État attire les grandes entreprises avec divers avantages.

À partir de janvier 2017, le gouvernement suédois a abaissé la taxe de 97% sur toute électricité utilisée par les centres de données. L'électricité en Suède est relativement chère et les réductions d'impôts ont mis la Suède sur un pied d'égalité avec d'autres pays scandinaves.

En décembre 2018, Google a accepté une exonération fiscale de 100% sur 15 ans sur la vente d'un centre de données à New Albany, dans l'Ohio, pour un centre de données d'une valeur de 600 millions de dollars, avec possibilité d'extension jusqu'en 2058. En septembre 2018, la France, dans l'espoir d'attirer des talents économiques et des capitaux mondiaux après le Brexit, a annoncé son intention de réduire les taxes sur l'électricité pour les centres de données.

Dans certains cas, la mise en place d'un centre de données est un moyen pour les entreprises de continuer à fonctionner dans des pays à haute sécurité.

En février 2018, Apple a commencé à stocker des données dans un centre situé à Guizhou, en Chine, afin de se conformer aux lois locales. Alors qu'auparavant, les autorités chinoises devaient utiliser le système juridique américain pour accéder aux informations des citoyens chinois stockées dans le centre de données américain, le centre de données local permet désormais aux autorités chinoises d'accéder plus facilement et plus rapidement aux informations des citoyens chinois stockées dans le cloud Apple. ...

Alors que les autorités chinoises devaient auparavant passer par le système juridique américain pour accéder aux informations des citoyens chinois stockées dans le centre de données américain, le centre de données local permet aux autorités d'accéder plus facilement et plus rapidement aux informations sur les citoyens chinois stockées dans le cloud d'Apple.

Connectivité et sécurité par fibre optique

Deux autres facteurs critiques en ce qui concerne les emplacements des centres de données sont la connectivité par fibre et une sécurité renforcée.

Pendant de nombreuses années, les réseaux de fibre optique ont été un facteur clé dans la sélection des emplacements des centres de données. Bien que les données soient souvent transférées vers des appareils mobiles via des réseaux sans fil ou une connexion Wi-Fi locale.

La plupart du temps, les données transitent vers et depuis le stockage via des câbles à fibre optique. La fibre optique connecte les centres de données aux antennes cellulaires, routeurs domestiques et autres périphériques de stockage.

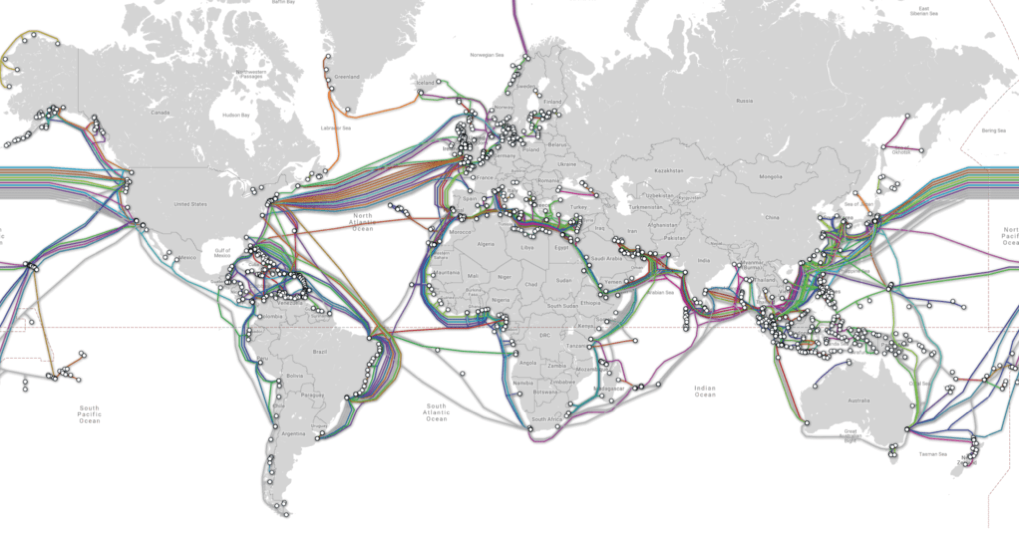

Carte des câbles sous-marins

Ashburn, Virginie et ses régions voisines sont devenues un grand marché de centres de données, en grande partie grâce au grand réseau d'infrastructure à fibre optique lancé par AOL en tant que siège social. Alors que d'autres sociétés comme Equinix ont déménagé dans la région et construit leurs propres centres de données, les réseaux de fibre optique de la région continuent de croître, attirant de plus en plus de nouveaux centres de données.

Facebook a investi près de 2 milliards de dollars dans un centre de données à Henrico, en Virginie, et en janvier 2019, Microsoft a reçu une subvention de 1,5 million de dollars pour la sixième fois pour agrandir son centre de données à Southside, en Virginie.

De nouvelles alternatives aux réseaux de fibre optique font également leur apparition alors que de grands techniciens construisent leur propre infrastructure de connectivité.

En mai 2016, Facebook et Microsoft ont annoncé un travail conjoint sur les câbles sous-marins entre Virginia Beach, Virginie et Bilbao, Espagne. En 2017, Facebook a annoncé de nouveaux plans pour construire son propre réseau de fibre souterrain de 200 miles à Las Lunas, au Nouveau-Mexique, pour connecter son centre de données du Nouveau-Mexique à d'autres fermes de serveurs. Le système de fibre optique souterrain créera trois itinéraires en réseau uniques pour le voyage d'information à Las Lunas.

Outre la connectivité, la sécurité est un autre point important. Ceci est particulièrement important pour les centres de données qui stockent des informations sensibles.

Par exemple, le géant financier norvégien DNB, en partenariat avec le centre de données Green Mountain, a créé son propre centre de données. Green Mountain a abrité le centre de données DNB dans une installation de haute sécurité - un bunker converti dans la montagne. La société affirme que la montagne est complètement protégée de toutes sortes de dangers, y compris les attaques terroristes, les éruptions volcaniques, les tempêtes, les tremblements de terre.

Le centre de données de Swiss Fort Knox est situé sous les Alpes suisses, avec une porte déguisée en pierre. Son système interne complexe comprend de nombreux tunnels qui ne sont accessibles qu'avec un dégagement approprié. Le centre de données est protégé par des moteurs diesel d'urgence et un système de pression d'air qui empêche les gaz toxiques d'entrer dans les locaux.

Le Fort Knox de Suède est hyper sécurisé physiquement et numériquement. Source: Mount 10

En raison du degré élevé de sécurité des serveurs dans certains centres de données, il existe de nombreux centres de données dont les emplacements n'ont jamais été annoncés. Les informations sur l'emplacement de ces centres peuvent être utilisées comme une arme.

En octobre 2018, WikiLeaks a publié une liste d'objets AWS interne. Parmi les informations trouvées, il y avait le fait qu'Amazon était un candidat à la création d'un cloud privé d'une valeur d'environ 10 milliards de dollars pour le ministère de la Défense.

WikiLeaks a lui-même rencontré des difficultés pour trouver un centre de données approprié pour héberger ses informations. AWS a cessé d'héberger WikiLeaks parce que la société a violé les conditions de service, à savoir, a publié des documents sur lesquels elle n'avait pas de droits et a mis des personnes en danger.

En conséquence, WikiLeaks a migré vers de nombreux centres de données différents. À un moment donné, il y avait même des rumeurs selon lesquelles WikiLeaks envisageait de placer son centre de données dans l'océan, dans l'état non reconnu de Sealand en mer du Nord.

Structure

Bien que l'emplacement soit sans doute le facteur le plus important pour réduire le risque de panne du centre de données, les structures des centres de données jouent également un rôle important pour garantir la fiabilité et la longévité.

La construction appropriée d'un centre de données peut le rendre résistant à l'activité sismique, aux inondations et à d'autres types de catastrophes naturelles. De plus, les conceptions peuvent être adaptées pour s'étendre et réduire les coûts énergétiques.

Dans tous les secteurs - de la santé à la finance et à la fabrication - les entreprises s'appuient sur des centres de données pour soutenir la consommation croissante de données. Dans certains cas, ces centres de données peuvent être détenus et situés sur le site, tandis que d'autres peuvent être partagés et situés à distance.

Dans tous les cas, les centres de données sont au centre d'un monde technologique en pleine croissance et continuent de vivre leurs propres transformations physiques. Selon CB Insights Market Sizing, le marché mondial des services de centres de données est évalué à 228 milliards de dollars d'ici 2020.

L'une des transformations les plus récentes dans la construction de centres de données est la taille. Certains centres de données sont devenus plus petits et plus répandus (ils sont appelés centres de données périphériques). Dans le même temps, d'autres centres de données sont plus grands et plus centralisés que jamais - ce sont des méga centres de données)).

Dans cette section, nous allons examiner les centres de périphérie et les méga-données.

Centres de données périphériques

De petits centres de données distribués, appelés centres de données périphériques, sont créés pour fournir un stockage hyper-local.

Alors que le cloud computing a traditionnellement servi de moyen fiable et rentable de connecter de nombreux appareils à Internet, la croissance continue de l'IoT et de l'informatique mobile a mis à rude épreuve la bande passante des réseaux de centres de données.

L'Edge computing est en train d'émerger pour proposer une solution alternative. (Edge computing est un paradigme de l'informatique distribuée qui se produit à la portée des points finaux. Ce type de calcul est utilisé pour améliorer les temps de réponse du réseau et mieux utiliser la bande passante du réseau.)

Cela implique de placer les ressources informatiques plus près de l'origine des données (c'est-à-dire des moteurs, des générateurs ou d'autres éléments. Ce faisant, nous réduisons le temps nécessaire pour déplacer les données vers des emplacements informatiques centralisés tels que les nuages.

Bien que cette technologie soit encore à ses balbutiements, elle fournit déjà une méthode plus efficace de traitement des données pour de nombreux cas d'utilisation, y compris les véhicules autonomes.Par exemple, les véhicules Tesla sont équipés de puissants ordinateurs de bord capables de traiter les données avec une faible latence (quasi temps réel) pour les données collectées par des dizaines de capteurs périphériques de véhicules. permet au véhicule de prendre des décisions indépendantes en temps opportun.)

Cependant, d'autres technologies avancées, telles que les dispositifs médicaux sans fil et les capteurs, n'ont pas la puissance de traitement nécessaire pour traiter directement de grands flux de données complexes.

En conséquence, de plus petits centres de données modulaires sont déployés pour fournir des systèmes de stockage et de traitement de données hyperlocaux. Selon CB Insights Market Sizing, d'ici 2023, le marché informatique mondial atteindra 34 milliards de dollars.

Ces centres de données, qui ont généralement la taille d'un conteneur d'expédition, sont situés à la base des tours cellulaires ou aussi près que possible de la source de données.

Outre les transports et les soins de santé, ces centres de données modulaires sont utilisés dans des secteurs tels que la fabrication, l'agriculture, l'énergie et les services publics. Ils aident également les opérateurs de réseaux mobiles (MNS) à fournir plus rapidement du contenu aux abonnés mobiles, tandis que de nombreuses entreprises technologiques utilisent ces systèmes pour stocker (ou mettre en cache) le contenu plus près de leurs utilisateurs finaux.

Vapor IO est l'une des sociétés offrant des services de colocation, hébergeant de petits centres de données basés sur des tours de cellules. La société a un partenariat stratégique avec Crown Castle, le plus grand fournisseur d'infrastructure sans fil aux États-Unis.

D'autres grandes sociétés de centres de données, telles qu'Edgemicro, fournissent des centres de microdonnées qui connectent les opérateurs de réseaux mobiles (MNC) aux fournisseurs de contenu (CPS). Les fondateurs d'EdgeMicro s'appuient sur l'expérience de dirigeants d'organisations telles que Schneider Electric, l'une des plus grandes sociétés énergétiques d'Europe, et CyrusOne, l'un des fournisseurs de services de centres de données les plus importants et les plus performants des États-Unis.

La société a récemment dévoilé sa première unité de production et prévoit de vendre ses services de colocation à des fournisseurs de contenu tels que Netflix et Amazon, qui bénéficieront d'une vitesse et d'une fiabilité améliorées de la livraison de contenu. Ces services de colocation sont idéaux pour les entreprises qui souhaitent posséder, mais non gérer, leur infrastructure de données.

Bord micro

Et les startups ne sont pas les seules sur le marché des centres de données périphériques.

De grandes entreprises comme Schneider Electric, non seulement collaborent avec des startups, mais développent également leurs propres produits pour les centres de données. Schneider propose plusieurs centres de données modulaires préfabriqués différents, idéaux pour diverses industries nécessitant des ressources informatiques et un espace de stockage hyper-locaux.

Huawei

Ces solutions de bout en bout intègrent les systèmes d'alimentation, de refroidissement, d'extinction des incendies, d'éclairage et de contrôle dans un seul ensemble. Ils sont conçus pour un déploiement rapide, un fonctionnement fiable et une surveillance à distance.

Centres de méga-données

À l'autre extrémité du spectre se trouvent les méga centres de données - des centres de données d'une superficie d'au moins 1 million de mètres carrés. ft. Ces installations sont suffisamment grandes pour répondre aux besoins de dizaines de milliers d'organisations en même temps et bénéficient grandement d'économies d'échelle.

Malgré le fait que la construction de ces mégacentres soit coûteuse, le coût par pied carré est beaucoup plus élevé que le coût d'un centre de données moyen.

L'un des plus grands projets est un objet d'une superficie de 17,4 millions de mètres carrés. ft. construit par Switch Communications, qui fournit aux entreprises le logement, le refroidissement, l'alimentation, la bande passante et la sécurité physique de leurs serveurs.

Commutateur

En plus de cet immense campus Citadel à Tahoe Reno, la société dispose également d'un centre de données de 3,5 millions de pieds carrés. pieds à Las Vegas, un campus de 1,8 million de m2 ft à Grand Rapids et un million de mètres carrés. pieds à Atlanta. Le campus de la Citadelle est le plus grand centre de données de colocation au monde, selon le site Web de l'entreprise.

La grande technologie construit également activement des méga-centres de données aux États-Unis, avec Facebook, Microsoft et Apple tous les bâtiments pour répondre à leurs besoins croissants de stockage.

Par exemple, Facebook construit un centre de données d'une superficie de 2,5 millions de mètres carrés. ft à Fort Worth, Texas, pour traiter et stocker les données personnelles de ses utilisateurs. On a supposé que le centre de données n'occuperait que 750 000 mètres carrés. Feet, mais la société de médias sociaux a décidé de tripler sa taille.

Source: Facebook

Le nouveau centre de données coûtera environ 1 milliard de dollars et sera situé sur 150 acres de terrain, ce qui permettra une expansion future. En mai 2017, 440 mille mètres carrés ont été mis en service. Pieds.

L'un des investissements les plus récents de Microsoft est un centre de données à West Des Moines, dans l'Iowa, qui a coûté 3,5 milliards de dollars à l'entreprise. Ensemble, ce cluster de centres de données couvre 3,2 millions de pieds carrés d'espace, le plus grand centre de données couvrant 1,7 million de pieds carrés. Ce centre de données spécial, appelé Projet Osmium, est situé sur 200 acres de terrain et devrait être achevé d'ici 2022.

Ces dernières années, l'Iowa est devenu une destination populaire pour les centres de données en raison de ses bas prix de l'énergie (parmi les plus bas du pays) et de son faible risque de catastrophe.

Apple ne construit pas non plus une grande installation dans l'Iowa: une superficie de 400 000 pieds carrés et coûte 1,3 milliard de dollars ..

Source: Apple Newsroom

Alors que certains objets Apple sont construits à partir de zéro pour gérer tout le contenu - applications de stockage, streaming de musique Avec le service, le stockage iCloud, les données utilisateur, Apple a repensé une usine de panneaux solaires de 1,3 m² à Mesa, en Arizona, qui a ouvert ses portes en août 2018. Le nouveau centre de données fonctionne à 100% d'énergie verte grâce à une ferme solaire à proximité.

En dehors des États-Unis, les régions spécifiques qui ont attiré ces méga-centres de données comprennent l'Europe du Nord, qui était une destination populaire pour les géants de la technologie de construction en raison de sa température fraîche et des allégements fiscaux.

Hohhot, en Chine, située en Mongolie intérieure, dispose également d'un emplacement idéal pour les méga centres de données, car elle a accès à une énergie locale bon marché, à des températures fraîches et à des talents universitaires (avec l'Université de Mongolie intérieure).

Alors que les grands centres de données sont devenus un sujet populaire dans toute la Chine, la région de la Mongolie intérieure est devenue une plaque tournante pour de tels développements. China Telecom (10,7 millions SF), China Mobile (7,8 millions SF) et China Unicom (6,4 millions SF) ont créé des méga centres de données dans la région.

Source: Top Data Centers au monde

Innovation de centre de données

Outre les centres de données, les nouvelles structures de centres de données conçues en tenant compte des avantages environnementaux sont une autre nouvelle tendance.

Aujourd'hui, de nombreuses organisations expérimentent des centres de données qui fonctionnent dans et autour de l'océan. Ces structures utilisent leur environnement et leurs ressources pour refroidir naturellement les serveurs à très faible coût.

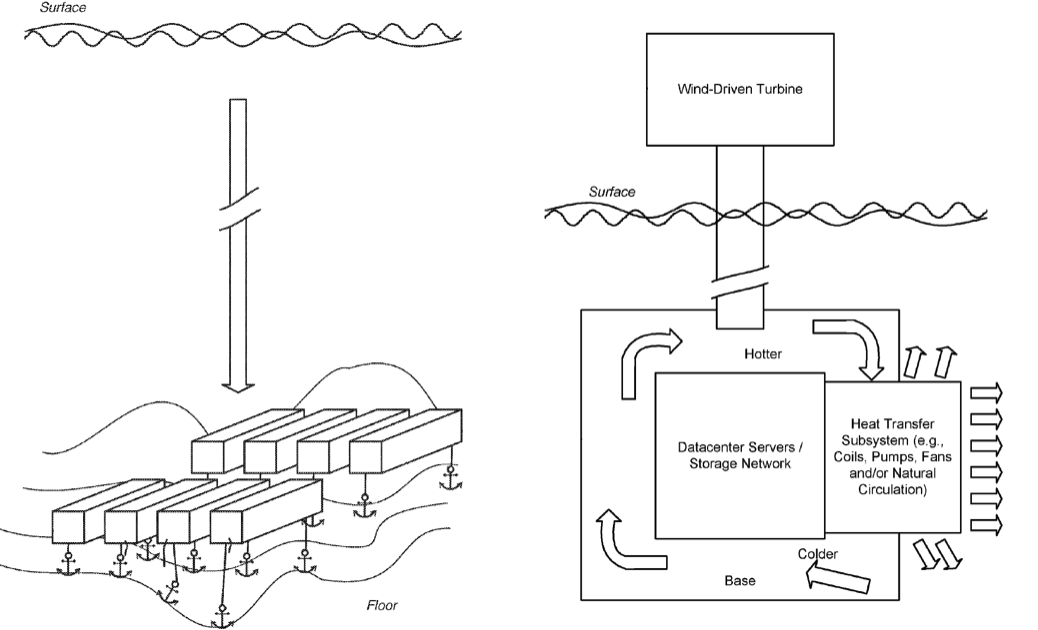

Le projet Natick de Microsoft est l'un des exemples les plus innovants de l'utilisation de l'océan à refroidissement libre. Comme indiqué dans une demande de brevet de 2014 appelée Submersible Data Center, Microsoft a submergé un petit centre de données cylindrique le long de la côte de l'Écosse.

Le centre de données utilise 100% de l'électricité renouvelable produite localement à partir de sources éoliennes et solaires côtières, ainsi que des marées et des vagues. L'installation utilise l'océan pour évacuer la chaleur des infrastructures.

Source: Microsoft

Dès ses débuts, Microsoft a fait de grands progrès sur ce projet, qui pourrait donner le feu vert à l'expansion future des datacenters océaniques.

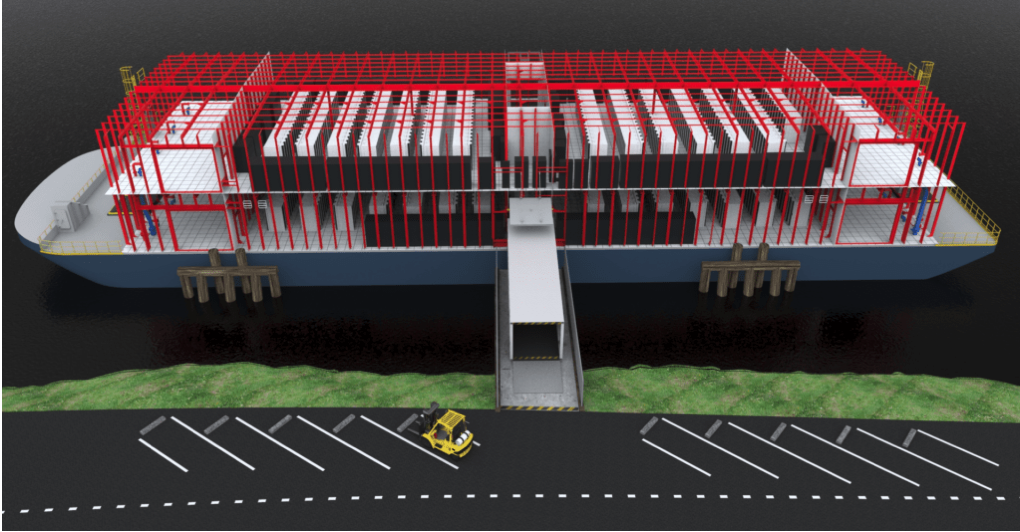

Google a également expérimenté des centres de données océaniques. En 2009, la société a déposé une demande de brevet pour le Water Based Data Center, qui prévoit la création de centres de données à bord de barges flottantes.

Semblable à la conception de Microsoft, la structure utilisera l'eau environnante pour refroidir naturellement l'installation. De plus, la barge peut également générer de l'énergie à partir des courants océaniques.

Bien que Google n'ait pas indiqué si ces conceptions avaient été testées, on pense que la société est responsable d'une barge flottante dans la baie de San Francisco en 2013.

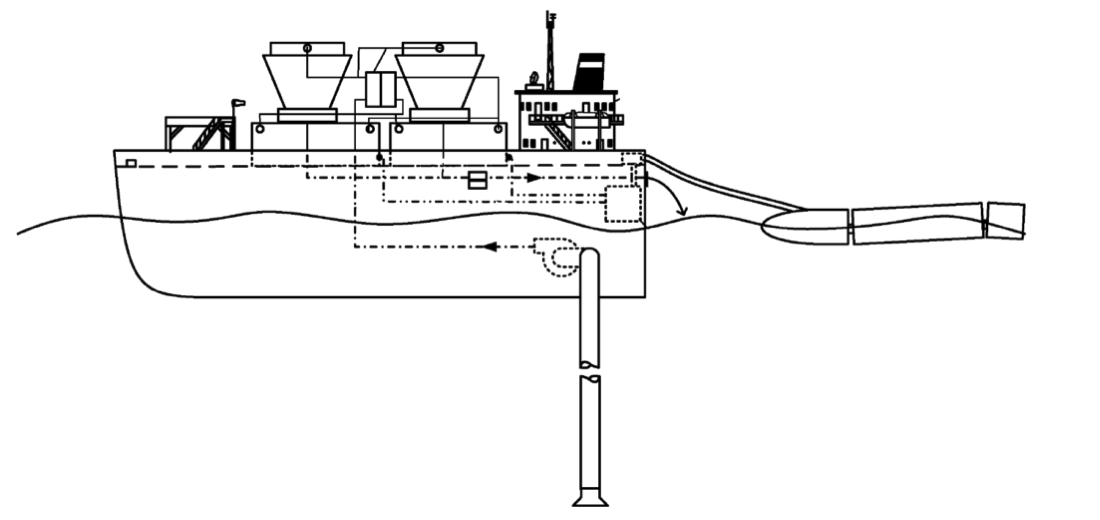

Le lancement de Nautilus Data Technologies a été réalisé avec une idée très similaire. Ces dernières années, l'entreprise a levé 58 millions de dollars pour donner vie au concept de ce centre de données flottant.

Source: Chef d'entreprise

La société se concentre moins sur le navire lui-même et plus sur la technologie nécessaire pour alimenter et refroidir les centres de données. Les principaux objectifs de Nautilus sont: réduire les coûts de calcul, réduire la consommation d'énergie, éliminer la consommation d'eau, réduire la pollution atmosphérique et réduire les émissions de gaz à effet de serre.

Efficacité énergétique et économie

Actuellement, 3% de toute la consommation d'électricité dans le monde tombe sur les centres de données, et ce pourcentage ne fera qu'augmenter. Cette électricité n'est pas toujours «propre»: selon les Nations Unies (ONU), le secteur des technologies de l'information et de la communication (TIC), qui est largement alimenté par les centres de données, fournit la même quantité de gaz à effet de serre que le secteur de l'aviation en carburant.

Alors que les TIC ont réussi à freiner l'augmentation de la consommation d'électricité en partie en fermant d'anciens centres de données inefficaces, cette stratégie ne peut qu'entraîner une augmentation de la consommation Internet et de la production de données.

À l'avenir, les centres de données auront deux options pour réduire les émissions: améliorer l'efficacité énergétique au sein du centre de données et garantir une utilisation d'énergie propre.

Réduire la consommation et augmenter l'efficacité énergétique

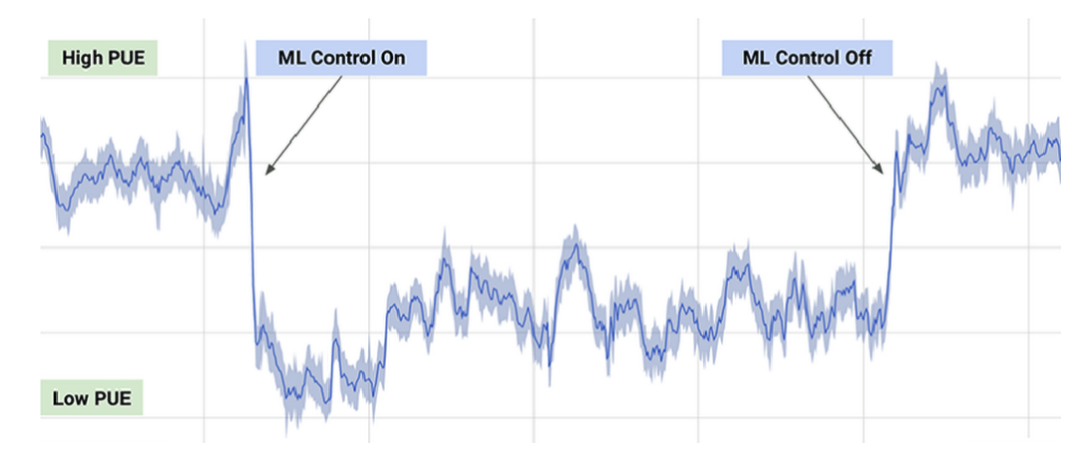

En 2016, DeepMind et Google ont travaillé sur un système de recommandation d'IA pour aider à rendre les centres de données de Google plus écoénergétiques. L'accent était mis sur les plus petites améliorations: même de petits changements étaient suffisants pour aider à économiser de l'énergie et à réduire les émissions. Cependant, après la mise en œuvre des recommandations, leur mise en œuvre a nécessité trop d'efforts de la part de l'exploitant.

Les opérateurs de centres de données ont demandé s'ils pouvaient être mis en œuvre de manière autonome. Cependant, selon Google, aucun système d'intelligence artificielle n'est encore prêt à contrôler totalement les processus de refroidissement et de chauffage dans le centre de données.

Le système de contrôle d'intelligence artificielle actuel de Google fonctionne sur des actions spécifiques, mais ne peut les exécuter que dans des conditions limitées, dont la priorité est la sécurité et la fiabilité. Selon l'entreprise, le nouveau système permet d'économiser jusqu'à 30% d'énergie en moyenne.

Jour PUE typique (efficacité énergétique) avec ML activé et désactivé.

Source: DeepMind

Google a également utilisé un système d'intelligence artificielle pour ajuster l'efficacité d'un centre de données dans le Midwest pendant la surveillance des tornades. Alors que l'opérateur humain pouvait se concentrer sur la préparation de la tempête, le système d'IA a profité de la connaissance et de la connaissance des conditions de tornade - telles que la pression atmosphérique et les changements de température et d'humidité - pour régler les systèmes de refroidissement du centre de données à une efficacité maximale pendant les tornades. En hiver, le système de contrôle AI s'adapte à la météo pour réduire la consommation électrique nécessaire au refroidissement du datacenter.

Cependant, cette méthode n'est pas sans inconvénients. Les lacunes de la technologie de l'IA empêchent le centre de prendre facilement des décisions efficaces et l'intelligence artificielle est très difficile à mettre à l'échelle. Chacun des centres de données de Google est unique et il est difficile de déployer l'outil AI (intelligence artificielle) à la fois.

Une autre façon d'améliorer l'efficacité consiste à modifier la façon dont vous refroidissez les parties surchauffées du centre de données, telles que les serveurs ou certains types de puces.

Une de ces méthodes consiste à utiliser du fluide au lieu de l'air pour refroidir les pièces. Le PDG de Google, Sundar Pichai, a déclaré que les puces récemment publiées par la société étaient si puissantes que la société devait les plonger dans un liquide pour les refroidir au degré souhaité.

Certains centres de données expérimentent des centres de données de plongée sous l'eau pour simplifier le refroidissement et améliorer l'efficacité énergétique. Cela permet aux centres de données d'avoir un accès constant à des eaux profondes naturellement fraîches, de sorte que la chaleur des équipements est acheminée vers l'océan environnant. Parce que le centre de données peut être situé au large de n'importe quel littoral, il existe un choix de connexions d'énergie verte - comme le Microsoft Project Natick de 40 pieds alimenté par le réseau éolien des Orcades.

L'avantage des centres de données sous-marins plus petits est qu'ils peuvent être modulaires. Cela simplifie leur déploiement par rapport aux nouveaux centres terrestres.

Cependant, malgré ces avantages, certains experts se méfient des centres de données sous l'eau, car des inondations sont possibles. Étant donné que le processus de refroidissement implique de puiser de l'eau propre et de libérer de l'eau chaude dans la région environnante, ces centres de données peuvent rendre la mer plus chaude en affectant la flore et la faune marines locales. Et bien que les centres de données sous-marins tels que Project Natick soient conçus pour fonctionner sans contrôle humain, si des problèmes surviennent, ils peuvent être difficiles à résoudre.

À l'avenir, les centres de données peuvent également contribuer à l'énergie propre et à l'efficacité en utilisant une partie de l'électricité qu'ils produisent. Certains projets explorent déjà la possibilité de réutiliser la chaleur. Le centre de données nordique DigiPlex s'associe au fournisseur de chauffage et de climatisation Stockholm Exergi pour créer un système de récupération de chaleur. Le concept de cette solution est de collecter l'excès de chaleur dans un centre de données et de l'envoyer à un système de chauffage urbain local pour potentiellement réchauffer jusqu'à 10 000 personnes à Stockholm.

Acheter de l'énergie propre

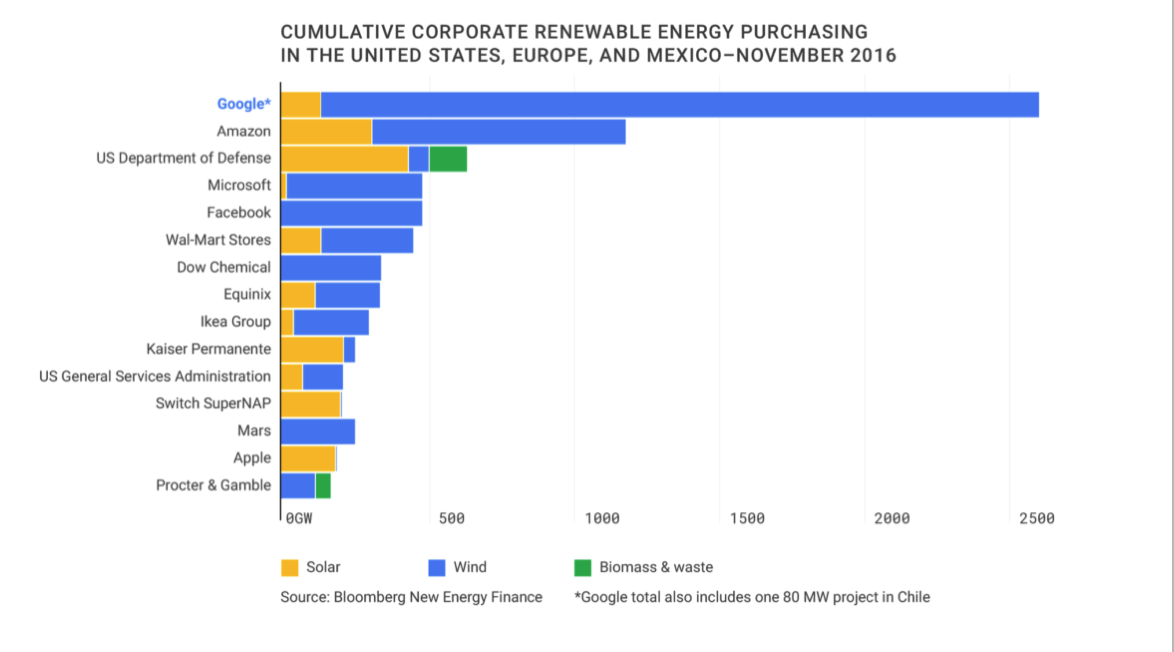

Selon l'AIE, l'industrie des TIC a fait des progrès dans le domaine des énergies propres et conclut actuellement près de la moitié de tous les accords d'achat d'énergie renouvelable des entreprises.

Depuis 2016, Google est le plus gros acheteur d'énergie renouvelable d'entreprise sur la planète.

Source: Google Sustainability

En décembre 2018, Facebook a acquis 200 MW d'électricité d'une société d'énergie solaire. À Singapour, où la superficie des terres est limitée, Google a annoncé son intention d'acheter 60 MW d'énergie solaire sur le toit.

Dans le même temps, les grandes entreprises telles que Google et Facebook, qui ont les ressources nécessaires pour acheter de grandes quantités d'énergie renouvelable, peuvent être difficiles pour les petites entreprises qui n'ont peut-être pas besoin de grandes quantités d'énergie.

Une autre option énergétique plus chère est MicroGrid: l'installation d'une source d'alimentation indépendante à l'intérieur du centre de données.

Un exemple d'une telle stratégie est les piles à combustible, similaires à celles récemment vendues par l'entreprise publique Bloom Energy. Les cellules utilisent l'hydrogène comme carburant pour créer de l'électricité. Bien que ces sources alternatives soient souvent utilisées comme énergie de secours, le centre de données peut compter entièrement sur ce système pour survivre, bien que ce soit une option économiquement coûteuse.

Les centres de données explorent également l'énergie propre en utilisant des sources d'énergie renouvelables (REC), qui représentent une certaine quantité d'énergie propre et sont généralement utilisées pour équilibrer «l'énergie sale» qu'une entreprise utilise. Pour toute quantité d'énergie sale produite, REC représente la production d'une quantité équivalente d'énergie propre dans le monde. Ces montants récupérés sont ensuite revendus au marché des énergies renouvelables.

Cependant, il existe certains problèmes avec le modèle REC. D'une part, les CER ne compensent que l'énergie sale - cela ne signifie pas que le centre de données fonctionne à l'énergie propre. Bien que la méthode REC soit généralement plus simple que de trouver des sources disponibles qui peuvent fournir suffisamment d'énergie pour répondre aux besoins du centre de données. L'inconvénient est que la méthode n'est généralement pas disponible pour les petites entreprises qui n'ont pas toujours de capital pour s'appuyer sur les fluctuations d'une centrale solaire ou éolienne.

À l'avenir, la technologie facilitera une collaboration étroite entre les petits producteurs et les acheteurs. Des modèles et des portefeuilles de marchés des énergies renouvelables (similaires à ceux créés par les OPC) font leur apparition pour évaluer et quantifier les fluctuations des énergies renouvelables.

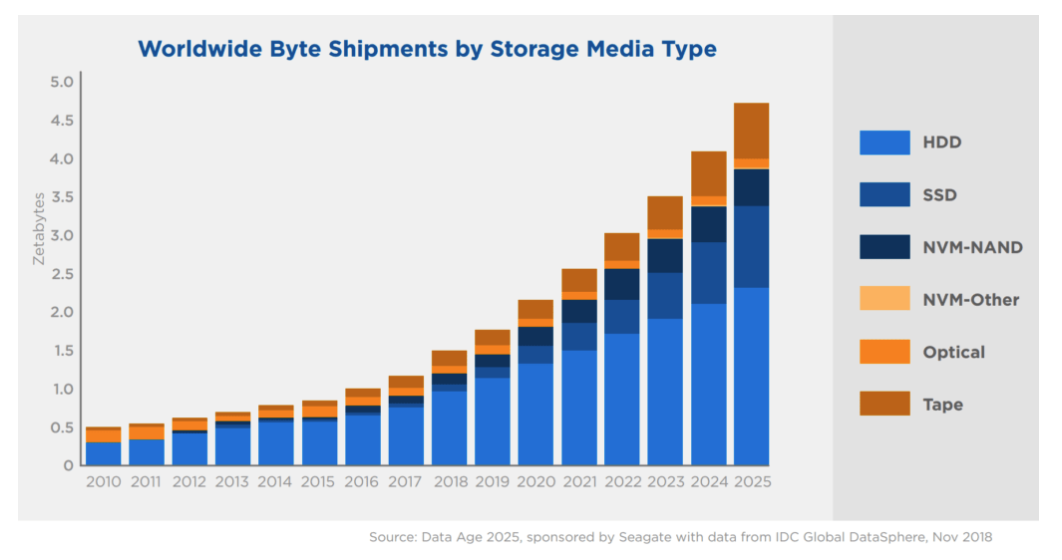

(SSD)

Les SSD, ou SSD, sont une forme de périphérique de stockage qui prend en charge la lecture et l'écriture de données. Ces appareils peuvent stocker des données sans alimentation - c'est ce qu'on appelle le stockage persistant. Cela diffère des formes temporaires de stockage de données, telles que la mémoire vive (RAM), qui stockent les informations uniquement pendant le fonctionnement de l'appareil.

Les disques SSD sont en concurrence avec les disques durs, une autre forme de stockage de masse. La principale différence entre SSD et HDD est que les SSD fonctionnent sans pièces mobiles. Cela permet aux SSD d'être plus durables et plus légers.

Cependant, les disques SSD restent plus chers que les disques durs traditionnels - une tendance qui devrait se poursuivre sans une percée dans la production de disques SSD.

Source: Silicon Power Blog

Bien que les SSD soient devenus la norme pour les ordinateurs portables, les smartphones et autres appareils à profil mince, ils sont moins pratiques et donc moins courants dans les grands centres de données en raison de leur prix plus élevé.

Source: Seagate & IDC

Selon IDC, d'ici la fin de 2025, plus de 80% de la capacité de stockage d'entreprise restera sous la forme de disques durs. Mais après 2025, les SSD pourraient devenir le support de stockage préféré des entreprises et de leurs centres de données.

Avec l'adoption généralisée des disques SSD dans l'électronique grand public et les appareils IoT, une demande accrue peut entraîner une augmentation de l'offre et, en fin de compte, une réduction des coûts.

Chambre froide

Contrairement aux nouveaux SSD, de nombreuses technologies plus anciennes, telles que les CD-R et les bandes magnétiques, utilisent le stockage à froid pour maintenir les données aussi bas que possible.

Le stockage à froid prend beaucoup plus de temps pour accéder aux données que le stockage à chaud (par exemple, SSD). Ces systèmes ne doivent stocker que des données rarement utilisées.

Les nuages «chauds» fonctionnent sur les disques SSD et les disques hybrides et fournissent l'accès le plus rapide aux informations. L'entreposage frigorifique est une solution plus économique et plus lente. Dans "Cold Clouds", ils stockent des informations qui ne sont pas nécessaires pour une familiarisation instantanée. Après une demande, les données peuvent être téléchargées de plusieurs minutes à des dizaines d'heures.

Littéralement parlant, la différence de température à l'intérieur des centres de données - plus le cloud est rapide, plus l'équipement génère de chaleur.

Cependant, les plus grandes sociétés technologiques du monde, telles que Facebook, Google et Amazon, utilisent le stockage à froid pour stocker même les données utilisateur les plus granulaires. Les fournisseurs de cloud tels qu'Amazon, Microsoft et Google proposent également ces services aux clients qui souhaitent stocker des données à bas prix.

Selon l'outil d'étalonnage du marché CB Insights, le marché des chambres froides devrait atteindre près de 213 milliards de dollars d'ici 2025.

habrastorage.org/webt/cr/cc/t-/crcct-u3vtckequtnd0eazlwkqk.png

Source: IBM

Aucune entreprise ne veut sortir de la courbe de la collecte de données. La plupart des organisations affirment qu'il est préférable de collecter autant de données que possible aujourd'hui, même si elles n'ont pas encore décidé comment elles seront utilisées demain.

Ce type de données inutilisées est appelé données sombres. Il s'agit de données qui sont collectées, traitées et stockées, mais qui ne sont généralement pas utilisées à des fins spécifiques. IBM estime qu'environ 90% des données des capteurs collectées sur Internet ne sont jamais utilisées.

À l'avenir, il existe peut-être des moyens plus efficaces de réduire la quantité totale de données obscures collectées et stockées. Mais de nos jours, même avec le développement de l'intelligence artificielle et de l'apprentissage automatique, les entreprises sont toujours intéressées par la collecte et le stockage du plus de données possible afin d'utiliser ces données à l'avenir.

Par conséquent, dans un avenir prévisible, le meilleur stockage à froid permet de stocker des données au prix le plus bas. Cette tendance se poursuivra à mesure que les utilisateurs généreront plus de données et que les organisations les collecteront.

Autres formes de stockage de données

En plus des disques SSD, des disques durs, des CD et des bandes magnétiques, un certain nombre de nouvelles technologies de stockage font leur apparition et promettent davantage de capacité par unité de stockage.

L'une des technologies prometteuses est l'enregistrement thermomagnétique (également l'enregistrement magnéto-thermique) ou HAMR. HAMR augmente considérablement la quantité de données qui peuvent être stockées sur des appareils tels que des disques durs en chauffant la surface du disque avec un laser de haute précision pendant l'enregistrement. Cela permet un enregistrement des données plus précis et plus stable, ce qui augmente la capacité de stockage.

D'ici 2020, cette technologie devrait produire jusqu'à 20 To de disques durs par lecteur de 3,5 pouces et augmenter encore la capacité de 30% à 40% par an. Seagate a déjà créé un disque dur de 16 To de 3,5 pouces, qu'il a annoncé en décembre 2018.

Au cours de la dernière décennie, Seagate a activement breveté cette technologie HAMR. En 2017, la société a déposé un nombre record de brevets liés à cette technologie.

(Remarque: il y a un délai de 12 à 18 mois entre le dépôt des brevets et la publication, de sorte que 2018 pourrait voir un nombre encore plus grand de brevets HAMR.)

Un peu de publicité :)

Merci de rester avec nous. Aimez-vous nos articles? Vous voulez voir du contenu plus intéressant? Soutenez-nous en passant une commande ou en recommandant à des amis, Cloud VPS pour les développeurs à partir de 4,99 $, un analogue unique des serveurs d'entrée de gamme, qui a été inventé par nous pour vous: Toute la vérité sur VPS (KVM) E5-2697 v3 (6 cœurs) 10 Go DDR4 480 Go SSD 1 Gbps à partir de 19 $ ou comment diviser le serveur? (options disponibles avec RAID1 et RAID10, jusqu'à 24 cœurs et jusqu'à 40 Go de DDR4).

Dell R730xd 2 fois moins cher au centre de données Equinix Tier IV à Amsterdam? Nous avons seulement 2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV à partir de 199 $ aux Pays-Bas! Dell R420 - 2x E5-2430 2,2 Ghz 6C 128 Go DDR3 2x960 Go SSD 1 Gbps 100 To - à partir de 99 $! En savoir plus . c Dell R730xd 5-2650 v4 9000 ?