Le monde technologique a adopté un nouveau battage médiatique - GPT-3.

Les énormes modèles de langage (comme GPT-3) nous surprennent de plus en plus par leurs capacités. Et si la confiance des entreprises en eux ne suffit pas pour les présenter à leurs clients, ces modèles démontrent les prémices d'une intelligence qui va accélérer le développement de l'automatisation et les capacités des systèmes informatiques «intelligents». Supprimons l'aura de mystère de GPT-3 et découvrons comment il apprend et comment cela fonctionne.

Le modèle de langage formé génère du texte. Nous pouvons également envoyer du texte à l'entrée du modèle et voir comment la sortie change. Ce dernier est généré à partir de ce que le modèle a "appris" pendant la période de formation en analysant de grandes quantités de texte.

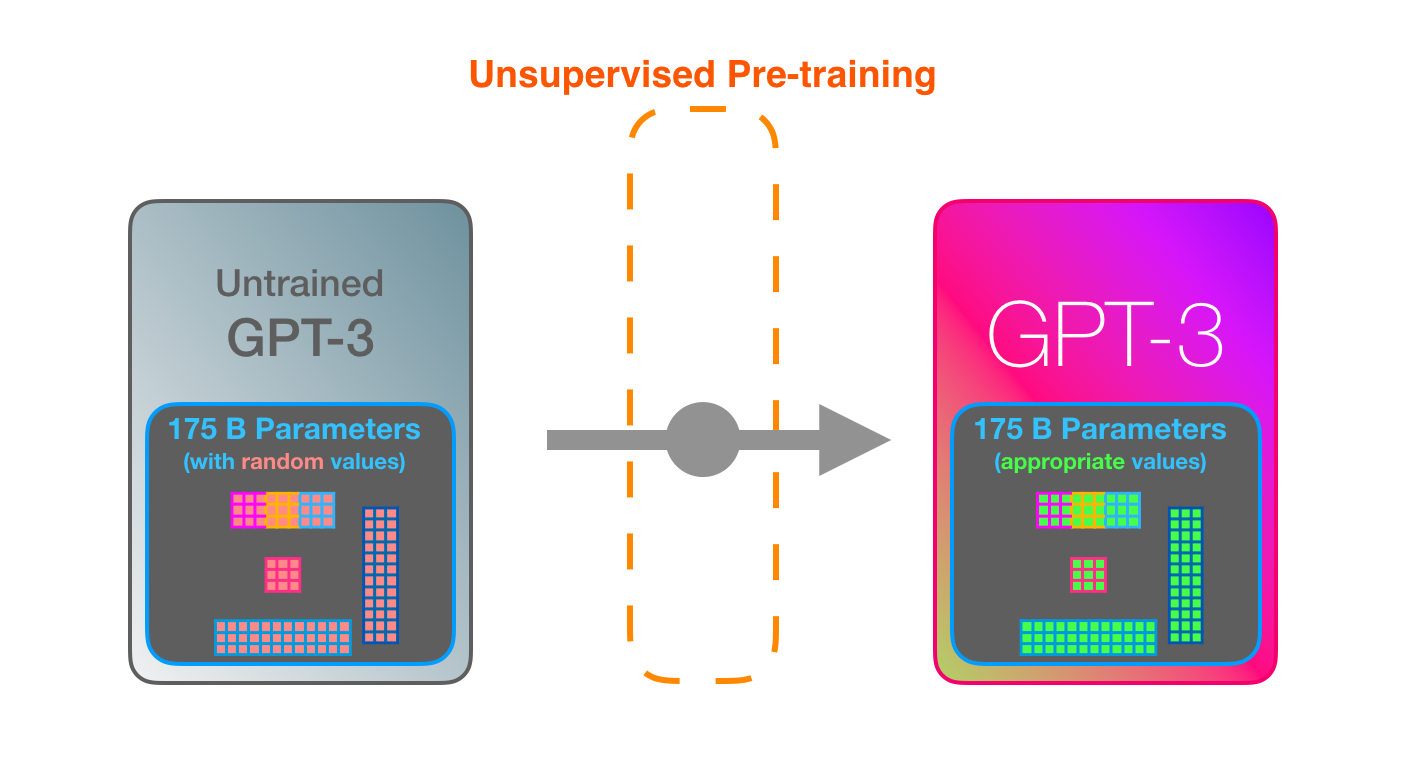

L'apprentissage est le processus de transfert d'une grande quantité de texte vers un modèle. Pour GPT-3, ce processus est terminé et toutes les expériences que vous pouvez voir s'exécutent sur le modèle déjà entraîné. Il a été estimé que la formation prendrait 355 années GPU (355 ans de formation sur une seule carte graphique) et coûterait 4,6 millions de dollars.

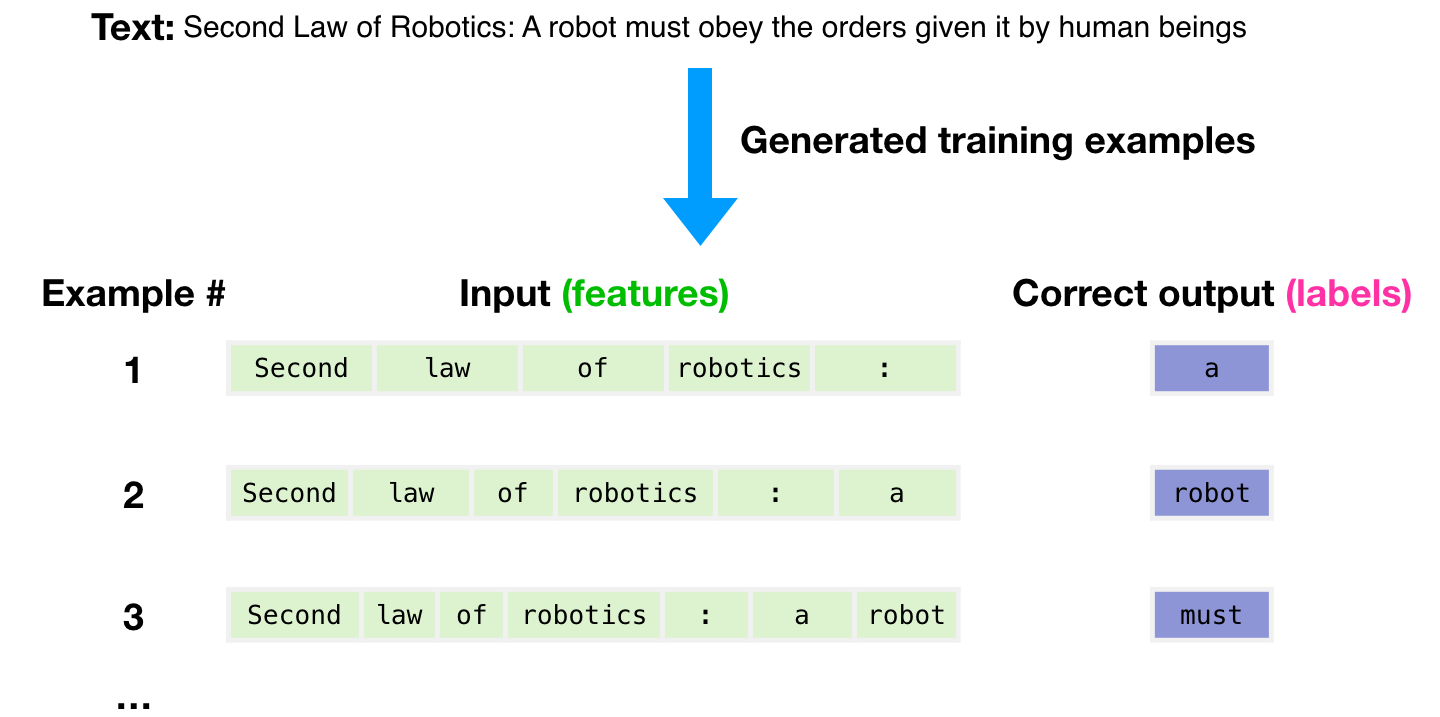

Un ensemble de données de 300 milliards de jetons de texte a été utilisé pour générer des exemples pour l'entraînement du modèle. Par exemple, voici à quoi ressemblent trois exemples de formation, dérivés d'une phrase ci-dessus.

, , .

( ) .

. , .

.

.

GPT-3 ( , – ).

GPT-3 . , , 175 ( ). .

, , .

– , – , .

« Youtube» – 175- .

, , .

GPT-3 2048 – « », 2048 , .

. «robotics» «A»?

:

- ( ).

- .

- .

GPT-3 96 .

? «» « » (deep learning).

1.8 . «». :

, , GTP-2 .

GPT-3 (dense) (sparse) (self-attention).

«Okay human» GPT-3. , . : , . .

React ( ), , => . React , , .

On peut supposer que les exemples et descriptions initiaux ont été ajoutés à l'entrée du modèle, avec des jetons spéciaux qui séparent les exemples du résultat.

La façon dont cela fonctionne est impressionnante. Il vous suffit d'attendre la fin de la mise au point de GPT-3. Et les possibilités seront encore plus étonnantes.

L'ajustement met simplement à jour les pondérations du modèle afin d'améliorer ses performances pour une tâche spécifique.

Auteurs

- Auteur original - Jay Alammar

- Traduction - Ekaterina Smirnova

- Montage et mise en page - Sergey Shkarin